GPU

GPU是一种专门在计算机上运行绘图运算工作的微处理器。

阿里云发布云数据中心处理器 CIPU,替代 CPU 成为云时代 IDC 的处理核心

CIPU 与计算结合,快速接入不同类型资源的服务器,带来算力的“0”损耗

英特尔的 XPU 计划:Falcon Shores 项目为超级计算机融合 x86 与 Xe 技术

Falcon Shores 项目主要针对超级计算 /HPC 市场,其核心是一个新的处理器架构,可以将英特尔的 x86 CPU 和 Xe GPU 硬件置入同一颗 Xeon 芯片中。它计划在 2024 年发布,且英特尔预计它将提供 5 倍以上的每瓦性能和 5 倍于该公司当前平台的内存容量。

英伟达的核弹级 GPU 来了:800 亿个晶体管,20 块就可承托全球互联网流量

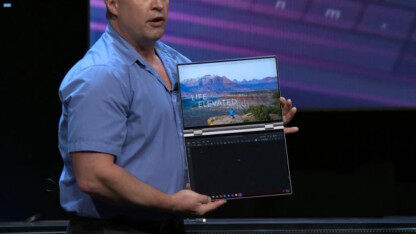

老黄大秀“AI 肌肉”!

黄仁勋谈 GPU 大战:每年都有“英伟达杀手”跳出来,但无人成功

在这场对话中,黄仁勋谈到了英伟达 Omniverse 平台所承载的元宇宙蓝图,探讨了数据中心业务如何保持增长,他还对显卡领域激烈的市场竞争发表了看法,他认为,尽管每年都有所谓的“英伟达杀手出现”,但 15 年来,英伟达在超级计算机 GPU 加速领域几乎无敌手。

OpenAI 发布 Triton,一款用于神经网络的类 Python GPU 开源编程语言

OpenAI 声称这款语言让开发人员无需太多努力即可挖掘硬件的最大潜能,从而比以往更轻松地创建更复杂的工作流程。

GPU 在计算机架构的新黄金时代还会继续闪耀吗?

GPU 能否保住人工智能世界“CPU”的宝座?

Facebook 推出数据并行训练算法 FSDP:采用更少的 GPU,更高效地训练更大数量级的模型

大规模训练 AI 模型并非易事。

突发!美商务部将 7 个中国超算实体列入实体清单,制裁或许没有华为严重

美国再“拉黑”7 个中国超算实体,这是拜登政府上任后,美国政府第一次增加对华实体清单名单。

缺了黄仁勋的 GTC China,还有什么惊喜?

“黄氏定律”开启新时代?

FPGA 在深度学习应用中或将取代 GPU

随着可编程性等问题在 FPGA 上的解决,FPGA 将成为市场人工智能应用的选择。

性能提升最高达 25 倍!新型分布式机器学习训练加速方案 RAT 技术解读

DNN 训练性能瓶颈正在从计算部分转移至通信部分。

GPU 选购指南:训练 ML 模型,我必须买 RTX3080 吗?

如果你想购买一块新 GPU,主要看哪些特性呢?GPU 内存、内核、张量核?如何做出有成本效益的选择?

终下决心!中国龙芯决定放弃所有美国技术,做真正的纯国产指令集

曾支撑 2015 年中国发射的北斗卫星,龙芯是近年来国产自主程度相对较高的芯片

英特尔前雇员讲述:50 年老厂是如何走上“挤牙膏”之路的?

芯片外包台积电背后的十年沉浮和无奈

突破算力束缚:阿里提出智能算力引擎 DCAF, 节省 20%GPU 算力

未来,计算力可能从过去算法进化的推力,变成阻力。

计算架构“新黄金十年”已来,Intel 设立了一个兴趣小组等你!

年代我们做研究那时一样,新的架构设计将会带来更低的成本,更优的能耗、安全和性能。计算架构的“新黄金十年”已经开启。

失去华为,寒武纪 IPO“芯”事重重

4 岁的寒武纪面临着不少成长中的烦恼,它能赶考科创板成功,成为“AI 芯片第一股”吗?

英特尔承认落后 AMD 7nm,直到 2021 年才能赶上对手

对于英特尔来说,2020 年和 2021 年将是竞争压力时刻环绕的漫长两年。

Imagination 老矣?最新 GPU 架构 IMG A 系列,性能提升 2.5 倍,有史以来最快

15 年来,Imagination Technologies 最重要的一次发布。

一台 CS-1 性能顶 1000 个 GPU?史上最大 AI 芯片 Cerebras WSE 正式投入使用

Cerebras Systems 的首席执行官 Andrew Feldman 表示,CS-1 是目前“最快的 AI 计算机”。

定义未来应用程序开发的十年?英特尔正式推出统一跨架构编程模型 oneAPI

英特尔或许能够凭借 oneAPI,对整个芯片设计行业进行一次“大规模的洗牌”。

英特尔推出首款通用 GPU ,英伟达却表示并不担心

英伟达黄仁勋表示:我们重视竞争对手,但我们有自己的技术。

基于 UAI-Train 平台的分布式训练

在大型数据集上进行训练的现代神经网络架构,可以跨广泛的多种领域获取可观的结果,涵盖从图像识别、自然语言处理到欺诈检测和推荐系统等各个方面,但训练这些神经网络模型需要大量浮点计算能力。

英特尔终于实现 10nm 芯片量产,7nm 芯片还要多久?

经过数年的拖延,英特尔终于交付了首批 10nm 处理器。

比 Horovod/NCCL 快 8 倍!伯克利与微软联合发布最优 GPU 通信库 Blink

随着 GPU 的算力不断提升,GPU 间的数据聚合(即模型同步)成为了大规模分布式模型训练的瓶颈。

CPU 并行编程概述(上)

一个自然而然的问题是:为什么要用并行编程?

我们距离纯粹的中国“芯”还有多远?| 话题

业界人士常谈,随着后摩尔时代的到来,中国的半导体行业会获得更多的机遇,芯片领域也会迎来春天。

阿里云智能总裁行癫:做芯片,我们喜欢走前人没走过的路

阿里巴巴的几位专家重点讨论了阿里在云和 AI 上的思考,以下为 InfoQ 整理的本次对话的关键信息。

苹果最新 A13 仿生芯片可还行?

除了“智能手机有史以来最好的机器学习性能”宣称外,“能效”或许可以被称作苹果 A13 仿生芯片的最大亮点之一。

全球首个软硬件推理平台 NVDLA 编译器正式开源,可在云端自主设计推理用 AI 芯片

近期,英伟达在 GitHub 上开源了 NVDLA 编译器的源代码,这是世界上首个软硬件推理平台的完整开源代码。