背景介绍

如今,大数据、移动互联网的兴起,对信息技术和通信技术的基础架构都提出了更高的要求。需要能提供随需而变、按需供给、灵活稳定的服务。信息产业和通信产业也进入共同发展的时代,SDN 作为跨界技术应运而生。

提起 SDN,也需要聊下云计算,云计算把计算、存储、网络等资源变成 IT 服务,用户可随需应变,便捷地从池中获取资源,而这些资源可快速供应、交付,最大程度减少用户的资源管理成本。SDN 可以为云计算的管理平台提供抽象的 API 接口,确保各种网络资源的调用,提升数据的高效运转。

可以说,SDN 的迅猛发展为信息产品和通信产品带来了巨大的变化。但是,对 SDN 技术的定义,迄今未达成共识。如今 SDN 门派各立,下文首先介绍 SDN 主流的四大派系,然后阐述可实践的 SDN 网路架构的特点,并提供该网络架构下的混合云案例。

SDN 主流四大派系

A 派系为 ONF(Open Networking Foundatin,开放网络基金会)

ONF 致力于 SDN 的发展和标准化,是当前业界最活跃、规模最大的 SDN 标准组织。其主要参与者包括雅虎、Google、德国电信、Facebook、微软、Verizon 等。该派系是对于 SDN 比较理想的状态模型规范。ONF 提出的 SDN 的典型架构分为三层,分别如下:

- 应用层:包含各种不同的业务和应用。

- 中间控制层:主要负责处理数据平台资源的编排、维护网络拓扑和状态信息。

- 基础设施层接口:负责处理数据、转发和状态收集。

除了上述三个层次之外,控制层与基础设施层之间的接口和应用层与控制层之间的接口也是 SDN 架构中的两个重要组成部分。按照接口与控制层的位置关系,前者通常被称作南向接口,后者则被称作北向接口。

南向接口:基础设施层接口与控制层的接口为 OpenFlow 标准;而北向接口没有定义。

因此,理想化的新一代网络,完全从控制层与数据层全面切割。以后,硬件是什么已经没有关系了。

B 派系由 ODL(OpenDaylight)在思科、IBM 等设备厂商推动下成立。目前主流的硬件厂商如华为、H3C ZTE、DELL 等都有参与进去。

OpenDaylight 是一套以社区为主导的开源框架,旨在推动创新实施以及软件定义网络(简称 SDN)透明化。面对 SDN 型网络,大家需要合适的工具帮助自己管理基础设施,这正是 OpenDaylight 的专长。

作为项目核心,OpenDaylight 拥有一套模块化、可插拔且极为灵活的控制器,这使其能够被部署在任何支持 Java 的平台之上。这款控制器中还包含一套模块合集,能够执行需要快速完成的网络任务。

OpenDaylight 属于设备供应商产品变化联盟。关注如何在新一代的网络来临之前把控先进,适应新业务带来的对设备供应商的需求。

C 派系:ETSI

ETSI 是运营商级别的联盟,主要是为了适应产业的变化。核心目的是加速 NFV 的产业进程和落地应用。成员包括 AT&T、英国电信、德国电信、Orange、Verizon、中国移动等。

D 派系:IETF(Internet Engineering Task Force 互联网络工程任务组)

这是市场上大家经常会用来与A派进行类比的一个派系。

IETF 的核心:以软件驱动网络(Software Driven Network)为出发点研究 SDN,代表的是传统网络厂商的利益,主要聚焦于 SDN 相关功能化和技术如何在网络中实现的细节。

主要解决现有的网络设备和现有的网络设备基础中,如何 平滑演进 至集中控制器的 SDN 网络。

另外,大家也关注一下软件定义网络 (SDN)和软件驱动网络(Software Driven Network)的区别:从可实践性的角度,软件驱动网络(Software Driven Network)是比较可以推进实践的。

举一个简单的例子:

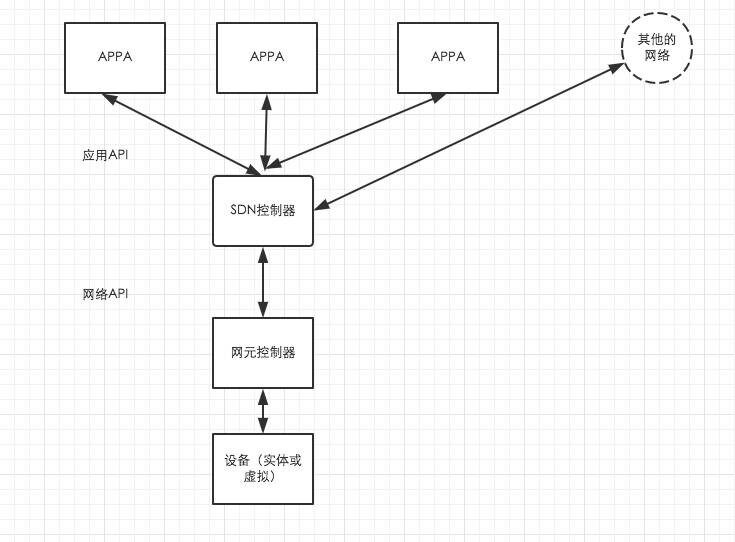

(点击放大图像)

从网络 API 和实用 API 中对于设备、网元控制器、SDN 控制等进行了逻辑区别。对于目前的设备尽量不改变其状态。通过网元控制器和 SDN 控制器,把网络的数据转发功能和控制管理功能进行区分。

除以上四大派系之外,SDN 的其他的派系还包括 3GPP、BBF、CCSA、ONOS 等。这些可以理解为单一行业或场景应用的派系。

产业网络需求

无论是 SDN 也好,还是新的网络技术,目前的产业对于网络的要求是什么样子的呢?

通过调研 100 多个直接用户,进行了如下的归纳。

- 用户自主服务。像用自来水一样使用网络,尤其是广域网网络。

- 运维自动化、可视化。

- 需要具备统一的私密性要求。

- 按需分配、弹性扩充。

- 统一的平台管理,可以对现有的数据中心资源、企业资源、云服务商资源统一进行管理、监控。

我的团队对可实践的 SDN 的网络进行了科研型地分析,融合上述主流派系的优势,提出了如下可实践性的 SDN 网络架构。

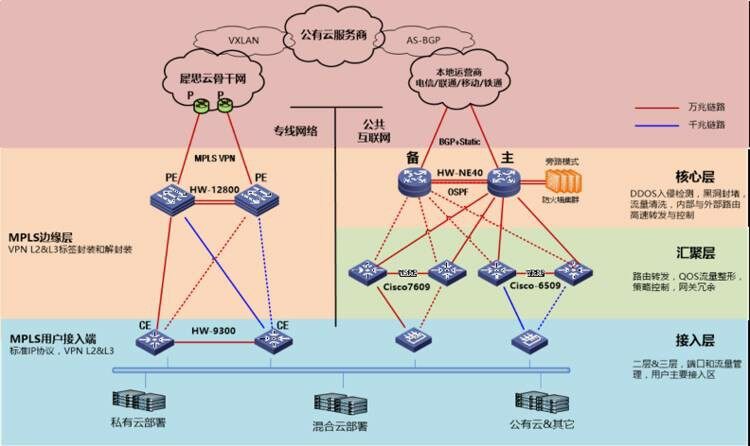

(点击放大图像)

利用现有网络改造为 SDN 网络:在所有的接入层、汇聚层与核心层的设备完全不做任何改变。

通过在现有设备接入 SDN 控制器服务器的方式:对于同一二层网络内的设备进行网络虚拟化。

在不改变现有硬件的情况下,利用 Netconf 和已有的设备接口,通过 XML 网络实现 SDN 管理。服务器的作用就是为了实现网络的 SDN 管理。

骨干网(汇聚)采用可编程控制 MPLS (Netconf),所有的设备包含光设备都是可管理设备。方便统一进行管理、监控。

接入网 OPENFLOW(狭义的 SDN) 的编程来进行规范网络。

整体的网络架构具体特性如下:

- 冗余性:全局网络物理链路层多线路冗余,POP 节点采用双设备冗余,POP 点的机房采用电力双冗余。

- 可靠性:整体网络数据采用 MPLS VPN 技术,通过 VPLS 将二层协议帧封装后在 PW 上传输、交换,使广域范围内多个局域网在数据链路层面被整合为一张网络,向用户提供虚拟的以太网服务。

- 安全性:通过 VPLS 的方式,通 ID 标识来确保网络唯一通信。

- 兼容性:整体 CXP 平台不改变客户的任何网络,对于客户的网络架构不做任何改变,可以无缝兼容任何网络形式。

(点击放大图像)

核心网络采用 SDN 网络云服务商(阿里云、腾讯云、青山云)等在 NNI 层对接。客户在接入网络中,可以采用 VPN、运营商专线、裸纤的方式。

(点击放大图像)

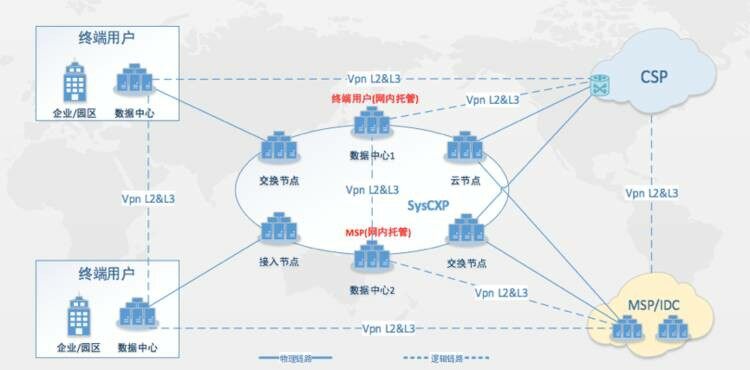

CXP 新一代的云交换平台形成一个包含了云服务商、数据中心、ISP、IDC 等合作伙伴的生态交换平台。

混合云中的 SDN

混合架构是什么样子?如下图:

(点击放大图像)

中间网络选择需要注意的问题

1、混合云专线选择

- 公网 VPN:通常使用 GRE 隧道 +IPSec 建立 VPN 专线优点:低成本、易操作、可应对轻量化应用缺点:受公网环境影响容易丢包和抖动、传输质量不稳定。

- 专线:运营商 MSTP/SDH 专线或第三方服务商的以太网专线)优点:无拥堵和丢包问题:线路稳定、低延迟、安全性高、能够应对各类应用及超大型应用负载。缺点:需要一定的成本、客户需要有较高的服务要求。

目前通常的做法都是无异于上面的两种。

2、 网络延迟与丢包的考虑

延迟和丢包率是衡量网络质量的最主要指标,两者越低说明网络质量越好。专线的延迟会因地理距离有所差异,但特征是稳定,丢包率接近 0,一般低于 0.2%。

延迟和丢包率对于网站终端用户影响不大,但对于服务端之间的数据库同步备份却是致命的,尤其对于类似两地三中心的高可用架构。

3、 专线 SLA 考虑

SLA(可用性服务),SLA 越高代表可用性越强,价格也会越高;尽可能选择专线的 SLA 与云服务 SLA 保持一致。与服务商签署协议前确认 SLA,避免不知情造成的损失。

目前的运营商级别的解决方案,在广域网层面也通常为 99.9 级别。对于 4 个 9 及以上,理论上存在的,但是,在时间的业务支撑中往往是无法达到的。

4、 私有云环境选择

- 新托管用户可参考综合指标:机房等级,地理位置、交通便利、电力保障及相关条件、网络连接条件等,选择比较符合自身需求以及未来网络可拓展空间等。

- 已托管用户对于已托管某 IDC 的用户,且需搭建混合云环境,但网络互联条件有限或其它原因,可通过 IDC 服务商或运营商专线解决网络互联。

5、 公有云的学习成本

- 产品线丰富,专业性较强,用户普遍对产品的理解有限

- 8 成用户面对混合云组网技术问题无法独立完成

- 少数企业的运维人员和架构师通过考试获得云计算认证

针对这些问题,下边给出我个人的经验:

1、 网络架构选择:

- 结合公司现有网络结构,根据预算和运维综合情况作出选择

- 如现有网络结构复杂,体量大,则建议维持现状,可通过专线上云缓冲架构变更

- 如新开资源,预算宽裕,且希望日后管理拓展方便,可考虑私有云主机或云物理机

- 高可用架构,可选云的两地三中心(公有云两个可用区,加上自有 IDC 的备份)

- 向混合云服务商咨询,出解决方案

2、 线路选择:

- 公网 VPN 或服务商专线均可满足不同的业务应用,可根据需求及预算选择

- 如果是轻量化的应用,如 OA 系统、小数据推送,且没有特别要求,公网 VPN 基本可满足

- 如果是视频、游戏、直播、会议系统以及相关依赖网络性能的应用,则直接上专线

基于 SysCXP 平台的混合云网络平台模型

基于目前我们提出的云交换的网络机构模型如下:

(点击放大图像)

- 场景一说明:数据中心与云直接互联。

- 场景二说明:企业与云互联。

- 场景三说明:数据中心与云互联

目前 CXP 的网络平台,可以实现如下功能:

- 网内支持自助线上开通

- 网外提供就近 POP 节点对接

- 一个端口,多个资源连接

- 高保障 SLA:99.9%、99.95%

- 支持带宽 100M-10G 及以上

- 基于 vxlan 安全隔离每用户

基于 SysCXP 的混合云解决方案

公有云服务商连接状态

犀思云目前已与国内主流云服务商完成连接,正在积极与 Microsoft Azure、AWS 为代表的海外服务商完成互联,助力中国企业在 DT 时代的海外拓展。

专注混合云“最后一公里”

代理运营商专线接入用户网络;犀思云 Edge 节点延升至用户网络;选择 SysCXP 内网络托管;犀思云 SD-WAN 产品互联(SD-WAN 的组网模型)

一站式服务

售前咨询、架构师指导 1 对 1 服务,根据需求免费设计方案,规划网络,以及后期建设、验收、优化、运维及监控在内周期的服务。

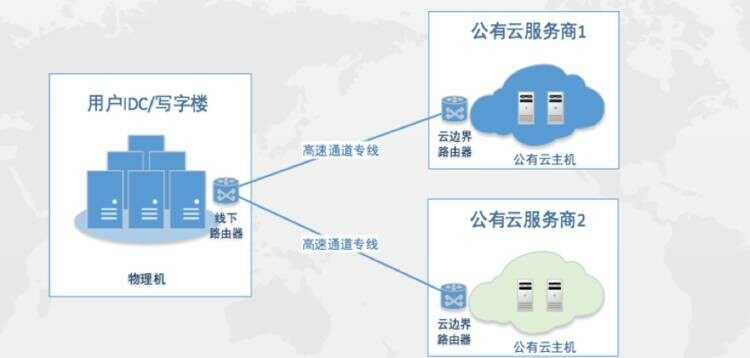

案例一:广告行业混合云的需求及解决方案客户介绍及需求说明

某广告公司是一家互联网广告公司,依托实时竞价 (RTB) 架构和算法,通过整合多家广告交易平台的展示类广告、视频广告、移动广告等资源,通过大数据挖掘及机器学习算法为广告主提供广告投放解决方案,从而达成广告投放效果提升的目标。

业务现状

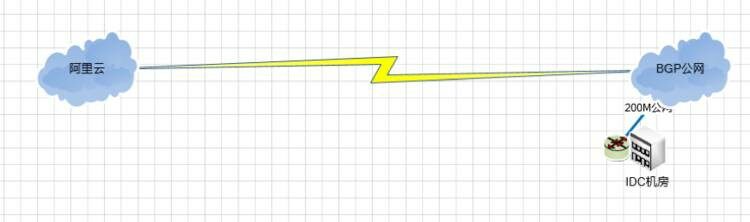

线上平台展示以及与 SSP 广告交易平台对接放在阿里云上,RTB 竞价相关对运算能力和竞价能力对设备性能要求高,云主机满足不了需求,托管物理机放在 IDC 机房。原来阿里云和 IDC 机房互联采用公网进行数据交换。

原有方案拓扑

(点击放大图像)

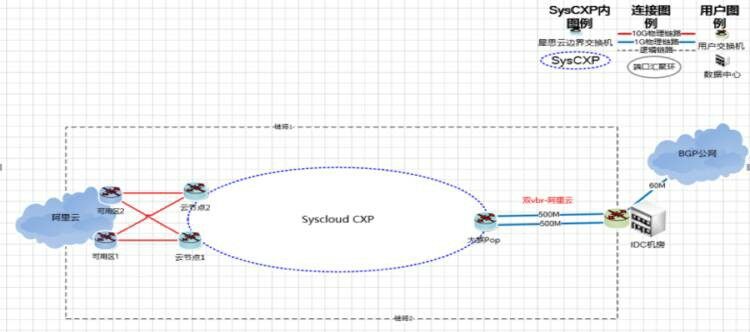

基于 CXP 的解决方案拓扑

(点击放大图像)

用户反馈

- 用户原有北京某 IDC 机房通过公网访问阿里云北京 ECS 正常延迟 10-20MS 之间,用网高峰期在 20-40MS 之间

- 使用犀思云提供的测试机从犀思云 IDC 机房专线访问阿里云在 2MS 左右,比较稳定不存在高峰期延迟波动情况

案例分享二:直播类客户的需求及解决方案客户需求说明

某直播教育平台提供在线教育技术服务,提供音视频互动直播,支持上万人同时在线,支持跨国业务。

该平台在全国各地都有用户,用户会将自己录制的教学视频上传到直播的服务器上。由于通过公网上传数据较不稳定、网速慢,为了实现音视频资源快速稳定回传,考虑使用专线传送数据。

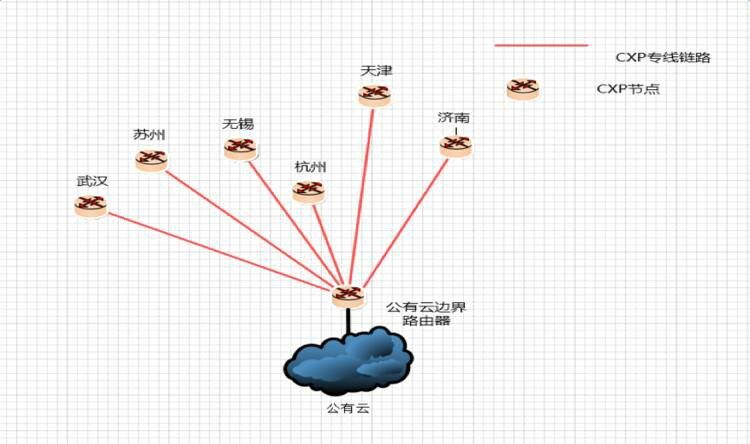

解决方案拓扑

(点击放大图像)

犀思云提供天津、济南、苏州、无锡、杭州、武汉等区域节点测试资源,由公网覆盖该区域的用户,各节点通过云专线汇聚到广州的公有云。

用户反馈

在使用目前的网络后,区域稳定性及客户覆盖大大的得到提升。从原有的单一站点源形成多站点源的拓扑结构,为后续多站点,多备份的方案实施做准备。

作者介绍

邵俊岭,犀思云解决方案高级总监。从事 IT 行业工作多年,早期参与过 CENET2 IPv6 网络的整体网络测试。后续,从事 IT 运维管理近 10 年,提供过 ITIL 咨询服务、机房运维管理服务、企业网络规划等项目。CENET2 IPv6 网络网络测试项目经理,拥有 SCPT 认证,也是 ITIL Expert 认证获得者,CCNA 网络培训讲师。