DALL·E 测试版终于来了,想好让 AI 生成什么图片了吗?

DALL・E 开放 100 万人大型公测

7 月 20 日,OpenAI 宣布将从候补名单中邀请 100 万用户,向其开放 DALL·E 测试版。

2021 年 1 月,OpenAI 正式推出 DALL·E,这是一个 AI 系统,可以根据文字描述创建图像。一年后,DALL·E 升级至 DALL·E 2,能够以 4 倍的分辨率生成更逼真、更准确的图像。

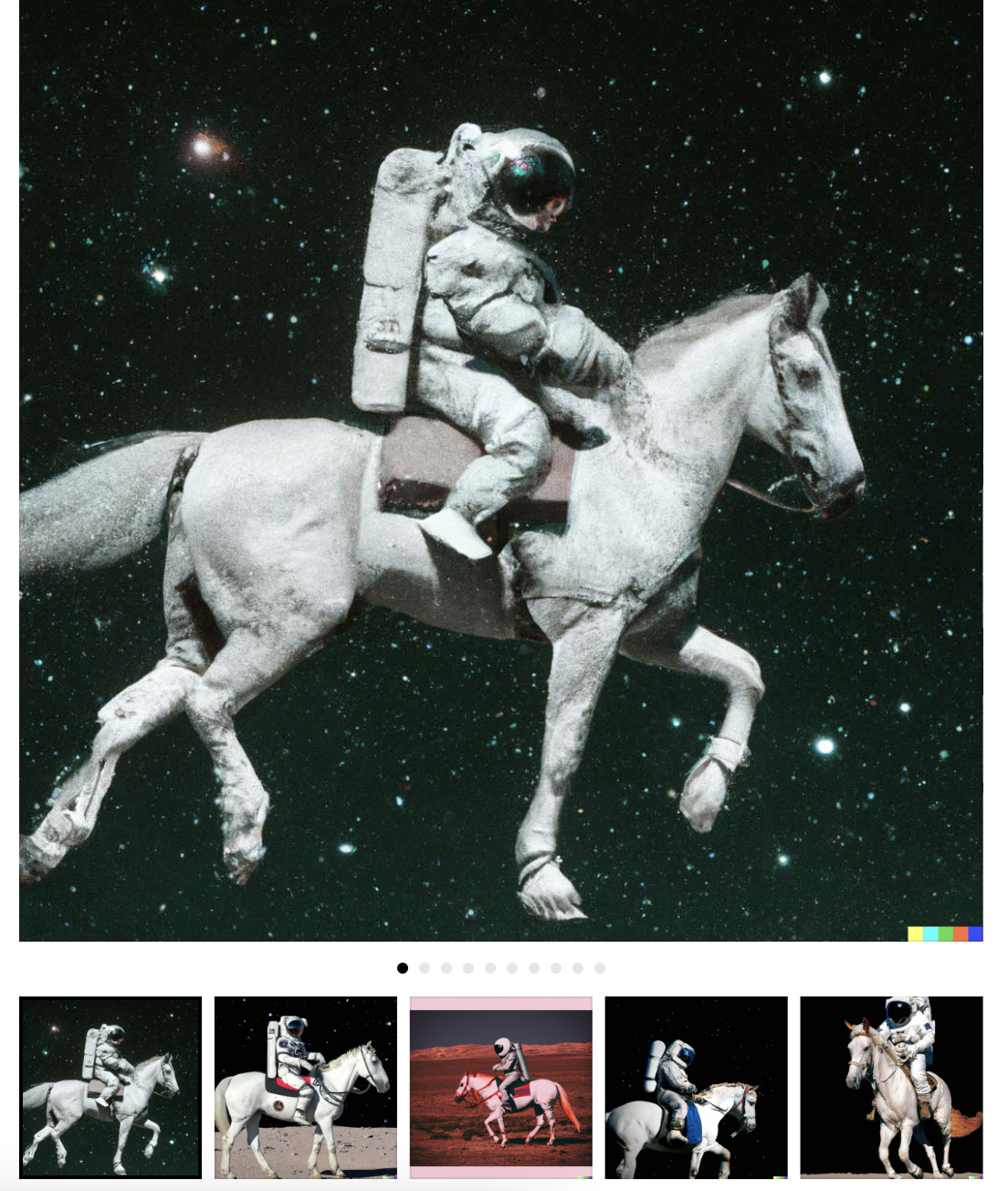

比如,输入“宇航员”,DALL·E 2 就可以生成以下这些图片。

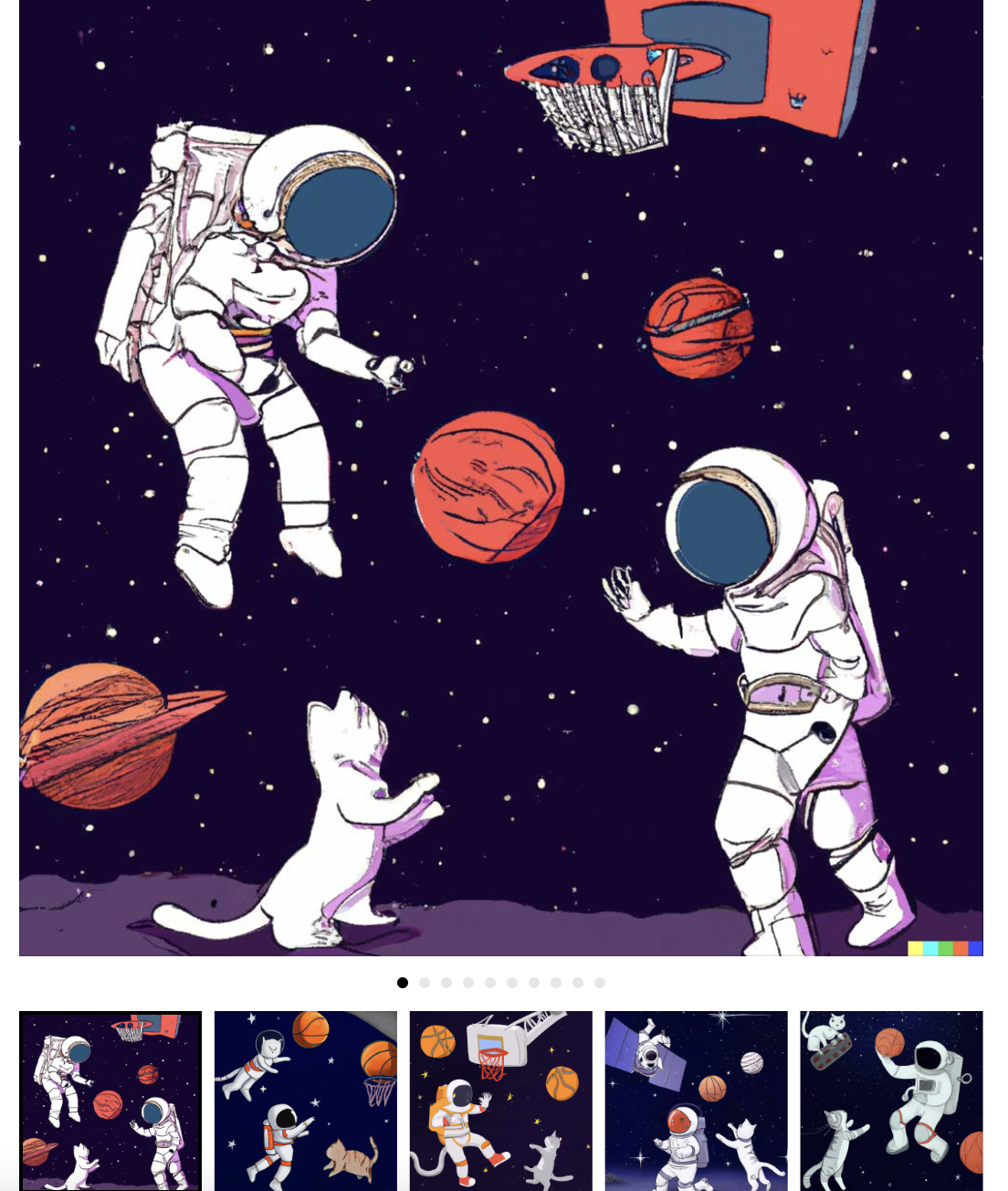

输入“与猫在太空打篮球”,DALL·E 2 就可以生成以下这些图片。

据悉,DALL·E 2 可以根据自然语言标题对现有图像进行逼真的编辑。它可以在考虑阴影、反射和纹理的同时添加和删除元素。下图左、右分别是原始图像与 DALL·E 编辑过的图像,可以看到 DALL·E 在图像中添加了个火烈鸟泳圈,并且与原始图片没有违和感。

根据 OpenAI 的介绍,DALL·E 2 学习了图像和用于描述图像的文本之间的关系。它使用一种称为“扩散”的过程,该过程从随机点的图案开始,并在识别图像的特定方面时逐渐改变该图案朝向图像。

OpenAI 表示,被邀请用户在第一个月将获得 50 个免费积分,接下来的每个月将获得 15 个免费积分。每个积分可用于一个原始 DALL·E 提示生成(返回 4 张图片)或一个编辑/变化提示(返回 3 张图片)。免费积分不够的话,用户可以以 15 美元的价格购买 115 个积分。

虽然 DALL·E 2 功能强大,但计算机科学家们的那句老话说得好:垃圾进、垃圾出,AI 也不例外。比如,这类模型也会出现社会偏见和刻板印象例如总体更倾向于生成肤色较浅的人像,也更倾向于生成符合西方世界刻板印象的职业与性别组合。例如,在让 DALL-E 生成“空乘人员”图像时,给出的几乎全是女性形象。而如果要求生成“CEO”图片,得到的就基本都是“老白男”。

谷歌近期发布的同类型模型 Imagen 也是如此。对于这种偏见,谷歌自己的结论是,Imagen“目前尚不适合公众使用”,并表示计划开发一种新方法来衡量“未来工作中的社会与文化偏见”,希望借此测试模型的后续迭代。

DALL·E 背后的功臣——深度学习模型 CLIP

DALL·E 能够将文字生成图像,背后全是深度学习模型 CLIP 的功劳。

2021 年,OpenAI 发布了CLIP,能够将文本和图像映射到相同的嵌入空间中,让用户判断文本描述是否与给定的图像匹配,该模型在很多计算机视觉任务中被证明是有效的。CLIP 以及类似的模型都是在图像-文本组合的数据集上进行训练,这些数据都是从互联网上搜集而来。随后,OpenAI 用 CLIP 创建了 DALL-E 模型

论文:https://arxiv.org/abs/2204.06125

据悉,CLIP 是一组模型,有 9 个图像编码器、5 个卷积编码器和 4 个 transformer 编码器。

卷积编码器是 ResNet-50、ResNet-101 和类似 EfficientNet 的模型,称为 RN50x4、RN50x16、RN50x64(数字越大,模型越好)。transformer 编码器是视觉变压器(或 ViT):ViT-B/32、ViT-B/16、ViT-L/14 和 ViT-L/14@336。最后一个在分辨率为 336×336 像素的图像上进行微调,其他的则在 224×224 像素上进行训练。

文本编码器是一个普通的 transformer 编码器,但具有掩蔽注意力。它由 12 层组成,每层有 8 个注意力头,总共有 63M 参数。有趣的是,注意力跨度只有 76 个 token(相比之下,GPT-3 有 2048 个 token,标准 BERT 有 512 个 token)。因此,模型的文本部分只适用于相当短的文本,不能在模型中放入大段文本。

评论