7 月 5 日,面壁智能联合创始人、首席科学家刘知远在 WAIC 2024 “模型即服务(Mass)加速大模型应用落地”论坛进行了《大模型时代的摩尔定律,迈入更高效的大模型时代》主题演讲,并首次对外介绍:

开源新一代高效、低能耗面壁小钢炮 MiniCPM-S 模型

助力开发者一键打造大模型 SuperAPP 的全栈工具集 MobileCPM

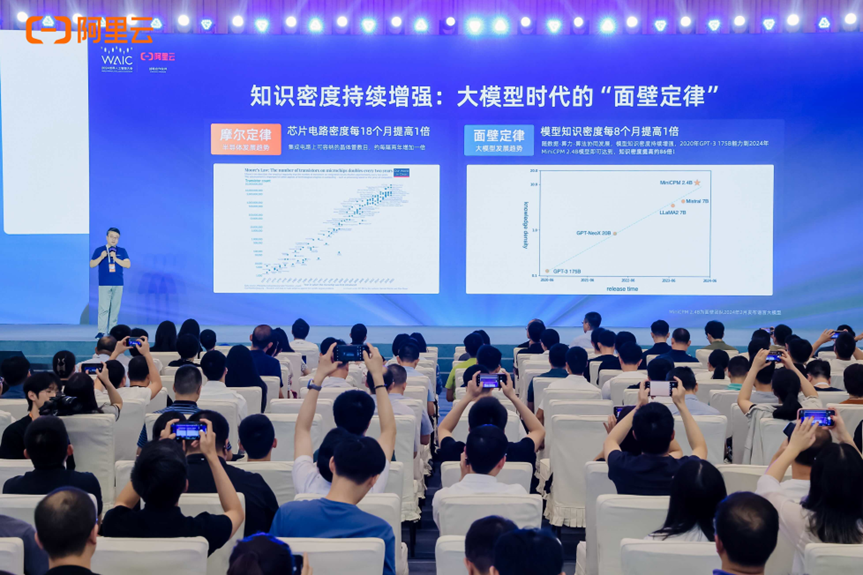

演讲开场,刘知远表示:“摩尔定律揭示了集成电路可容纳晶体管数目约每隔 18 个月便会增加一倍的规律,在过去几十年中给半导体和互联网行业的发展带来了科学指导意义;身处大模型时代,我们亟需新的“摩尔定律”。我们根据过去几年在大模型领域的深耕和实践,对大模型的发展趋势进行观察总结,提出了大模型时代的面壁定律:大模型的知识密度不断提升,平均每 8 个月提升一倍。”

其中,知识密度=模型能力 / 推理算力消耗。

如下图所示,相比 OpenAI 于 2020 年发布的 1750 亿参数的 GPT-3,2024 年初,面壁发布具备 GPT-3 同等性能但参数仅为 24 亿的 MiniCPM-2.4B ,把知识密度提高了大概 86 倍。

不过这还不是面壁的极限,面壁持续优化 Scaling Law,使模型知识密度不断提升,不断训练出计算更加高效且表现更强(参数规模降低,数值位宽降低,结构更加高效)的基础大模型。面壁新一代高效稀疏架构大模型由此而生。

MiniCPM-S:新一代高效低能耗「面壁小钢炮」

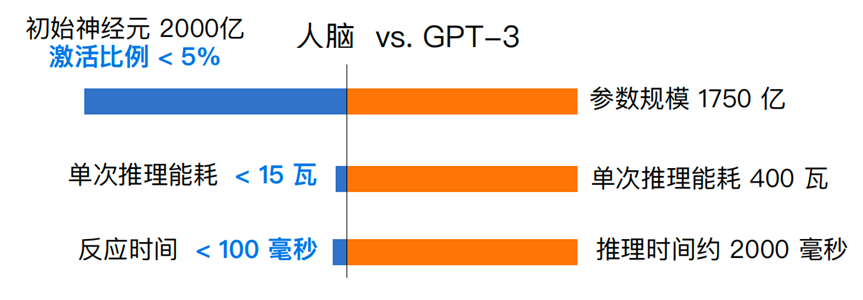

为何人脑中的神经元数量与当代最大的基础模型可比,但能源和时间消耗却远低于大模型?这背后,稀疏激活是大脑得以实现低能耗的一大核心“技术”,通过不同任务调取不同⼤脑分区神经元,能源与时间消耗⼤⼤降低。

和大脑类似,采用稀疏激活也能够在同等参数下减少大模型的推理能耗——稀疏度越高,每个词元(token)激活的神经元越少,大模型的推理成本和能耗就越少。MiniCPM-S 1.2B 采用了高度稀疏架构,通过将激活函数替换为 ReLU 及通过带渐进约束的稀疏感知训练 ,巧妙地解决了此前主流大模型在稀疏激活上面临的困境。

和同规模的稠密模型 MiniCPM 1.2B 相比,MiniCPM-S 1.2 具备:

Sparse-高稀疏低能耗:在 FFN 层实现了高达 87.89% 平均稀疏度,推理算力下降 84%;

Speed-神仙推理: 更少计算,迅疾响应。纯 CPU 环境下,结合 Powerinfer 推理框架,推理解码速度提升约 2.8 倍;

Strong-无损强大性能:更少计算量,无损下游任务性能;

另外,MiniCPM-S 1.2B 将知识密度空前提升:达到同规模稠密模型 MiniCPM 1.2B 的 2.57 倍,Mistral-7B 的 12.1 倍。

面壁“高效 Scaling Law” 仍在持续演绎。

相关开源链接:

论文地址:https://arxiv.org/pdf/2402.13516.pdf

模型地址:https://huggingface.co/openbmb/MiniCPM-S-1B-llama-format

PowerInfer 可直接运行格式:https://huggingface.co/openbmb/MiniCPM-S-1B-sft-gguf

开源大模型 APP 神器 MobileCPM:一键集成端侧大模型到 APP

此外面壁智能最新开源了业内首个端侧大模型工具集 “MobileCPM ",帮助开发者一键集成大模型到 APP。MobileCPM 开箱即用,包含了开源端侧大模型、SDK 开发套件以及翻译、摘要等丰富的 intent ,人人都可以一站式灵活地定制出满足不同应用场景需求的大模型 APP,低门槛速成「大模型创业者」。

MobileCPM 为开发者提供了三种模式:

基础模式:包含了丰富的适配端侧⼤模型 APP 的 SDK 套件发者基于此即可⾃由灵活地搭建⼤模型 APP,但在这个过程中,基座模型和智能体仍需要开发者⾃⾏开发和接⼊;

精装模式:在基础模式基础上,提供 1.2B 参数的⾯壁新⼀代⾼效稀疏⼤模型 MiniCPM-S,并且 MobileCPM 还支持任意端侧模型的集成,开发者可以根据具体需求选择替换其它端侧模型,并可以通过增加或修改 prompt 的方式定制多种 API,满足不同业务场景需求。

全包配件模式:在精装模式的基础上预装丰富的 intent,并提供保姆式教程,开发者也可使用自定义 intent,减少开发时间,⼤幅提升应⽤的丰富性。

本次发布,MobileCPM 默认集成了面壁新一代高效稀疏架构模型 MiniCPM-S 1.2B ,一次性将智能密度拉满,更兼具:

毫秒极速响应:得益于面壁小钢炮 MiniCPM 系列背后的高效大模型训练和推理工厂,MiniCPM-S 能够在毫秒级时间内完成推理和响应,确保用户体验的流畅性。

零推理成本:无需云端 GPU,MiniCPM-S 专为端侧设备而生,在保证性能强大的同时大幅降低了计算资源的消耗,使得端侧推理几乎 0 成本。

一键集成:大模型与 APP 无缝衔接;

预装多种 intent,提供保姆式教程;

基于 MobileCPM 一键开发的示例 APP(端侧模型由 MiniCPM-S 支持),在 iPhone 15 离线环境下毫秒级对话响应,推理速度轻松可达约 30 tokens/s,相当于人类语速的 18~30 倍。

MobileCPM 拉开了端侧AI生态序幕,基于 MobileCPM,任何开发者都可以轻松打造自己的 SuperAPP,有效解决推理成本问题。PC 和智能手机时代,所有原有的应用都值得用高效端侧模型尝试一遍!

MobileCPM 现已全面支持 iOS 系统,Android 版本也即将上线,敬请期待。

开源地址:

https://github.com/OpenBMB/MobileCPM

TestFlight 外测链接: