近日,研究人员发表了一篇学术论文,展示对于 GitHub Copilot 安全影响的研究成果。这项研究利用 GitHub Copilot 完成 Visual Studio Code 的代码。结果显示,在不同的场景中,大约 40% 的测试项目存在安全漏洞。

GitHub Copilot 被定义为“结对编程人工智能”,其来自 OpenAI 的先进人工智能系统被称为 Codex,在 GitHub 的高质量代码仓库上进行训练。因此,它的工作方式就像一个超级充电的 IntelliCode(VSCode 的智能补全插件)。Codex 是对 OpenAI 的生成式预训练 Transformer 3(Generative Pre-trained Transformer 3,GPT-3)机器语言模型的改进,它使用了深度学习来生成类似人类的文本。

GitHub 首席执行官 Nat Friedman 在 6 月 29 日的博文表示:“OpenAI Codex 对人们如何使用代码有广泛的了解,在代码生成方面显然比 GPT-3 更为强大,部分原因在于它是在一个包含更多公共源代码的数据集上接受训练的。”

GitHub Copilot 适用于广泛的框架和语言,但是这一技术预览版本在 Python、 JavaScript、 TypeScript、 Ruby 和 Go 方面表现出色。

该项目立即在各个方面引发了争议,它涉及到代码质量、法律和道德问题、取代人类开发者的可能性以及潜在的安全漏洞。

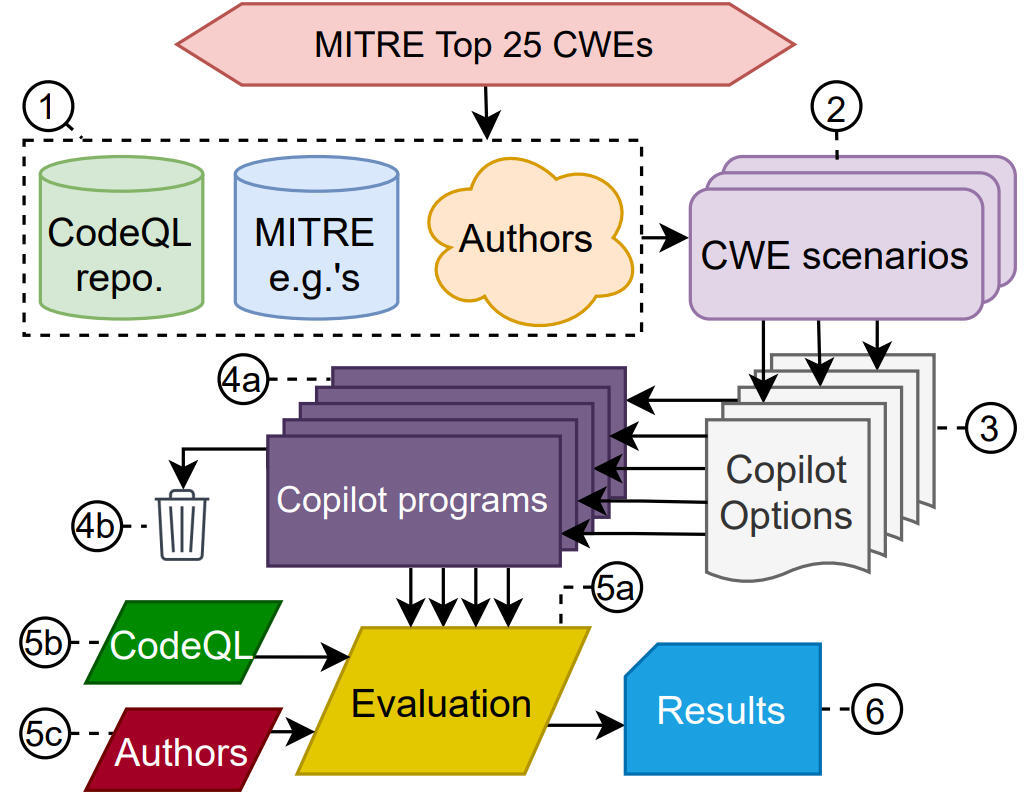

最后一项,即安全问题,也是这篇新的学术论文的核心,题为《GitHub Copilot 代码贡献的经验性网络安全评估》(An Empirical Cybersecurity Evaluation of GitHub Copilot's Code Contributions.)。这项研究旨在确定 Copilot 会产生不安全代码的趋势,为用户防范安全问题所需的审查量提供一个衡量标准。

通过对来自于 89 种不同代码完成场景的 1692 个程序的测试,通过严谨而细致的科学分析得出结论,40% 的程序存在漏洞。

这些情况与前 25 个高风险的通用弱点枚举(Common Weakness Enumeration,CWE)中的一个子集有关,CWE 是由非营利的 MITRE 安全组织管理的一个社区开发的软件和硬件弱点类型列表。

这项研究从三个方面追踪了 Copilot 的行为:

领域的多样性,其对领域的响应,即编程语言/范式;

弱点的多样性,在有可能出现漏洞的情况下,其生成的代码容易受到 CWE 前 25 个中每一个弱点的影响;

提示的多样性,它对特定场景的环境的响应(SQL 注入)。

这篇学术论文指出:“总体而言,从安全的角度来看,Copilot 对我们的方案的响应有好有坏,这是因为 Copilot 会产生很容漏洞(在所有坐标轴和编程语言中,39.33% 的顶级和 40.48% 的总选项都存在漏洞)。”

“顶级选项的安全性尤为重要:新手用户可能更有信心接受‘最佳’建议。由于 Copilot 是通过 GitHub 上的开源代码进行训练的,我们推测安全质量的变化源于社区提供的代码的性质。也就是说,在开源库中某些错误更加明显的地方, Copilot 将更多地复制这些错误。”

这篇学术论文与另一篇题为《评估在代码上训练的大型语言模型》(Evaluating Large Language Models Trained on Code)的论文一起,研究了安全以及法律和其他方面的影响。

上个月发表的那篇论文说:“Codex 有可能在一系列方面发挥作用。例如,它可以帮助入职用户熟悉新的代码库,减少有经验的编码人员的上下文切换,使非程序员能够编写出规范来实施 Codex 草案,并且有助于教育和探索。然而,Codex 也带来了重大的安全挑战,它并不总能生成符合用户意图的代码,而且也有可能被滥用。”

GitHub Copilot 也遭到了自由软件基金会的批评,该基金会宣称,要求发表更多的论文来解决围绕这个项目的哲学和法律问题是“不可接受和不公正的”。

这也引发了一些开发者的生存忧虑,他们担心,它和其他先进的人工智能系统可能会取代人类开发者。

作者(Hammond Pearce、Baleegh Ahmad、Benjamin Tan、Brendan Dolan-Gavitt 和 Ramesh Karri)在结论中说:“毫无疑问,像 GitHub Copilot 这样的下一代自动完成工具,将会提升软件开发者的生产力。”

“但是,尽管 Copilot 能够快速地生成大量代码,我们的结论却表明,当使用 Copilot 作为结对编程的人工智能程序员时,开发人员应该保持警觉。理想情况下,在训练和生成过程中,Copilot 应该配合使用合适的安全意识工具,以最大限度地减少安全漏洞的引入。尽管我们的研究为它处理与安全相关的场景的行为提供了新的视角,但是将来的工作还需要研究其它方面,包括安全强化训练的对抗方法。”

研究未提及加强功能以防范安全漏洞的涌入,因此可能会有更多的论文和研究正在进行中。

作者介绍:

Insane 是一家技术博客,专注于人工智能、机器学习、数据科学、应用开发和 Web 开发方面。

原文链接:

https://www.theinsaneapp.com/2021/09/github-copilot-generated-40-percent-insecure-code.html

评论