在 12 月 18 日举办的火山引擎 Force 大会上,字节跳动正式发布发布豆包视觉理解模型,不仅在数学、物理、图表、代码等更方面加强推理能力,而且千 tokens 输入价格仅为 3 厘,一元就可处理 284 张 720P 的图片,比行业价格便宜 85%。

豆包大模型全面升级

豆包视觉理解模型发布

研究显示,人类接受的信息超过 80%来自视觉。视觉理解将极大地拓展大模型的能力边界,同时也会降低人们与大模型交互的门槛,为大模型解锁更丰富的应用场景。

据火山引擎总裁谭待介绍,豆包视觉理解模型不仅能精准识别视觉内容,还具备出色的理解和推理能力,可根据图像信息进行复杂的逻辑计算,完成分析图表、处理代码、解答学科问题等任务。此外,该模型有着细腻的视觉描述和创作能力。

- 3.0x

- 2.5x

- 2.0x

- 1.5x

- 1.25x

- 1.0x

- 0.75x

- 0.5x

- 3.0x

- 2.5x

- 2.0x

- 1.5x

- 1.25x

- 1.0x

- 0.75x

- 0.5x

此前,豆包视觉理解模型已经接入豆包 App 和 PC 端产品。豆包战略研究负责人周昊表示:“豆包一直在努力,让用户的输入更快更方便”。为此,豆包产品非常注重多模态的输入和打磨,包括语音、视觉等能力,这些模型都已通过火山引擎开放给企业客户。

豆包 3D 生成模型首次亮相

会上,豆包 3D 生成模型也首次亮相。豆包 3D 模型采用 3D-DiT 等算法技术生成高质量的 3D 模型。

veOmniverse 是火山和英伟达一起合作的数字孪生平台,该平台与豆包 3D 模型结合使用,可以高效完成智能训练、数据合成和数字资产制作,成为一套支持 AIGC 创作的物理世界仿真模拟器。

下面是字节展示的 Demo,通过 veOmniverse 编辑器和文生 3D 快速搭建工厂车间场景。用户只需输入文本,即可实时生成 3D 场景和模型,满足仿真训练的多样化需求。

- 3.0x

- 2.5x

- 2.0x

- 1.5x

- 1.25x

- 1.0x

- 0.75x

- 0.5x

字节方面表示,通过豆包 3D 模型与 veOmniverse 的结合方案,团队可以高效完成智能训练、数据合成和数字资产制作,加速虚拟与现实的深度融合。

此外,其他豆包大模型多款产品也迎来重要更新。

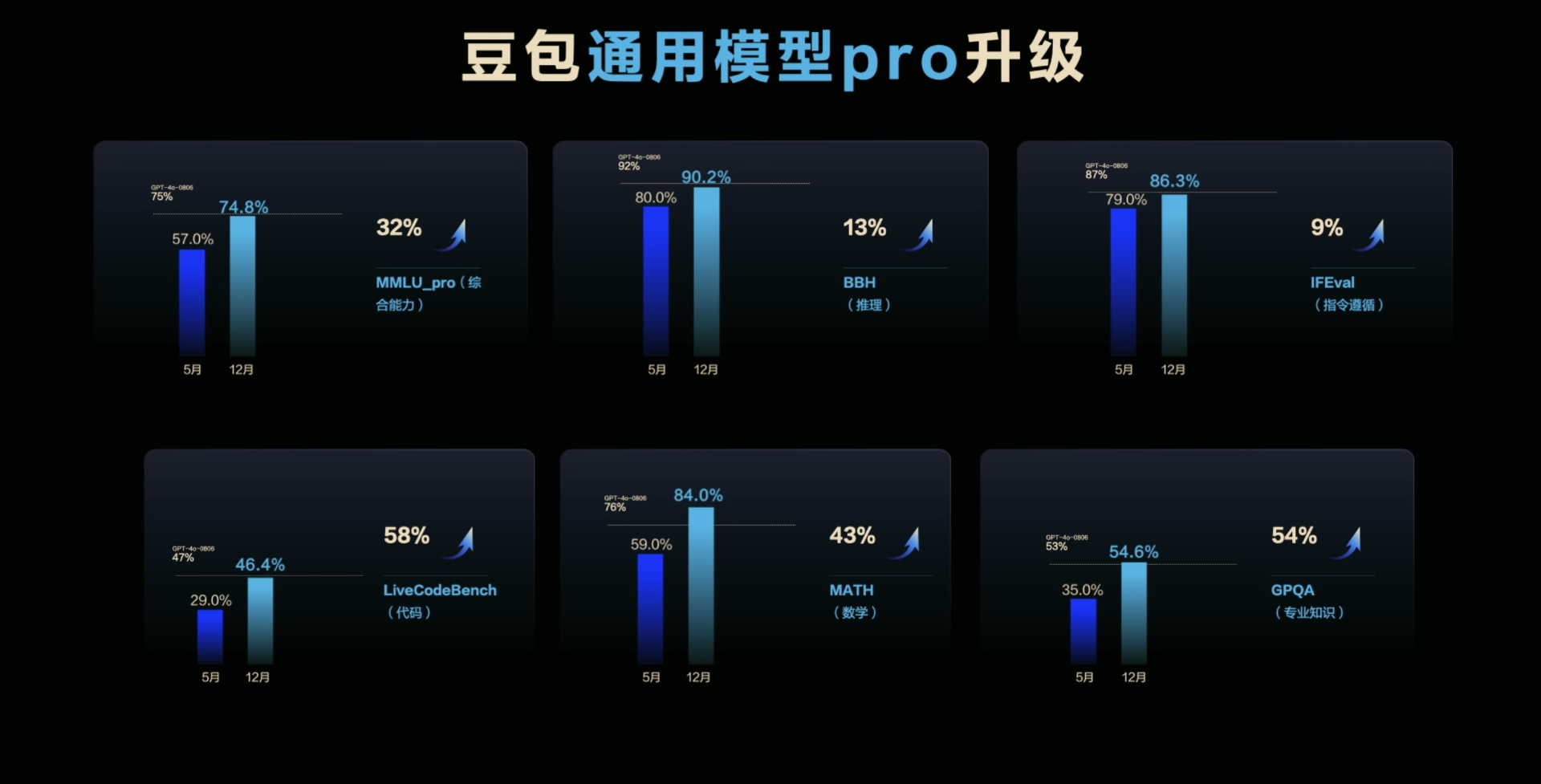

豆包通用模型 pro 已全面对齐 GPT-4o,使用价格仅为后者的 1/8。谭待介绍,在专业知识领域,豆包 pro 相比五月版本提升了 54%,这一效果略微领先于 GPT-4o;在综合任务处理能力上提升 32%,和 GPT-4o 持平;指令遵循提升 9%、推理能力提升 13%,在数学方面提升 43%。“可以看到,豆包 pro 已经全面对齐 GPT-4o 能力,甚至在部分复杂任务中表现更好,而且使用价格只有 GPT-4o 的八分之一。”

豆包音乐模型从原来生成 60 秒的简单结构,升级到生成 3 分钟的完整作品。新的模型能够合理运用旋律、节奏、和声等信息,使全曲保持连贯性。如果对生成的歌词不满意,还能开启局部修改模式。

- 3.0x

- 2.5x

- 2.0x

- 1.5x

- 1.25x

- 1.0x

- 0.75x

- 0.5x

文生图模型升级到 2.1 版本,该的新技能总结成一句话就是“一键 P 图,一键海报”,实现精准生成汉字和一句话 P 图的产品化能力,该模型已接入即梦 AI 和豆包 App。据介绍,豆包文生图 2.1 模型打通了 LLM 和 DIT 架构,构建了高质量文字渲染能力,可以让文字与整体画面的融合更为自然和实用。

- 3.0x

- 2.5x

- 2.0x

- 1.5x

- 1.25x

- 1.0x

- 0.75x

- 0.5x

大会还宣告,2025 年春季将推出具备更长视频生成能力的豆包视频生成模型 1.5 版,豆包端到端实时语音模型也将很快上线,从而解锁多角色演绎、方言转换等新能力。谭待表示,豆包大模型虽然发布较晚,但一直在快速迭代进化,目前已成为国内最全面、技术最领先的大模型之一。

即梦 Dreamina 张楠认为,生成式 AI 技术可以把每个人脑子里的奇思妙想快速视觉化,“像做梦一样”。即梦希望成为“想象力世界”的相机,记录每个人的奇思妙想,帮助每个有想法的人轻松表达、自由创作。

豆包日均 tokens 使用量 7 个月增长 33 倍

数据显示,截至 12 月中旬,豆包通用模型的日均 tokens 使用量已超过 4 万亿,较七个月前首次发布时增长了 33 倍。大模型应用正在向各行各业加速渗透。

据悉,豆包大模型已经与八成主流汽车品牌合作,并接入到多家手机、PC 等智能终端,覆盖终端设备约 3 亿台,来自智能终端的豆包大模型调用量在半年时间内增长 100 倍。

与企业生产力相关的场景,豆包大模型也获得了众多企业客户青睐:最近 3 个月,豆包大模型在信息处理场景的调用量增长了 39 倍,客服与销售场景增长 16 倍,硬件终端场景增长 13 倍,AI 工具场景增长 9 倍,学习教育等场景也有大幅增长。

谭待认为,豆包大模型市场份额的爆发,得益于火山引擎“更强模型、更低成本、更易落地”的发展理念,让 AI 成为每一家企业都能用得起、用得好的普惠科技。

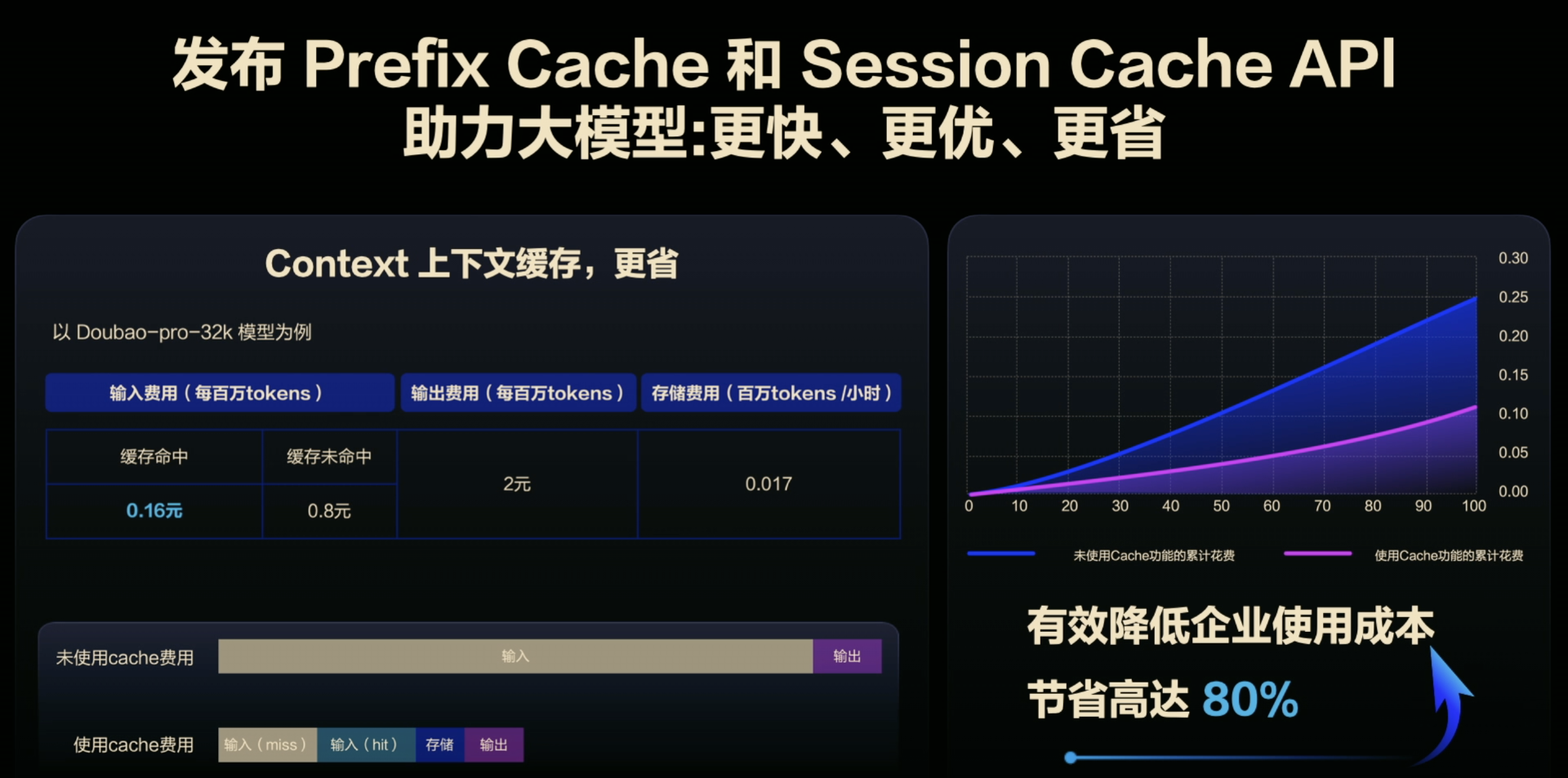

在公布豆包视觉理解模型超低定价的同时,火山引擎升级了火山方舟、扣子和 HiAgent 三款平台产品,帮助企业构建好自身的 AI 能力中心,高效开发 AI 应用。其中,火山方舟发布了大模型记忆方案,并推出 prefix cache 和 session cache API,降低延迟和成本。火山方舟还带来全域 AI 搜索,具备场景化搜索推荐一体化、企业私域信息整合等服务。

云原生是过去十年最重要的计算范式,大模型时代则推动着云计算的变革。火山引擎认为,下一个十年,计算范式应该从云原生进入到 AI 云原生的新时代。

基于 AI 云原生的理念,火山引擎推出了新一代计算、网络、存储和和安全产品。在计算层面,火山引擎 GPU 实例,通过 vRDMA 网络,支持大规模并行计算和 P/D 分离推理架构,显著提升训练和推理效率,降低成本;存储上,新推出的 EIC 弹性极速缓存,能够实现 GPU 直连,使大模型推理时延降低至 1/50、成本降低 20%;在安全层面,火山将推出 PCC 私密云服务,构建大模型的可信应用体系。基于 PCC,企业能够实现用户数据在云上推理的端到端加密,而且性能很好,推理时延比明文模式的差异在 5%以内。

谭待说:“今年是大模型高速发展的一年。当你看到一列高速行驶的列车,最重要的事就是确保自己要登上这趟列车。通过 AI 云原生和豆包大模型家族,火山引擎希望帮助企业做好 AI 创新,驶向更美好的未来。”

评论