Google Research 与哈佛大学最新的合作研究,提出了一种称为“Mip-NeRF 360”的新方法。该方法使用 NeRF(Neural Radiance Fields)创建 360 度完整神经场景(neural scene)的视频,进一步推动了 NeRF 适用于在任何环境中随意抽象,不再受限于桌面模型或封闭室内场景。

不同于大多数前期方法,Mip-NeRF 360 给定了对光线的解释方式,并通过建立关注区域边界降低了原本冗长的训练时间,实现可处理背景的扩展和天空这样的“非受限”场景。

新论文的标题为“Mip-NeRF 360: Unbounded Anti-Aliased Neural Radiance Fields”,由 Google Research 高级研究科学家 Jon Barron 牵头完成的。

为深入理解该论文的技术突破,首先对基于 NeRF 的图像生成做一个基础的阐释。

什么是 NeRF?

NeRF 网络并非真正地去描述一个视频,而是使用对单张照片和视频各帧的多个视角拼接出场景,因此更类似于一种基于 AI 实现的完全 3D 虚拟环境。该场景从技术上看只存在于机器学习算法的隐空间(latent space),但可从中任意抽取出大量的视角和视频。

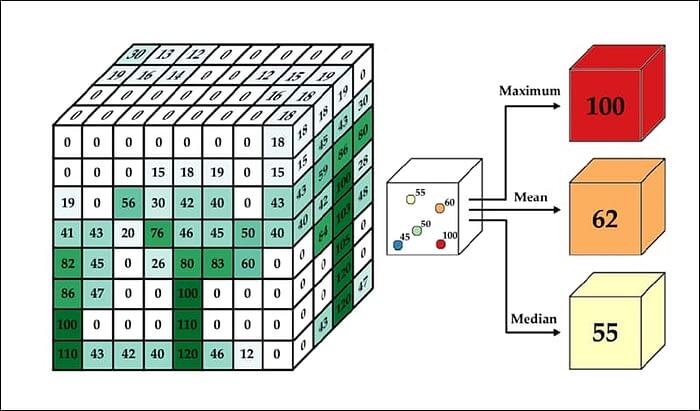

给定一张照片,通过训练其中的信息,生成一个类似于传统 CGI 工作流中体素网格(Voxel grids)的矩阵。矩阵中为 3D 空间中的每个点赋予了一个值,形成可被访问的场景。

该方法在完成各照片间必要的间质空间计算后,通过“光线追踪”确定光照路径上每张照片的每个可能像素点,并对其分配一个颜色值和透明度值。如果没有指定透明度,那么神经矩阵可能是完全不透明的,也可能是完为空的。

NeRF 矩阵与基于 CGI 的三维坐标空间不同,但与体素网格类似,其中的“封闭”对象并不存在任何内部表示。例如,一个架子鼓对象在 CGI 中是可以拆开查看其内部的,但在 NeRF 中一旦将该对象的表面不透明度值设置为 1,那么这台架子鼓就会消失。

像素视角的扩展

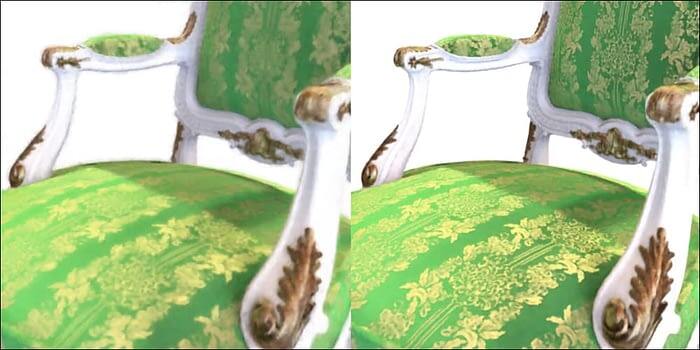

Mip-NeRF 360 是对2021年3月发表的一项研究的进一步拓展。该研究提出的 Mip-NeRF 方法通过在 NeRF 中引入有效的抗锯齿,避免做过量的超采样(supersampling)。

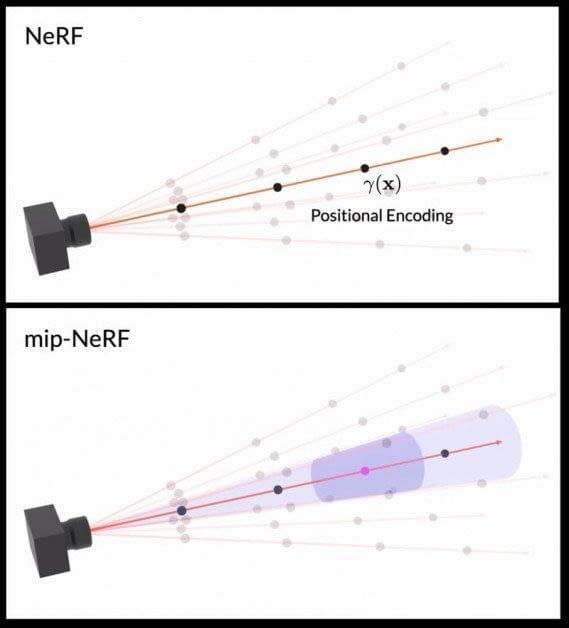

NeRF 一般只计算单条像素路径,易于产生早期互联网图像格式和游戏系统中所特有的“锯齿感”。为消除锯齿感边缘,已有方法通常是对相邻像素进行采样,并给出平均表示。

针对传统 NeRF 仅对单条像素路径采样,Mip-NeRF 提出了一种类似宽光束手电筒的“锥形”汇集区,对相关相邻像素提供了充分的信息,形成细节改进的低代价抗锯齿方法。

该方法显著改进了标准 NeRF 实现,如下图所示:

无界 NeRF

但 Mip-NeRF 依然存在三个尚未解决的问题。首先,要应用于天空这样的无界环境中,其中可能包含超远距离的对象。Mip-NeRF 360 通过对 Mip-NeRF 高斯空间应用Kalman扭曲解决了该问题。

第二,更大的场景需要更高的处理能力和更长的训练时间。为解决该问题,Mip-NeRF 360 使用小规模“提议”多层感知器(MLP,multi-layer perceptron)去“提炼”场景的几何形状。MLP 根据大规模标准 NeRF MLP 预测的几何形状,预先限定了当前形状范围,将训练速度提高了三倍。

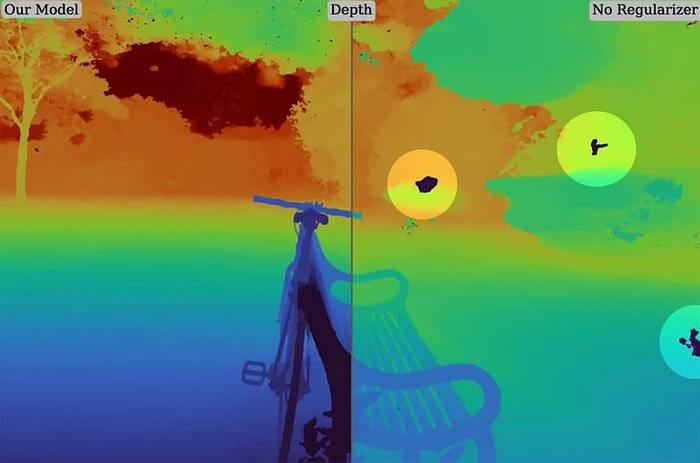

第三,更大的场景往往会导致需解构几何体的离散化存在模糊不清的问题,进而导致输出游戏玩家可能非常熟知的“画面撕裂”伪影。Mip-NeRF 360 通过新建对 Mip-NeRF 射线间隔的正则化处理而解决了该问题。