看新闻很累?看技术新闻更累?试试下载 InfoQ 手机客户端,每天上下班路上听新闻,有趣还有料!

在 Microsoft Build 2018 大会上,Matt Winkler 做演讲介绍了 Azure Machine Learing 的新特性。

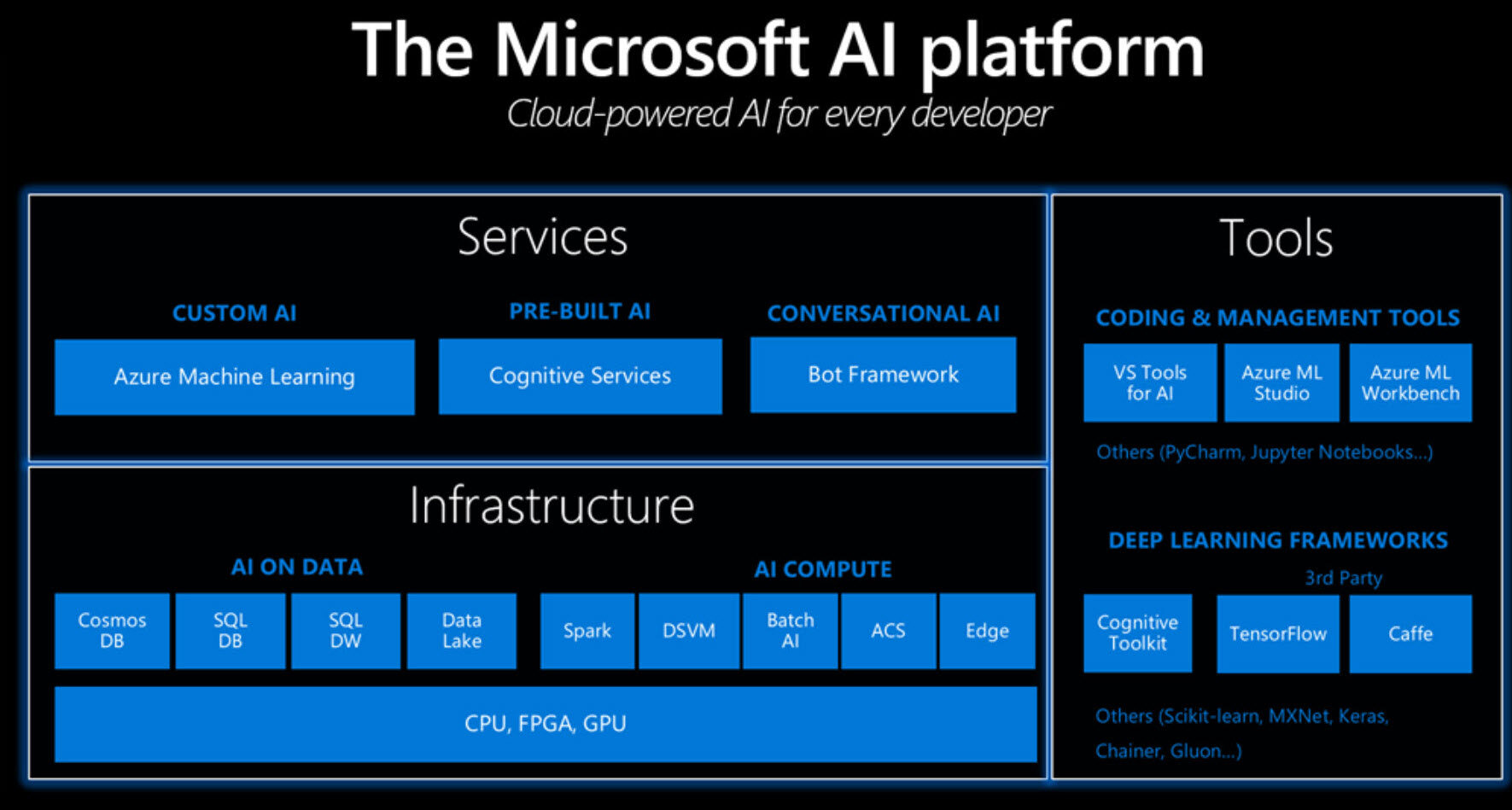

Azure Machine Learning(ML)平台构建在硬件平台层之上,支持用户自由选择任何工具和框架。如果在 Python 上运行,用户可在工具和框架中以三种方式实现服务,即对话式、预训练和定制 AI。

Azure ML 这是一种完全受控的平台,支持用户大规模地构建、部署和管理模型。它提供数据准备、模型的构建和训练,以及模型的部署支持敏捷开发,降低了一个模型从理念到实际可部署间的延迟。这一点非常必要的,因为用户并不能保证他所提出的模型会获得成功,或是可以发现模式。使用 Azure ML,用户可以在任何地方部署 AI,包括在云上、在本地、在没有因特网连接的远端设备,甚至拖拉机、传感器或相机等边缘(Edge)设备上。用户也可通过 Azure ML 获得遥测数据,帮助优化模型。

Azure ML 的新特性涉及多个方面,包括简化开发、单容器部署以加速开发 - 测试循环、使用 Azure Notebook 提供的 SDK 实现控制,以及帮助人们着手解决一些特定的问题。

为解决上述问题,Microsoft 当前在预览版中加入了多项功能。包括,使用硬件加速模型的 Brainware 项目,提供视觉、文本和预测功能的 Azure ML 软件包、ONNX 模型库、对 Azure Notebook 改进的 SDK 更新、超参数调优服务、添加了 ACI/AKS 的批量 AI 计算目标,以及物联网部署上的改进等。

Azure ML 软件包实现了当前框架中尚未提供的一些常用的视觉、文本和预测任务。它以 Python 软件包提供,可部署在 Azure ML 上。用户可以使用缺省功能,或对训练过程加以相当程度上的控制。

硬件加速模型使用FPGA ,在性能上获得了显著的改进。它支持实时打分,这使得用户可在新数据到来时进行增量训练。例如,用户可对单个图像在1.8 微秒内给出打分。这样,用户可以低代价在云规模上获得业界性能领先的实时AI 能力。

ONNX 模型库提供了一系列已开发的模型,用户可以直接使用这些模型,避免了在没有必要的情况下构建模型上的时间和开销。进而,用户可以跳过模型开发中的构建和训练步骤。ONNX 支持通用交换格式,用户可在各处使用模型,例如在应用内部,或是部署到服务中。

SDK 改进对提升了 Azure Notebook。SDK 可安装在任何可运行 Python 的地方,这使得计算目标易于配置,易于在笔记本上或大规模集群上运行训练作业。SDK 中集成了基于 Microsoft 企业内部经验构建的超参数调优。用户也可以自行注册并部署模型。

超参数调优支持对适用的模型给出争取的配置。用户可以定义所需搜索的参数,以及搜索的方法(是基于格点,或是随机查找等)。它还提供了提前终止策略,以供用户在发现所用的模型正在变坏时使用。这使得用户避免在毫无结果的查找上产生浪费。Microsoft 已发现,该特性在规模上可为用户降低约 50%的计算费用。进而,用户用同样的代价可以搜索更大的空间。

在实现视觉硬件加速开发包上,Microsoft 已与 Qualcomm 建立合作伙伴关系。用户可以部署经 Azure ML 训练的模型。Microsoft 还提供了用于物联网边缘设备的 Azure AI 工具包。其设计适用场景包括零售收银机处理收据、农田中工作的拖拉机等。在这些场景中,并不具有 IT 架构。