美国拉斯维加斯时间 2017 年 11 月 29 日上午,AWS CEO Andy Jassy 在一年一度的 AWS re:Invent 大会上发布了主题演讲。在短短两小时内,Andy 宣布了一系列令人兴奋的新服务。其中最重要的包括一款售价 249 美元的、名为 DeepLens 的人工智能摄像机;一套用于开放并部署机器学习算法的 SageMaker 平台;外加实时视频识别、文字翻译等多项应用层服务。

据 AI 前线了解,作为全场最大亮点的 SageMaker 平台,真正做到了“默默秒杀全场”的强大功能:除了免去了开发者进行数据清洗、建模的麻烦事儿,甚至还可以把开发者最头疼的调参优化交给机器处理。

显而易见,亚马逊公司希望各企业客户能够更好地运用人工智能技术——当然最重要的是,使用由亚马逊出售的人工智能工具。

通过本次大会公布的这一整套人工智能解决方案,亚马逊方面已经明确表示,希望能够乘这股人工智能的繁盛东风进一步拓展收入规模。与此同时,这批声明的发布也标志着亚马逊与同样拥有自家 AI 企业解决方案的谷歌在这一领域成为了竞争对手。

Amazon SageMaker

正如本文开头所说,这也许是本次 re:Invent 上发布的最大杀器,也可能是自各类开源机器学习框架流行以来在 AI 领域出现的最大杀器(如果使用体验真的如 Andy Jassy 所描述的那样好的话):普通开发者也想用机器学习来玩自己的数据,但是数据清洗、建模、各种试错太难太花时间,把开发者都吓跑了。SageMaker 的目标是,开发者只需要关心自己输入什么数据,自己想用什么框架和什么算法,其他的各种参数调优什么的脏活儿就让机器自己用机器学习来做,一键直达式机器学习服务,开发者值得拥有。

让我们来看看这个可能会让大数据工程师“失业”的神器到底有何玄机?

Amazon SageMaker 是一项全托管端到端机器学习服务,可帮助数据科学家、开发人员以及机器学习专家快速构建、训练并托管规模化机器学习模型。它的出现将显著加速一切机器学习工作,同时帮助大家快速将机器学习元素添加至生产应用程序当中。SageMaker支持当前机器学习行业中最为流行的各类框架(包括谷歌 TensorFlow、Facebook Caffe2、Pytorch 以及 MXNet 等),且允许开发者从查找必要数据起步对其 AI 模型进行训练,而后将成果发送给客户——整个流程皆可在此程序内实现。

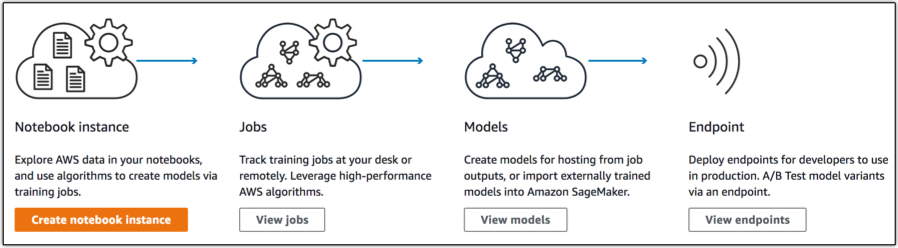

Amazon SageMaker 由以下三大主要部分组成:

- 创作(Authoring):无需进行任何设置,使用 Jupyter Notebook IDE 就能进行数据探索、清洁与预处理。你可以在常规实例类型或 GPU 驱动型实例当中运行此类工作负载。

- 模型训练:一项分布式模型构建、训练与验证服务。你可以利用其中的内置常规监督与无监督学习算法及框架,或者利用 Docker 容器创建属于自己的训练机制。其模型训练规模可囊括数十个实例,以支持模型构建加速。训练数据读取自 S3,训练后的模型成果亦可存放在 S3 存储桶内。最终得出的模型结果为数据相关模型参数,而非模型当中进行推理的代码。将关注点分开之后,开发人员能够更轻松地将 Amazon SageMaker 训练出的模型部署至其它平台(例如 IoT 设备)。

- 模型托管:模型托管服务可配合 HTTP 端点以调用模型进行实时推理。这些端点可进行规模扩展,从而支持实际流量;开发人员也可以同时对多套模型进行 A/B 测试。此外,你也可以使用内置的 SDK 构建这些端点,或者选择 Docker 镜像提供自己的配置选项。

上述组成部分皆可独立使用,这意味着 Amazon SageMaker 将能够轻松填补现有流程中的空白环节。换句话来说,当开发人员以端到端方式使用该服务时,将能够享受到由其提供的强大功能。

作为 AWS 免费项目的一部分,大家无需任何投入即可马上开始使用 Amazon SageMaker。在前两个月中,用户每月可获得 250 个小时的 t2.medium 记事本实例使用额度,50 个小时的 m4.xlarge 训练用实例使用额度,外加 125 个小时的 m4.xlarge 托管用实例使用额度。在免费范围之外,具体计费标准因实际服务区而定,但总体成本包含每秒实例使用、每 GB 存储容量使用以及每 GB 数据传入 / 传出等因素。(小编注:大家可以先试用之后看看 Amazon SageMaker 是否真如 Jassy 所说的这么智能。)

AWS 官方博客上对如何使用 SageMaker 提供了一份简易指南,下面截取并翻译了构建机器学习流程的部分,迫不及待的小伙伴们到官网查看完整的操作方法: https://aws.amazon.com/cn/blogs/aws/sagemaker/

SageMaker 使用指南

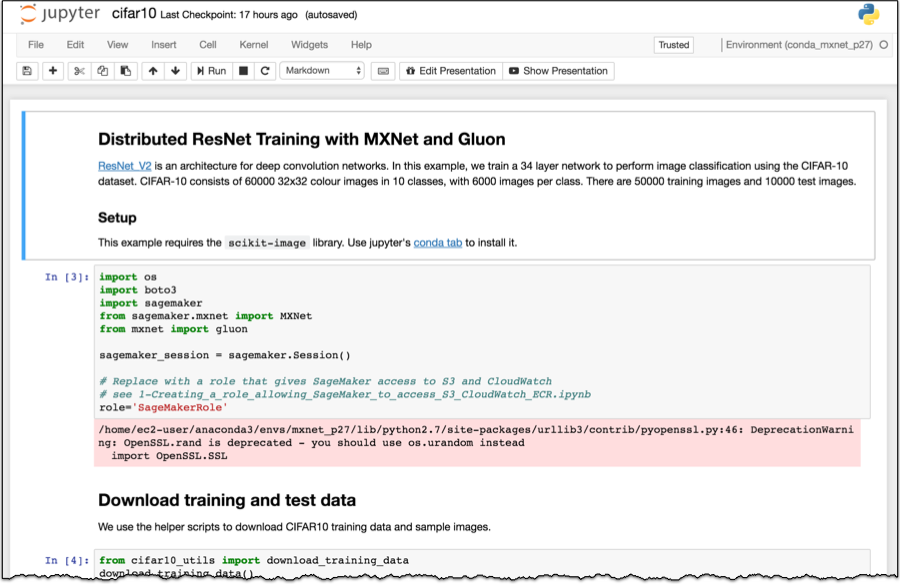

作为示例,这里假定我们需要构建、训练并部署一套基于 Apache MXNet 的图像分类器。这里我们使用 Gluon 语言、CIFAR-10 数据集,外加 ResNet V2 模型架构。

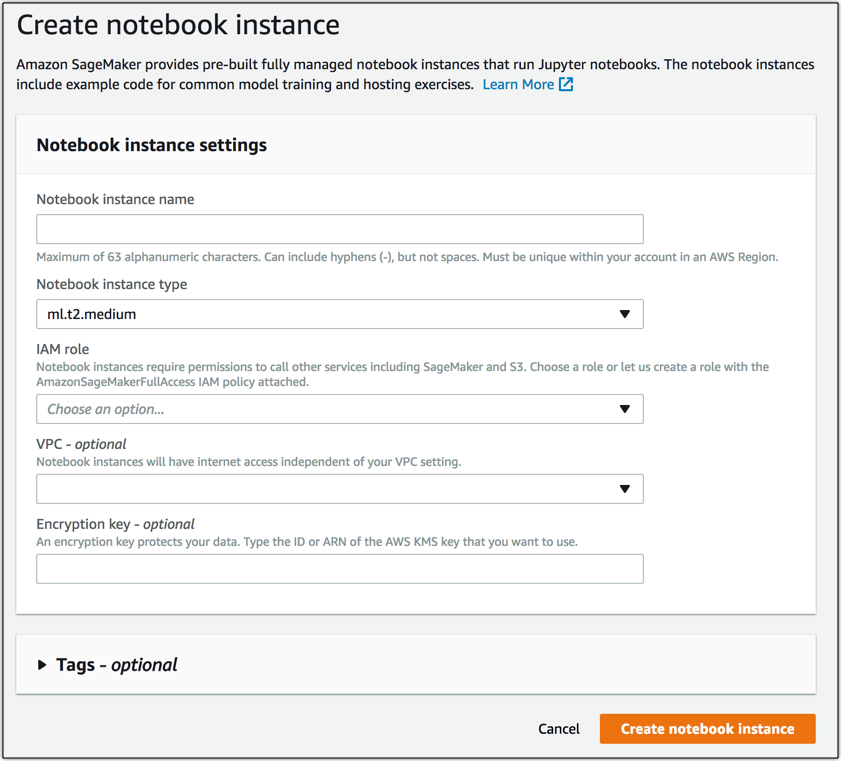

从 Jupyter Notebook 开始创作

在创建记事本实例时,其会启动一个配备有 Anaconda 软件包与常规深度学习库、具有 5GB 机器学习存储分卷,且包含多种示例记事本算法显示机制的机器学习计算实例。开发人员可以选择配置其中的 VPC 支持能力,从而在自己的 VPC 内创建 ENI 以简化并保护对资源的访问。

在实例配置完成之后,我们就可以打开记事本并开始编写代码!

模型训练

为了简洁起见,我们在这里忽略实际模型训练代码。不过对于任何 Amazon SageMaker 常规框架训练工作,您都可以通过以下方式建立起一套简单的训练接口:

def train({1} channel_input_dirs, hyperparameters, output_data_dir, model_dir, num_gpus, hosts, current_host): pass def save(model): pass

这里,我们打算在 Amazon SageMaker 基础设施中的 4 个 ml.p2.xlarge 实例之上创建一项分布式训练任务。顺带一提,这里已经将所有必要的数据下载到本地。

import sagemaker from sagemaker.mxnet import MXNet m = MXNet("cifar10.py", role=role, train_instance_count=4, train_instance_type="ml.p2.xlarge", hyperparameters={'batch_size': 128, 'epochs': 50, 'learning_rate': 0.1, 'momentum': 0.9})

现在,我们已经构建起模型训练任务,并可通过以下命令为其馈送数据:m.fit(“s3://randall-likes-sagemaker/data/gluon-cifar10”).

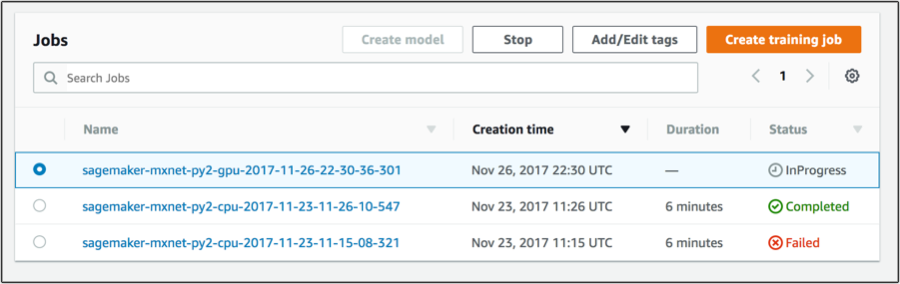

如果前往任务控制台,就会看到这项任务正在运行当中!

托管与实时推断现在我们的模型已经完成了训练,并可用于进行实际预测!利用之前提到的代码,这里创建并启动一个端点。

predictor = m.deploy(initial_instance_count=1, instance_type='ml.c4.xlarge')

而后运行以下命令调用该端点: predictor.predict(img_input)!

就这么简单,只需要不足 100 行代码,我们的端到端机器学习流程即构建完成。

AWS DeepLens

在今天于 AWS re: Invent 大会上发布的消息当中,DeepLens 摄像机可能是最吸引眼球的。与谷歌 Clips 类似,这同样是一款带有内置 AI 功能的摄像头;但与 Clips 不同的是,DeepLens 专门面向开发者,而非消费者。这是全球首款面向开发者且可实现深度学习的无线视频摄像头。Andy Jassy 对它的定位是个“学习机”——可以手把手帮助开发者学习如何入门图像识别 / 视频识别。

DeepLens 预装大量 AI 工具,包括光学字符识别、图像与物体识别等等。AWS 方面在一篇博文中解释称:“它能够帮你检测猫狗、人脸、家庭及日常环境下的各类物品、动作与行动等等。”

对于普通企业来说,DeepLens 则能够帮助大家更快测试并开发基于视觉的新型 AI 功能。举例来说,如果你正在运营仓库并希望自动扫描货品库存,则可购置一些 DeepLens 摄像机以完成这项工作。在这之后,还可以使用亚马逊提供的预训练 AI 识别基本物品,或者训练自有模型并将其加载至摄像头当中。每款 DeepLens 都配有一块英特尔凌动处理器,能够采集 1080p 视频与音频。为了实现连接与数据导出,DeepLens 还设有 Wi-Fi、USB 以及迷你 HDMI 接口。

如大家所预期,DeepLens 将与 AWS 推出的其它云及 AI 服务进行紧密集成。正如苹果公司努力将客户同其生态系统绑定起来一样,亚马逊也希望开发者们能够将其所有 AI 工具放到同一个平台上。

目前 DeepLens 已经在 Amazon.com 上预售,价格 249 美元,2018 年 4 月发货。

更多教程和介绍见:

https://aws.amazon.com/cn/blogs/ai/customize-and-display-aws-deeplens-project-output-on-your-laptop/

https://aws.amazon.com/cn/blogs/ai/extend-aws-deeplens-to-send-sms-notifications-with-aws-lambda/

其他应用层新服务

除了以上两项大杀器,Andy Jassy 也发布了一系列应用层的新服务。

- Rekognition Video:继去年发布的 Rekognition 图像识别服务之后,本次又发布了视频识别服务,可以做人物跟踪一类的任务并实时得出分析结果,相关消息在 re:Invent 大会前已经发布,详见 AI 前线之前的报道。

- Amazon Kinesis Video Streams:帮助用户把来自不同设备、不同制式的视频流上传云端的一项服务。

- Amazon Transcribe:音频转文字服务,目前支持英语和西班牙语。

- Amazon Translate:翻译服务。

- Amazon Comprehend:自然语言识别服务。

这一切究竟意味着什么?首先几乎可以肯定的是,这意味着 AWS 这一已然成为亚马逊营收主体的业务支柱未来还将帮助其赚取更多资金。AWS 这家子公司已经成为全球服务器容器销售领域的领导者,如果人工智能工具的市场需求持续增长,那么其必将在这一层面有所建树。凭借着 Alexa 这类产品,亚马逊公司已经证明其能够构建 AI 产品,并打算将其智能方案销售给其它企业。

上个季度,AWS 营收与 2016 年同期相比增长了 42%,本季度营收为 45.8 亿美元,远超分析师们的预期。(不过这一增长率同上个季度持平,这意味着其爆炸性的增长速度可能正在放缓。)而在被问及 AWS 最终是否可能成为全球规模最大的企业级科技公司并击败甲骨文时,CEO Andy Jassy 在今天发布公告前接受 CNBC 采访时表示,“也是有可能的。”

参考资料来源:

https://www.theverge.com/2017/11/29/16715688/amazon-ai-camera-developer-enterprise-tools

评论