昨天,在位于苹果公园的史蒂夫乔布斯中心,苹果公司全球市场部高级副主席 Philip Schiller 介绍了新近发布的 iPhone X 中面部识别系统背后的技术,其中包括在 A11 芯片中置入的专用神经网络引擎。

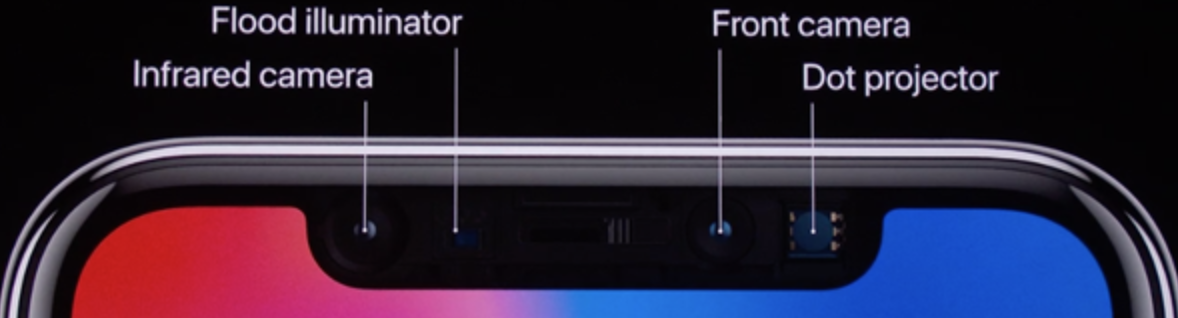

从上图可以看出,面部识别系统通过“TrueDepth”摄像头启动,该摄像头由红外 (IR) 摄像头、 泛光感性器、前端摄像头和点阵投影器组成。当用户注视 iPhone X 时,摄像头通过泛光感应器检测用户的面部。“红外摄像头则负责绘制 IR 图像,点阵投影器发送超过 3 万的不可视 IR 点。IR 图像和点阵图形被推送到神经网络中用于创建面部的数学模型。然后我们会把用户之前存储的面部模型和新生成的模型进行比较,如果匹配成功就解锁用户的手机”,Schiller 提到神经网络已经被训练到足以应对简单的欺骗攻击行为,例如使用照片解锁,而三星的Galaxy S8 则会被照片骗过。他们甚至与好莱坞的专业面具制造商和化妆师合作,防止那些企图击败Face ID 的任何尝试。他继续说到,人群中一个人通过Face ID 解锁你iPhone 的概率是一百万分之一,而Touch ID 的概率则是5 万分之一。用户相关数据以本地存储方式存储在苹果的安全区域,数据的处理也在本地完成,只需要用户在解锁时注视手机即可。

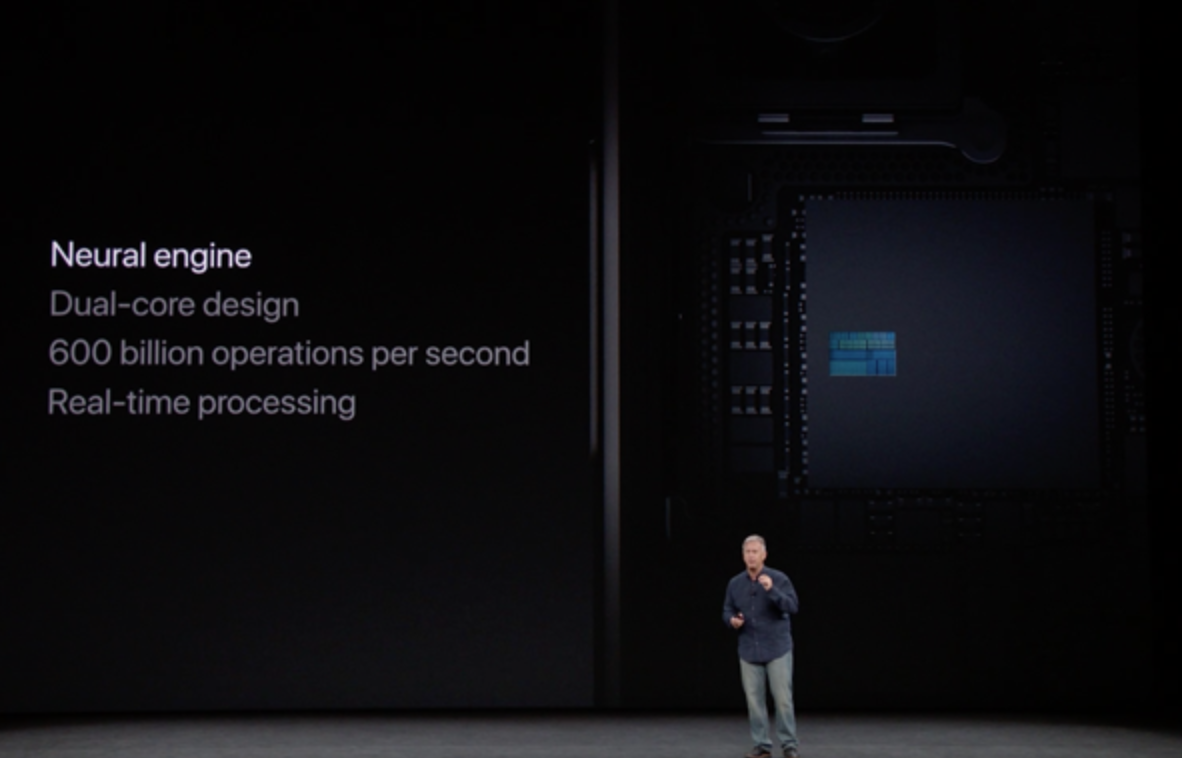

为了能够在手机上使用神经网络,苹果在A11 芯片上构建了他们的第一个神经引擎。神经引擎实际上是一对专门用于处理“特定机器学习算法”的处理内核,这些机器学习算法正是iPhone 内部高级功能例如Face ID、Animoji 以及增强现实(AR) 等apps 的源动力。Schiller 提到这些核可以支撑每秒6 千亿次的运算。

在设备端的处理性能上发力,是苹果公司应用机器学习算法的典型方式。可以看到,苹果公司在2016 年谈到了他们在隐私差异化上做的工作,在那年的WWDC 上,他们再次介绍了已经置入到iOS 11 的 CoreML 库。通过让手机本身的硬件具备 AI 处理能力,将会有更少的数据流出终端设备,这就能更好的保护用户的隐私。这也意味着手机能够在不借助持久数据连接的情况下就可以处理任务。

这项举措其实也是有大环境因素的,那就是工业界普遍都在推动针对 AI 任务的专业硬件的发展。谷歌已经设计了针对数据中心的两代处理器,其他一些公司也在效仿苹果把机器学习任务运行在终端设备上。中国技术巨头华为公司也把类似的神经处理单元植入 Kirin970 芯片中,号称其在处理像图像识别等任务上必传统 CPU 快出 20 倍之多。谷歌也发布了针对手机做过特定优化的 Tensorflow 版本 Tensorflow Lite 。

查看英文原文: Apple’s iPhone X Has Custom Neural Engine Processor Built In

感谢罗远航对本文的审校。

给InfoQ 中文站投稿或者参与内容翻译工作,请邮件至 editors@cn.infoq.com 。也欢迎大家通过新浪微博( @InfoQ , @丁晓昀),微信(微信号: InfoQChina )关注我们。