如果你是 B 站用户,那你肯定知道“羊驼 - 阿花”这个人气主播,它是一款由“虚拟偶像女团 A-SOUL”背后的虚拟娱乐公司“枝江娱乐”打造的一款 AI 主播产品,其动物的外形 + 萝莉声线,一经推出便迅速走红网络,甚至一跃成为 B 站人气 Top2 的流量 AI 明星。

在直播间,“羊驼 - 阿花”能够自然流畅的与粉丝互动,风趣的回答粉丝的问题,这种互动体验甚至比与真实的人物还要精彩。更令人惊叹的是 A-SOUL 技术团队为阿花设定了完备的形象成长曲线,经过持续的 NLP 训练后,阿花逐渐能够根据观众的反馈提供新鲜和爆点的内容输出,可以说是妥妥的“养成系主播”。

近年来,虚拟 AI 直播的发展迅速,已经从初期的概念验证阶段,逐渐发展成为一种主流的直播形式。目前,虚拟 AI 直播技术已经能够实现高度逼真的虚拟主播形象,通过自然语言处理、语音合成等技术,只需要较低的制作成本就可以在短时间内实现与观众的实时互动。

随着人工智能语音合成技术的提高和生成式对抗网络 GANs 的崛起,虚拟 AI 形象层出不穷,然而,“羊驼 - 阿花”的出现却依旧让人眼前一亮。在众多虚拟 AI 形象中脱颖而出,要说没有强大的技术支撑无异于痴人说梦。

那“羊驼 - 阿花”究竟有哪些过人之处?有哪些技术支撑?面对常见的虚拟 AI 形象技术难题,“羊驼 - 阿花”制作团队是如何解决的?

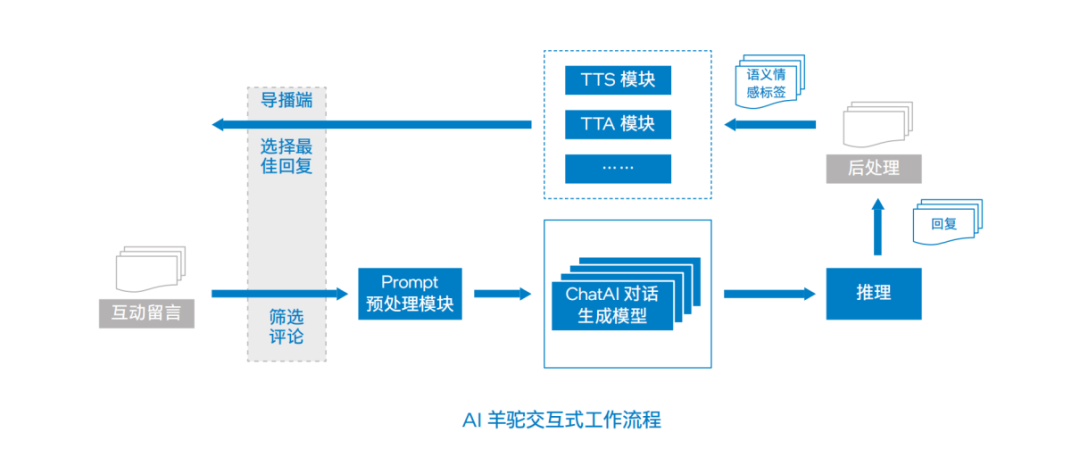

优化互动体验:AI 羊驼交互式工作流程解析

在虚拟偶像产业中,技术是组织竞争过程中取胜的关键。“羊驼 - 阿花”作为一款虚拟 AI 形象,能够在众多虚拟形象中脱颖而出,最主要的技术优势在于其基于 NLP 技术的交互式系统。这一系统使得“羊驼 - 阿花”能够理解并回应观众的互动留言,提供有趣的语言和动作表达,从而与观众建立更加自然和真实的交互体验。

为了让 “羊驼 - 阿花”具备良好的语言和行为成长曲线,A-SOUL 技术团队在后台交互式系统中,加入基于 LLM (Large Language Model,大语言模型) 构建的 ChatAI 对话生成模型来为阿花提供 NLP 能力。

“羊驼 - 阿花”交互式的工作流程包括多个模块,每个模块都经过了 A-SOUL 技术团队的深度优化。导播端获取观众的互动留言,经筛选后输入到 Prompt 预处理模块,这一模块负责对提示语进行加工,同时过滤掉有害词语。预处理过的、具有结构化格式的输入数据会进一步发送到多个 ChatAI 对话生成模型中。这些模型是已经过微调的,能够根据输入数据进行模型推理——根据不同风格的语料,从中进一步学习特定任务的知识,例如对话任务中的上下文理解和回复生成等。

紧接着,系统会对所生成的回复进行后处理,提取语义情感并作为标签同步到用于音频合成的 TTS(Text to Speech,文本转语音)、用于文本动画生成的 TTA(Text to Animation,文本转动画)等模块。值得一提的是,TTA 模块在结合了最新 motion diffusion 技术之后,能让 “羊驼 - 阿花”实现更多更有趣的语言和动作表达。同时,系统的内容安全与合规对齐模块也会对内容进行敏感关键词、偏见内容的校准,避免回复存在不公平性或歧视性。

基于目前对中文有着良好支持的 LLM,A-SOUL 技术团队在 NLP 工作流程中采用了已在大量开源中文语料上进行了预训练的中文模型作为系统的基座模型,并在流程中予以微调。其中,预训练过程是采用自监督学习(self-supervised learning)方法在大规模无标签文本数据集上进行,在这一过程中,“羊驼 - 阿花”对话生成模型学习到了大量的语言知识,如语法规则、语义信息等。微调则是在有标签的对话数据集上进行,“羊驼 - 阿花”对话生成模型能根据不同风格的语料,从中进一步学习特定任务的知识,如对话任务中的上下文理解和回复生成等。

优化性能方案:如何打破算力、成本、速度的不可能三角

技术优化是保证系统高效运行的重要前提,然而在 “羊驼 - 阿花”的性能表现上,A-SOUL 技术团队却始终面临巨大的挑战,主要涉及三个方面:

微调过程中可能出现过拟合现象,模型未完全理解输入语境,或可能对输入数据中的偏见进行过拟合等问题;

海量算力需求以及由此产生的计算成本巨大,特别是在系统的预训练阶段,数以亿计的参数和数据集处理需要基础承载平台具备强大的算力支持和突出的内存性能;

直播场景对于实时性的要求越来越严苛,这意味着需要系统能够快速生成内容,这对推理性能提出了巨大的挑战。拥有庞大参数量的 LLM 大模型需要大量的计算资源来开展推理,而在计算资源有限的情况下产生的过长推理时延,会使对话失去实时性效果。

要知道,PyTorch 是主流 AI 框架之一,对于 AI 羊驼 - 阿花方案的部署和运行至关重要。然而,PyTorch 在 CPU 平台上无法完全释放已有处理器的全部潜能,虽然 PyTorch 2.0 提供了 CPU 平台上的模型推理优化能力,但仅适用于静态且精度为 FP32 的模型。此外由于 LLM 推理任务中的 MHA 计算依赖于随生成词元自增长的缓存矩阵,导致 torch.compile 模块需要生成庞大的执行代码且优化模型所需时间长,因此 PyTorch 框架无法有效支持基于 CPU 平台的 LLM 推理优化。

为了解决算力、成本、速度之间的平衡问题,A-SOUL 技术团队计划引入了更经济的 CPU 推理平台以及更有针对性的优化方案,并开展多方位的模型优化及硬件加速——与英特尔合作推出了 Super-fused LLM FP16/AMX BF16 推理加速方案,针对用于 LLM 推理的 PyTorch 框架进行了优化。

英特尔第四代至强处理器提供的 AVX-512_FP16 和 AMX BF16 加速指令可以完美支持并加速 LLM 推理,该推理加速方案弥补了 PyTorch 在第四代至强处理器上进行 LLM 推理任务时的性能不足。同时,英特尔® oneMKL (Intel® oneAPI Math Kernel Library,英特尔® oneAPI 数学内核库) 加速推理计算,能够在减少权值存储空间的同时降低内存带宽压力,在保持精度的前提下显著提升推理性能;FP16 Flash Attention 算法通过算子融合及减少内存操作来降低模型中的 MHA 计算占比以提升推理性能。

另外值得一提的是,在传统的 PyTorch 推理过程中,大量的计算缓存被用于存储模型算子产生的中间结果。然而,有了 Super-fused LLM FP16/AMX BF16 推理优化方案后,这一情况可以得到显著的改善。可以说,基于新方案,“羊驼 - 阿花”模型成功地融合了 PyTorch Transformer 算子,并且能够根据模型推理运行时的具体输入,更精确地预测所需的缓存空间。这不仅实现了融合算子间的缓存复用,还有效地提升了推理性能。

应用优化方案后的 A-SOUL 技术团队在 “羊驼 - 阿花”的性能上取得了显著的提升。在单实例场景下,“羊驼 - 阿花”方案中的不同 LLM 可取得 1.89 至 2.55 倍的推理性能提升;在多实例场景中,由 IPEX 带来的优化,可令其推理性能在单实例基础上进一步提升 1.16 至 1.2 倍。

从实际测评数据来看,A-SOUL 技术团队通过该优化方案实现了成本和生态上的有效收益。在成本方面,英特尔第四代至强®可扩展处理器完全胜任对参数规模为 10B 及以下的 LLM 推理任务,该方案帮助团队以更低的成本满足推理性能要求,优化后的 CPU 平台在环境配置方面也更加简单,达到了全面降本增效的目的。在生态方面,该方案基于 PyTorch 框架开发,完整继承 了 AI 羊驼 - 阿花方案中 LLM 的文本生成模块,与 PyTorch 模型推理接口完全一致,使用者无需为调用推理优化方案进行额外的代码开发,更易部署和落地。

强强联合塑造未来 AI 直播生态

A-SOUL 技术团队在 AI 算法和直播技术方面有着深厚的积累,而英特尔则以其强大的计算能力和算法支持为 AI 直播的研发提供了有力保障。通过技术互补和创新,两家公司共同研发出了更加智能化的 AI 主播算法,提高了直播的互动性和社交性。可以说,“羊驼 - 阿花”不仅仅是一个 AI 主播,它也是 A-SOUL 团队与英特尔技术合作的结晶,其代表了 AI 技术在直播领域的最新突破。

面向未来,A-SOUL 与英特尔的合作还有很大的发展空间。在技术研发方面,双方可以继续深化合作,共同探索 AI 直播技术的更多可能性,例如可以共同研发更加智能化的直播算法、提高直播的质量和用户体验等;在市场拓展方面,双方可以共同开拓更多的市场领域,如针对不同行业和场景推出定制化的 AI 直播解决方案以满足更多用户的需求。此外,在产业链合作方面,双方可以进一步整合资源,完善产业链布局,如共同投资建设 AI 直播技术的研发中心和生产基地,从而提高整个产业的竞争力和创新能力。

随着 AI 技术的不断进步,AI 直播也呈现出了更为智能化、个性化的特点——通过精准的用户画像分析,AI 主播能够实时调整直播策略,提供更符合观众口味的内容。借助先进的交互技术,AI 主播将打破传统直播的界限,让观众更加沉浸于直播体验中。

总体来说,AI 直播技术主要分为四个阶段——第一阶段,AI 对话机器人仅拥有简单的外形,后来语气逼真度和响应速度逐渐提升;第二阶段,用户可以根据自己的喜好定制 AI 机器人的外观与语音,赋予 AI 独特的个性。第三阶段,AI 可以在虚拟世界中展现自己独立的行为能力,不再局限于简单的对话交流,它们逐渐拥有自己的故事线,为直播内容注入丰富的情节。第四阶段,AI 可以实现如“西部世界”般栩栩如生的实况直播场景,为观众带来前所未有的沉浸式体验。

而当前,中国正处于 AI 直播领域的初始阶段,随着商业化产品应用的逐渐崭露头角,预计在 5 年内,众多形态各异的 AI 产品将喷发式涌现,而首个“拥有完整故事背景和世界观”的产品问世的那一天,将就是 AI 技术在游戏和直播领域成熟的那一天。

我们有理由相信,在不远的未来,不断进步的技术和日益增长的用户需求一定能驱动 AI 直播为我们带来更加丰富多彩的直播体验。同时,我们也期待看到更多像 A-SOUL 团队与英特尔这样的强强联合案例,共同推动 AI 技术的发展和应用创新。