在当今的数字化浪潮中,大模型以其卓越的语言理解和生成能力,正成为推动业务创新的重要引擎。随着“模型即服务”在云服务领域的崛起,企业对于高效、经济的 AI 模型应用的需求日益迫切。然而,现实中大模型的应用并非一帆风顺,企业在尝试将其融入业务流程时,往往面临着效果不尽人意、成本高昂以及落地难度大等诸多挑战。

在这样的背景下,大模型的实践应用不应仅仅是市场的“噱头”,企业客户迫切需要真正“好用、能用、有用”的产品和服务。更重要的是“性价比”,产品能力固然重要,但在市场竞争如此激烈的今天,价格已经成为了企业客户决策的第一要素。

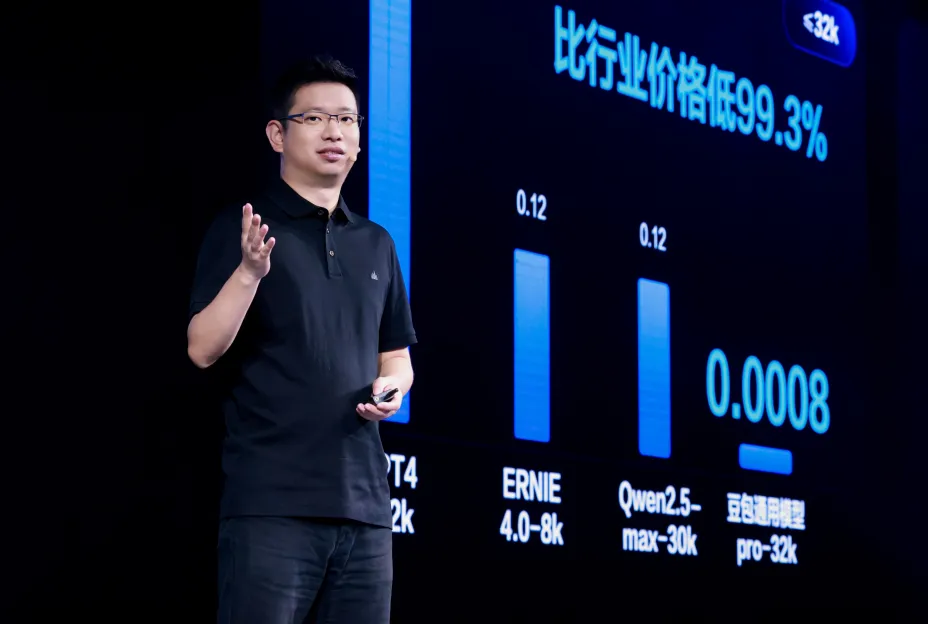

5 月 15 日,2024 火山引擎 FORCE 原动力大会上,火山引擎重磅发布了豆包大模型家族和火山方舟 2.0 等一系列创新产品,并且宣布豆包主力模型在企业市场的定价为 0.0008 元 / 千 tokens,0.8 厘就能处理 1,500 多个汉字,比行业便宜 99.3%,是当之无愧的“超低价”。

“大模型的超低定价,来源于我们在技术上有信心优化成本。” 火山引擎总裁谭待在大会上表示,技术上的优势,为火山引擎提供了定价的底气。火山引擎不仅想为企业提供模型服务,更致力于打造一个完备而有效的全栈 AI 技术服务生态,为企业提供模型服务的全链路解决方案。

那么,相对于市面上的其他产品,字节跳动的模型产品和火山引擎的模型服务到底有何优势?火山引擎又将如何打造全栈模型服务能力,为企业的智能化升级提供支持?

模型应用进化,实践是最好的磨刀石

相比市面上大多数 AI 产品的“大张旗鼓”,字节跳动的 AI 产品一直保持着低调作风,但不知不觉中,以豆包 App、扣子为代表的字节系 AI 应用已然成为了用户的热门选择。

以豆包 App 为例,自 2023 年 8 月上线以来,就攻陷了各大应用市场的下载榜单,据悉,截止目前,豆包 App 下载量已经超过 1 亿,桌面端 +App 的月活用户数量已经达到了 2600 万,有超过 800 万个智能体被创建,是当之无愧的明星 AI 产品;扣子也早已在海内外打出名气,凭借超强的扩展性和性价比攻城略地。能在火热的 AI 应用市场中脱颖而出,并在大众对于 AI 认知趋于理性后,仍旧保持着高访问量、调用量和活跃度,豆包 App 和扣子的“实力”有目共睹。

这直接戳中了当下 AI 应用普遍面临着的痛点:不怕不好用,只怕没人用。基于大模型产品的技术特性,只有最大的使用量,才能打磨出最好的模型,只有最多的实践数据,才能催动“智能涌现”的发生,而在庞大使用量和实际场景的锻炼下,应用才能更好地满足用户的使用需求,实现持续迭代。

遗憾的是,对于很多产品来说,没有 GPT 那样的顶流地位,想实现“应用进化”非常艰难。

而作为行业中的“标杆案例”,豆包大模型就是在“千锤百炼”下长成的。现如今,豆包大模型平均每天处理 1200 亿 tokens(约 1800 亿汉字),生成 3000 万张图片,对于火山引擎和豆包大模型来说,模型服务早已不是“纸上谈兵”,其正在用户、企业的实际应用中不断迭代与进化。

首先是字节跳动内部 50+ 业务的持续打磨。基于字节跳动庞大的业务生态,豆包大模型光是在内部就能接触到足够丰富的业务场景。据悉,豆包大模型不仅参与到办公智能助手、数据智能分析、编程助手等企业内部的办公开发场景,还覆盖了电商导购、售后客服、营销创作等前端对客场景,在字节跳动 50 余个实际业务的打磨之下,豆包大模型被应用在一线使用场景中,在字节系产品的庞大用户量、数据量的催化下,豆包大模型得以快速迭代。

除了内部打磨、C 端实践,企业端场景的应用至关重要,这决定着模型是否能真正成为“生产力工具”。现如今,豆包大模型已经被广泛应用于火山引擎的企业服务中,覆盖了智能终端、汽车、金融、消费等多个重要行业,更多触达了 OPPO、vivo、小米、荣耀、三星、华硕、招行、捷途、吉利、北汽、智己、广汽、东风本田、海底捞、飞鹤...... 等知名企业。

大会上,火山引擎与企业客户宣布共同成立两大模型联盟:智能终端大模型联盟与汽车大模型生态联盟,在智能终端 AI、汽车全场景 AI 等领域进一步展开探索,这也让豆包大模型的未来发展充满了更多可能性。

豆包大模型家族发布:多元场景、安全可控

实践应用是模型能力进化的关键环节,但如何为模型服务开拓更多用户、寻找更多落地机会,则需要更深入的思考。不得不承认,当前企业客户对于模型服务存在一种“为了用而用”的误区,这往往导致模型服务与实际需求之间出现偏差。当需求得不到满足时,对前沿技术的过度依赖也可能变成一种资源浪费,这不利于整个行业的可持续发展。

对于火山引擎等行业内的领军企业来说,谁能真正洞察企业客户的深层需求,谁就能占据有利地位。从当前云计算与智能化融合的趋势来看,AI 及大模型若想助力企业业务创新升级,主要需要实现三大目标:

利用 AI 打造差异化优势,提升业务场景的创新能力,助力用户体验升级。

降低成本、提高效率,通过智能化手段提升业务效率,加快决策和工作流程。

在满足企业多样化需求的同时,确保模型服务的安全性和稳定性。

能满足上述三大目标的模型服务产品,不仅要有模型本身的卓越性能,还需要满足可用性、易用性、成本可控、安全合规等需求。这就要求模型服务产品本身不能有明显的缺陷。

或许正是基于这样的洞察,字节跳动选择推出豆包大模型家族,加持火山引擎的模型服务能力。

首先,模型的性能效果仍然是核心。正如上文所述,豆包大模型在模型效果上实现了显著提升。以字节跳动自研的 LLM 模型专业版“豆包通用模型 pro”为例,其最大窗口尺寸可达 128K,且全系列可精调,具备强大的理解、生成、逻辑和记忆能力,适用于问答、摘要、创作、文本分类、角色扮演等通用场景,功能全面。

针对不同的业务场景和多模态需求,豆包大模型也实现了进一步的进化。除了通用模型,还包括 5 秒即可实现声音 1:1 克隆的声音复刻模型、具有超自然语音合成能力的语音合成模型、准确率极高的语音识别模型、扣子背后的主力模型 Function Call,以及角色扮演模型、文生图模型、向量化模型等。它们共同构成了豆包大模型家族,旨在满足各行业、多元场景的服务需求。

针对企业的个性化需求,豆包的主力模型提供了通用全面的 pro 版本和低延迟、高性价比的 lite 版本,企业可以根据自身需求灵活选择。同时,全系列语言模型均支持继续预训练或 SFT 精调,使企业能够基于自身业务场景,自主开发更适配的 AI 应用。豆包将模型精调和预训练的能力赋予客户,使企业能够实现“一个模型,多元应用”。

更重要的是,这一次豆包大模型真正做到了“人人用得起”,豆包主力模型在企业市场的定价只有 0.0008 元 / 千 tokens,0.8 厘就能处理 1,500 多个汉字,比行业便宜 99.3%。在这样的“卷”的价格之下,企业可以真正做到降本增效,用低成本创造新价值。

大会上,火山引擎总裁谭待表示,有信心通过技术优化降低成本。例如通过对模型结构的优化调整、在工程上从以前的单机推理演进到现在的分布式推理、把不同负载的推理混合调度,这些技术能够把各种各样底层算力用得更好,同时实现大幅的降低成本,让每一家企业都能用得起大模型。

在金融、科技等行业客户极为关注的安全问题上,豆包大模型作为首批通过大模型服务安全备案的产品,满足了合规性需求。在火山方舟平台全周期安全可控方案的支持下,豆包大模型在数据加密传输、信息内容安全、防止恶意攻击和数据泄露等方面提供了有力保障,让企业能够放心使用。

从应用到平台,火山引擎全栈模型服务是如何炼成的?

豆包大模型家族已经为火山引擎的企业客户提供了强大的模型服务解决方案,但这只是一个开始。火山引擎的终极目标是通过其大模型云计算能力,全面赋能企业,助力其在 AI 时代实现数字化与智能化的升级。这一愿景在火山方舟 2.0 的推出中得到了充分体现。

作为一站式大模型服务平台,火山方舟 2.0 在性能和系统承载力方面实现了显著提升。平台拥有海量资源,能够通过资源潮汐调度保障流量高峰时业务的稳定性。同时,其瞬时可用的特性,使得创建模型接入点后 5 秒即可使用,大大提升了业务的响应速度。极致弹性的扩缩容能力,为企业有效支撑突发流量和业务高峰提供了保障,同时降低了成本。

在企业 AI 应用的稳定性和成本控制方面,火山方舟 2.0 为企业级 AI 应用的落地提供了坚实的基础。而三大核心插件则进一步加速了企业 AI 应用的产出与创新。

联网插件提供了与头条、抖音相同的搜索能力,结合多模态交互方式和领先的意图识别技术,大幅提升了模型的信息获取能力。内容插件则依托字节跳动体系的海量内容资源,通过基于意图的垂直内容信息检索,提供了内容时效性更强的解决方案。RAG 知识库插件以其毫秒级的高性能检索和流式知识库索引更新,降低了企业在使用 AI 模型时的“幻觉”,提升了应用的实用性。

扣子专业版的推出,使得企业或创业者可以接入更多高级特性,享有企业级的各项能力。在扣子原有功能基础之上,扣子专业版提供企业级性能的智能体运行时。保障各项服务 SLA,包括但不限于并发量、响应时长等。并开放 SSO、组织权限管理等企业特性。

可以预见,未来将有越来越多的企业利用扣子专业版进行多场景的开发,非编程人员也可以更好地使用上 AI,为工作全流程进行提效。除此之外,火山引擎还推出了智能创作云 2.0,发布了智能数据洞察 AI 助手 ChatBI、销售 AI 助手 Sales Copilot 等 AI 应用,帮助企业快速实现 AI 升级。

全栈 AI 技术服务生态的构建不仅仅在于模型服务本身和 AI 应用开发,基础设施的匹配升级同样重要。在这次升级中,火山引擎还对旗下云底座进行了全面升级。会上,火山引擎全新发布了混合云 veStack 智算版,其拥有着万卡集群组网,3.2T 高性能无损网络的超大规模优势、可以实现 97.78% 训练加速比和分钟级故障发现和自愈的极致性能,还能够适配十余种 GPU 和主流国产化 GPU,应对本地部署需求。

通过这些升级,火山引擎展现了其全栈 AI 技术服务生态的构建能力。从基础设施到模型即服务(MaaS)、模型应用,火山引擎的技术服务生态为企业提供了全方位的支持,帮助企业在 AI 时代实现数字化与智能化的升级,推动业务的持续增长和创新。

火山引擎的这一系列动作,无疑是对 AI 技术应用的一次深刻洞察和前瞻性布局。火山方舟 2.0 的推出,不仅为企业提供了更加强大和灵活的 AI 应用开发平台,更是在推动整个行业向更高效、更智能的方向发展。随着火山引擎全栈 AI 技术服务生态的不断完善,我们有理由相信,它将为企业带来更多的可能性,开启 AI 技术应用的新篇章。