DeepMind 是谷歌的母公司 Alphabet 旗下的人工智能实验室,它长期以来一直投资于博弈人工智能。这家实验室的理念是,博弈尽管没有明确的商业用途,但它是一个独一无二的与认知和推理能力有关的挑战。这使得它们可以作为一个有用的基准来衡量人工智能的进展。最近数十年,博弈催生了一种可以进行自学习的人工智能,它可以赋能计算机视觉、自动驾驶汽车,以及自然语言处理。

作为 DeepMind 研究工作的延续,它创建了 Player of Games 的系统,这家实验室在预印本服务器 Arxiv.org 上发表的一篇研究论文中,首次披露了这一系统。

与 DeepMind 之前开发的其他博弈系统不同,如赢得国际象棋的 AlphaZero 、击败《星际争霸 II》(StarCraft II)的 AlphaStar,Player of Games 既能在完美信息博弈(如中国棋类博弈围棋和国际象棋)中表现良好,也能在不完美的信息博弈(如扑克)中表现良好。

像交通拥堵时的路线规划、合同谈判、甚至与客户的互动等任务都涉及妥协,并考虑到人们的偏好如何重合和冲突,就像在博弈中一样。即便人工智能系统是自利的,它们也可能通过协调、合作和在人群或组织之间的互动而受益。因此,诸如 Player of Games 之类的系统,可以对他人的目的和动机进行推理,从而为人工智能在与他人的协作中取得成功,包括解决与保持信任相关的问题铺平道路。

不完美信息博弈与完美信息博弈

不完美信息博弈在博弈过程中对 Player 隐藏了信息。与此形成鲜明对比的是,完美信息博弈从一开始时就把所有的信息都展示了出来。

完美信息博弈,要想取得胜利,必须要有足够的预先思考和规划。Player 需要在博弈中解决他们所看到的一切,并且确定他们的对手可能会怎么做,同时努力实现获胜的最终目标。而不完美信息博弈则要求 Player 考虑隐藏的信息,并思考下一步如何行动才能获胜,包括可能的虚张声势或联手对抗对手。

AlphaZero 这样的系统在象棋等完美信息博弈中表现出色,而诸如 DeepStack 和 Libratus 等算法在扑克这样的不完美信息博弈中表现得非常好。但 DeepMind 宣称,Player of Games 是首个“通用且健全的搜索算法”,它在完美信息博弈和不完美信息博弈都表现不错。

尽管 Player of Games 具有极强的通用性,但它不能仅仅进行任何博弈。Schmid 说,这个系统必须要把博弈中的每一个 Player 所有可能的视角都考虑进去。尽管在完美信息博弈中只有一个视角,但是在不完美信息博弈中,这样的视角可以有很多,比如,扑克有大约 2000 个视角。另外,与 DeepMind 的 AlphaZero 的继任者 MuZero 不同,Player of Games 还需要了解它所进行的博弈的规则。MuZero 能够随时掌握完美信息博弈的规则。

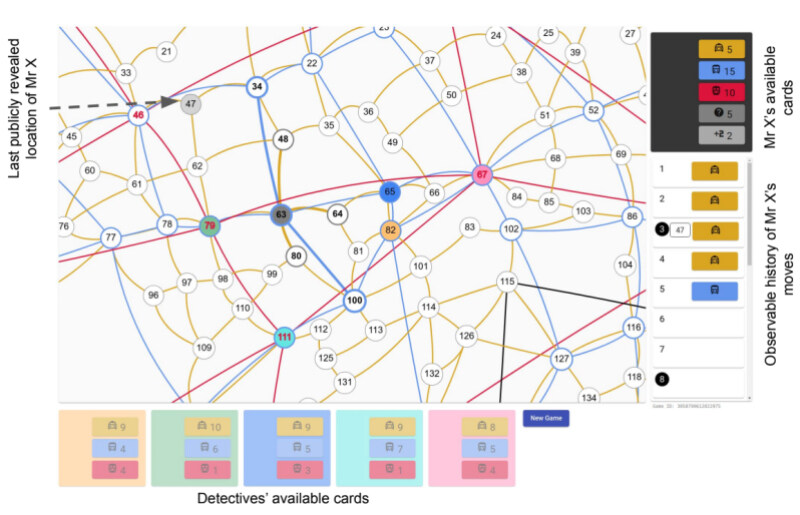

在研究中,DeepMind 通过谷歌的 TPUv4 加速芯片,在国际象棋、围棋、德州扑克和战略棋盘博弈苏格兰场(Scotland Yard)对 Player of Games 进行了评估。对于围棋,DeepMind 在 AlphaZero 和 Player of Games 之间设置了一场 200 局的比赛;对于国际象棋,DeepMind 让 Player of Games 与 GnuGo、Pachi、Stockfish、AlphaZero 等顶级系统进行较量。Player of Games 的德州扑克比赛是与公开的 Slumbot 进行的,该算法与 Joseph Antonius Maria Nijssen 研发的机器人进行了苏格兰场比赛,DeepMind 的合作者们为其起了昵称“PimBot”。

苏格兰场的抽象视图,Player of Games 可以持续获胜

在国际象棋和围棋中,事实证明,Player of Games 在某些方面(但并非所有方面)胜过 Stockfish 和 Pachi,并在与最强的 AlphaZero 智能体的较量中,赢得了 0.5% 的比赛。虽然败于 AlphaZero,但 DeepMind 相信,Player of Games 在博弈中的表现和“顶级人类业余选手”相当,甚至可能达到了专业水准。

Player of Games 是一个更好的扑克和苏格兰场 Player 。在与 Slumbot 的比赛中,这个算法平均每手赢了 7 个百万大盲注(百万大盲注/手),其中百万大盲注/手是指每 1000 手赢得的平均大盲注数(大盲注等于最小赌注)。同时,在苏格兰场,DeepMind 报告说,Player of Games 在对阵 PimBot 时获得了“显著 ”的胜利,尽管 PimBot 拥有更多的机会去搜索获胜的动作。

今后的工作

Schmid 认为,Player of Games 是迈向真正的通用博弈系统的一大步,但远非最后一步。这个实验的总体趋势是,如果有更多的计算资源,则算法会表现得更好(光是苏格兰场就有 1700 万步或动作的数据集训练 Player of Games),Schmid 预期这种方法会在可预见的未来得到推广。

Schmid 说:“我们期望从 AlphaZero 中受益的应用也能从 Player of Games 中受益。使这些算法更具通用性,是一项令人兴奋的研究。”

毫无疑问,支持大规模计算的方式使得诸如初创公司和学术机构等资源相对匮乏的组织都会陷入劣势。这在语言领域尤其如此,像 OpenAI 的 GPT-3 这样的大规模模型,在性能上处于领先地位,但是所需要的资源却常常高达数百万美元,这比大多数研究小组的预算都要高。

甚至连 DeepMind 这种资金雄厚的公司,其花费也会超出人们认为可以承受的范围。AlphaStar 公司的研究者没有刻意尝试使用不同的方式来构建一个关键组件,原因是他们的高管认为训练成本过高。DeepMind 在去年首次实现盈利,当时它的营收为 8.26 亿英镑(11.3 亿美元)。此前一年,DeepMind 的亏损为 5.72 亿美元,并承担了 10 亿美元的债务。

AlphaZero 的训练成本预计达到了数千万美元。DeepMind 并未透露 Player of Games 的研发经费,但考虑到每场博弈的训练步骤数量从几十万到几百万不等,所以它的经费并不会很少。

当研究最后从博弈过渡到其他更商业化的领域时,如应用推荐、数据中心冷却优化、天气预报、材料建模、数学、医疗保健和原子能计算,不平等的影响可能会变得越来越明显。“一个有趣的问题就是,这种水平的博弈是否可以用较少的计算资源就能实现。”Schmid 和他的合作者们在论文中进行了思考——但并没有给出答案。

作者介绍:

Kyle Wiggers,技术记者,现居美国纽约市,为 VentureBeat 撰写有关人工智能的文章。

原文链接: