人工智能工具如何将一张静态图像转化为一段动态、逼真的视频?OpenAI 的 Sora 通过时空补丁的创新使用给出了答案。

在快速发展的生成式 AI 模型领域,OpenAI 的 Sora 已经成为了一座重要的里程碑,有望重塑我们对视频生成的理解和能力。我们揭示了 Sora 背后的技术及其激发新一代图像、视频和 3D 内容创建模型的潜力。

这个演示是由 OpenAI 使用以下文本提示生成的:

一只猫叫醒熟睡的主人,要求吃早餐。主人试图忽视这只猫,但猫尝试了新的策略,最后主人从枕头下拿出秘密藏匿的零食,让猫再呆一会儿。

随着 Sora 的诞生,我们在视频内容生成方面已经迈入了与现实几乎无法区分的境界。由于该模型正在测试,它尚未向公众完整发布。

Sora 的独特方法如何改变视频生成技术

在生成式模型的世界中,我们业已看到了从 GAN 到自回归和扩散模型的许多方法,它们都有自己的优点和局限性。Sora 现在引入了一种范式转变,采用了新的建模技术并提升了灵活性,可以处理更长的持续时间、更多的宽高比和分辨率参数。

Sora 将 Diffusion 和 Transformer 架构结合在一起创建了一个 Diffusion Transformer 模型,并能够提供以下功能:

文本到视频:正如我们所见

图像到视频:为静态图像带来生命

视频到视频:将视频转换为其他风格

实时延长视频:向前和向后

创建无缝循环:让循环视频看起来永无止境

图像生成:静止图像是浓缩在一帧中的影片(最大 2048 x 2048)

生成任何格式的视频:从 1920 x 1080 到 1080 x 1920 以及之间的所有格式

模拟虚拟世界:如《我的世界》和其他视频游戏

创建一段视频:长度不超过 1 分钟,包含多个短片

想象一个厨房场景。传统的视频生成模型(例如 Pika 和 RunwayML 中的模型)就像严格遵循菜谱做菜的厨师。他们可以制作出精美的菜肴(视频),但受到他们所知道的食谱(算法)的限制。厨师可能专注于使用特定成分(数据格式)和技术(模型架构)烘焙蛋糕(短片)或烹饪面食(特定类型的视频)。

相比之下,Sora 是一位了解风味基础知识的新型厨师。这位厨师不仅可以按已有的菜谱做菜,还能发明新的菜谱。Sora 的原料(数据)和技术(模型架构)的灵活性使它能够制作各种高质量的视频,就像多才多艺的大厨的烹饪作品一样。

Sora 秘方的核心:探索时空补丁

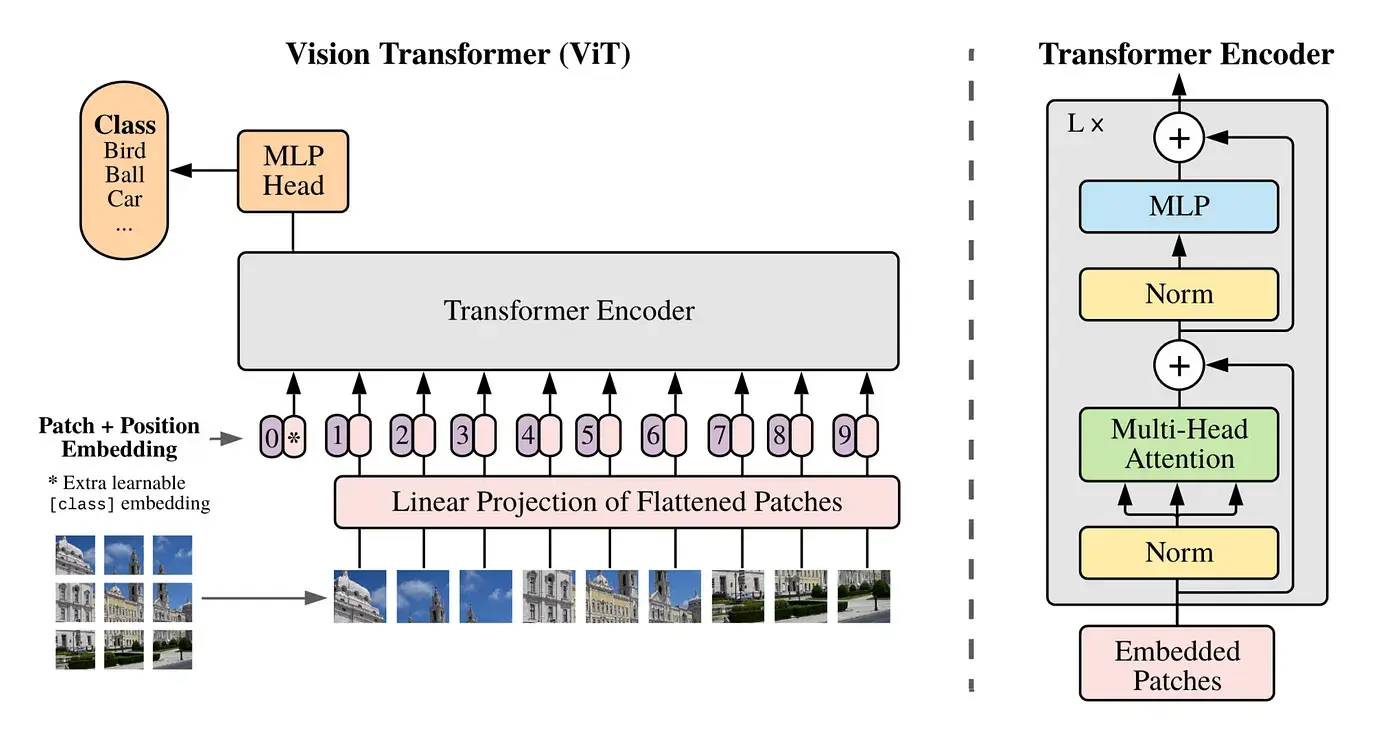

时空补丁是 Sora 创新的核心,建立在 Google DeepMind 对 NaViT 和 ViT(视觉 Transformer)的早期研究基础上,该研究基于 2021 年的论文《An Image is Worth 16x16 Words》。

“Vanilla”视觉 Transformer 架构 — 来源:Dosovitskiy et al., 2021

传统上,对于视觉 Transformer,我们使用一系列图像“补丁”(而不是用于语言 Transformer 的单词)来训练用于图像识别的 Transformer 模型。这些补丁使我们能够摆脱卷积神经网络来处理图像。

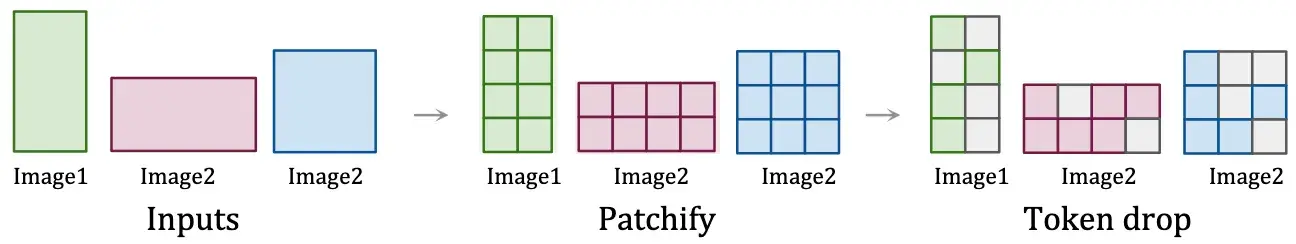

帧/图像如何“补丁化” — 来源:Dehghani et al., 2023

然而,视觉 Transformer 受到了大小和长宽比固定的图像训练数据的限制,从而限制了质量水平并且需要大量的图像预处理工作。

视频时态数据切片的可视化 — 来源:kitasenjudesign

Sora 将视频视为很多补丁序列,这样就保持了原始的宽高比和分辨率,和 NaViT 对图像的处理机制很像。这种保存方法非常重要,使模型能够捕捉视觉数据的真正本质,从更准确的世界表示中学习,从而赋予 Sora 近乎神奇的准确性。

时空补丁(处理)的可视化 — 来源:OpenAI(Sora)

该方法使 Sora 能够有效地处理各种视觉数据,而无需调整大小或填充等预处理步骤。这种灵活性确保每条数据都能够帮助模型加深理解,就像厨师使用各种原料来提升菜肴的风味一样。

通过时空补丁对视频数据进行详细而灵活的处理,为精确的物理模拟和 3D 一致性等复杂功能奠定了基础。有了这些至关重要的功能后,我们就可以创建不仅看起来逼真,而且符合世界物理规则的视频,让我们一睹人工智能创建复杂、动态视觉内容的潜力。

喂养 Sora:多样化数据在训练中的作用

训练数据的质量和多样性对于生成模型的性能而言是非常重要的。现有的视频模型传统上是基于更严格的数据集、更短的长度和更窄的目标来训练的。

Sora 使用的是庞大且多样化的数据集,其中包括了不同时长、分辨率和宽高比的视频和图像。它能够重建像《我的世界》这样的数字世界,它的训练集中可能还包括来自虚幻或 Unity 等系统的游戏玩法和模拟世界画面,以便捕捉所有角度和各种风格的视频内容。这样 Sora 就迈入了“通用”模型的境界,就像文本领域的 GPT-4 一样。

这种涉猎广泛的训练方法使 Sora 能够理解复杂的动态并生成多样化且高质量的内容。该方法模仿大型语言模型在不同文本数据上的训练方式,将类似的原理应用于视觉内容以实现通用能力。

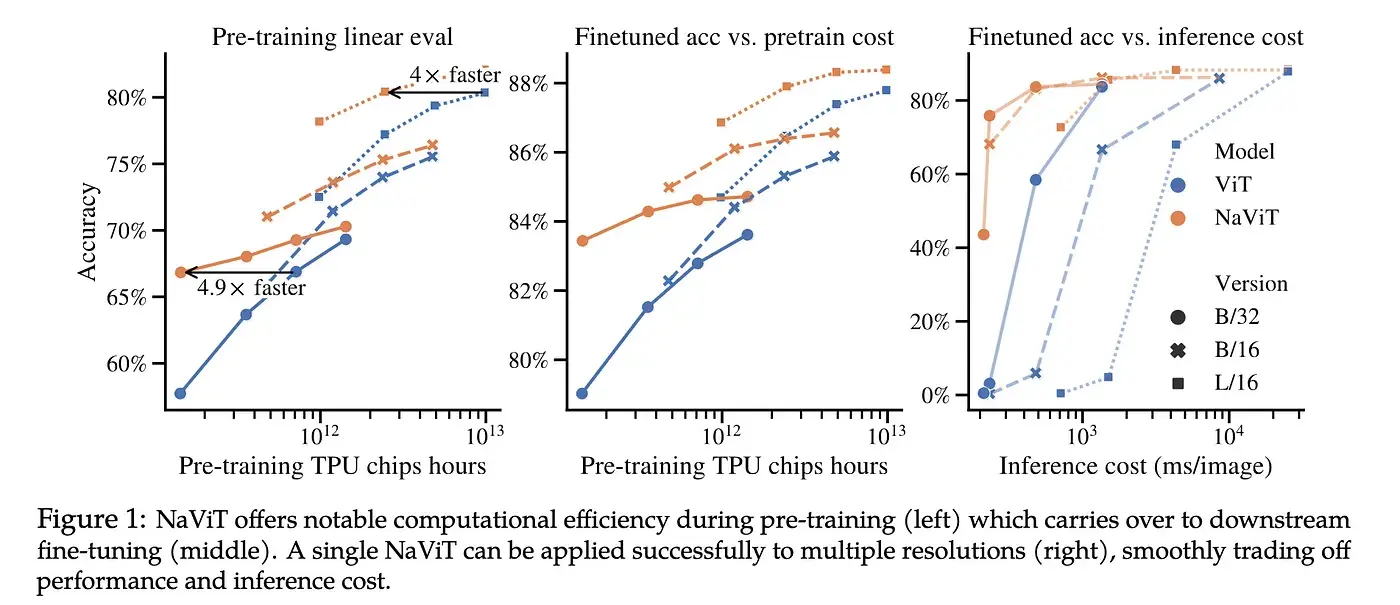

可变“补丁”,NaVit 与传统视觉 Transformers 的对比,来源:Dehghani et al., 2023

正如 NaViT 模型将不同图像的多个补丁打包到单个序列中的方法展示了显著的训练效率和性能增益一样,Sora 利用时空补丁在视频生成中实现了类似的效率。这种方法可以更有效地从海量数据集中学习,提高模型生成高保真视频的能力,同时其所需的计算量与现有建模架构相比也减少了。

将物理世界带入生活:Sora 对 3D 和连续性的把握

3D 空间和物体持久性是 Sora 演示中的关键亮点之一。通过对各种视频数据进行训练,无需调整或预处理视频,Sora 学会了以令人印象深刻的精度对物理世界建模,因为它能够使用原始形式的训练数据。

它可以生成数字世界和视频,其中对象和角色在三维空间中令人信服地移动和交互,即使它们被遮挡或离开镜头也能保持连贯性。

展望未来:Sora 的未来影响

Sora 为生成式模型的潜能设立了新的标准。这种方法很可能会激发开源社区尝试和推进视觉模式的能力,推动新一代生成式模型的发展,突破创造力和现实主义的界限。

Sora 的旅程才刚刚开始,正如 OpenAI 所说,“扩展视频生成模型是构建物理世界通用模拟器的一条有希望的道路”。

Sora 的方法将最新的人工智能研究与实际应用相结合,预示着生成式模型的光明未来。随着这些技术的不断发展,它们有望重新定义我们与数字内容的交互方式,使高保真、动态视频的创建变得更加容易和多样化。

InfoQ AIGC 学习交流群成立,一起探索 AI、大模型的无限可能。

群内福利:

AIGC 最新资讯和技术分享

专属福利和奖品