在即将发布的 Apache Spark 2.0 中将会提供机器学习模型持久化能力。机器学习模型持久化(机器学习模型的保存和加载)使得以下三类机器学习场景变得容易:

- 数据科学家开发 ML 模型并移交给工程师团队在生产环境中发布;

- 数据工程师把一个 Python 语言开发的机器学习模型训练工作流集成到一个 Java 语言开发的机器学习服务工作流;

- 数据科学家创建多个训练 ML 模型的作业,稍后需要保存和评估。

Spark MLlib 将提供基于 DataFrame 的 API 来支持 ML 持久化。后面将分三部分介绍:概要、代码实例和 MLlib 持久化 API 一些小细节。

概要

ML 持久化关键特色:

- 支持 Spark 原有的多种开发语言:Scala、Java 和 Python & R;

- 基于 DataFrame 的 API 几乎支持所有的 ML 算法;

- 支持单个 ML 模型和多管道 ML 模型;

- 使用可转换格式分布式保存机器学习模型

学学 API

在 Apache Spark 2.0 中,机器学习组件 MLlib 提供基于 DataFrame 的 API,可实现类似于 Spark 数据源 API 的保存和载入功能,见以前的文章。

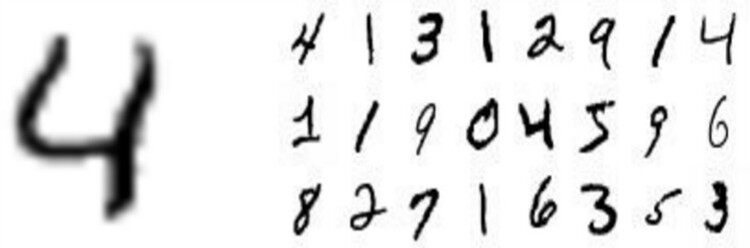

作者使用经典的机器学习例子(手写数字识别,使用 MNIST 数据库,MNIST 数据库包含 0 到 9 的手写数字和标注标记数据)来证实 ML 模型保存和加载功能。作者取其它手写数字并鉴别数字是几,完整例子代码见 notebook:加载数据、训练模型和保存以及加载模型。

保存和加载单模型

首先展示如何使用不同编程语言保存和加载同一单模型。作者使用 Python 训练和保存随机森林分类器模型,然后使用 Scala 来加载同一个 ML 模型回来。

training = sqlContext.read... # data: features, label

rf = RandomForestClassifier(numTrees=20)

model = rf.fit(training)

可以简单的调用 save 方法来保存上面训练好的 ML 模型,然后使用 load 方法再加载回来。

model.save("myModelPath")

sameModel = RandomForestClassificationModel.load("myModelPath")

这里也可以加载刚才同一个 ML 模型(使用 Python 保存)进入 Scala 或者 Java 应用。

// Load the model in Scala

val sameModel = RandomForestClassificationModel.load("myModelPath")

这个工作既可以对小数据量、局部模型(比如,常见的分类模型 K-Means)适用,也可以对海量数据、分布式模型(比如,常见的推荐模型 ALS)。刚加载的模型都包含有相同的参数设置和训练数据,所以即使在不同的 Spark 部署加载同一个模型也会得到相同的预测结果。

保存和加载多管道模型

前面仅仅描述来保存和加载单个 ML 模型,而实际应用中,ML 工作流包含多阶段:从特征提取和转化到模型拟合和优化。MLlib 会提供 Pipeline 来辅助使用者来构建这些工作流。

MLlib 提供使用者保存和加载整个 Pipeline。下面来看下如何来实现:

- 特征提取:图像数据二值化为 0 和 1(黑和白);

- 模型拟合:随即森林分类器读取图像数据并预测数字 0 到 9;

- 优化结果:交叉验证来优化树的深度。

看下代码:

// Construct the Pipeline: Binarizer + Random Forest

val pipeline = new Pipeline().setStages(Array(binarizer, rf))

// Wrap the Pipeline in CrossValidator to do model tuning.

val cv = new CrossValidator().setEstimator(pipeline) ...

在这个管道拟合模型前先来展示我们如何保存整个 ML 工作流。这个工作流将在其它 Spark 集群后续被加载。

cv.save("myCVPath")

val sameCV = CrossValidator.load("myCVPath")

最后,我们拟合模型管道,保存管道,并在以后进行加载。下面保存了特征抽取、随机森林模型交叉验证的优化以及模型优化对应的统计数据。

val cvModel = cv.fit(training)

cvModel.save("myCVModelPath")

val sameCVModel = CrossValidatorModel.load("myCVModelPath")

细节知识点

Python 优化

在 Spark 2.0 中并没有提供 Python 优化功能,Python 不支持保存和加载 CrossValidator 和 TrainValidationSplit 来做模型超参数优化,这个功能将在 Spark 2.1 中实现(SPARK-13786)。但是 Python 还是可以保存 CrossValidator 和 TrainValidationSplit 的结果。例如,我们可以使用 Cross-Validation 优化随机森林模型并保存调试好的优化模型。

# Define the workflow

rf = RandomForestClassifier()

cv = CrossValidator(estimator=rf, ...)

# Fit the model, running Cross-Validation

cvModel = cv.fit(trainingData)

# Extract the results, i.e., the best Random Forest model

bestModel = cvModel.bestModel

# Save the RandomForest model

bestModel.save("rfModelPath")

可转换的存储格式

本质上,我们把模型元数据和参数存储为 JSON,数据集存储成 Parquet。这些存储格式是可转换的,并且也能被其它开发库读取。Parquet 文件允许使用者存储小模型(比如,贝叶斯分类)和分布式模型(比如,ALS)。存储路径可以是任意 Dataset/DataFrame 支持的 URI,比如 S3、本地存储等。

跨语言兼容性

机器学习模型可以在 Scala、Java 和 Python & R 间任意存储和加载。但 R 语言有两个局限性:第一,不是所有 MLlib 模型都支持 R 语言,所以不是所有的使用其它语言训练的模型能被 R 语言加载;第二,使用 R 独有的方式的 R 模型格式存储不易被其它语言使用。

结论

随着 Spark 2.0 的即将发布,基于 DataFrame 的 MLlib API 将会提供几乎完善的模型和机器学习管道持久化。机器学习模型持久化在团队间合作、多编程语言 ML 工作流以及迁移模型到生产环境方面相当重要。基于 DataFrame 的 MLlib API 也将最终会成为 Spark 在机器学习方面主要的 API。

查看英文原文: Apache Spark 2.0 Preview: Machine Learning Model Persistence