省流版:基础软件相当能打,新的 TPU v5p 支持下的 AI 超级计算机架构足以应对最严苛的生成式 AI 大语言模型和场景。Agent 已经商业化,单就用例本身(视频智能生成、智能办公等等)国内均有类似形态的产品,没有“WoW”的感觉,但与国内同样产品相比,谷歌的用例精细化能力相当高,足以应对企业级场景的需求。

美国时间 4 月 9 日,Google Cloud Next ’24 在拉斯维加斯正式召开。 Google Cloud CEO Thomas Kurian 等带来了主题为「即刻踏上云端新旅程」的开幕演讲。

在会议开始之前,媒体及分析师们均十分期待谷歌本次大会上与生成式 AI 相关的发布,包括今年引起巨大讨论的 Gemini 系列,以及 vertexAI、硬件层面的更新等,包括是否会与英伟达最新发布的芯片合作等。

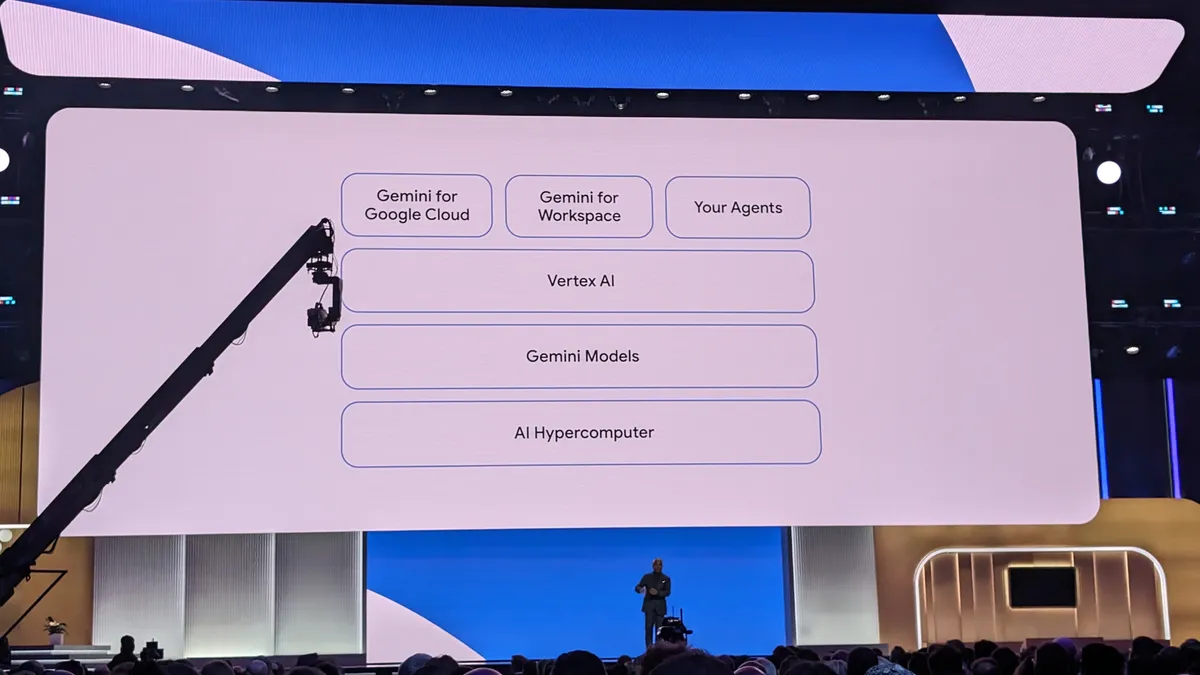

事实证明,谷歌已经围绕生成式 AI 构建起一整套的成熟架构,这是属于 AI 时代的超级计算架构。Thomas Kurian 表示自上次 Cloud Next 大会以来,谷歌已经进行了一千多次的产品更新,并声称这是世界上增长最快的云提供商。Alphabet 首席执行官 Sundar Pichai 特别赞扬了 Gemini 系列为各地企业提供了很多发展机会。与此同时,本届大会展示了谷歌已经构筑起的生成式 AI 全景图。

基础设施看谷歌,联手英伟达,AI Hypercomputer 超级能打

一系列芯片更新...

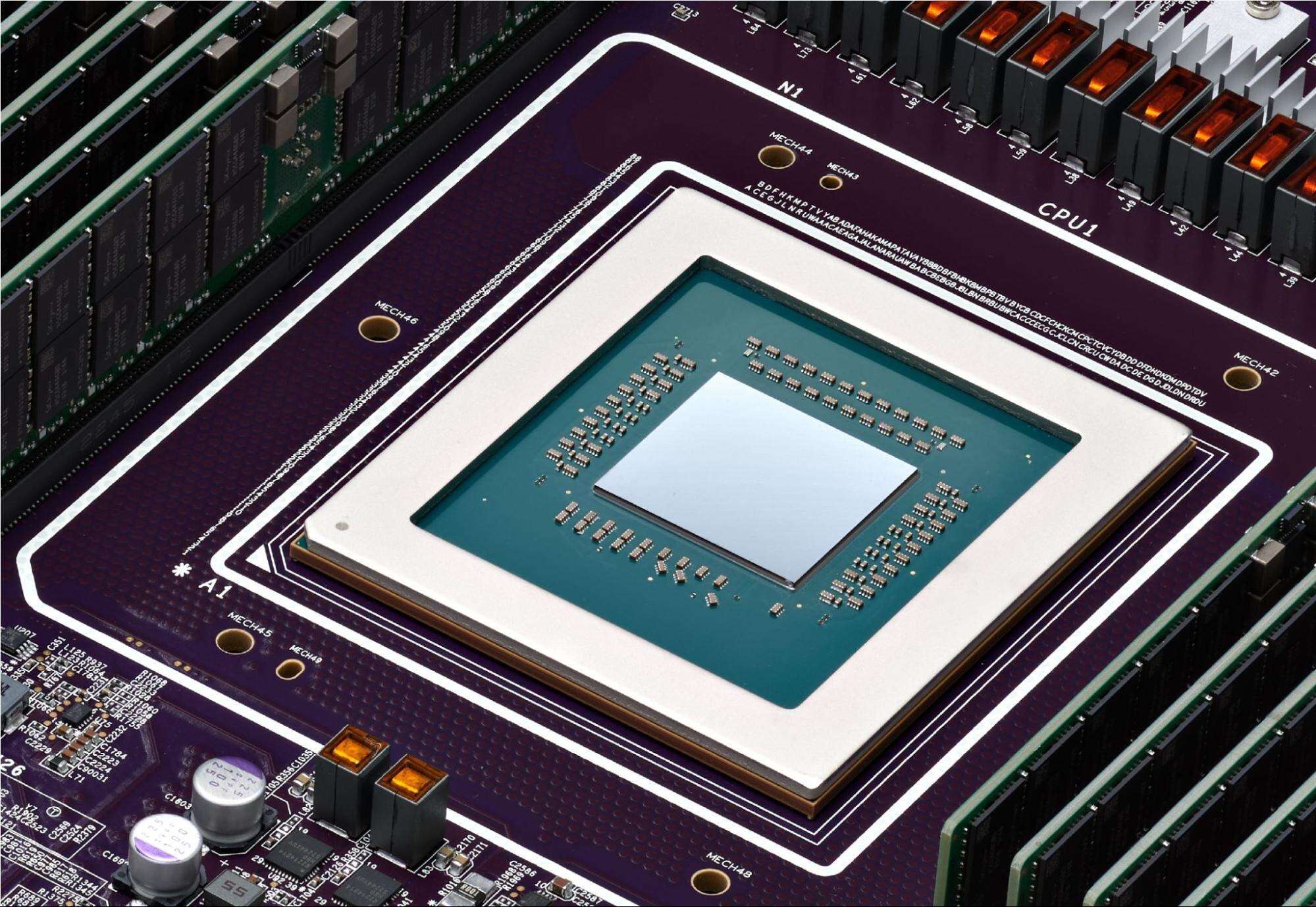

为了支持当今企业中采用的日益强大的生成式人工智能模型,谷歌宣布全面推出迄今为止最强大、可扩展的张量处理单元- TPU v5p,其设计目的只有一个——训练和运行最苛刻的生成式 AI 模型。

TPU v5p 旨在提供巨大的计算能力,单个 Pod 包含 8,960 个协同运行的芯片,这是 TPU v4 Pod 数量的两倍多。谷歌方面表示,TPU v5p 提供了令人印象深刻的性能提升,每秒浮点运算次数增加了一倍,每芯片的高带宽内存增加了三倍,从而大大提高了整体吞吐量。为了使客户能够训练和服务在大规模 TPU 集群上运行的 AI 模型,谷歌在 Google Kubernetes Engine 上添加了对 TPU v5p 虚拟机的支持,Google Kubernetes Engine 是其用于运行软件容器的云托管服务。

如预期,谷歌与英伟达联手,用户可以使用英伟达的最新硬件在 Google Cloud 上训练其生成式 AI 模型。除了 TPU 系列之外,它还通过新的 A3 系列虚拟机提供对 Nvidia H100 GPU 的访问。A3 Mega VM 将从下个月开始全面上市,其主要优势之一是支持“机密计算”,这是指即使在处理最敏感的数据时也可以保护其免受未经授权的访问的技术。

这是一个极其关键的发展,这为生成式 AI 模型提供了一种方法来访问以前被认为处理风险太大的数据,而数据安全随着生成式 AI 的爆火而愈发重要。

“Character.AI 正在使用 Google Cloud 的 Tensor 处理器单元和在 Nvidia H100 Tensor Core GPU 上运行的 A3 VM 来更快、更高效地训练和推断 LLM,”Character Technologies Inc.首席执行官 Noam Shazeer 表示。“在强大的人工智能优先基础设施上运行的 GPU 和 TPU 的可选性使 Google Cloud 成为我们显而易见的选择,因为我们需要扩展规模,为数百万用户提供新的特性和功能。”

与此同时,谷歌官宣了其宏伟计划-AI Hypercomputer,面向生成式 AI 时代的超级计算机架构,提供端到端的基础设施,从硬件到软件的一切服务,并宣布了 Google Axion 处理器,这是谷歌首款专为数据中心设计的基于 Arm 的定制 CPU。Axion 提供业界领先的性能和能源效率,并将于今年晚些时候向 Google Cloud 客户提供。

更令人兴奋的是谷歌将在今年晚些时候推出的产品。尽管没有透露具体时间,但谷歌方面确认计划将英伟达最近宣布但尚未发布的Blackwell GPU 引入其 AI 超级计算机架构。谷歌方面表示, Blackwell GPU 将提供两种配置,虚拟机由 HGX B200 和 GB200 NVL72 GPU 提供支持。前者是为最苛刻的人工智能工作负载而设计的,而后者则有望支持实时大语言模型推理和万亿参数规模模型的大规模训练的新时代。

Gemini 1.5 Pro 正式发布公共预览版

Gemini 1.5 Pro 的预览版发布只能说中规中矩,毕竟该系列在今年 2 月份就已经面世,这个模型最大的特点就是创下了最长上下文窗口的纪录。

根据官方披露,Gemini 1.5 Pro 将上下文窗口容量提到了 100 万 token(极限为 1000 万 token),远远超出了 Gemini 1.0 最初的 32000 个 token,此前的 SOTA 模型也才将上下文窗口容量提高到了 20 万 token。

这意味着 Gemini 1.5 Pro 可以自如地处理 22 小时的录音、超过十倍的完整的 1440 页的书(587,287 字)《战争与和平》,以及四万多行代码、三小时的视频。

凭借超长上下文理解能力,Gemini 1.5 Pro 得到了很多用户的认可。很多测试过 Gemini 1.5 Pro 的人更是直言,这个模型被低估了。如今预览版正式推出,期待后续广大开发者的反馈。

Kurian 现场介绍了众多可能的用例,并强调通过系列新增功能,谷歌云仍然是唯一提供广泛使用的第一方(Gemini 系列)和第三方模型(主要指 vertexAI 上面的模型)服务的云服务商。

Google Search 升级

通过使用新的提示管理工具对模型进行更精细的调整,包括解释为什么某些提示比其他提示效果更好等,可以进一步提高搜索结果的质量,显著降低产生幻觉的可能性。

这些现均已在 Vertex AI 上提供,Vertex AI 是 Google Cloud 的平台,用于定制和全面管理各种领先的人工智能模型。如今,超过 100 万开发人员正在使用谷歌的生成式 AI 工具,包括 AI Studio 和 Vertex AI。此外,通过 Vertex AI,客户现在可以通过两种新方式增强和基础他们的模型——将模型输出连接到可验证的信息源。第一个是 Google Search,它提供高质量的信息以提高响应的准确性。第二个是用户自己的数据和事实来源,例如 Workday 或 Salesforce 等企业应用程序以及 BigQuery 等 Google Cloud 数据库。

生成式 AI 时代,基础设施是一切创新的基础,极其重要,而单看这一部分,谷歌还是相当全面,超级能打。

Agent、Agent、Agent,已经商业化

会议现场,谷歌公布了系列 Agent 用例,比如 Custom Agent、Code Agent。可能是国内应用市场的繁荣导致平常“吃得太好”,这部分用例并没有让笔者有“Wow”的感觉,但单从 Demo 来看,谷歌公布出来的场景效果确实足够精细,这种精细指的是“足以在企业场景中落地”,极其重要的是谷歌已经将这些商业化了,每一个用例都跟着一个客户故事。

为了有效创建下一代 Agent,谷歌宣布了新的 Vertex AI Agent Builder,其提供了一个更简单的流程来训练、编辑和启动相关工具,包括相关控制能力和基础响应。

今年初,国内外对 Agent 寄予厚望,这被认为是生成式 AI 最有可能变现的一条路。如今看来,谷歌已经实现了,奔驰、沃尔玛等企业均在利用谷歌提供的 Agent,而主会场的后半程几乎都被 Agent 所占据。

由于这部分用例较多,且大部分国内感知有限(比如 Google Workspace),就不一一列举,着重聊下 Data Agents 和 Code Agents。

视频生成、剪辑相关用例

Data Agents 类似的产品形态,国内其实也有一些简单的尝试,通过在数据库或者数据平台上添加一些基本功能,让用户可以通过自然语言的方式与“业务数据”做交互。谷歌基于 BigQuery 做了 Data Agents 方面的尝试,沃尔玛执行副总裁 Suresh Kumar 也通过视频表示已经利用该功能来创造新的见解和个性化体验。

Code Agent 也显示出了人工智能将为代码编写带来巨大变化。Gemini Code Assist 获得了强大关注,谷歌现在正在将其扩展到 Gitlab、Github、本地和外部。谷歌表示,Gemini 1.5 Pro 即将加入 Code Assist,为编码带来 100 万 tokens,“彻底改变”编码。Gemini Cloud Assist 还可跨应用程序框架工作,让业务更顺畅、更轻松地推出和扩展。

国内外的智能编码工具不少,大部分目前是集成在 IDE 中使用,Agent 这种形态确实比较领先。早前,笔者从国内头部编码工具厂商那里了解到,其也将在今年下半年推出 Agent 版本,或许是国内目前来看比较有希望的节点。

面向生成式 AI 时代,谷歌的每一层架构都做好了准备。Kurian 提到:“我们正处于行业的关键时刻,我们正在重塑基础设施以支持人工智能新时代”。

“我们正在共同构建一种新的云方式。”