智源研究院院长黄铁军教授认为,近年来人工智能的发展,已经从“大炼模型”逐步迈向了“炼大模型”的阶段。

3 月 20 日,北京智源人工智能研究院举办“智源悟道 1.0 AI 研究成果发布会暨大规模预训练模型交流论坛”。会上,智源研究院发布超大规模智能模型“悟道 1.0”。

“悟道 1.0”是我国首个超大规模智能模型系统,由智源研究院学术副院长、清华大学唐杰教授领衔,带领来自北京大学、清华大学、中国人民大学、中国科学院等单位的 100 余位 AI 科学家团队联合攻关,形成超大规模智能模型训练技术体系,训练出包括中文、多模态、认知、蛋白质预测在内的系列模型,构建我国人工智能应用基础设施。

“悟道”模型:旨在从更加本质的角度进一步探索通用智能

会上,智源研究院院长黄铁军教授介绍了“悟道”模型研发的初衷。 黄铁军表示,本轮人工智能浪潮的基本特点是“数据+算力+算法=模型”,模型浓缩了训练数据的内部规律,是实现人工智能应用的载体。

近年来人工智能的发展,已经从“大炼模型”逐步迈向了“炼大模型”的阶段,通过设计先进的算法,整合尽可能多的数据,汇聚大量算力,集约化地训练大模型,供大量企业使用,这是必然趋势。

图:智源研究院院长 黄铁军

智能模型不仅要规模大(主要体现为参数量),还要智商高,才能满足各种应用需要,这需要突破大量技术挑战。例如:如何使得预训练模型具备像人类一样的符合逻辑、意识和推理的认知能力?如何实现对图、文和视频等多模态数据和信息的理解和建模的统一?如何将中文融入预训练模型,推动中文应用背景下的人工智能的发展?如何使得预训练模型深入融入自然科学研究,在目前基础上进一步实现对超长/复杂蛋白质序列的建模和预测?

2020 年 10 月,智源研究院正式启动超大规模智能模型“悟道”项目,研发既博大又精深的超大规模训练模型,从更加本质的角度进一步探索通用人工智能。同时,构建大规模智能模型应用生态,推动相关机构和个人开发者基于模型研发各类新型智能应用。

成立“悟道”模型技术委员会

图:智源大模型技术委员会(部分),从左到右分别为黄铁军、唐杰、鄂维南、文继荣、万小军、刘知远、杨植麟

为了更好地推动“悟道”大模型的研发,保持研发过程中技术的领先性,此次发布上,还同时成立了由 9 位来自学术界和产业界的顶尖科学家组成的“悟道”大模型技术委员会。委员会主任由清华大学唐杰教授担任,委员会成员包括:北京大学鄂维南院士、清华大学鲁白教授、中国人民大学人工智能信息学院院长文继荣教授、清华大学计算机系长聘副教授刘知远、清华大学计算机系长聘副教授黄民烈、北京大学王选计算机研究所万小军研究员、一流科技创始人袁进辉、循环智能联合创始人杨植麟。 后续,技术委员会将为大模型研发的技术方案和路线选择等进行指导和把关。

“悟道 1.0”:我国首个超大规模智能模型

会上,“悟道”模型技术委员会主任、智源研究院学术副院长唐杰教授介绍了“悟道”模型的战略布局及阶段性成果。据介绍,“悟道 1.0”先期启动了 4 个大模型的研发。

图:智源学术副院长唐杰 介绍”悟道”大模型团队

1.悟道·文源:面向中文的预训练语言模型

“悟道·文源”是“以中文为核心的大规模预训练模型”,目标是构建完成全球规模最大的以中文为核心的预训练语言模型,在中英文等多个世界主流语言上取得最好的处理能力,在文本分类、情感分析、自然语言推断、阅读理解等多个任务上超越人类平均水平,探索具有通用能力的自然语言理解技术,并进行脑启发的语言模型研究。

目前,“悟道·文源”模型参数量达 26 亿,具有识记、理解、检索、数值计算、多语言等多种能力,并覆盖开放域回答、语法改错、情感分析等 20 种主流中文自然语言处理任务,技术能力已与 GPT-3 实现齐平,达到现有中文生成模型的领先效果。

2.悟道·文澜:首个公开的中文通用图文多模态预训练模型

“悟道·文澜”是“超大规模多模态预训练模型”,目标是突破基于图、文和视频相结合的多模态数据的预训练理论难题,并最终生成产业级中文图文预训练模型和应用,并在多个评测应用上超过国际最高性能。

目前,“悟道·文澜”模型参数量达 10 亿,基于从公开来源收集到的 5000 万个图文对上进行训练,是首个公开的中文通用图文多模态预训练模型。 目前,该模型性能已到达国际领先水平,在中文公开多模态测试集 AIC-ICC 的图像生成描述任务中,得分比冠军队高出 5%;在图文互检任务中,得分比目前最流行的 UNITER 模型高出 20%。

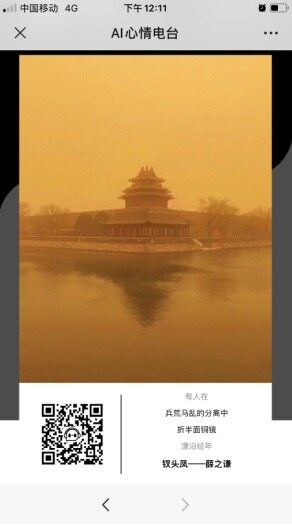

“悟道·文澜”模型已对外开放 API。发布会上,为了展示如何使用“悟道·文澜”模型,智源研究院联合中国人民大学高瓴人工智能学院和一览群智公司,推出了两款基于该模型的小应用,其中“赋魂”AI 小程序,可以为用户上传的照片配文,“AI 心情电台”小程序可以利用图片和歌词的相关性,为用户上传的照片搭配最合拍的音乐。

图:“悟道·文澜”模型根据图片自动搭配歌曲

3.悟道·文汇: 我国首个具有认知能力的超大规模预训练模型

“悟道·文汇”为“面向认知的超大规模新型预训练模型”,致力于从认知的角度研究通用人工智能中一系列更本质问题,侧重进一步提升和发展预训练模型基于逻辑、意识和推理的认知能力,目标是研发出千亿至万亿级别参数量的、更通用且性能超越国际水平的预训练模型,搭建预训练模型体系,同时形成认知智能生态。

目前,“悟道·文汇”模型的参数规模达 113 亿,在多项任务中“悟道·文汇”的表现已经接近突破图灵测试,通过简单微调就已经实现 AI 作诗、AI 作图、AI 制作视频、图文生成、图文检索、复杂推理。

例如,“悟道·文汇”模型可以应用在电商行业自动撰写商品文案等场景,在阿里电商场景下进行微调,输入以下图片。

“悟道·文汇”模型可以生成以下文字:

旗袍是一种古典的风格,它不仅能够彰显出女性优雅气质,而且还具有很好的修饰身形。这款旗袍采用了经典的圆领设计,穿着舒适自在,同时又能够展现出女性柔美的颈部线条,让你更加的迷人。精致的绣花工艺,使得整件衣服看起来更加的精致,也更加的凸显出女性的魅力。

图:“悟道·文汇”模型基于图片自动撰写商品文案

另外,“悟道·文汇”在图灵测试中已取得接近人类的作诗水平。

图:“悟道·文汇”模型实现的自动作诗

“悟道·文汇”模型还可以实现“以文生图”,自动作画。

图:“悟道·文汇”模型实现的“以文生图”

4.悟道·文溯:超大规模蛋白质序列预测预训练模型

“悟道·文溯”是“超大规模蛋白质序列预测预训练模型”,最终目标是以基因领域认知图谱为指导,研发出十亿参数规模、可以处理超长蛋白质序列的超大规模预训练模型,在基本性能、可解释性和鲁棒性等多个方面达到世界领先水平。

目前,“悟道·文溯”已在蛋白质方面完成基于 100GB UniParc 数据库训练的 BERT 模型,在基因方面完成基于 5-10 万规模的人外周血免疫细胞(细胞类型 25-30 种)和 1 万耐药菌的数据训练,同时搭建训练软件框架并验证其可扩展性。

据唐杰教授介绍,此次发布的“悟道”大模型 1.0 版本,已经完成了百亿和千亿参数规模的预训练,在多个国际评测中取得世界第一,在部分任务上具有一定认知能力。今年,还将陆续发布后续迭代版本,面向产业界开放使用。

“悟道 1.0”:构建了超大规模预训练模型技术体系

在科研方面,“悟道 1.0”模型正在逐步搭建并完善超大规模预训练模型技术体系,取得了多项国际领先的 AI 技术的突破。

1. 基础性能方面,在自然语言理解和生成、跨视觉和文字的理解与检索等多项任务上取得更好表现

(1)“悟道·文汇”提出了全新的预训练范式 GLM,以生成为核心,打破 BERT 和 GPT 瓶颈,历史上首次实现单一模型在理解、生成、seq2seq 三种任务上取得最优效果;相同训练量下,超越 BERT、RoBERTa、T5 等常见预训练模型。

(2)“悟道·文澜”发布首个公开中文通用图文多模态预训练模型,能够懂得基于图文弱相关的“内涵信息”。

2. 针对预训练模型有效使用,提出高效算法

(1)“悟道·文汇”提出基于连续向量的微调方法 P-Tuning,历史上首次实现自回归模型在理解任务上超越自编码模型,并在知识抽取(LAMA)、少样本学习(Superglue Fewshot)等 10 多个任务上取得世界第一,性能提升超 20%;

(2)“悟道·文汇”提出 Inverse Prompting 算法,显著改善了对语言模型生成结果的控制,效果大幅度超越当前最好方法,在问答和诗歌生成任务中接近人类水平,并首次实现根据现代题材创作古体诗;

(3)“悟道·文源”发布开源的中文预训练模型 CPM,并进一步开源了微调算法代码。以此为基础的模型蒸馏技术 CPM-Distill,实现语言困惑度降低 38%,在下游任务上获更好效果;

(4)“悟道·文澜”不同于 OpenAI 的 CLIP 模型,采用更先进的跨模态对比学习算法:给定某一图文对,基于 MoCo 思想,对每种模态扩大负样本数目,特别是区分难度大的负样本,进一步提高神经网络的表达能力。

3. 进一步实现规模和性能的扩增中面临的挑战

(1)“悟道·文溯”发布并开源了万亿参数模型训练的基石 FastMoE,是首个支持 PyTorch 框架的高性能 MoE(混合专家模型)系统,不再受限于谷歌软硬件,支持多种硬件,只需一行代码即可完成 MoE 化改造,相比传统 PyTorch 实现,模型训练速度提升 47 倍;

(2)“悟道·文澜”可以方便地把图像和文本的编码器替换成最先进的单模态预训练模型,随即达到增大模型表达能力的目的,在预测阶段,速度是 UNITER 模型的 20 倍,容易部署。

4. 建设并开放了全球最大中文语料数据库 WuDaoCorpora

WuDaoCorpora 数据集的数据规模达 2TB,超出之前全球最大的中文语料库 CLUECorpus2020 十倍以上,同时着重去除了数据中包含的隐私信息,防止了隐私泄露。另外,WuDaoCorpora 的数据来源丰富,包括新闻咨询、评论、百科、论坛、博客、学术论文等,使得该数据集能够适用于不同种类的自然语言处理任务,训练出的模型泛化性更强。此外,WuDaoCorpora 数据标签的完备性较高,语料中包含医疗、法律、金融等领域标签,可以依据需求抽取某个特定领域的数据,用于训练该领域的模型,也可以用于对大模型进行微调,构建某一特定领域的应用。

该数据集不仅为“悟道”项目提供了数据支撑,还可被用于中文自然语言处理领域的多种任务模型训练,包括文本生成模型、词嵌入模型、问答对话模型等,对于国际自然语言处理领域的发展将有着积极的促进作用。

应用生态“三步走”:探索“悟道”大模型生态发展

在模型研发的同时,智源研究院也在同步探索“悟道”模型的应用生态建设模式。据唐杰教授介绍,后续“悟道”模型将以开放 API(应用程序接口)的形式对外提供服务,用户通过申请并经授权后可以基于模型 API 开发各类智能化应用。另外,也会开源模型的社区版本。

图:智源研究院学术副院长 唐杰

唐杰教授介绍,下一步,“悟道”模型应用生态建设分为三个主要阶段,分别关注示范应用、API 生态及社区运营维护等。

第一阶段为示范性应用搭建,将构建面向电子商务、智能文本服务、垂直领域以及数个独立的示范性应用,将开放几个高质量的应用 Demo,支持用户在平台页面上使用及测试。第二阶段为 API 及平台生态构建,将设计多个 API,支持对模型的不同请求方式,构建支持高并发、高速推理的 API 接口,分别支持企业级用户、个人独立开发者对模型或特定功能的请求。第三阶段为社区运营及迭代,将逐步增量扩大在线评测,构建开发者及使用者社区,建立完善的使用反馈机制,并作为模型迭代的参考标准,同时加强社区维护及管理,加快模型迭代。

目前,智源研究院已启动第一阶段的示范性应用搭建,正与快手、搜狗、360、阿里、智谱华章、一览群智、循环智能、新华社等机构就模型的应用进行洽谈,联合构建一批工业级示范性应用。

下一步,智源研究院将加强用户的开发,做好用户服务,与 AI 龙头企业共同研发更多工业级示范性应用,并将加快推动 API 生态构建及社区运营迭代工作,通过举办学术交流、技术挑战赛等活动提高“悟道”模型的影响力,吸引更多 AI 企业、研究机构、个人开发者等开展基于模型的应用开发工作,推动构建国际领先的超大规模智能模型应用生态。