本文最初发布于博客 CodeX,经 InfoQ 翻译。

AI 寒冬这个词并不是我为了吸引你阅读这篇文章而编造的,实际上,这是 AI 行业的一个知名词汇。其原因是我们在 20 世纪已经经历了两次人工智能寒冬。

什么是 AI 寒冬?

AI 寒冬与雪无关,也与季节无关。它是关于科研资金、创业资金和对人工智能的普遍兴趣的倒退。造成这种倒退的原因是,人们意识到许多希望和承诺无法实现,或者换句话说:人工智能被过度夸大了。

当然,人工智能很吸引人,而且有很多东西有待发现,但如果你认为可以在短时间内轻易实现巨大的科学飞跃,那就太天真了。有时,甚至是简单问题(如知识表示或逻辑推理)的巨大难度也被严重低估了。

就这个领域来说,人工智能这个名字可能并不那么慷慨,因为它导致了人们对人工智能寄予厚望和产生误解,比如说人工智能将在未来几十年内取代许多工作。尽管目前研究的重点不是 AGI(通用人工智能),而是狭义的人工智能,但许多人在想到人工智能时,脑子里仍然会浮现某种终结者或超级智能机器人的形象。这就导致了炒作。

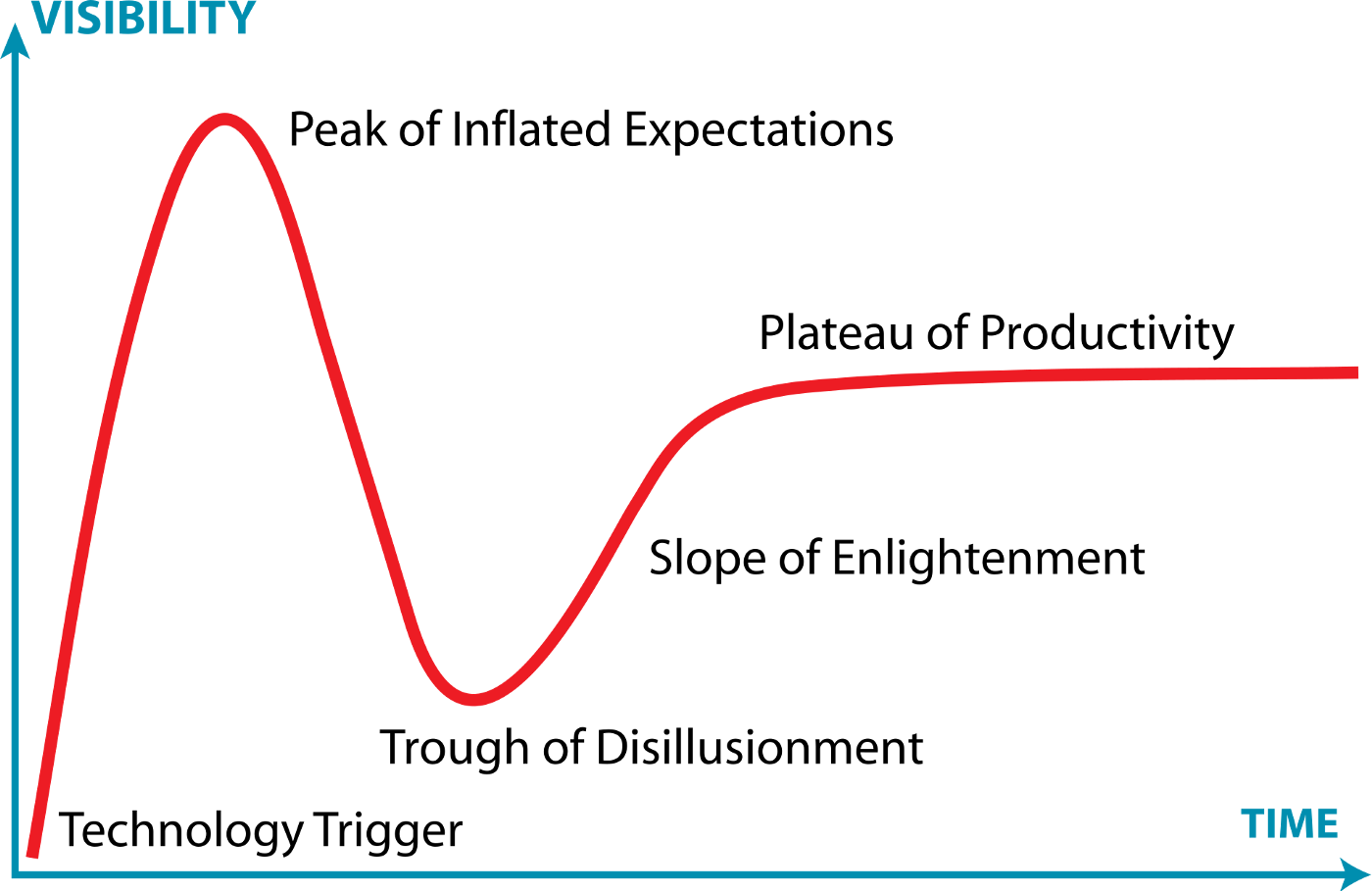

Gartner 的炒作周期

这与 Gartner 的“炒作周期”有很强的相关性,它旨在说明一项新技术一开始会引发不切实际的期望,进而导致对这项技术的大量研究和调查。在意识到这是幻想之后,研究和大众兴趣急剧下降。至此,该项技术才得以通过缓慢但稳定的改进取得真正的进展。

这与人工智能非常相似,只是我们没有“复苏期(Slope of Enlightenment)”这个状态,还没有真正取得稳定的改进。

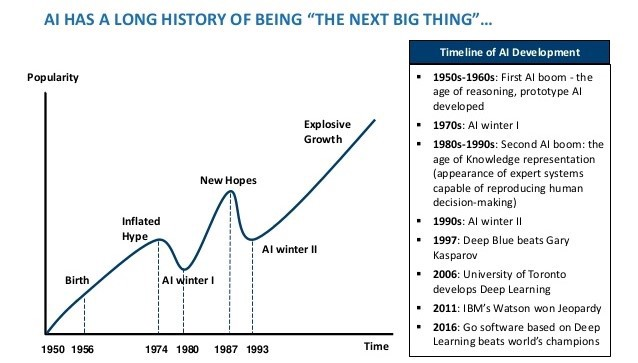

过去的 AI 寒冬

AI 寒冬时间线

第一次人工智能热发生在 20 世纪 50 年代,这也被称为推理和原型人工智能的时代。但很快,在 1970 年代,一个长达十年的人工智能寒冬开始了。

20 世纪 80 年代出现了新的人工智能热。当时,严重依赖知识表示的专家系统出现,试图重现人类决策过程。但那些成果并不能满足人们的期望,因为知识表示只适用于少数领域,而且由于缺乏数据和计算能力,其他算法并不可行。

下一个人工智能寒冬来了,并持续了一段时间,直到数据量和计算能力几乎呈指数级增长,提供了实施深度学习的可能性。这就是我们现在的情况,很可能是这种模式的重现。

为什么很快又会来临?

这就好比是泡沫破裂。每当某样东西的价值被人为地高估时,一旦普遍的误解转变为人所共知的常识,泡沫就很有可能破灭。

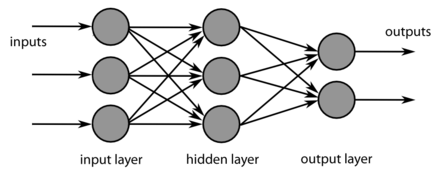

深度神经网络

现在的高性能人工智能,主要是深度神经网络,被认为是黑盒模型,它执行大量的浮点数计算来预测 X,或 Y,或其他东西。这些模型可以非常准确,因为它们是通用多项式函数近似器,有成百上千的神经元随着时间的推移抽象出函数。每当你问自己这样的模型是如何得出结论的时候,能够得出模型推理过程的方法非常有限,因为人无法解释通过无数神经元的浮点数流。这就是为什么这些模型在推理和知识表示研究领域没有取得进展的原因。长远来看,这非常令人担忧,因为我们需要模型有理解力,而不仅仅是进行“愚蠢的”模式检测。

例如,一个在图像中检测狗的神经网络可能会预测图像中存在一只狗,但它并没有真正理解什么是狗,以及除了视觉模式之外它还能做什么。

你可能会认为,一个能够对图像中的狗和猫进行分类的神经网络也能轻易地对图像中的鸟进行分类。但问题是,如果不重新学习它已经学到的所有知识,并在此基础上加入鸟类,人工智能就根本无法对鸟类或其他动物进行分类。这显然可以得出一个结论,推理和知识表示对于发现某种关联非常重要。举例来说,每当人类想到狗的时候,我们的脑子里可能会浮现这个词的拼写,以及狗的样子,还有一些狗的名字,等等。

联想记忆之所以重要,是因为需要有多任务模型(这是迈向 AGI 的第一步),它能够做不止一件事。人工智能不只是对图像中的动物进行分类,还可以对句子中的动物进行推理。它应该明白,“狗”这个词和狗的实际形象紧密相关,并且是指同一个东西。

小结

因为现如今几乎所有的人工智能研究都发生在深度学习领域,设法不断提升神经网络的性能或鲁棒性,所以大的问题并没有得到解决。如果不向基于推理的人工智能范式转变,那么下一个人工智能寒冬将很快到来。

一个乐观的观点

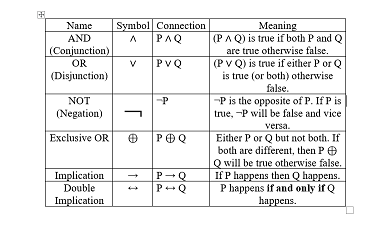

尽管目前人工智能面临着许多困难,但希望仍在。一个可能将深度学习和推理相结合的研究领域是逻辑神经网络,它试图将神经元映射到由 AND、OR 等运算符组成的逻辑谓词上......其前景是,神经网络将不再是黑盒子,知识表示可以更容易地转移到其他模型。

公平地说,到今天为止,这种方法还不是很有效,因为在映射神经元状态以获得逻辑谓词时,许多信息会丢失。人们希望能够找到解决此类问题的方法,使人工智能的梦想成为现实。

查看英文原文: