近日, Llama2 大语言模型宣布开源,覆盖 70 亿、 130 亿及 700 亿参数版本。 Llama2 可免费用于研究场景和月活 7 亿用户以下的商业场景,为企业和开发者提供了大模型研究的新工具。然而,对 Llama2 的再训练和部署仍存在较高门槛,尤其是针对效果更胜一筹的大尺寸版本。

为方便开发者群体,阿里云机器学习平台 PAI 在国内率先对 Llama2 系列模型进行深度适配,推出了轻量级微调、全参数微调、推理服务等场景的最佳实践方案,助力开发者快速基于 Llama2 进行再训练,搭建自己的专属大模型。

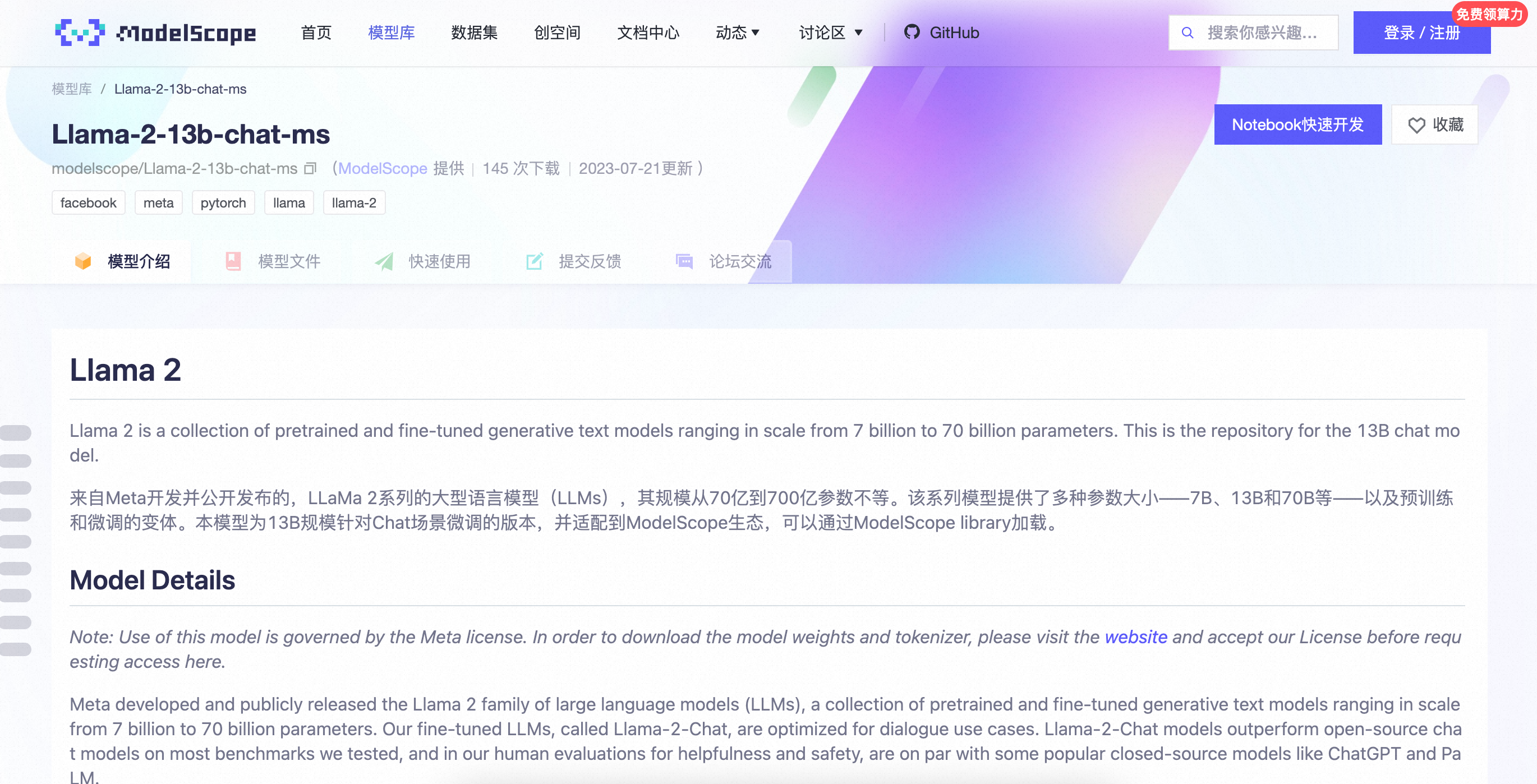

阿里云牵头发起的 AI 模型社区魔搭 ModelScope ,第一时间上架了 Llama2 系列模型。开发者可在魔搭社区 Llama2 模型页面点击“ Notebook 快速开发”,一键拉起阿里云机器学习平台 PAI ,对模型进行云上开发和部署;在其他平台下载的 Llama2 模型,也可使用阿里云 PAI 进行开发。

针对特殊的场景需求,开发者往往需使用微调训练的方法对模型进行“调整”,以获得特定领域的专业能力和知识。此时, PAI 支持开发者在云上进行轻量级 Lora 微调或更深度的全参数微调。完成模型微调后, PAI 支持开发者通过 Web UI 及 API 的方式部署 Llama2 ,使模型可以通过网页或嵌入应用与使用者交互。

相比本地单机训练 Llama2 ,在阿里云上可完成对超大尺寸模型的深度开发,且预置环境免运维,操作简单便捷,同时开发者可获得丰富的 AI 计算资源和极致弹性。本地单卡 GPU 只能完成 Llama2 70 亿 参数版本的轻量级 Lora 微调和推理,更大尺寸版本及更深度训练均很难支撑。在阿里云上,通过 PAI 灵骏智算服务提供的分布式计算能力,可对 Llama2 全尺寸版本进行轻量级和全参数微调,并进行高效部署和推理。

作为全球前三、亚洲第一的云厂商,阿里云是中国 AI 浪潮重要的引领者和服务者,已构建完备的 IaaS+PaaS+MaaS 一体化 AI 服务。在基础设施层,阿里云拥有国内最强的智能算力储备,灵骏智算集群具备最大十万卡 GPU 规模扩展性,可承载多个万亿参数大模型同时在线训练;在 AI 平台层,阿里云机器学习平台 PAI 提供 AI 开发全流程的工程能力, PAI 灵骏智算服务支撑了通义千问等超大模型的训练和应用,可将大模型训练性能提高近 10 倍,推理效率提升 37 %;在模型服务层,阿里云构建了国内最活跃的 AI 模型社区魔搭,并支持企业基于通义千问或三方大模型进行再训练。

今年 7 月初,阿里云宣布,将把促进中国大模型生态的繁荣作为首要目标,向大模型创业公司提供包括模型训练、推理、部署、精调、测评、产品化落地等在内的全方位服务,并在资金和商业化探索方面提供充分支持。