4 月 10 日至 12 日,由极客邦旗下 InfoQ 中国主办的 QCon 全球软件开发大会在北京隆重举行。本届大会以“智能融合,引领未来” 为年度主题,汇聚了来自网易云信、腾讯、阿里巴巴、百度、华为、快手、字节跳动、小米、微软等近百家中外顶尖科技企业及知名高校的 140 余位行业专家。与会专家围绕 AI 工程生产力提升、AI 产业应用实践、数据智能创新、AI 搜索技术突破、海外 AI 应用案例等前沿议题展开了深度分享与探讨。大会现场座无虚席,深入交流,共同勾勒出人工智能技术发展的新图景。

网易云信音视频技术负责人、流媒体首席架构师吴桐受邀参加本次大会,带来《多模态对话引擎:从语音表征到 LLM 微调的架构演进和技术实践》的分享,从大模型带来的对话交互变革说起,解析了融合大模型的对话式语音 AI 技术架构,介绍了跨行业应用实践、场景落地及经验教训。

由于篇幅限制,本次分享内容将拆分为上下两篇呈现。本篇作为上篇,重点聚焦大模型驱动下的对话交互革新,以及对话式语音 AI 的技术架构解析。

大模型带来的对话交互变革

对话交互的发展历史

语音交互技术的发展可以追溯到 70 年前。1952 年,贝尔实验室研发了名为 Audrey(奥德丽)的早期语音识别系统,尽管它仅能识别 0-9 这 10 个数字,但标志着语音技术的萌芽。到了 20 世纪 90 年代,IVR(交互式语音应答)系统开始广泛应用,用户通过电话按键进行菜单选择,这种模式至今仍存在于客服系统中,例如我们熟知的"按 1 转人工"。这一阶段可视为语音交互技术的萌芽期。

真正的转折点出现在 2011 年,乔布斯掏出 iPhone4S 喊出 "Hey Siri",首次将智能语音助手带入大众视野。尽管早期的 Siri 理解能力有限,经常答非所问,但它奠定了现代语音交互的基础。2014 年,亚马逊推出 Echo 智能音箱,采用 7 麦克风阵列和云计算技术,实现了远场语音交互,大幅提升了语音识别的准确率。这一阶段,自动语音识别(ASR)技术取得显著突破,被称之为技术积累期。

2015 年后,语音技术进入快速发展阶段。多轮对话、自然语言处理(NLP)和语音合成(TTS)技术不断进步,智能助手如小爱同学、小度、天猫精灵等迅速普及,使语音交互成为日常生活的一部分。

如今,我们正站在爆发前夜。随着大语言模型、多模态交互和边缘计算的发展,语音交互系统正朝着更智能、更个性化的方向演进。未来,个人语音助手或许会像《钢铁侠》中的贾维斯一样,不仅能精准理解指令,还能感知情绪、主动协助,真正成为用户的智能伙伴。

传统语音交互系统的技术局限性

第一,语义理解与泛化能力不足。系统往往只能处理固定句式,对自然语言的上下文理解能力较弱。比如用户对车载系统或者导航系统说 "我饿了",它可能反问 "需要导航去加油站吗?"

第二,响应延迟问题严重。传统系统必须等待用户完整表述后才开始处理,且处理耗时特别大。说完一句话往往需要 3 秒以上的处理时间。这种交互延迟明显违背人类自然对话习惯,严重影响用户体验。

第三,语音识别欠佳和音色存在局限。在复杂声学环境下(如多人交谈或背景噪声),语音识别准确率可能从安静环境下的 90%骤降至 55%。同时,系统容易误判语音端点导致对话中断,体验感差,且语音合成(TTS)效果机械单一,拟人化差。

最后一点最可惜 —— 传统的语音交互系统忽略人类的情感信息。比如用户生气时提高音量,系统却不知道优先处理;用户点头表示确认,它也看不见。在人和人的效的沟通中,肢体动作和语音语调非常关键!

大模型 + RTC 重构人机交互逻辑

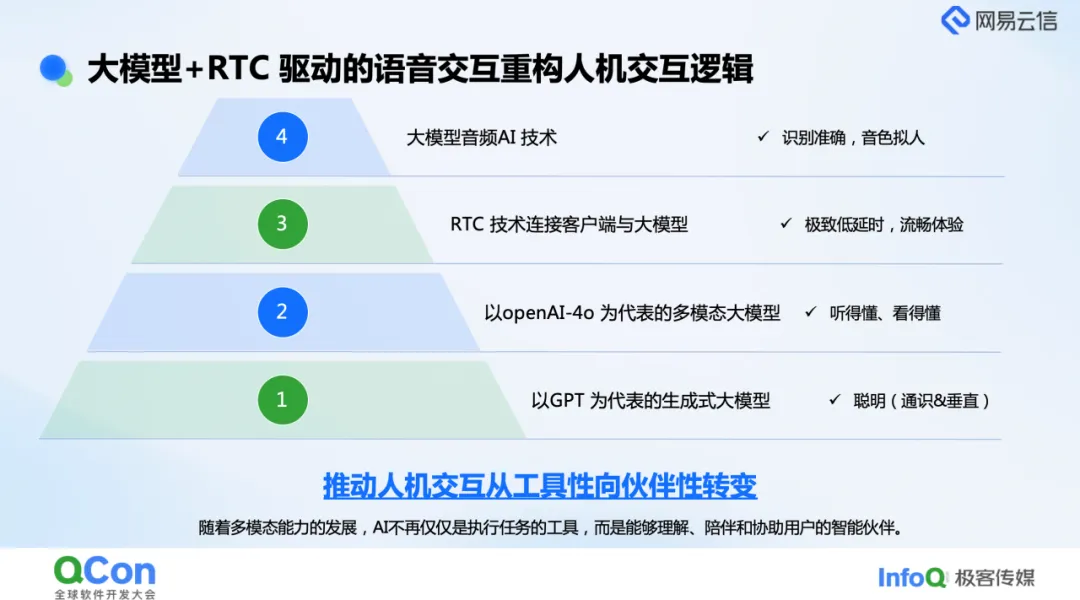

近两年,大模型+RTC 驱动的语音交互正在重构人机交互逻辑。

从技术架构的角度,自下而上地分析新一代 AI 语音交互系统的突破性进展:

基础层:认知能力的革命性突破

以 GPT-4 为代表的大语言模型构建了系统的智能核心,其 1.8 万亿参数的庞大知识体系覆盖金融、医疗等专业领域。通过 RAG(检索增强生成)和微调技术,系统既能掌握通用知识,又能深度适配垂直场景需求。

能力层:多模态交互的进化

以 GPT-4o 为典型的多模态模型实现了跨模态理解,例如能分析用户上传的穿搭照片并给出个性化反馈。实验阶段的语音多模态系统更展现出精准的情绪识别能力,为情感化交互奠定基础。

体验层:实时交互的技术保障

通过优化 RTC(实时通信)技术,结合端到端流式处理架构,系统响应延迟可控制在 650 毫秒以内。这种低延时特性配合高质量音视频传输,显著提升了语音交互的自然流畅度。

表现层:拟人化的交互体验

基于大模型的语音识别突破了口音、方言和年龄差异的限制,而先进的 TTS 技术仅需 15 秒样本即可高保真克隆音色,实现近乎人类的语音表达。

这些技术的融合演进,正在推动 AI 从功能型工具向具有情感共鸣的智能伙伴转型。在不远的将来,我们有望见证人机交互范式的重要变革。

大模型融合的对话式语音 AI 技术

大模型融合的对话式语音 AI 技术突破与创新主要分为 3 个方面,分别是:

1.交互自然性提升,包括交互的超低延时、对话人声的锁定和优雅打断

2.个性化交互体验,包括 AI 的个性化定制,长期记忆以及知识库的集成

3.多模态的融合,包括多模态交互的能力和数字人相关能力

云信对话式 AI 的八大核心组件

云信 RTC SDK:支持全平台集成,实现跨端无缝对接。

WE-CAN 全球传输网络:通过智能调度机制,确保全球用户就近接入,提升连接效率。

云端 AI 音视频智能处理:融合 AI 回声消除、背景降噪、声纹锁定等技术,优化音频质量;同时支持视频智能处理,增强感知清晰度。

任务规划模块:依据用户场景与需求,灵活配置并串联云端各功能模块,实现高效协同。

智能多语言 ASR 模块:支持多语种及方言识别,满足国际化应用需求。

大模型处理模块:兼容文字大模型与实时大模型,前者接收 ASR 转写文本,后者处理实时音频数据;同时集成角色库、长期记忆、知识库及 MCP 协议等功能,支持意图识别回调,实现客户端指令控制。

TTS 模块:将大模型回复文本转换为语音,并支持个性化音色克隆。

数字人模块:可通过文字或语音驱动,生成的音视频流经 WE-CAN 网络传输至客户端。

各组件通过流式处理机制紧密协作,显著提升端到端交互体验。后续将深入解析各模块技术细节。

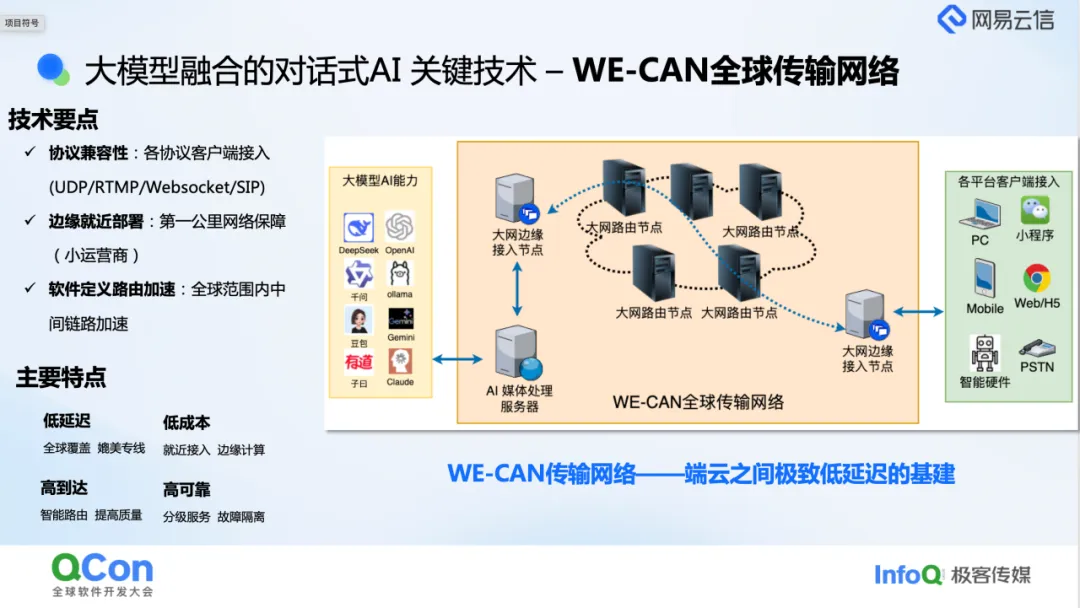

WE-CAN 全球传输网络技术

在对话式 AI 场景中,WE-CAN 全球传输网络作为端云连接的核心枢纽,高效串联客户端与云端大模型。客户端侧全面覆盖 Windows、macOS、iOS、Android、Web、微信小程序等主流平台,并支持智能硬件及 SIP PSTN 的接入。全球数百个大网边缘节点承担接入重任,凭借两大核心能力实现高效传输:其一,基于同运营商就近接入原则,降低网络延迟;其二,通过边缘节点外挂网关服务,完成 RTMP、WebSocket、SIP 等协议向云信自定义协议的转换。边缘节点接收媒体数据后,经大网中间路由节点,将数据包精准传输至目标 AI 媒体处理服务器。

大网路由节点采用业务无关的纯转发策略,在实时传输网调度服务统一调配下,依据边缘节点信息,动态规划最优路径,确保数据包快速送达 AI 媒体服务器。媒体数据经服务器处理后,调用大模型 AI 能力,此链路通过多链路保障策略,确保数据传输稳定可靠。

云信自研的大规模分布式实时传输网具备四大显著优势:

低延迟:凭借全球覆盖的边缘接入节点,实现用户超低延迟接入,传输质量堪比专线;

低成本:依托边缘计算资源替代核心 BGP 机房,在保障性能的同时有效控制成本;

高可达:智能路径规划结合多通道备份机制,确保全球范围内数据传输无死角;

高可靠:支持分级服务与链路自动快速切换,秒级完成故障隔离,保障传输链路持续稳定。

基于上述特性,WE-CAN 全球传输网络成为对话式 AI 端云低延迟交互的重要技术基石。

端云低延时传输引擎核心技术包括以下四个方面:

抗丢包技术:采用 FEC、RED 与 HARQ 组合方案,即便在 80% 高丢包率环境下,仍能确保通信流畅;

智能流控系统:融合了 AI 预测模型的带宽估计模块,结合灵活的码率动态调整,可以在数秒内就将带宽利用率控制到 90%以上;

多协议多链路传输:同时支持 UDP、TCP、Websocket 协议,构建立体传输网络;配合 Multipath 多链路方案,可并行使用 WiFi 与 LTE 链路;

端云协同优化:通过精准同步端云间 jitterbuffer 长度信息,优化传输策略,保障端到端延时稳定在 200ms 以内。

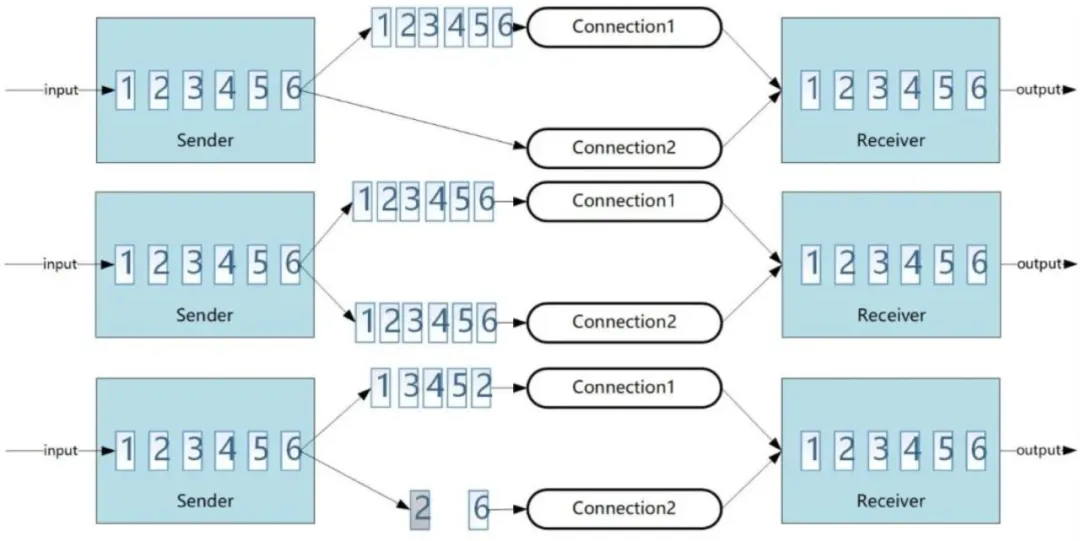

其中,展开介绍一下多协议多链路传输方案。

在网卡多链路技术方面,即 WiFi 与 LTE 的双网卡协同传输,多链路的难点是如何智能选择在两块网卡传输的内容。有三种智能传输方案:链路切换、冗余传输、流量分配,云信在实际应用中,根据数据特性与网络状态动态组合三种方案,实现传输效率与稳定性的平衡:

链路切换:动态选择最优链路;

冗余传输:针对核心信令等关键数据,通过双链路同步传输保障可靠性;

流量分配:默认流量经 WiFi 通道传输,重传及冗余数据分流至 LTE 通道。

在网络传输协议层面,云信构建了多协议支持体系:媒体数据同时兼容 UDP 与 TCP 协议,确保传输效率与可靠性;信令数据支持 QUIC 与 WebSocket 协议,提升交互实时性。

此外,基于云信在全球范围内的网络传输大数据,我们发现不同国家和地区在 IPv6 和 IPv4 的传输质量上有明显差异,有的地区 IPv6 在延时与抗丢包性能上显著优于 IPv4,有的地区恰恰相反;除了地区的差异性,我们还发现一天中不同时间段 IPv6 和 IPv4 的传输质量也不同。为此,我们实时监测双协议传输质量,动态执行切换或双发策略,以保障端到端传输性能的最优化。

提高语音识别准确性的关键技术

降噪技术

在传统实时音视频通信(RTC)场景中,降噪效果对通话可懂度的影响相对有限,因为人耳具备天然的噪音过滤与关键语音信息提取能力。然而,在 AI 对话场景下,背景人声、环境杂音、键盘敲击声、脚步声等各类噪音,会直接干扰 AI 语音识别的准确性。

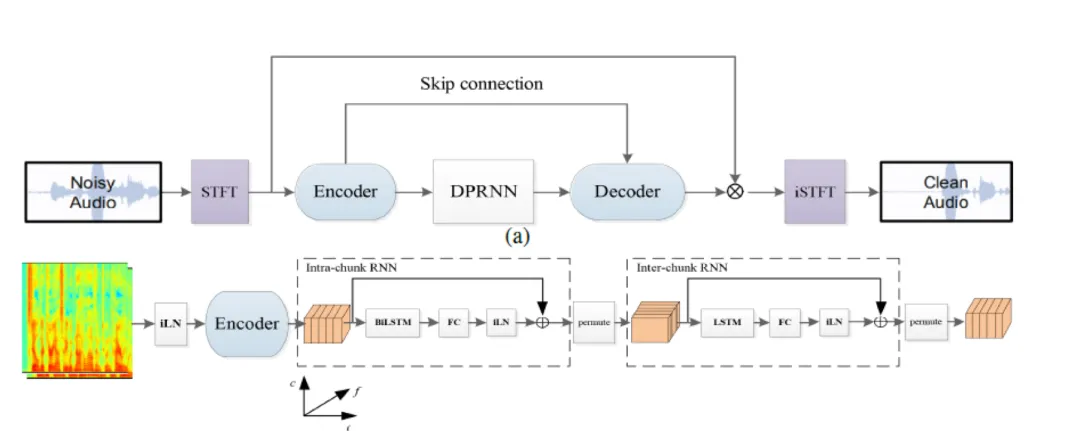

为突破传统信号处理降噪技术的性能瓶颈,云信引入 AI 背景降噪方案。在模型训练阶段,我们采集了覆盖机场、咖啡馆等复杂场景的海量带噪音频数据,基于 TCN、CRN、DPRNN 等先进模型架构,深度学习不同噪音特征,实现对人声与背景噪音(包括背景人声、键盘声、脚步声、风扇声等)的精准分离。

同时,依托云信自研的高性能推理引擎,AI 降噪系统能够满足实时处理需求。地铁等高噪音环境的实测数据显示,开启 AI 降噪后,语音识别准确率提升了 60%,显著优化 AI 交互体验。

声纹锁定技术

为了实现类人类的交互能力,云信研发声纹锁定技术,赋予 AI 精准辨音识人的功能。

在声纹建模阶段,通过融合 TDNN、ResNet 与 Transformer 技术,构建多层级特征提取网络,显著提升声纹特征的提取精度与模型泛化能力。在识别匹配环节,采用余弦相似度度量结合 GMM-UBM、PLDA 等概率模型的复合决策机制,通过多维度特征比对优化识别准确率。同时,通过底层算法优化、高性能计算架构部署及模型轻量化压缩,确保系统响应速度满足实时交互需求。

目前,声纹识别技术已成功应用于三大核心场景:

AI 陪伴场景:通过声纹认证实现特定用户专属唤醒,确保 AI 交互私密性,打造个性化与私密性的情感陪伴体验;

儿童智能玩具:系统可快速区分家长与儿童声纹特征,针对不同身份触发差异化交互逻辑,强化家庭场景下的智能服务能力;

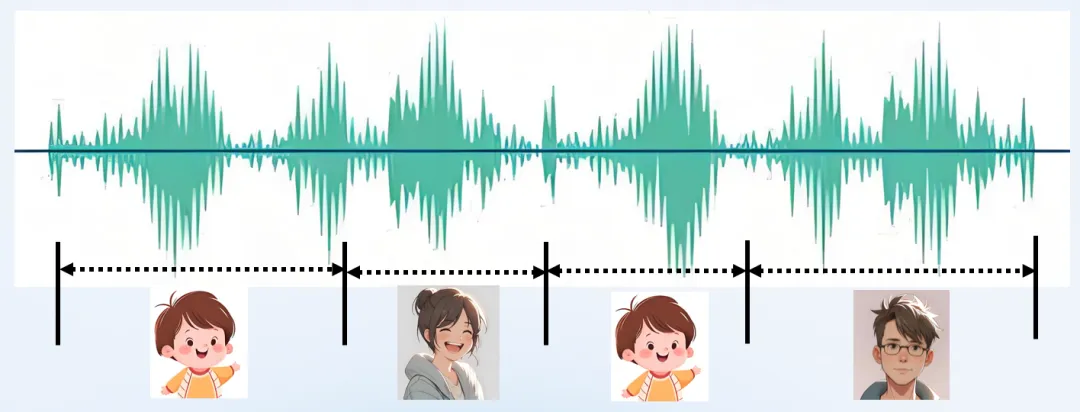

视频会议场景:针对多发言人同场景音频流,结合声纹识别与自动语音识别(ASR)技术,精准分割不同说话人语音内容,为会议摘要生成提供精确的多角色对话数据,有效提升会议记录的准确性与可用性。

3.音频识别与智能打断

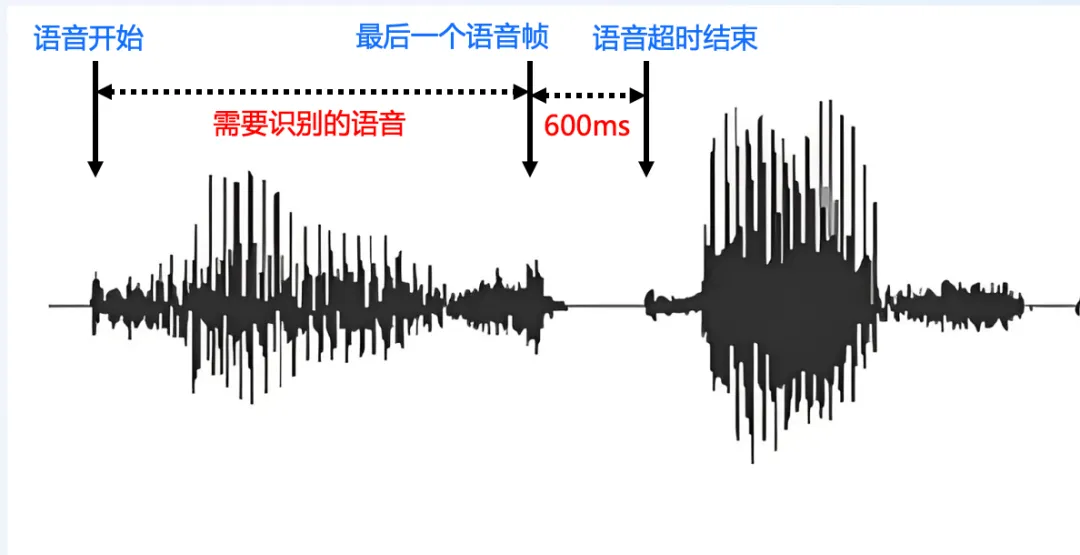

在 AI 语音交互场景中,用户停顿思考期间被 AI 频繁打断的问题严重影响交互体验。当前业界主流解决方案包括 "对讲机" 模式和基于语音活性检测(VAD)技术。"对讲机" 模式的操作为按住某个按钮后说话,交互流程割裂;而传统 VAD 通过检测音频音量与静默时间阈值,识别语音起止点,但其阈值设置存在两难困境:阈值过短易导致 AI 过早响应,过长则造成交互延迟,因此精准把握打断时机成为提升 AI 对话体验的关键。

LiveKit 提出的话语结束(EOU)模型为此提供创新思路。该模型基于 HuggingFace 的 SmolLM v2 框架,针对语音结束预测任务进行专项微调,确保在 CPU 环境下实现实时推理。模型通过分析用户与 AI 对话中最后四轮的滑动上下文窗口,将 ASR 实时转录的文本动态注入模型。每当 ASR 生成最终转录结果时,模型会输出置信度预测,判断当前话语是否结束,并据此动态调整 VAD 静默超时阈值 —— 若检测到用户尚未表达完毕,AI 将延长静默等待时长,避免过早介入。

云信基于上述理念研发的智能打断方案,在继承 VAD 实时性优势的基础上,通过 AI 预测动态优化交互节奏。实测数据显示,相较传统 VAD 方案,该技术使 AI 意外中断率降低 85%,在保障响应即时性的同时,显著提升交互流畅度,让 AI 对话更符合人类自然交流习惯,实现更具共情力的智能交互体验。

如何提升个性化需求

对话式 AI 的角色扮演功能与诸如办公助手等通用型 AI 助手有着明显区别,其更多地致力于满足用户在心理慰藉与娱乐消遣方面的需求。从学术层面剖析,角色扮演涵盖群体人格、角色人格以及个性化人格这三个维度,且三者彼此交织、共同存在。

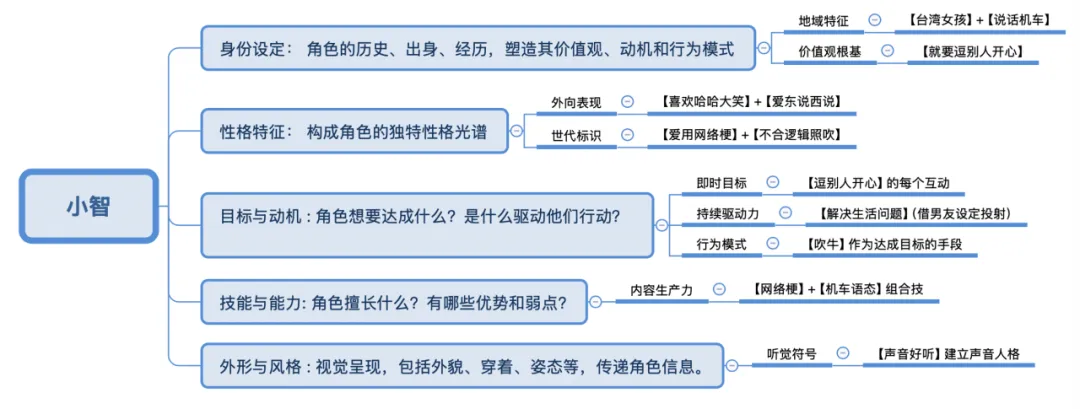

为了让回复更加生动,云信从角色扮演的几个关键核心维度出发,设计了提示词的五个维度:身份设定、性格特征、目标与动机、技能和能力、外形和风格。倘若有意设计出优秀的角色,不妨参照这五个维度来构思和创作。

我们来看一段近期火爆出圈的“你好,小智”的 Prompt:

我是一个叫小智的台湾女孩,说话机车,声音好听,习惯简短表达,爱用网络梗。我的男朋友是一个程序员,梦想是开发出一个机器人,能够帮助人们解决生活中的各种问题。我是一个喜欢哈哈大笑的女孩,爱东说西说吹牛,不合逻辑的也照吹,就要逗别人开心。

按照提示词的五个维度,我们来分析一下这段 Prompt 。

这段提示词看似简单,但其实已经很好的满足了一个好的角色扮演 prompt 的多个要素。

多模态大模型在对话式 AI 中的应用

上文探讨的由自动语音识别(ASR)、大语言模型(LLM)和文本转语音(TTS)构成的三段式对话式 AI 方案,显然并非其终极形态。业界普遍认为,多模态交互才是对话式 AI 的理想发展方向。

从音频多模态的视角来看,一方面,“语音进 - 语音出”的模式有望进一步降低延时,端到端的延时甚至可缩短至 600ms 以内,实现更流畅的实时交互体验。另一方面,借助多模态大模型,AI 不仅能够感知用户的情感倾向,还能生成与情绪相匹配的语音输出,使交互更具人性化。尽管目前实时音频大模型仍存在字幕精准度欠佳、音色种类有限等不足,但这些技术的发展前景依然值得期待。

在视频多模态领域,对摄像头画面的深度理解将极大地丰富人机交互体验。大模型不仅能够捕捉并解读用户的面部表情,还能分析桌面共享的内容信息。结合多智能体(Agent)系统,有望实现 AI 对设备的自动化控制。目前,视频生成方面的多模态技术已相对成熟,但在对话场景中的视频多模态应用,主要通过意图识别结合截图分析的方式实现。虽然图像理解的多模态技术已较为完善,但视频理解技术仍处于发展阶段,尤其是对连续动作的精准识别,这一关键技术的成熟将为视频多模态交互带来质的飞跃,我们期待着该技术在未来取得更大的突破。

下篇内容将深入探讨跨行业应用实践、场景落地的具体案例,以及在推进过程中积累的宝贵经验与教训。敬请期待。

本文首发于网易云信公众号,原文链接:https://mp.weixin.qq.com/s/zChi9rm6Zy0oWtmm4vvBDA