这个除夕,所有的聚光灯理应给到 DeepSeek。

刚刚,人工智能社区 Hugging Face 显示,DeepSeek 刚刚发布了开源多模态人工智能(AI)模型 Janus-Pro,这是一款基于 DeepSeek-LLM-1.5b-base 和 DeepSeek-LLM-7b-base 构建的模型。在这系列模型中,Janus-Pro-7B 在 GenEval 和 DPG-Bench 基准测试中击败了 OpenAI 的 DALL-E 3 和 Stable Diffusion。

GitHub 项目地址:https://github.com/deepseek-ai/Janus?tab=readme-ov-file

HuggingFace 项目地址:https://huggingface.co/deepseek-ai/Janus-Pro-1B

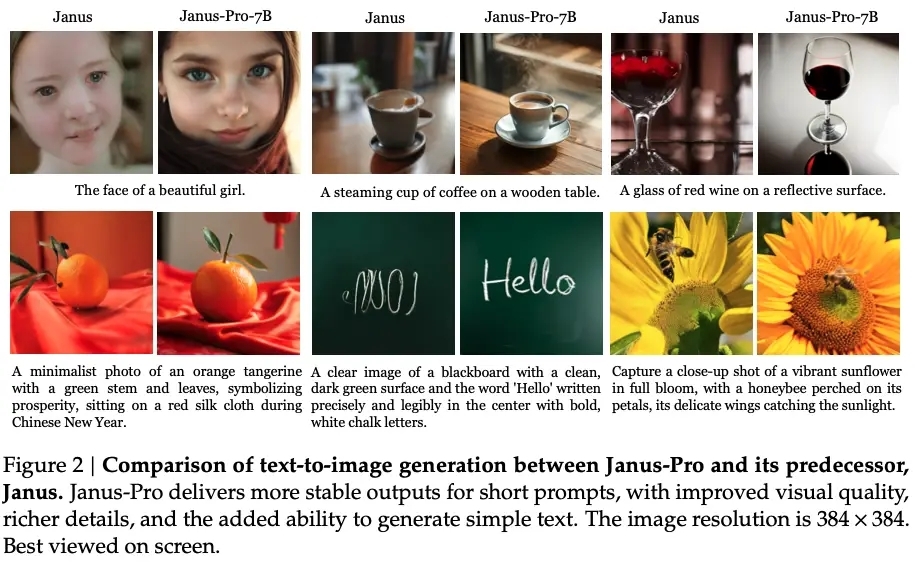

据悉,Janus-Pro 是一种创新的自回归框架,旨在统一多模态理解与生成任务。它通过将视觉编码解耦为独立的路径,同时仍采用单一的统一 Transformer 架构进行处理,从而解决了以往方法的局限性。这种解耦不仅缓解了视觉编码器在理解与生成任务中的角色冲突,还增强了框架的灵活性。值得一提的是,Janus-Pro 超越了以往的统一模型,还在性能上媲美甚至超越了针对特定任务设计的模型。

Janus-Pro 的发布在网上引发了轩然大波,但也有网友认为,Janus-Pro 虽然在基准测试中赢了 DALL-E 3,但基准测试毕竟不等于实际应用,DPG-Bench 看重生成质量和理解能力,实际用起来效果还得看落地表现。

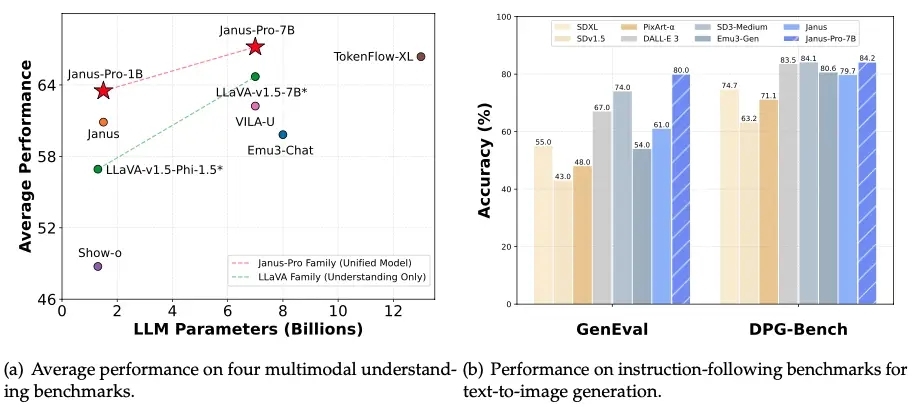

具体来说,Janus-Pro-7B 在多模态理解基准 MMBench 上取得了 79.2 的分数,超越了 Janus (69.4)、TokenFlow (68.9)等最先进的统一多模态模型,和 MetaMorph (75.2)。此外,在文本到图像指令跟踪排行榜 GenEval 中,Janus-Pro-7B 得分为 0.80,优于 Janus (0.61)、DALL-E 3 (0.67) 和 Stable Diffusion 3 Medium(0.74)。

Janus-Pro-7B 在 GenEval 上获得了 80% 的总体准确率,这优于所有其他统一或仅生成的方法,例如 Transfusion (63%) SD3-Medium (74%) 和 DELLE-E 3 (67%)。这表明我们的方法具有更好的指令跟踪能力。另外,Janus-Pro 在 DPG-Bench 上获得了 84.19 的分数,超过了所有其他方法。这表明 Janus-Pro 擅长遵循密集的指令来生成文本到图像。

在多模态理解方面,它使用 SigLIP-L 作为视觉编码器,支持 384x384 的图像输入。在图像生成方面,Janus-Pro 使用了来源于此的分词器(tokenizer),其下采样率为 16。

但值得一提的是,由于太过火爆,DeepSeek 现在已经限制国外新用户注册了,海外用户需要购买虚拟账号注册方能使用。

DeepSeek 在其官方公告中表示:近期 DeepSeek 线上服务受到大规模恶意攻击,为持续提供服务,暂时限制了+86 手机号以外的注册方式已注册用户可以正常登录,感谢理解和支持。

最后,祝大家新春快乐!