近日,第 2024 届 ECCV 联合举办的 AIM Workshop 大赛公布比赛结果,在视频超分辨率质量评估赛道上,火山引擎多媒体实验室凭借基于大模型的画质评估算法获得冠军,技术能力达到行业领先水平。

大赛背景

AIM (Advances in Image Manipulation) 2024 是新兴的计算机视觉国际竞赛,每年在模式识别和机器视觉顶级国际会议 ECCV 上举行。该比赛旨在鼓励学者和研究人员探索计算机视觉中图像恢复和提升的新技术和方法,并且促进学术交流,在计算机视觉领域获得了广泛的关注和参与,吸引了众多高校和业界知名公司参加。

近年来视频和图像超分辨率(SR)技术得到了广泛学术研究,同时在短视频业务服务端/客户端中有着广泛的应用,它能够显著提升用户的主观观看体验,提高内容的清晰度和视觉吸引力。为了评估不同超分辨率算法的主观画质提升效果,需要使用图像和视频质量评估指标。然而由于难以捕捉超分辨率引发的复杂多样的增强伪影,传统算法 PSNR 和 SSIM 以及其他基于深度学习的方法均被证明无法准确估计超分辨率图像的质量。因此,超分辨率质量评估与普通的图像和视频质量评估任务是有所不同的,本次竞赛旨在针对超分辨率进行专用评估指标的研究,推动这一领域的发展。

冠军算法介绍

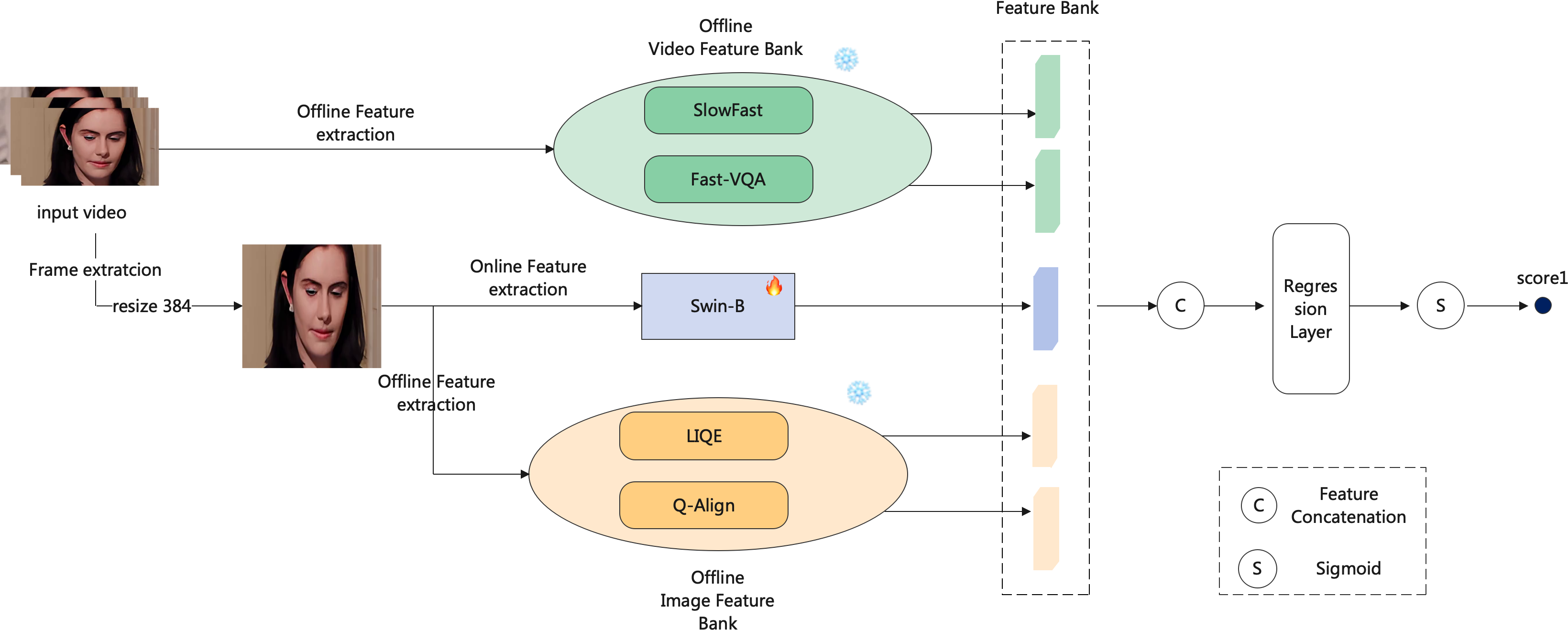

超分辨率画质评估的主要挑战在于如何捕捉超分辨率画质算法处理后内容的画质变化因素,相比传统质量评估需要考虑更复杂多样化的处理算法带来伪影/涂抹/过锐等失真类型。由于有限的样本数量和数据集大小,端到端的训练方案无法达到理想效果,经过多轮方案验证,团队最终采用 Rich Quality-Aware Feature 算法方案架构,针对多样化的视觉内容和复杂的失真类型,利用空域模型微调,同时利用丰富离线视频特征库和图像特征库来增强模型的泛化能力。微调模型采用了预训练于 LSVQ 数据集的 Swin Transformer-B 作为主干网络来提取空域特征,离线视频特征库包含 SlowFast 时域特征和 Fast-VQA 时空联合特征;离线图像特征库提供了全面的帧级特征表示,其中 LIQE 包含质量感知、失真特定及场景特定的信息,而 Q-Align 则包含来自多模态模型(MLLM)的强大质量感知特征。最终将可学习和不可学习的特征拼接在一起,经非线性回归层得到预测分数,最终分数通过 Sigmoid 函数转换为 [0-1] 范围。

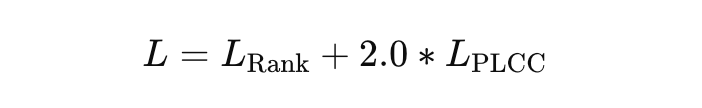

除了算法层面的综合分析设计和数据增广处理等,团队对数据集进行深入的分析理解,数据集根据失真的难度分为 Easy/Moderate 和 Hard 三种难度,Hard 难度包含了目前大多数评估指标无法解决的失真类型,从训练集的主观评分分布我们也观察到困难组的视频主观评分相比简单组和中等组更难区分,为了增强泛化能力防止算法模型在 easy 数据集出现过拟合的问题,除了 PLCC 损失外,我们还应用了成对排序的 hinge 损失来引导模型区分困难样本,同时快速学习简单样本。训练损失函数为:

其中排序边距设为 0.05。我们在 8 块 A100-SXM-80GB GPU 上进行了 100 个 epoch 的训练,学习率为 1e-5,批次大小为 16。我们随机选取了 80% 的视频作为训练数据,20% 的视频用于验证,并选择在验证集中表现最佳的模型进行最终测试。

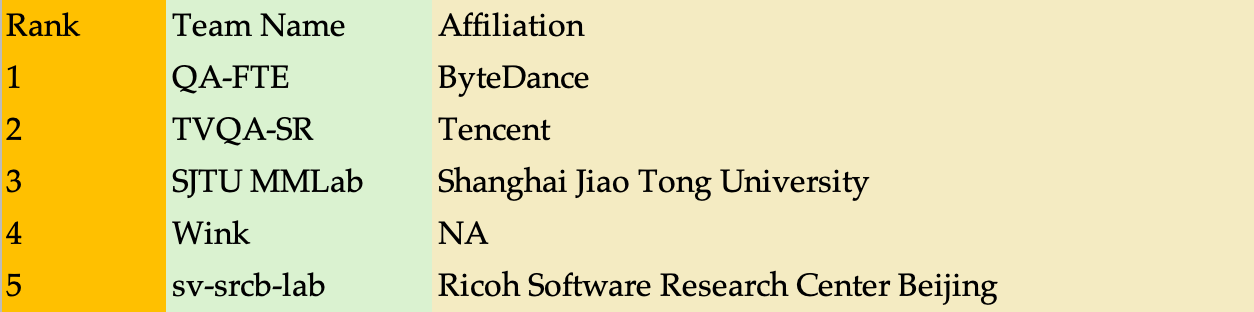

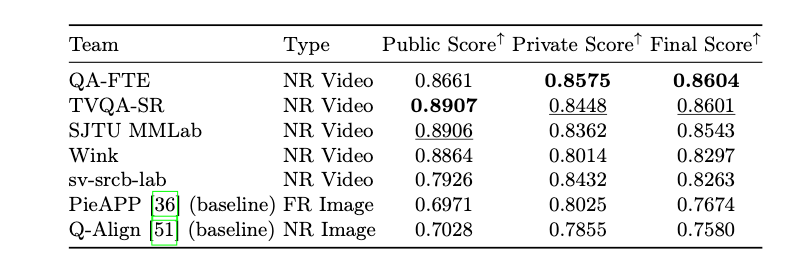

最终团队在 private 数据集获得最好的效果,通过 public 和 private 两部分内容的稳定发挥获得第一名的成绩。

总结

火山引擎多媒体实验室在视频超分质量评估领域实现了突破性的进展,并获得了该赛道冠军。增强处理算法质量评估算法的沉淀积累可以帮助处理算法和应用策略的迭代优化,从而更高效地给用户提供更为清晰主观视觉体验,有助于推动数字媒体行业向着更加智能化、高效化的方向发展。

火山引擎多媒体实验室是字节跳动旗下的研究团队,致力于探索多媒体领域的前沿技术,参与国际标准化工作,其众多创新算法及软硬件解决方案已经广泛应用在抖音、西瓜视频等产品的多媒体业务,并向火山引擎的企业级客户提供技术服务。实验室成立以来,多篇论文入选国际顶会和旗舰期刊,并获得数项国际级技术赛事冠军、行业创新奖及最佳论文奖。

火山引擎是字节跳动旗下的云服务平台,将字节跳动快速发展过程中积累的增长方法、技术能力和工具开放给外部企业,提供云基础、视频与内容分发、大数据、人工智能、开发与运维等服务,帮助企业在数字化升级中实现持续增长