Stability AI 发布了 Stable Diffusion 3.0,这款图像生成 AI 模型再次刷新了人们的认知。

这款由 Stability AI 倾力打造的文本变图模型,可是迄今为止最强大的“黑科技”! 无论你想生成多主题的奇幻场景,还是高精度的风景写真,统统不在话下!

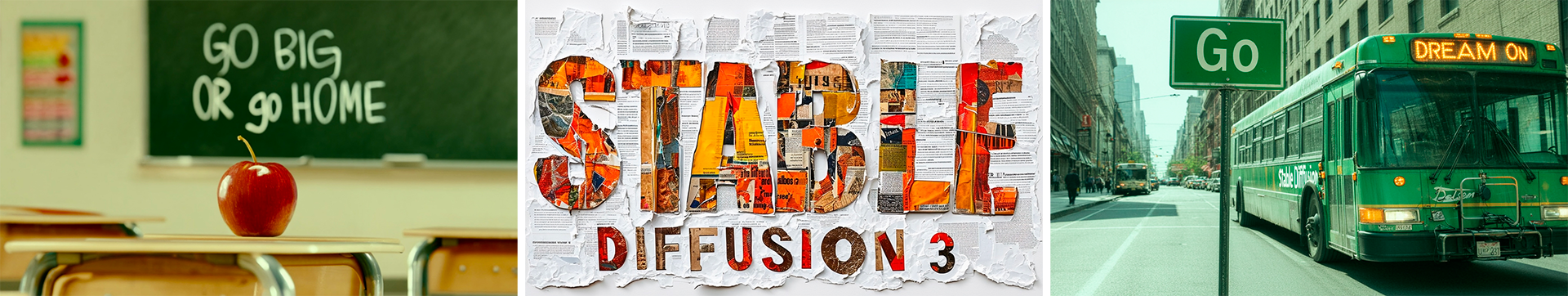

Stability AI 强调了该版本的几个亮点,其中首要的就是文字渲染能力,他们在其官网上一连给了三幅含有文字的图片,不仅文字清晰而且也没有任何拼写错误。

Stability AI 的首席执行官 Mostaque 也在 X(Twitter)上狂炫带有文字的图片:

Stable Diffusion 3.0 中改进的排版是 Stability AI 在新模型中构建的几个改进的结果。

Stability AI 的首席执行官 Mostaque 说:“这归功于 Transformer 架构和额外的文本编码器。现在可以实现完整的句子和一致的风格。”

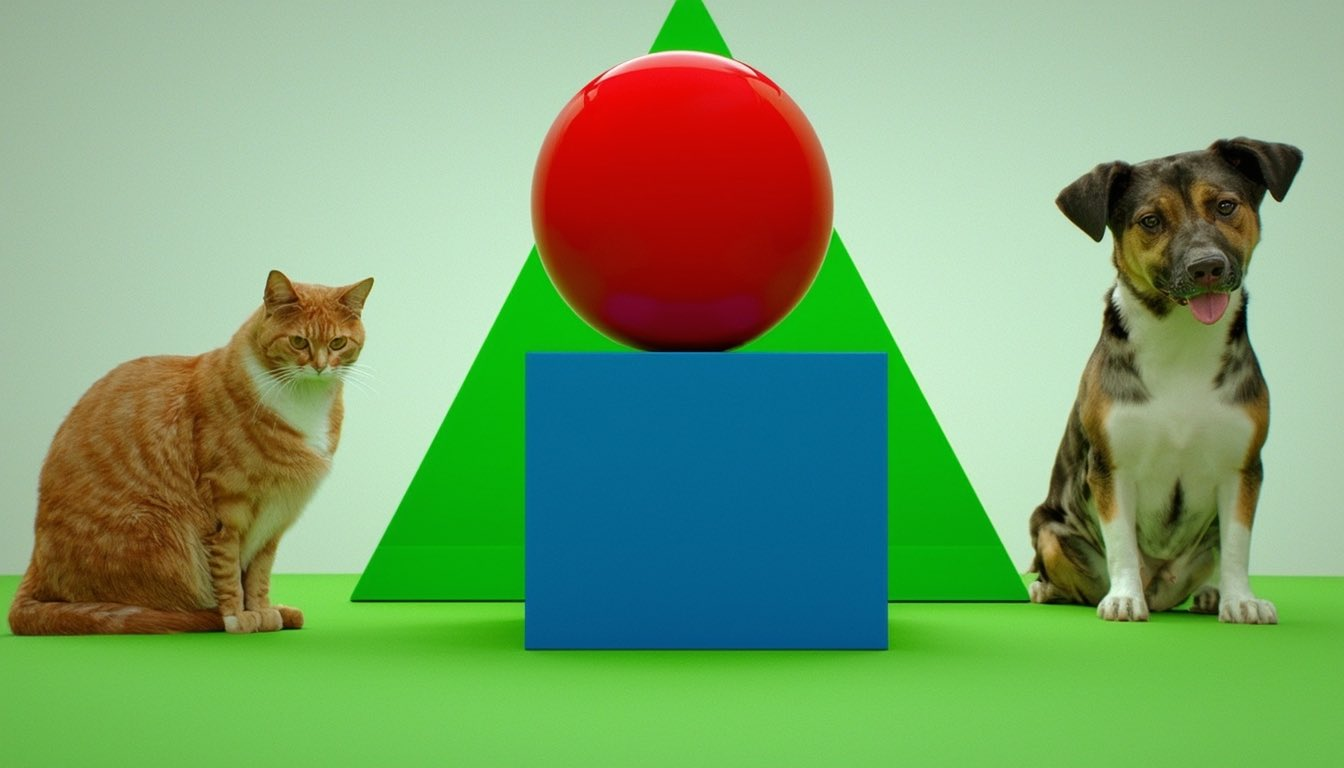

另一个亮点是“多主题生成”:用一句话,就能描绘出用户脑中的万千世界!

Stability AI 举了一些例子,让 SD3 根据一句含有多个元素的 Prompt 画一幅画:

“一幅画作,描绘了一位宇航员骑着一头穿着芭蕾舞裙的猪,手里还撑着一把粉色雨伞。在猪旁边,一只戴着高顶礼帽的知更鸟静静伫立。画面一角,写着‘Stable Diffusion’。”

“一张照片,画面中有一个红色的球体放在一个蓝色的立方体上面。它们的后面有一个绿色的三角形,右边有一只狗,左边有一只猫。”

其中一个主题元素变化还能不影响其他元素:

还有一个亮点就是“超高画质”,这简直是细节控的福音,每一张图片都堪称艺术品!例如下面这张变色龙特写照片:

而且生成的漫画和素描,质感也比之前的版本进步了一个台阶:

虽然 Stable Diffusion 3.0 最初被展示为文本转图像生成 AI 技术,但它将成为更广泛应用的基础。Stability AI 近几个月也在开发 3D 图像生成和视频生成功能。

Mostaque 说:“我们制作可以随时随地使用并适应任何需求的开放模型。这是一个跨尺寸的模型系列,将支持我们下一代视觉模型的发展,包括视频、3D 等。”

Mostaque 也在 X(Twitter)给出了一个 SD3D 的视频:

而且,Stable Video 也正式开放公测了,支持图生视频和文生视频。尽管人们都在关注 Sora,但有人估计至少 Sora 还需要三个月才能开始内测。需要强调的是,这是内测,不同于像 Stable Video 这样的公开测试。

从官网放出的例子来看,生成视频在画面稳定性、运动幅度、画面细节丢失上,效果跟 Sora 不相上下。

而一些试玩了 Stable Video 的网友,还是觉得跟 Sora 有所差距,并对此评论:“越来越期待 Sora 了”。该网友表示,“用自己的照片试用了一下 Stable Video,发现只有没有脸的图才能有比较好的生成结果,有脸的都崩了。”其他网友补充称,有脸的图调低 motion 值也可以得到相对正常的结果,但会很卡顿。

架构变革:采用类似 Sora 模型架构

在过去的一年中,Stability AI 一直在稳步迭代和发布多个图像模型,每个模型都显示出越来越高的复杂性和质量。7 月份发布的 SDXL 大幅改进了 Stable Diffusion 基础模型,现在该公司正寻求更进一步的发展。

新的 Stable Diffusion 3.0 模型旨在提供改进的图像质量和更好的性能,以从多主题提示生成图像。它还将提供比以前的 Stable Diffusion 模型更出色的排版,从而在生成的图像中实现更准确和一致的拼写。过去,排版一直是 Stable Diffusion 的一个弱点,包括 DALL-E 3、Ideogram 和 Midjourney 在最近的版本中也一直在努力解决这个问题。Stability AI 正在构建各种模型大小的 Stable Diffusion 3.0,模型可选择的参数范围在 800M 到 8B 。

Stable Diffusion 3.0 不仅仅是 Stability AI 已经发布的模型的新版本,它实际上基于一种全新的架构。

Emad Mostaque 表示,Stable Diffusion 3 是原始 Stable Diffusion 的正统续作。它采用了类似于 OpenAI 近期发布的 Sora 模型的 Diffusion Transformer 新架构,代表了该领域的最新技术突破。

“Diffusion Transformer”技术在 2022 年首次提出,并在 2023 年进行了改进,现在已经实现了可扩展性。 此外,Stable Diffusion 3.0 还采用了“流匹配”技术,这也是另一项改进质量且不会增加太多额外负担的新技术。

Stability AI 一直在尝试多种图像生成方法。本月早些时候,该公司发布了 Stable Cascade 的预览版,它使用 Würstchen 架构来提高性能和准确性。Stable Diffusion 3.0 采取了不同的方法,使用了 Diffusion Transformer。

Mostaque 强调说:“Stable Diffusion 以前没有 Transformer。”

Transformer 是许多生成 AI 革命的基础,被广泛用作文本生成模型的基础。图像生成主要在 Diffusion 模型领域。详细介绍 Diffusion Transformer (DiT) 的研究论文解释说,它是一种新的 Diffusion 模型架构,它用操作潜在图像块的 Transformer 取代了常用的 U-Net 主干。DiT 方法可以更有效地利用计算资源,并且可以超越其他形式的 Diffusion 图像生成。

Stable Diffusion 的另一个重大创新是流匹配 (flow matching)。 流匹配的研究论文解释了它是一种训练 Continuous Normalizing Flows (CNFs) 以模拟复杂数据分布的新方法。根据研究人员的说法,使用 Conditional Flow Matching (CFM) 和 optimal transport paths(最佳传输路径),与 diffusion paths 相比,可以实现更快的 training、更有效的采样和更好的性能。

参考链接:

https://stability.ai/news/stable-diffusion-3