3 月 14 日,商汤科技发布了多模态多任务通用大模型“书生(INTERN)2.5”,并已经开源。

据商汤介绍,该模型拥有 30 亿参数,是目前全球开源模型中ImageNet准确度最高、规模最大,同时也是物体检测标杆数据集 COCO 中唯一超过 65.0 mAP 的模型。

“书生(INTERN)”最初版本由商汤科技、上海人工智能实验室、清华大学、香港中文大学、上海交通大学在 2021 年 11 月首次共同发布,并持续联合研发。凭借在多模态多任务处理能力方面多项突破,“书生 2.5”的图文跨模态开放任务处理能力可为自动驾驶、机器人等通用场景任务提供高效精准的感知和理解能力支持,向通用人工智能又迈出了坚实一步。

即日起,“书生 2.5”多模态通用大模型已在商汤参与的通用视觉开源平台 OpenGVLab 开源。

迈向 AGI 通用人工智能

在当今快速增长的各式应用场景需求下,传统计算机视觉已无法处理真实世界中数不胜数的特定任务和场景需求。我们迫切需要一种具备通用场景感知和复杂问题处理能力的高级视觉系统。

“书生 2.5”实现了通过文本来定义任务,从而可以灵活地定义不同场景的任务需求,并根据给定视觉图像和任务的提示性语句,给出相应的指令或作答,进而具备通用场景下的高级感知和复杂问题处理能力,比如图像描述、视觉问答、视觉推理和文字识别等。

在自动驾驶和居家机器人等通用场景下,“书生 2.5”可辅助处理各种复杂任务。例如在自动驾驶场景下,可以大幅提升场景感知理解能力,准确地辅助车辆判断交通信号灯状态、道路标志牌等信息,为车辆的决策规划提供有效信息输入。

“书生 2.5”同时具备AIGC“以文生图”的能力,可根据用户提出的文本创作需求,利用扩散模型生成算法,生成高质量、自然的写实图像。例如借助“书生 2.5”的以文生图能力帮助自动驾驶技术研发,通过生成各类真实的道路交通场景,如繁忙的城市街道、雨天拥挤的车道、马路上奔跑的狗等,生成写实的 Corner Case 训练数据,进而训练自动驾驶系统对 Corner Case 场景的感知能力上限。

“书生 2.5”还可根据文本快速检索出视觉内容。例如,可在相册中返回文本所指定的相关图像,或是在视频中,检索出与文本描述最相关的帧,提高视频中时间定位任务的效率。此外还支持引入物体检测框,根据文本返回最相关的物体,可实现开放世界视频或图像中物体检测及视觉定位。

囊括三大模型能力,打通 NLP、图像等多模态任务处理

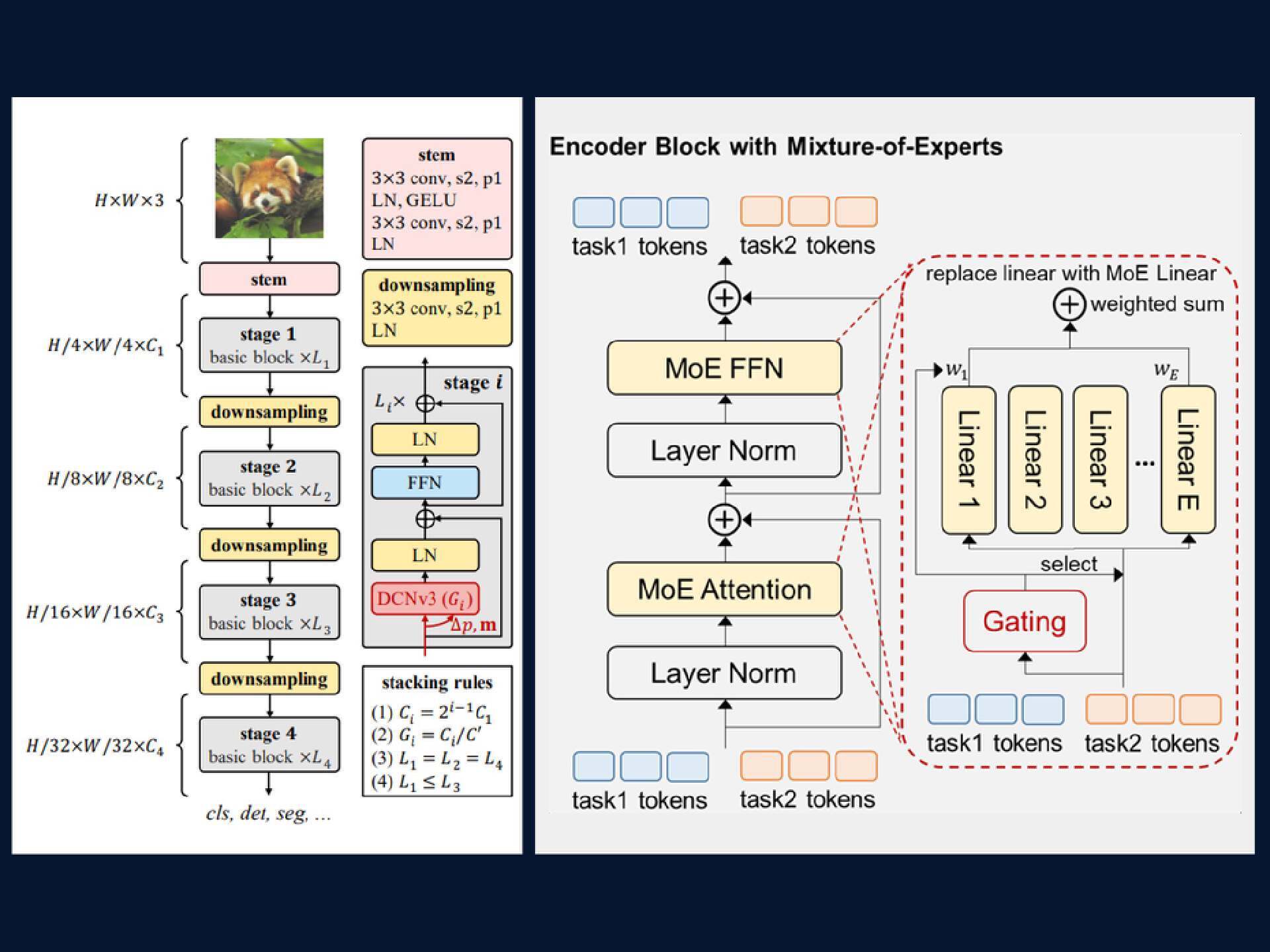

“书生 2.5”在图文跨模态领域优秀的性能表现来自于视觉、语言及多任务建模三大模型能力的有效融合,即 InternImage-G 通用视觉大模型、用于文本理解的超大语言预训练模型(LLM)和用于多任务的兼容解码建模大模型(Uni-Perceiver)。

其中,InternImage-G 通用视觉大模型能够基于动态稀疏卷积算子自适应地调整卷积的位置和组合方式,从而为多功能视觉感知提供强大的表示。

超大语言模型通过在超大规模丰富文本语料库上进行预训练提供强大可靠的文本特征。Uni-Perceiver 通才任务解码建模通过将不同模态的数据编码到统一的表示空间,将不同任务统一为相同的任务范式,从而能够以相同的架构和共享的模型参数同时处理各种模态和任务。此外,“书生 2.5”还创新性地引入了任务级别的稀疏激活机制,使其具备高效的多任务协作能力。

在视觉主流图像分类数据集 ImageNet 上,该模型仅基于公开数据便达到了 90.1%的 Top-1 准确率。这是除谷歌与微软之外,唯一准确率超过 90.0%的模型,值得一提的是,谷歌与微软均未公开模型及额外数据集。

“书生 2.5”项目地址:https://github.com/OpenGVLab/InternImage