大模型的价值潜能有目共睹,但“成本黑洞”也不失为一个事实。除了寻找最佳落地路径和业务场景之外,大模型的成本问题也一直备受关注。作为一个短板效应明显的系统工程,万亿级参数规模,背后不但涉及巨大的算力资源消耗,还有随之而来的存储、推理、运维、应用等一系列成本。

如何才能让“烧钱”的大模型物超所值,解决绝大多数企业当下最关心的“降本增效”问题?腾讯正在通过实践不断探索和寻求他们的答案。

在 6 月 14 日 -6 月 15 日即将于深圳举办的 ArchSummit 全球架构师峰会上,我们邀请到了来自腾讯多个不同条线的技术专家,从训练框架、开发、落地应用等多个维度分享现阶段企业如何利用大模型实现降本增效的目标。

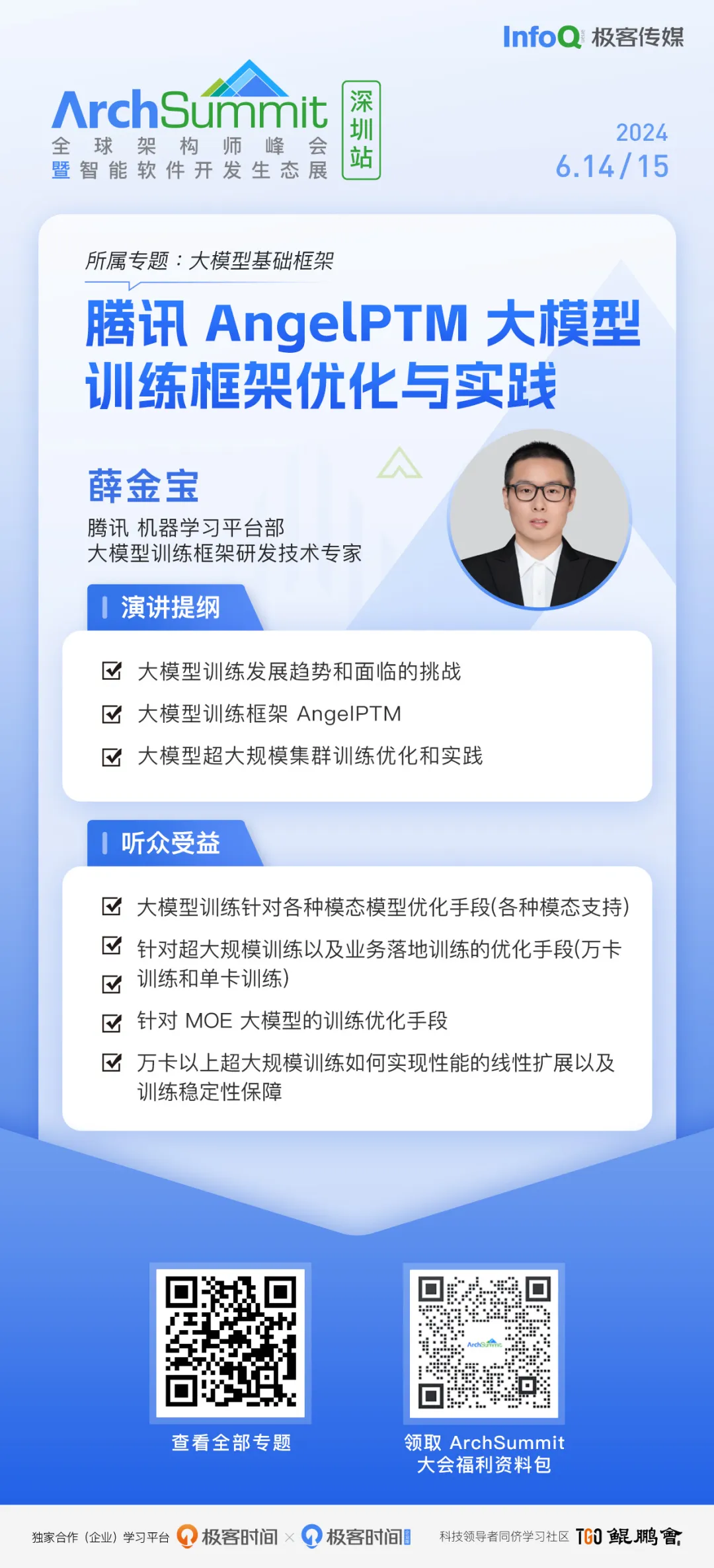

拿训练框架来说,目前不仅要支持文生文、多模态、文生图、文生视频等大模型训练,还要支持 Dense 和 MoE 模型的训练;不仅要支持小模型的训练,还要支持万亿参数模型的训练;不仅要支持单任务单卡大模型的训练,还要支持单任务万卡规模大模型的训练;不仅要支持同构 GPU 的训练,还要支持异构 GPU 的加速训练,如何满足大模型训练的多种加速需求,成为大模型 AI Infra 的必须解决的挑战。

基于对存储、网络、计算的深度融合优化,腾讯研发了 AngelPTM 大模型训练框架,其通过 6D 并行策略提高模型的训练并行度、通过 ZeROCache 解决大模型训练显存压力大的问题,通过 MOE 加速组件解决超大规模参数模型高效训练的问题,通过与星脉高速网络的协同优化,与算力、服务器、存储等团队的通力配合来解决单任务万卡训练的问题。

据悉,通过 AngelPTM 支持文生文、多模态、文生图 / 视频等大模型的高速训练,单任务万卡训练可实现长时间的稳定高性能训练。

围绕这些话题,腾讯机器学习平台部大模型训练框架研发技术专家薛金宝将在 ArchSummit 深圳带来《腾讯 AngelPTM 大模型训练框架优化与实践》的议题分享。

软件开发是大模型较早入局的落地场景之一,通过与低代码技术的结合,开发效率提升将迈入新的台阶。

具体而言,低代码平台旨在使用少量代码,高效的搭建页面。对非前端从业者友好,提供了开箱即用的无代码数据配置服务,和以 LowCode 进行了管理端研发体系升级。随着大模型的能力飞速提升,大模型的提效能力加上低代码的易用性相辅相成,将让低代码开发效率更高,更大程度降低用户的使用门槛。

在 ArchSummit 深圳,腾讯 PCG 前端技术专家苑宗鹤将分享《AI 在低代码平台搭建中的运用和挑战》。

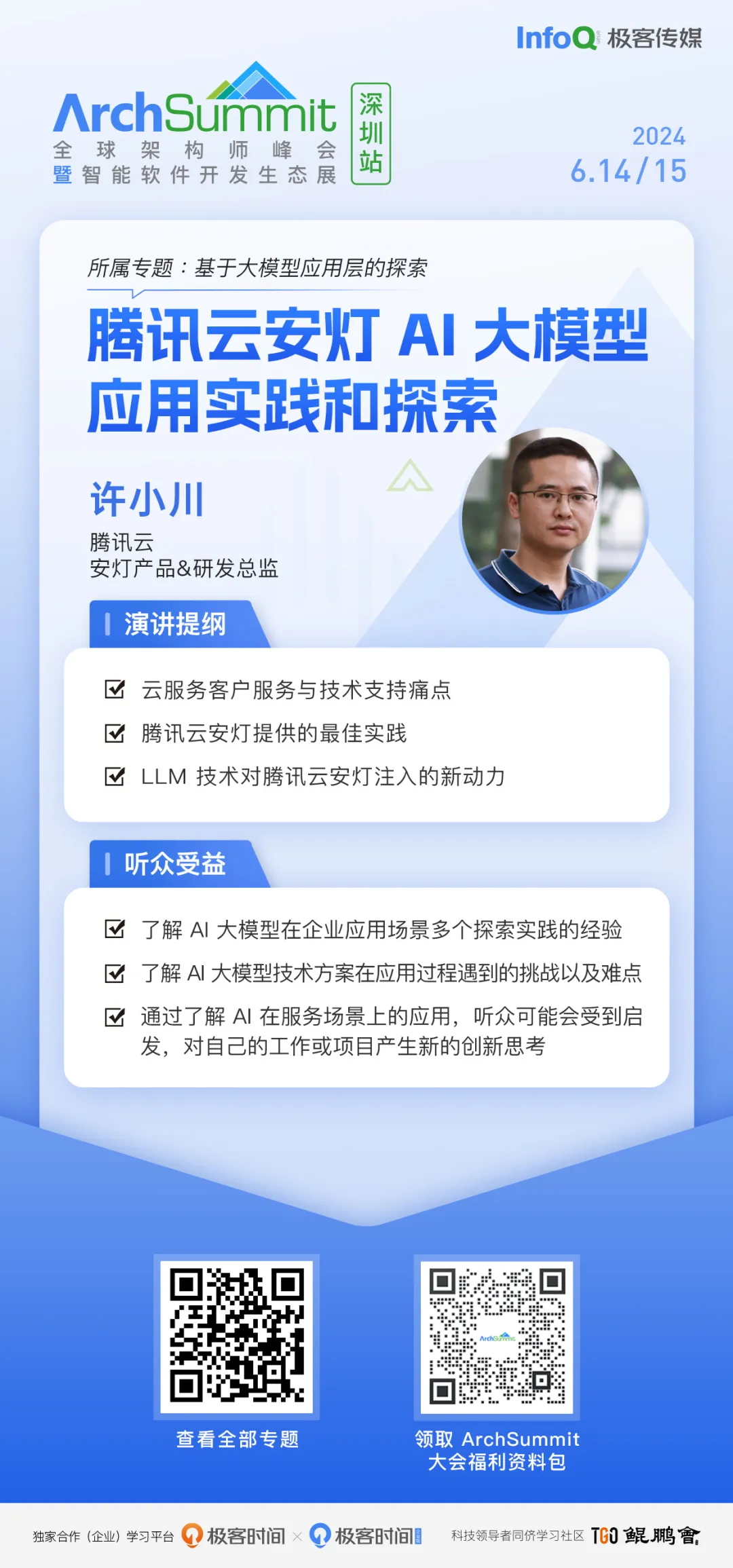

行业探索方面,腾讯云利用 RAG 技术结合私域知识,基于腾讯云行业大模型构建了 AI 智能助手,对内提升服务效率的同时,还对外提升客户自助服务降低成本,在此过程中沉淀出企业智能知识库的解决方案。此外,基于过去多年沉淀服务数据,腾讯云通过大模型理解力,构建发现问题 - 量化分析 - 改进优化 - 线上验证的闭环,持续提升自身云产品的竞争力。

腾讯云安灯产品 & 研发总监许小川将在 ArchSummit 深圳分享《腾讯云安灯 AI 大模型应用实践和探索》。腾讯云安灯是一款服务于腾讯云内部、伙伴及客户的一站式 IT 服务管理平台。随着 LLM 技术迅猛发展,其在 AI 大模型应用上做了诸多实战,帮助腾讯云、伙伴及客户降本提效、提升服务水平。

除此之外,在工业质检场景,腾讯云还联合头部标机客户,结合其在所属场景的数据优势,提供基于公有云 / 私有化服务集群的质检大模型训练服务,并与端侧单机软件打通,实现在质检行业呼唤已久“0 样本、秒换型、快应用”的新范式突破。

工业 AI 质检,从能不能到快不快,到是否能更快。腾讯云采用的解决方案是一体化方案,标准平台建设,云 + 端协同。该方案已经在 3C/ 锂电 / 光伏等复杂质检项目落地,获评工信部最佳实践,IDC 市场排名第一。

对此,腾讯云高级产品专家王刚将在 ArchSummit 深圳带来《大模型时代的工业质检方法论》的议题分享。

当然,大模型不是企业降本增效的唯一手段,也不是眼下需要重点关注和跟进的唯一技术。在建造 AI 智能化这座“高楼”的过程中,基础的技术基底也必须打牢。

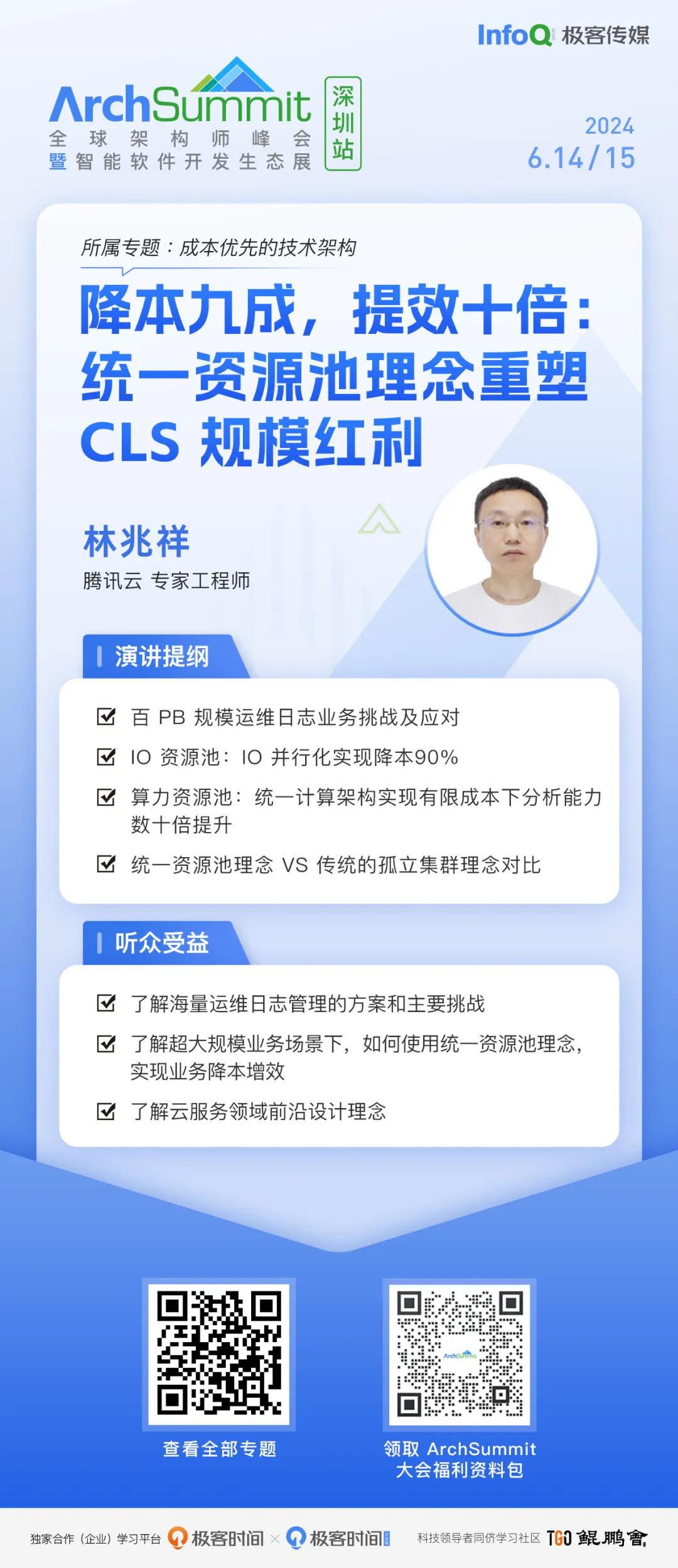

比如,如何持续提升可观测性技术中日志检索和分析等核心能力?据了解,腾讯云 CLS 利用统一资源池理念,消除了系统中各个层次的 IO 资源隔离,实现了成本降低 90% 的目标;同时在优先控制成本的前提下,通过消除全地域算力资源隔离,实现了大规模分析能力提升数十倍。

在 ArchSummit 深圳,腾讯云专家工程师林兆祥详细介绍“降本九成,提效十倍”的目标究竟是如何达成的。

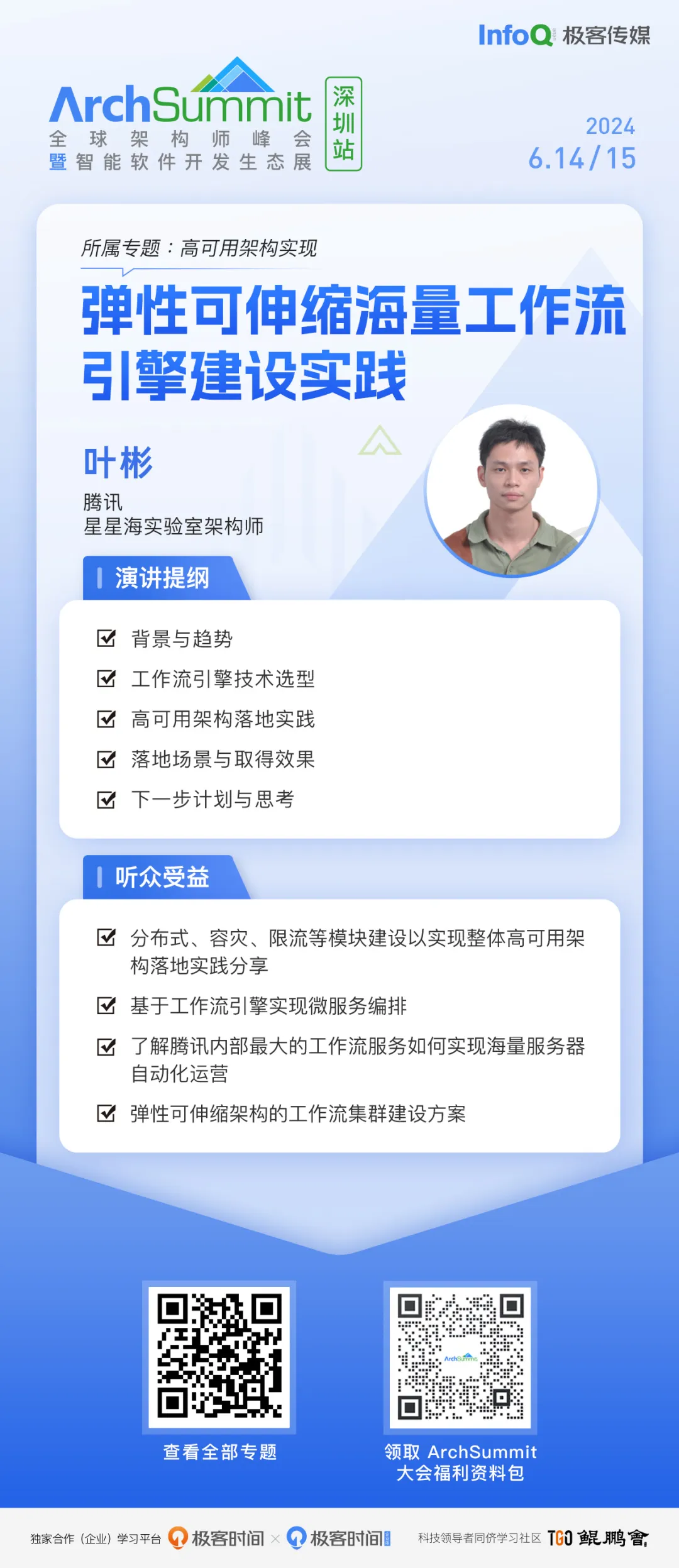

与此同时,大模型的盛行也将重塑微服务架构。微服务架构的广泛应用,把大而复杂的业务系统拆分成高内聚的微服务,对整个系统实现解耦。每个服务负责相对独立的逻辑,但是要实现业务价值,需要协调所有服务保证端到端业务流的成功。

腾讯星星海实验室架构师叶彬将在 ArchSummit 深圳分享《弹性可伸缩海量工作流引擎建设实践》,具体从业务场景出发(海量服务器全链路运营),并结合真实的业务痛点,阐述在落地过程中如何开创性实现了弹性可伸缩架构,使得该引擎具备千万级多层嵌套流程毫秒级调度、峰值十万 QPS、秒级容灾自愈的基础设施流程调度能力,有效支撑海量服务器全链路数亿级作业场景。

除了腾讯的众多优秀讲师之外,我们也邀请了(以下排名不分先后)阿里巴巴、百度、网易、字节跳动 / 火山引擎等互联网技术大厂, vivo、知乎、高德地图、Uber 、蚂蚁集团、eBay、货拉拉、快手、哔哩哔哩、携程等头部互联网企业,以及 CNCF、Thoughtworks、顺丰集团、美的集团、鸿海科技集团(富士康母公司)、宁德核电、广发证券、微众银行、众安银行、天弘基金等众多机构和企业的专家共同探讨生成式 AI 技术对于企业未来架构的影响。

目前,ArchSummit 深圳大会议程已经上线,并将持续更新,感兴趣的同学请锁定大会官网:https://archsummit.infoq.cn/2024/shenzhen/schedule。