3 月 22 日,生命未来研究所(Future of Life)向全社会发布了一封《暂停大型人工智能研究》的公开信,呼吁所有人工智能实验室立即暂停比GPT-4更强大的人工智能系统的训练,暂停时间至少为 6 个月。

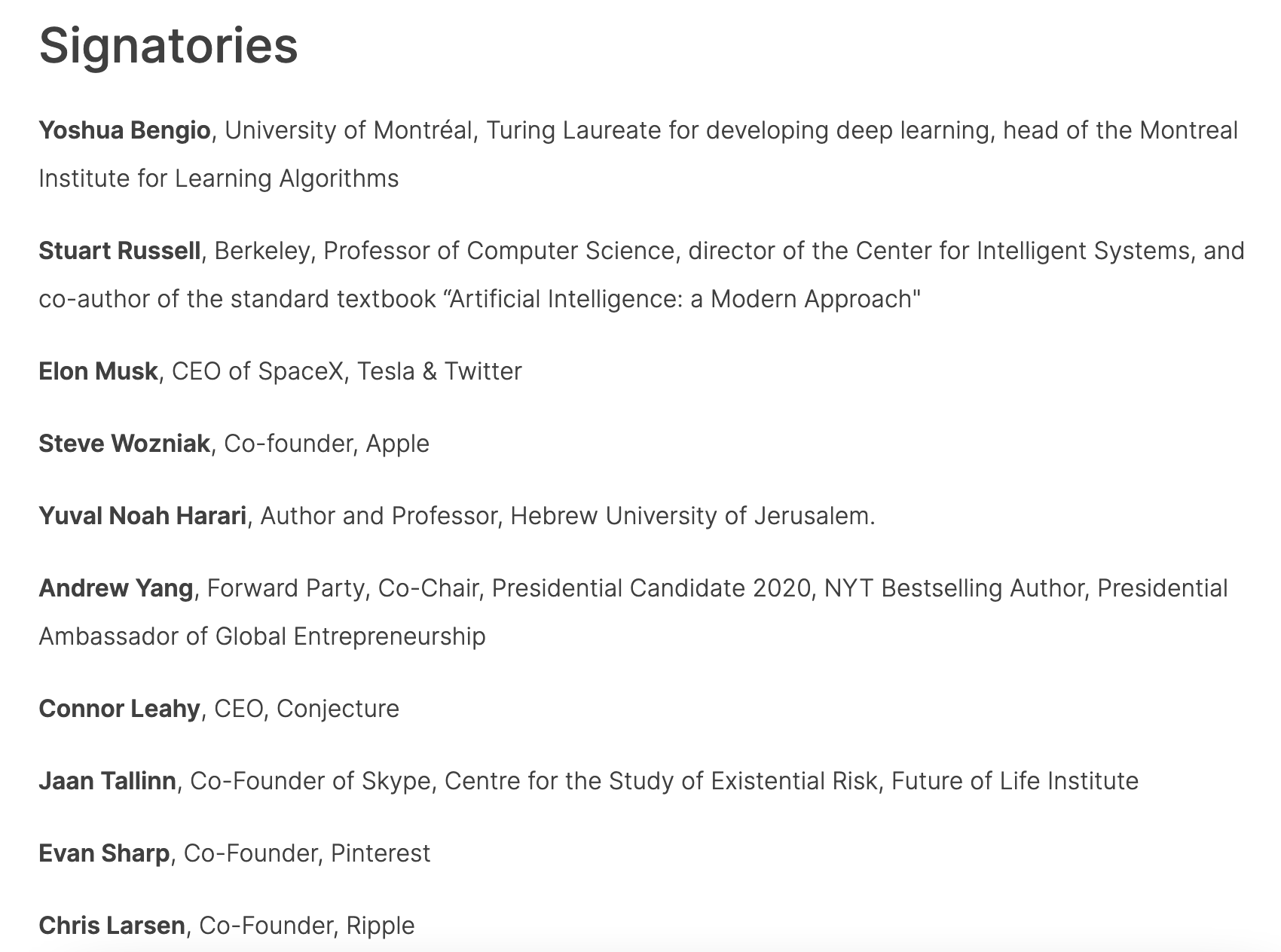

截止目前,马斯克、图灵奖得主 Yoshua Bengio、苹果联合创始人 Steve Wozniak、Stability AI 创始人 Emad Mostaque、DeepMind 高级研究科学家 Zachary Kenton 等上千名科技大佬和 AI 专家已经签署公开信。

不过,也有大佬公开表达了反对意见。图灵奖得主、Meta 首席 AI 科学家 Yann LeCun 在 Twitter 上表示:“我不会签署这个公开信,不同意这封公开信的内容。”

自ChatGPT、GPT-4 发布以来,关于 AI 与安全性的讨论声不断,甚至引发了不少科技大佬的深切担忧。

“人工智能教父”、英国计算机科学家 Geoffrey Hinton 接受 CBS 新闻的长篇采访中提到,人工智能正处于“关键时刻”。目前,人们经常提到 AGI 提高当前模型能力的预兆,但无论业界多么欢呼它的到来,或者它真正需要多长时间,Hinton 说,我们现在应该仔细考虑它的后果,这可能包括它试图毁灭人类的小问题。

3 月 25 日,OpenAI 创始人兼首席执行官 Sam Altman 在接受科技博客主 Lex Fridman 的采访时表态,他不会回避“人工智能可能杀死全人类”的说法。

在 Youtube 平台公布的视频中,Fridman 在访谈中提到了人工智能研究者、LessWrong 研究所创始人 Eliezer Yudkowsky 的观点。Yudkowsky 此前指出“人工智能可能杀死所有人”,并认为,当人工智能发展为超级智能时,几乎无法与人类站在统一战线上。

生命未来研究所在公开信中表示,通过广泛研究和顶级 AI 实验室的调查认可,具备类人智能的 AI 系统很可能对社会和人类构成深远风险。正如广受推崇的阿西洛马 AI 原则中所述,高级 AI 可能代表着地球生命史上一场影响深远的变化,应给予相应的关注和资源进行规划和管理。

生命未来研究所表示,遗憾的是,我们并没有看到这种级别的规划和管理。最近几个月来,AI 实验室陷入了一场失控般的技术竞赛,全力开发和部署一颗颗愈发强大的“数字大脑”,但就连创造者自己都无法理解、预测或可靠地加以控制。

附公开信原文:

关于叫停巨型 AI 实验的一封公开信

我们呼吁所有 AI 实验室,立即暂停对体量超过 GPT-4 的 AI 系统的训练,且暂停期至少 6 个月。

通过广泛研究和顶级 AI 实验室的调查认可,具备类人智能的 AI 系统很可能对社会和人类构成深远风险。正如广受推崇的阿西洛马 AI 原则中所述,高级 AI 可能代表着地球生命史上一场影响深远的变化,应给予相应的关注和资源进行规划和管理。但遗憾的是,我们并没有看到这种级别的规划和管理。最近几个月来,AI 实验室陷入了一场失控般的技术竞赛,全力开发和部署一颗颗愈发强大的“数字大脑”,但就连创造者自己都无法理解、预测或可靠地加以控制。

当代 AI 系统在常规任务上已经具备与人类相仿的能力,因此我们必须扪心自问:我们是否应该让机器用宣传和谎言填满信息渠道?我们真的应该推动一切工作自动化,包括目前已经令人满意的岗位吗?我们是否应当开发出最终可能超越自身、超越特种甚至取代我们的非人类思维?我们应该承担这份失去对文明掌控权的风险吗?很明显,这些问题的答案,不该由少数未经选举产生的技术领导者决定。只有当我们确信具有积极影响且风险可控时,才应当实际开发强 AI 系统。对这个问题的判断需要坚毅的决心,也要充分考虑到系统潜在影响等因素。OpenAI 近期发布的 AI 声明指出,“必须承认,在开始训练未来系统之前,可能应该认真考虑开展独立审查。对于最前沿的探索,也应该对新系统的算力资源增长率做出限制。”我们完全认同这一判断,并坚信当下就是最恰当的时机。

因此,我们呼吁所有 AI 实验室,立即暂停对体量超过 GPT-4 的 AI 系统的训练,且暂停期至少 6 个月。这种暂停应当对外公开且可加验证,涵盖所有关键参与者。如果未能迅速实施暂停,政府应介入并强制要求其暂停。

各 AI 实验室和独立专家则应把握这次暂停,共同开发和实施一套用于高级 AI 设计和开发的共享安全协议,并由外部独立专家进行严格审计与监督。这些协议应确保依其构建的系统具备无可置疑的安全性。我们并不是要全面叫停 AI 开发,只是想从目前这场危险的竞赛中退后一步,避免最终衍生出体量更大、更加不可预测的黑盒模型。

AI 研究和开发工作应当集中注意力,努力让目前最强大、最先进的系统变得更准确、更安全、更可解释、更透明、更稳健、更一致,也更加忠诚且值得信赖。

与此同时,AI 开发商必须与立法机构合作,加快开发出强大的 AI 治理体制。其中至少应当包括:专门负责 AI 事务的新型监管机构;监督和跟踪高性能 AI 系统及大量算力的机构;出处与水印系统,帮助区分真实与合成信息,同时跟踪模型泄露;强大的审计和认证生态系统;对 AI 造成的伤害进行责任回溯;为 AI 安全研究提供强大的公共资金支持;指派资源充足的机构应对 AI 将会在经济和政治层面造成的巨大破坏。

人类应当享受到 AI 造就的繁荣未来。在成功创建起强大的 AI 系统之后,我们才能平稳度过“AI 之夏”,静候金秋带来的累累硕果。但这一切的前提,是暂时叫停一切可能对社会造成灾难性影响的技术,这也是我们的当务之急。为社会提供过渡期、确保系统设计造福每个人,我们才能信心满满地迎接“AI 之秋”。

原文链接:

https://futureoflife.org/open-letter/pause-giant-ai-experiments/