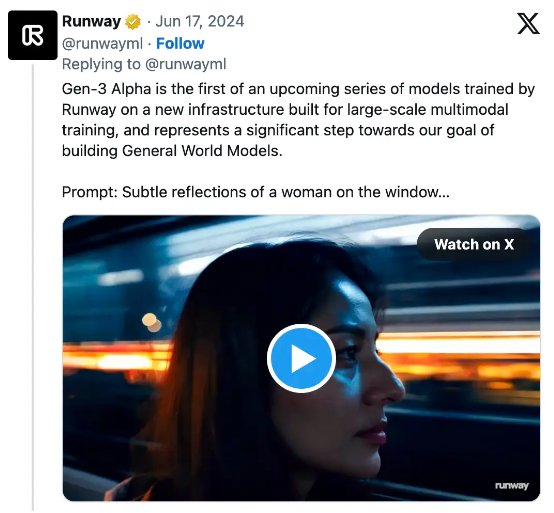

凭借广受欢迎的视频生成工具而声名大噪的 AI 厂商 Runway 最近发布了最新版本的 Runway Gen-3。Gen-3 Alpha 是 Runway 在专为大规模多模态训练所构建的全新基础设施之上,训练出的模型家族的首位成员。与 Gen-2 相比,Gen-3 在保真度、一致性和运动表现方面迎来重大改进,并朝着构建通用世界模型迈出了坚实一步。

新模型目前仍处于 alpha 内测阶段,尚未对外公布。但从一系列演示视频的效果来看,与目前已经开放的 Gen-2 相比,下代模型生成的视频似乎在连续性、真实性以及提示词遵循能力方面取得了重大飞跃。

细粒度的时间控制

Gen-3 Alpha 由描述精细、时间密集的描述词训练而成,可实现富有想象力的过渡效果并为场景元素生成精确的关键帧。

逼真的人类形象

Gen-3 Alpha 擅长生成具有各种动作、手势及情绪,且富有表现力的人类形象,开拓出前所未有的叙事方式与空间。

为艺术家而生,供艺术家使用

Gen-3 Alpha 的训练由研究科学家、工程师及艺术家共同组成的跨学科团队倾力完成,旨在诠释各种视觉风格及镜头语言。

Gen-3 模型生成的视频,特别是包含大画幅人脸特写的视频,拥有极为逼真的画面效果。这也不禁令 AI 艺术社区的成员们将其与 OpenAI 尚未发布,但同样备受期待的 Sora 进行了比较。

网友评价

一位 Reddit 用户在 Runway Gen-3 讨论主题下的高票评论中写道,“哪怕目前展示的都是精心挑选的优质之作,效果看起来也要比 Sora 好得多。Sora 的效果和观感仍有风格化痕迹,但这边的视频则更真实,也是我迄今为止见过的最好的 AI 生成视频。”

另一位用户则在拥有 6.6 万成员的 Reddit AI Video 子频道上写道,“如果不告诉我,我肯定会觉得这些画面是真实拍摄出来的。”

AI 电影制作人、自称 Runway 创意合作伙伴的用户 PZF 发布推文称,“这些 Runway Gen-3 片段在我看来吸引力十足——看起来很有电影的质感。画面流畅、平实(我是说非常自然)而且相当可信。”

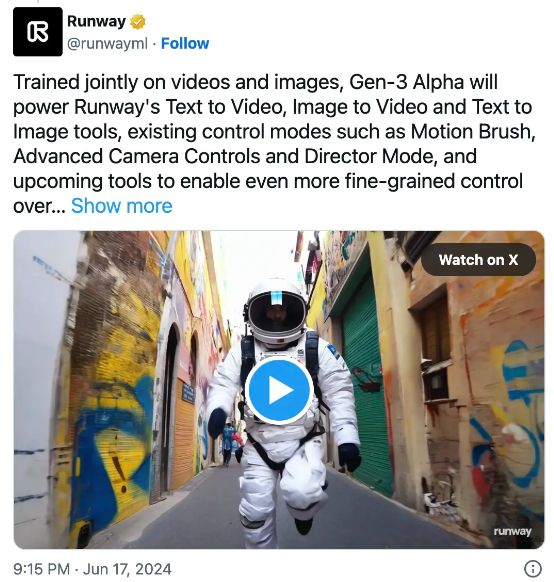

除了 Gen-3 视频生成器,Runway 还推出了一套微调工具,提供更灵活的图像与相机控制选项。该公司发布推文称,“Gen-3 Alpha 将为 Runway 的文本生视频、图像生视频以及文本生图像工具、现有控制模式(例如运动画笔、高级相机控制及导演模式)以及即将推出的工具提供支持,以前所未有的精细方式控制结构、风格与运动形态。”

Gen-3 Alpha 是 Runway 在专为大规模多模态训练所构建的全新基础设施之上训练出的模型家族的首位成员,代表我们朝着构建通用世界模型迈出了坚实一步。

Gen-3 Alpha 经过视频与图像的联合训练,旨在为 Runway 旗下各文本生视频、图像生视频及文本生图像工具、现有控制模式(如运动画笔、高级相机控制、导演模式)以及即将推出的更多工具提供支持,以前所未有的精细方式控制结构、风格与运动形态。

Runway 宣称,Gen-3 是其实现建立“通用世界模型”这一雄心勃勃目标的重要一步。这些模型使得 AI 系统能够构建环境的内部表现,并借此来模拟该环境中将要发生的未来事件。这种方法使得 Runway 有别于只关注特定时间轴内下一可能帧的传统预测技术。

虽然 Runway 方面尚未透露 Gen-3 的具体发布时间,但公司联合创始人兼 CTO Anastasis Germanidis 宣布 Gen-3 Alpha“将很快在 Runway 产品内现身”。他还透露,具体包括现有模态以及“一些目前只能借助更强大基础模型实现的新模态”。

Runway Gen-3 Alpha 将很快在 Runway 产品中现身,并将支持大家所熟悉的全部现有模态(文本生视频、图像生视频、视频生视频),以及一些目前只能借助更强大基础模型实现的新模态。

竞品对比

Runway 的 AI 探索之旅始于 2021 年,当时他们与慕尼黑大学的研究人员合作开发出 Stable Diffusion 的首个版本。Stability AI 后来以帮助该项目承担计算成本为由介入,并推动 AI 视频生成在全球范围内掀起热潮。

从那时起,Runway 就一直是 AI 视频生成领域的重要参与者,与 Pika Labs 等竞争对手并驾齐驱。然而,随着 OpenAI 宣布推出超越现有模型能力的 Sora,市场格局也随之发生变化。好莱坞著名演员阿什顿·库彻最近表示,像 Sora 这样的工具可能会彻底颠覆影视剧的创作逻辑,此言一出旋即引发轰动。

然而就在全球翘首期待 Sora 发布之际,新的竞争对手也陆续崭露头角,包括快手打造的 Kling 以及 Luma AI 的 Dream Machine。

Kling 是一款来自中国的视频生成器,能够以每秒 30 帧的速度生成最长 2 分钟的 1080p 分辨率视频,较现有模型实现了巨大改进。这套中文模型现已发布,但用户需要使用中国手机号进行注册。快手表示后续将为该模型推出全球版。

另一颗新星 Dream Machine 则是一套可供免费使用的平台,能够将书面文本转换为动态视频,且生成结果在质量、连续性及提示词遵循效果方面全面超越 Runway Gen-2。用户只需提交 Google 账户即可完成登录,但目前由于人气过高,内容生成速度往往很慢、甚至无法顺利完成视频生成。

在开源领域,Stable Video Diffusion 虽然在生成效果上不算出色,但其开放属性却为模型的后续改进和发展提供了坚实基础。Vidu 是由北京生数科技和清华大学开发的另一款 AI 视频生成器,采用名为 Universal Vision Transformer (U-ViT) 的专有视觉转换模型架构,只需一次单击即可生成 16 秒长的 1080p 分辨率视频。

至于前面提到的 Pika Labs,由于尚未发布重大更新,所以其目前的生成效果基本与 Runway Gen-2 持平。

参考链接: