11 月 14 日,李开复旗下 AI 企业零一万物开源大模型Yi-34B被指责完全使用 LLaMA 的架构 ,只对两个张量 (Tensor) 名称进行修改。

对此,零一万物表示:GPT 是一个业内公认的成熟架构,Llama 在 GPT 上做了总结。零一万物研发大模型的结构设计基于 GPT 成熟结构,借鉴了行业顶尖水平的公开成果,由于大模型技术发展还在非常初期,与行业主流保持一致的结构,更有利于整体的适配与未来的迭代。同时零一万物团队对模型和训练的理解做了大量工作,也在持续探索模型结构层面本质上的突破。

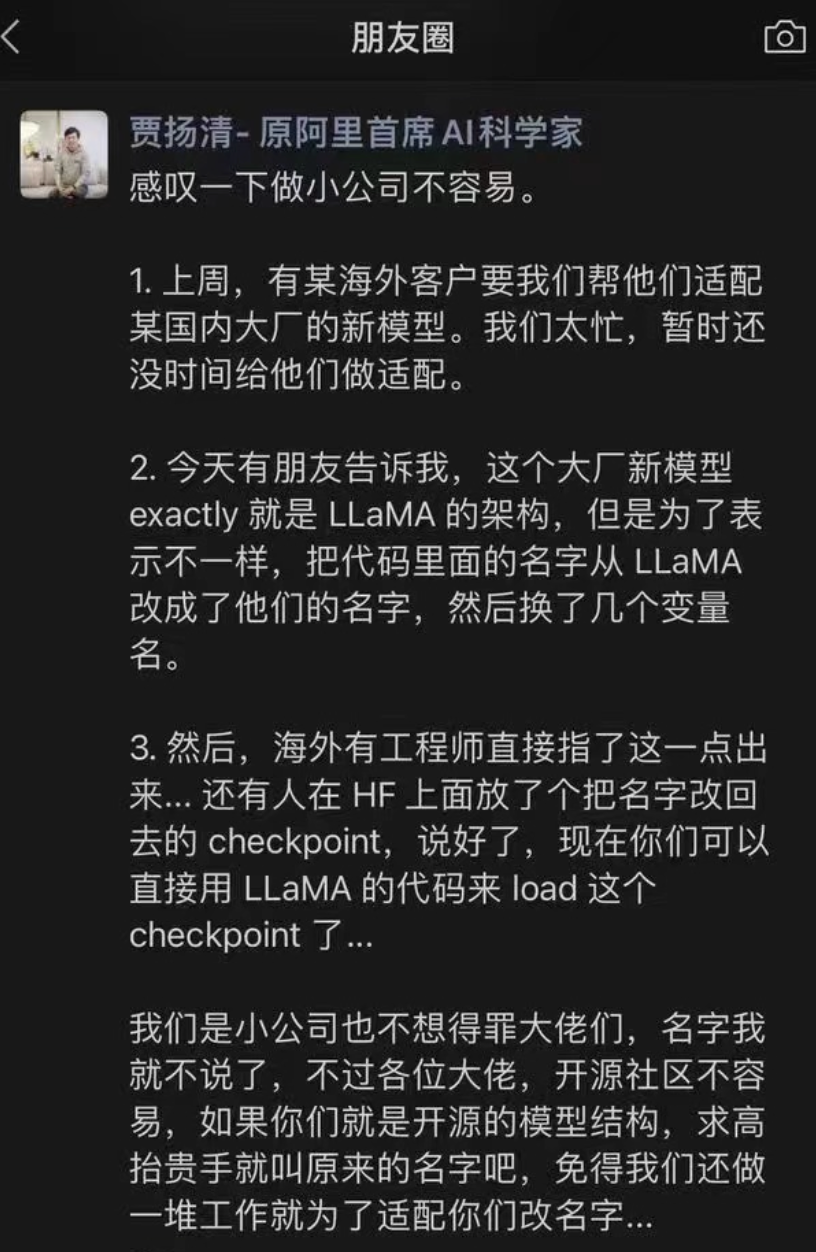

此事起源于贾扬清在朋友圈的一个吐槽,贾扬清提到,有个“大厂新模型 exactly 就是 LLaMA 的架构,但是为了表示不一样,把代码里面的名字从 LLaMA 改成了他们的名字,然后换了几个变量名。然后,海外有工程师直接指了这一点出来... 还有人在 HF 上面放了个把名字改回去的 checkpoint,说好了,现在你们可以直接用 LLaMA 的代码来 load 这个 checkpoint 了”。

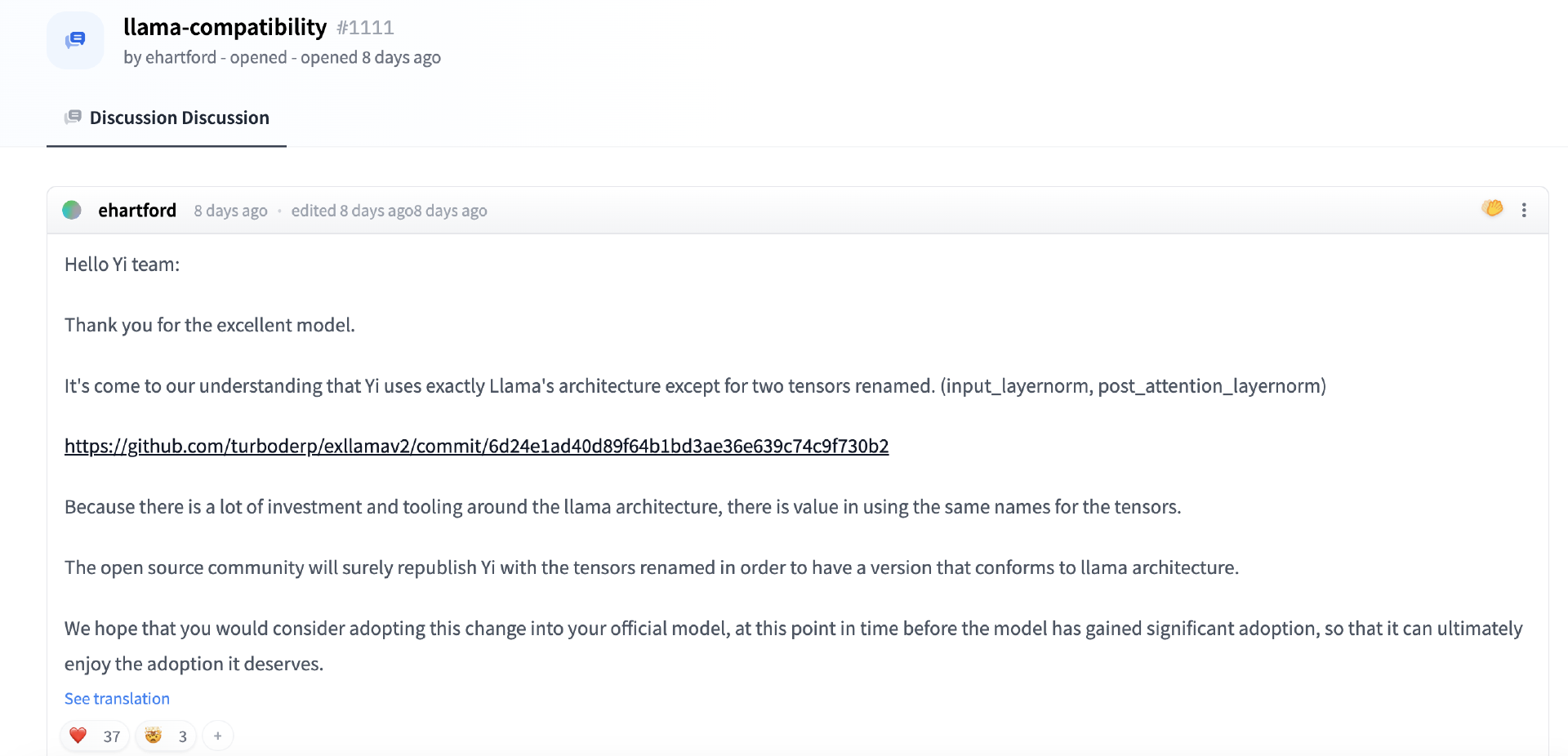

一时间,大家纷纷猜测这个基于 Llama 魔改的大模型到底是哪个。贾扬清随后专门留言表示不是自己的老东家阿里的。后来,有人扒到Hugging Face社区的Yi-34B项目下讨论区的留言,留言指出,“除了两个张量被重新命名外,Yi 完全使用了 Llama 的架构。”

有网友评论称,“如果他们使用了确切的 Meta LLaMA 结构、代码库和所有相关资源,则还需要遵守 LLaMA 规定的许可协议。要求以 LLaMA 形式正式发布 Yi 模型是有问题的,因为它破坏了 Yi 许可条款的可执行性。”

后续:

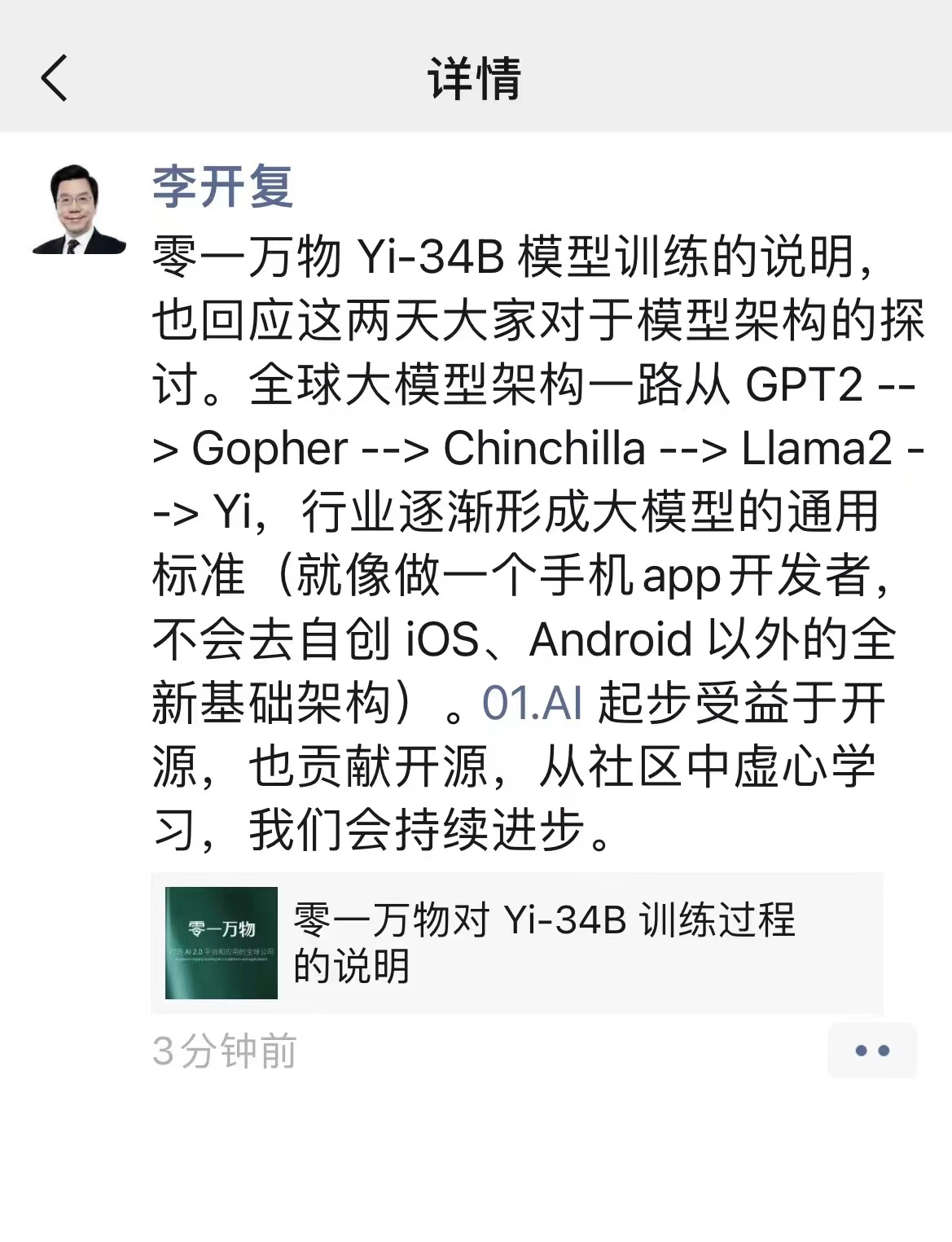

11 月 15 日,零一万物公众号发布了对 Yi-34B 训练过程的说明,李开复在朋友圈也转发了该说明,并表示,“01.AI 起步受益于开源,也贡献开源,从社区中虚心学习,我们会持续进步。”

说明原文如下:

就零一万物的观察和分析,大模型社区在技术架构方面现在是一个处于接近往通用化逐步收拢的阶段,基本上国际主流大模型都是基于 Transformer 的架构,做 attention,activation,normalization,positional embedding 等部分的改动,LLaMA、Chinchilla、Gopher 等模型的架构和 GPT 架构大同小异,全球开源社区基于主流架构的模型变化非常之多,生态呈现欣欣向荣,国内已发布的开源模型也绝大多数采用渐成行业标准的 GPT/LLaMA 的架构。然而,大模型持续发展与寻求突破口的核心点不仅在于架构,而是在于训练得到的参数。

模型训练过程好比做一道菜,架构只是决定了做菜的原材料和大致步骤,这在大多数人的认知中也逐步形成共识。要训练出好的模型,还需要更好的“原材料”(数据)和对每一个步骤细节的把控(训练方法和具体参数)。由于大模型技术发展还在非常初期,从技术观点来说,行业共识是与主流模型保持一致的模型结构,更有利于整体的适配与未来的迭代。

零一万物在训练模型过程中,沿用了 GPT/LLaMA 的基本架构,由于 LLaMA 社区的开源贡献,让零一万物可以快速起步。零一万物从零开始训练了 Yi-34B 和 Yi-6B 模型,并根据实际的训练框架重新实现了训练代码,用自建的数据管线构建了高质量配比的训练数据集(从 3PB 原始数据精选到 3T token 高质量数据)。除此以外,在 Infra 部分进行算法、硬件、软件联合端到端优化,实现训练效率倍级提升和极强的容错能力等原创性突破。这些科学训模的系统性工作,往往比起基本模型结构能起到巨大的作用跟价值。

零一万物团队在训练前的实验中,尝试了不同的数据配比科学地选取了最优的数据配比方案,投注大部分精力调整训练方法、数据配比、数据工程、细节参数、baby sitting(训练过程监测)技巧等。这一系列超越模型架构之外,研究与工程并进且具有前沿突破性的研发任务,才是真正属于模型训练内核最为关键、能够形成大模型技术护城河 know-how 积累。在模型训练同时,零一万物也针对模型结构中的若干关键节点进行了大量的实验和对比验证。举例来说,我们实验了 Group Query Attention(GQA)、Multi-Head Attention(MHA)、Vanilla Attention 并选择了 GQA,实验了 Pre-Norm 和 Post-Norm 在不同网络宽度和深度上的变化,并选择了 Pre-Norm,使用了 RoPE ABF 作为 positional embedding 等。也正是在这些实验与探索过程中,为了执行对比实验的需要,模型对部分推理参数进行了重新命名。

在零一万物初次开源过程中,我们发现用和开源社区普遍使用的 LLaMA 架构会对开发者更为友好,对于沿用 LLaMA 部分推理代码经实验更名后的疏忽,原始出发点是为了充分测试模型,并非刻意隐瞒来源。零一万物对此提出说明,并表达诚挚的歉意,我们正在各开源平台重新提交模型及代码并补充 LLaMA 协议副本的流程中,承诺尽速完成各开源社区的版本更新。

我们非常感谢社区的反馈,零一万物在开源社区刚刚起步,希望和大家携手共创社区繁荣,在近期发布 Chat Model 之后,我们将择期发布技术报告,Yi Open-source 会尽最大努力虚心学习,持续进步。

开源社区讨论参考:

https://huggingface.co/01-ai/Yi-34B/discussions/11#6553145873a5a6f938658491