智能时代,大模型正在重构 AI 基础设施,数据中心的算力、网络、存储、管理、能效如何应对大模型 Scaling law 带来的全向 Scale 的创新挑战?

在 2024 开放计算中国峰会现场,浪潮信息服务器产品线总经理赵帅在《开放计算:以技术创新之力,驱动智算发展》的主题演讲中,给出了他的答案。

他强调了开放计算在推动 AI 创新中的关键作用。开源开放是 AI 创新的核心动力,尤其是在开源大模型领域,开源模型的能力在短时间内得到了显著提升。如今,已有 2/3 的 AI 模型选择开源,这极大地推动了 AI 技术的发展和应用的普及。

赵帅也详细介绍了浪潮信息在开放多元算力标准、管理、基础设施标准等方面的贡献:开放加速模组和开放网络实现了算力的 Scale,开放固件解决方案实现了管理的 Scale,开放标准和开放生态实现了基础设施的 Scale,未来要以开放创新加速算力系统全向 Scale,应对大模型 Scaling Law。

全球化的开放协作,全向 Scale 创新推动 AI 发展

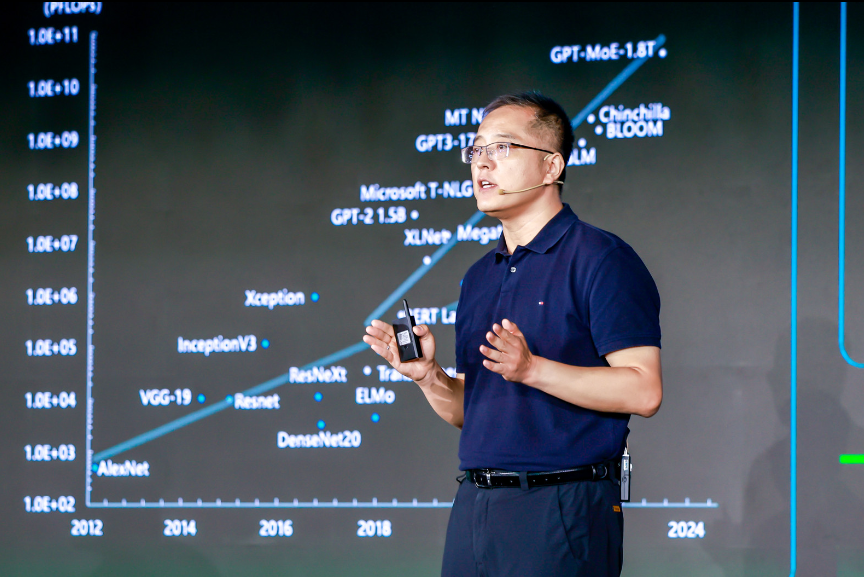

算力、算法和数据是推动人工智能发展的三驾马车,尤其在大模型领域,这三者的协同作用尤为显著。自 Transformer 架构出现以来,大模型性能与其参数量、计算当量、数据量密切相关,这种现象被称为 Scaling Law。

随着大模型在快速迭代升级,模型能力在持续进化,模型类型也在从传统的语言模型往多模态、长序列、混合专家模型等转变,由此引发的是对 GPU domain、互联、算力等的新需求,对基础设施、算力管理、迭代升级等都提出了新的挑战。

开放加速算力“Scale Up+Scale Out” 并存发展

为应对大模型 Scaling law 对算力扩展的巨大需求(Scale up 和 Scale out),全球化的开放合作变得至关重要。

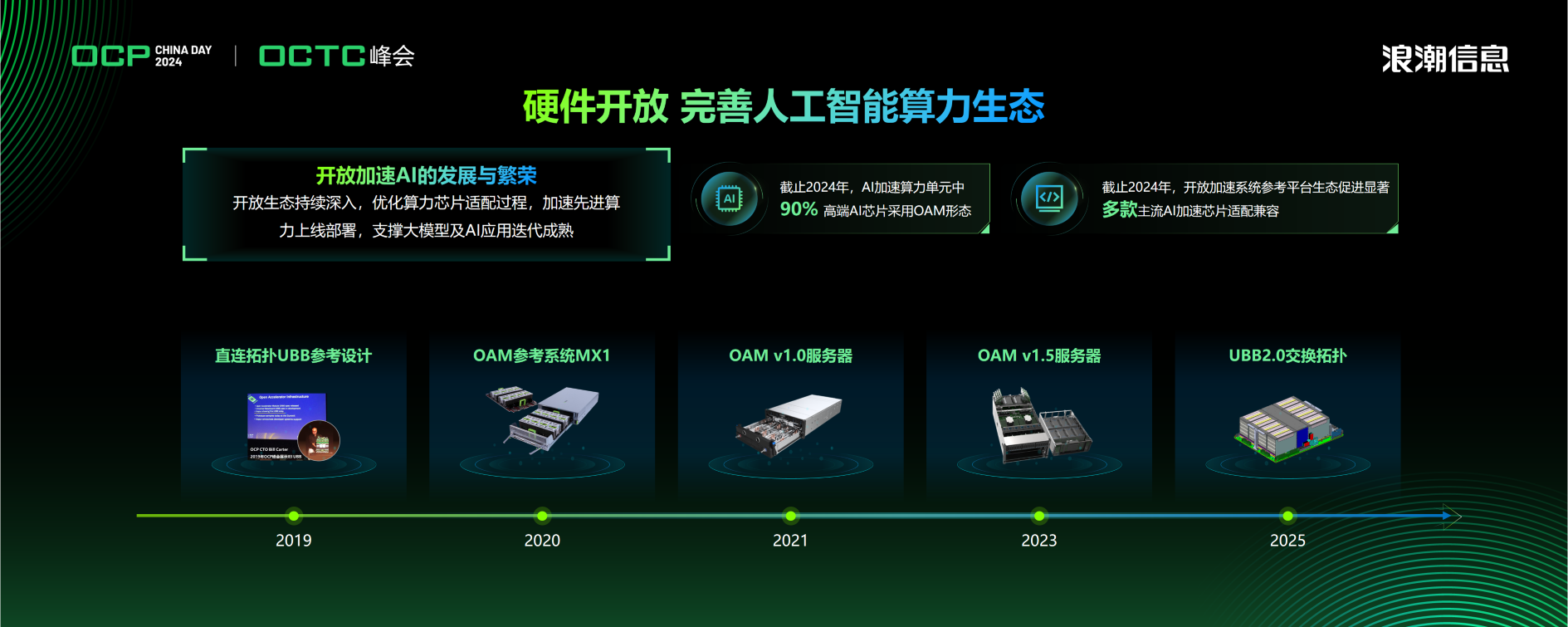

大模型的高效训练通常需要具备千卡以上高算力 AI 芯片构成的 AI 服务器系统支撑。而实现数千颗芯片互联,并让它们能够高效协同工作的前提,是解决单个服务器内部芯片的高速直联,提升 Scale up 的效率。为此,OCP 建立了 OAI(Open Accelerator Infrastructure)小组,对更适合超大规模深度学习训练的 AI 加速卡形态进行了定义,发布了开放加速规范 OAM。开放加速规范 OAM 的出现,解决了单个服务器内多元 AI 加速卡形态和接口不统一,高速互连效率低,研发周期长等问题,得到了众多企业的支持与参与,包括英伟达、英特尔、AMD、微软、阿里巴巴、谷歌、浪潮信息等 AI 芯片企业、互联网企业、系统厂商等,为 AI 算力的技术创新营造了开放、活跃的生态。

目前开放计算规范 OAM 已成为全球最多高端 AI 加速芯片遵循的统一设计标准,全球 20 多家芯片企业支持开放加速规范标准,为 AI 芯片企业节省研发时间 6 个月以上,为整体产业研发投入节省数十亿元,极大地降低了 AI 算力产业创新的难度,加速高质量 AI 算力普惠发展。OAM 规范还在持续迭代,未来基于 OAM2.0 规范的 AI 加速卡将支持 8k 张加速卡的卡间互联,突破大模型 Scale up 互联瓶颈。

同时,在人工智能时代,一切计算皆 AI,CPU 也要具有 AI 的能力。但目前 CPU 多元化发展,如何快速完成 CPU 到计算系统的创新,使其能够适用于 AI 推理负载,已经成为缓解当前 AI 算力稀缺、推动人工智能发展的关键环节。为此,会上开放算力模组规范(OCM)正式立项,首批成员包括中国电子技术标准化研究院、百度、浪潮信息、英特尔、AMD、小红书、联想、超聚变等,以 CPU、内存为核心构建最小算力单元,兼容 x86、ARM 等多架构芯片的多代处理器,方便用户根据应用场景灵活、快速组合。

在 Scale out 方面,大模型的发展需要更大规模的集群,浪潮信息开放网络交换机可以实现 16k 个计算节点 10 万+GPU scale out 组网,,满足 GPU 之间的互联通信需求,带宽利用率高达 95%+。

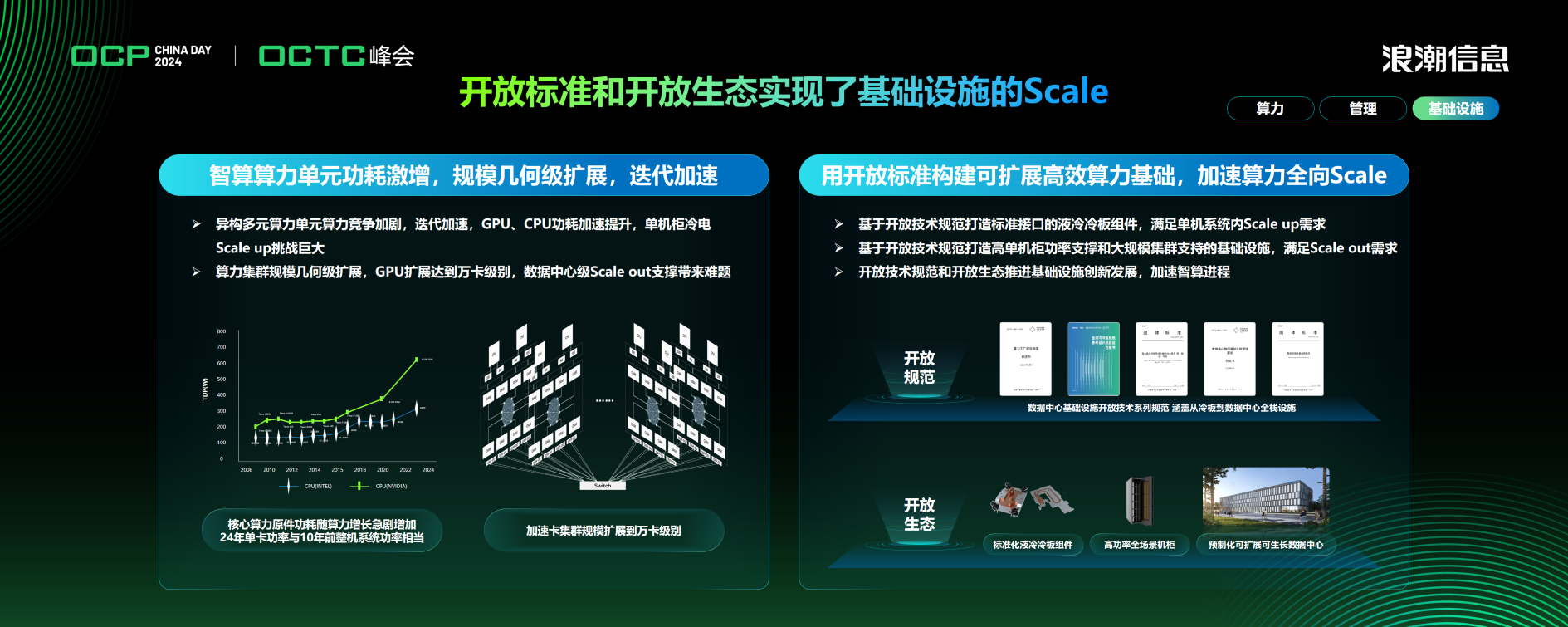

开放的液冷规范和生态,加速基础设施的 Scale

智算时代,数据中心面临算力扩展两个方向的巨大挑战:一是 GPU、CPU 算力提升,单芯片单卡功耗急剧增加,单机柜在供电和制冷上面临着 Scale up 的支撑挑战;同时,大模型 scaling law 驱动 GPU 集群无限膨胀,达到万卡、十万卡级别,在数据中心层级带来了 Scale out 的支撑挑战。

采用开放的标准、开放的生态,来构建数据中心基础设施,才能够匹配智算时代多元、异构算力的扩展和迭代速度,进而支撑上层智能应用的进一步普及。基于开放的标准,浪潮信息推出了标准接口的液冷冷板组件,支撑单机系统内 GPU 和 CPU 核心算力原件 scale up 扩展;推出模块化、标准接口的 120kw 机柜,兼容液冷、风冷场景,以支撑柜内更大的部署需求;并且基于开放标准的预制化集装箱数据中心,大幅压缩建设周期,可扩展可生长来满足 GPU 集群增长需要。

开放 BMC 管理规范,更快、更好地满足数据中心大规模设备管理需求

随着云计算、人工智能的快速发展,数据中心的大规模异构服务器设备面临多种处理器架构、多种 GPU、多种设备协议、不同管理芯片兼容的系统化设计挑战,如何实现多处理器、多 AI 加速芯片等部件在服务器内部系统高效稳定的运行,对服务器管理控制系统 BMC (Baseboard Management Controller)固件的兼容性、精细度、定制化和快速迭代能力提出了更高的要求。

开源开放的 OpenBMC,以创新的分层解耦软件架构,可以兼容越来越多的处理器、AI 加速卡和管理芯片,并提供更加精细化的智能运维和预警功能,为数据中心的异构算力基础设施提供了灵活、开放的运维管理解决方案,也将推动产业形成开放、标准的管理固件生态。

作为开源技术的拥护者与重要贡献者,浪潮信息积极拥抱 OpenBMC。早在 2017 年,浪潮信息与 IBM 合作贡献社区,并陆续完成多款主流服务器产品的 OpenBMC 适配。2023 年,浪潮信息在 OpenBMC 社区开源代码贡献排名中保持全球第 5 位和中国第 1 位,共计贡献代码 86000 余行,参与社区代码审核 1800 余次,广泛覆盖 Redfish、IPMI、PLDM、LED、USB、时间管理、电源管理、固件升级等模块,推动了社区的健康发展。基于 OpenBMC 方案,浪潮信息也构建起更加稳定可靠、更具扩展性且芯片级安全的开放架构通用服务器产品,通过分层解耦、模块化设计的 OpenBMC 方案 InBry,在 BMC 层面实现了软硬件的标准设计,支持服务器产品的快速、稳定迭代,从而更快、更好地满足用户资产信息管理、故障预警、远程管理和批量自动部署等需求。