人类善于分析事物。但是现在看来,机器很有可能做得更好。机器可以不知疲倦夜以继日地分析数据,不断从中找到很多人类场景用例的模式:信用卡欺诈预警、垃圾邮件检测,股票价格预测、以及个性化地推荐商品和视频等等。他们在这些任务上变得越来越聪明了。这被称为 “分析人工智能(Analytical AI)” 或”传统人工智能(Traditional AI)”。

但是人类不仅擅长分析事物,还善于创造。我们写诗、设计产品、制作游戏和编写代码。直到公元 2022 年之前,机器还没有机会在创造性工作中与人类竞争,它们只能从事分析和死记硬背的认知劳动。但是现在(是的,就是现在)机器已经开始在创造感性而美好事物的领域尝试超越人类,这个新类别被称为 “生成式人工智能(Generative AI)”。这意味着机器已经开始在创造生成全新的事物,而不是分析已经存在的旧事物。

生成式人工智能不仅会变得更快、更便宜,而且在某些情况下比人类手工创造的更好。每个需要人类创作原创作品的行业—从社交媒体到游戏、从广告到建筑、从编码到平面设计、从产品设计到法律、从营销到销售都有待全新重塑。某些功能可能会被生成式人工智能完全取代,或者激发出超越人类想象力的全新灵感。

亚马逊云科技开发者社区为开发者们提供全球的开发技术资源。这里有技术文档、开发案例、技术专栏、培训视频、活动与竞赛等。帮助中国开发者对接世界最前沿技术,观点,和项目,并将中国优秀开发者或技术推荐给全球云社区。如果你还没有关注/收藏,看到这里请一定不要匆匆划过,点这里让它成为你的技术宝库!

新世界正在到来。

Transformer 新世界

做为一名曾经多次穿越过市场周期的从业者,我亲历过通信行业、IT 行业、移动互联网行业等不同时代的周期,亲身体验过其间的潮起云涌,亲眼目睹过其中的天高云淡,以及最终惨烈竞争后的回归平淡。因此,面对已经开启的 AI 时代周期,与其盲目地跳进去跟随,不如先搞清楚这个新周期的一些底层逻辑,比如说:知识底座。

如果说 TCP/IP、HTML 等知识结构是上一个时代的知识底座,那么面对已经开始的 AI 时代,我们每个人是否应该先问自己一个问题:“什么是 AI 时代的知识底座?”

从到目前为止 AI 的知识发展看来,也许这个知识底座会是:Transformer。

1 Transformer 概述

欢迎进入 Transformer 的新世界。

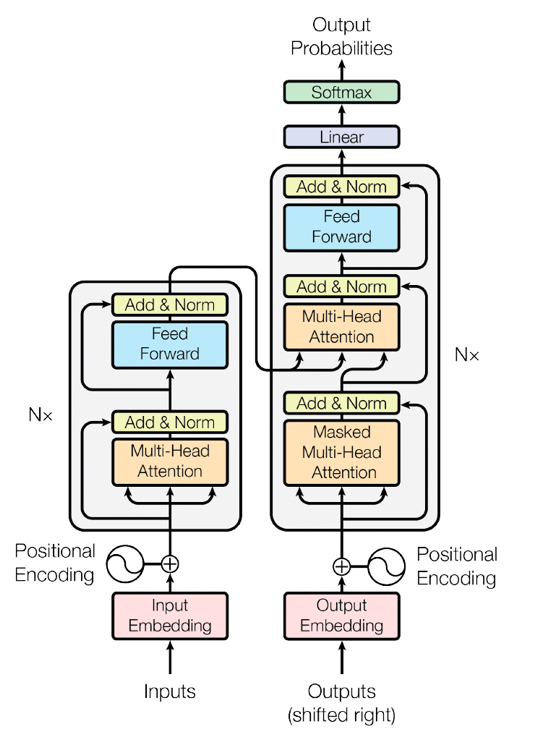

在过去的五年中,人工智能世界发生了很多令人欣喜的重大变化。其中许多变化是由一篇名为 “Attention is All You Need” 的论文推动的。这篇发表于 2017 年的论文介绍了一种名为 “Transformer” 的新架构。下图为“Attention is All You Need” 的论文中描述的 Transformer 模型的架构图示。

Source: https://arxiv.org/pdf/1706.03762.pdf?trk=cndc-detail

概括来说,Transformer 模型为机器学习领域做出了两项贡献。首先,它提高了在人工智能中使用并行计算的效率。其次,它引入了 “注意力(Attention)” 的概念,这使人工智能能够理解单词之间的关系。你所听到的技术,例如 GPT-3、BERT、Sable Diffusion 等,都是 Transformer 架构在不同领域演进的结果。

2 注意力机制(Attention)

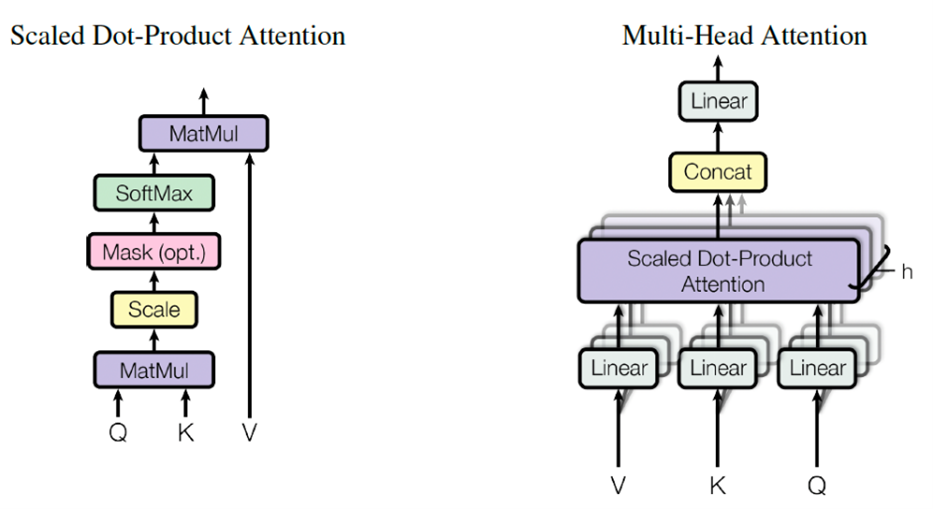

什么是注意力机制?根据该论文中的描述,注意力函数可以描述为将查询和一组键值对映射到输出,其中查询、键、值和输出都是向量。输出是按值的加权总和计算的,其中分配给每个值的权重由查询的兼容性函数与相应键值计算得出。Transformer 使用多头注意力(multi-headed attention),这是对称为缩放点积注意力(scaled dot-product attention)的特定注意力函数的并行计算。如下图所示。

Source: https://arxiv.org/pdf/1706.03762.pdf?trk=cndc-detail

上面这段对“注意力机制”的描述还是偏学术化。维基百科上的定义会更通俗易懂些:“注意力机制(英语:attention)是人工神经网络中一种模仿认知注意力的技术。这种机制可以增强神经网络输入数据中某些部分的权重,同时减弱其他部分的权重,以此将网络的关注点聚焦于数据中最重要的一小部分。数据中哪些部分比其他部分更重要取决于上下文。可以通过梯度下降法对注意力机制进行训练 ……”

可见,注意力机制的灵活性来自于它的“软权重”特性,即这种权重是可以在运行时改变的,而非像通常的权重一样必须在运行时保持固定。

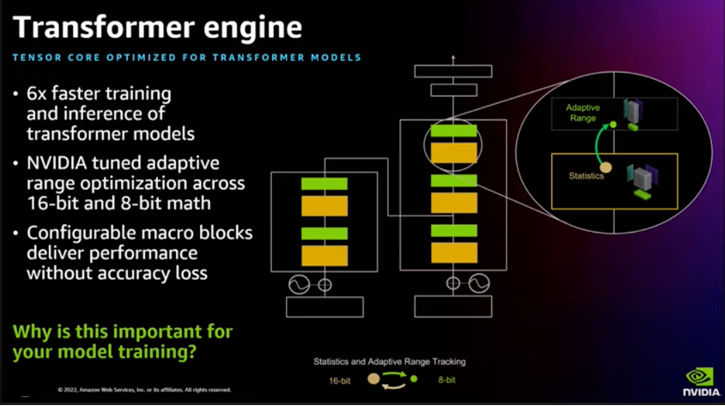

3 Transformer in Chip

很多人工智能领域的思想领袖和专家,认为 Transformer 架构在未来五年左右并不会有太大变化。这就是为什么你会看到一些芯片制造商在其新芯片(例如 NVIDIA H100)中集成 Transformer Engine 的原因。

在 2022 年拉斯维加斯的 re:Invent 2022 中,来自 NVIDIA 的架构师分享了如何在亚马逊云科技上,使用 NVIDIA 新一代芯片做深度学习训练的专题,里面特别提到了 H100 芯片中 Transformer Engine 的设计结构和初衷。对技术架构细节感兴趣的同学,可以通过以下视频深入了解:

https://www.youtube.com/watch?v=l8AFfaCkp0E?trk=cndc-detail

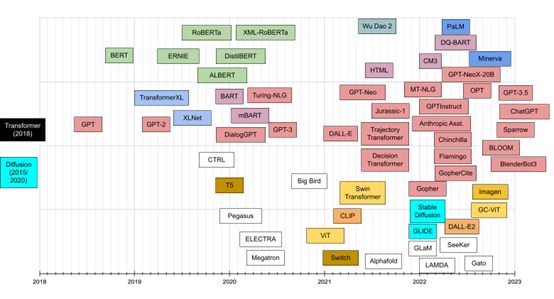

4 Transformer 演进时间线

一个有趣的视角是将各种 Transformer 按照出现的时间顺序排列的图示。

Source: “Transformer models: an introduction and catalog” https://arxiv.org/abs/2302.07730?trk=cndc-detail

我听到过的一个比较有趣的视角是:如果您之前对 Transformer 知道得不多,不要恐慌。因为您看到引领这一波生成式人工智能(Generative AI)变革的重要几篇论文的情况:

CLIP 论文在 2021 年发表;

Stable Diffusion 和 DALL-E-2 在 2022 年才出现;

GPT3.5、ChatGPT、Bloom 等在 2022 年底才出现……

这个新世界的演进才刚刚开始,你还有足够的时间重新开始学习 Transformer!

Generative AI

1 为什么现在发生?

Generative AI 与更广泛的人工智能具有相同的值得人类深入思考问题:“为什么现在发生?” 概括来说,这个答案是我们当下具有:

更好的模型;

更多的数据;

更多的计算;

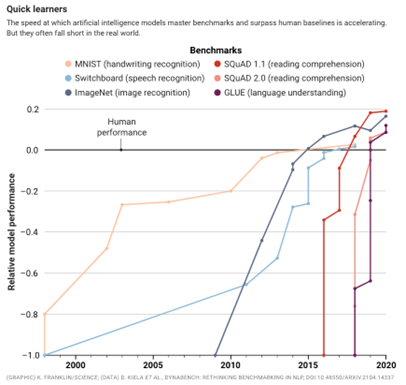

Generative AI 的进化速度比我们所能想象的要快得多,为了将当前时刻置于大时代洪流的背景之下,非常值得我们大致地了解下 AI 的发展历史和曾经走过的路。

第一波浪潮:小型模型占据了至高无上的地位(2015 年之前)

小型模型在理解语言方面被认为是 “最先进的”。这些小型模型擅长分析任务,可用于从交货时间预测到欺诈分类等工作。但是,对于一般用途的生成任务,它们的表现力还不够。生成人类级写作或代码仍然是白日梦。

第二波浪潮:规模竞赛(2015 年至今)

2017 年发表的里程碑意义的论文(“Attention is All You Need”)描述了一种用于自然语言理解的新神经网络架构,这种架构名为 Transformer,它可以生成高质量的语言模型,同时更具可并行性,并且需要更少的训练时间。这些模型是 few-shot learners 的,因此可以相对容易地针对特定领域进行定制。

随着模型越来越大,它们开始提供人类层面的结果,然后是超人的结果。在 2015 - 2020 年间,用于训练这些模型的计算增加了 6 个数量级,其结果超过了人类在手写、语音和图像识别、阅读理解和语言理解方面的性能基准。GPT-3 模型在这时脱颖而出,该模型的性能比 GPT-2 有了巨大的飞跃,内容涉及从代码生成到写作等多项任务。

尽管基础研究取得了种种进展,但这些模型并不被人广泛使用。原因是它们庞大且难以运行(需要 GPU 编排等),能够使用这些模型的门槛太高(不可用或仅限封闭 BETA),而且用作云服务的成本也很高。尽管存在这些局限性,但最早的 Generative AI 应用程序开始进入竞争阶段。

第三波浪潮:更好、更快、更便宜(2022 年以后)

由于像亚马逊云科技这样的云技术公司,一直在推动云计算的普及,计算变得更加便宜。而像 diffusion model 等新技术降低了训练和运行推理所需的成本,研究界因此可以继续开发更好的算法和更大的模型。开发者访问权限从封闭 BETA 扩展到开放 BETA,或者在某些情况下扩展到开源(open-source)。对于一直缺乏 LLM 访问权限的开发人员来说,现在闸门已开放,可供探索和应用程序开发。应用程序开始蓬勃发展。

第四波浪潮:杀手级应用程序的出现(现在)

随着基础平台层的逐渐巩固,模型不断变得更好/更快/更便宜,模型访问趋向于免费和开源,应用层的创造力爆炸的时机已经成熟。

正如十年前的移动互联网爆发的前夜,由于移动通过 GPS、摄像头和移动连接等新场景、新功能释放了新类型的应用程序一样,我们预计这些大型模型将激发新一轮的 Generative AI 应用。我们预计 Generative AI 也将出现杀手级应用程序。

Source:https://www.sequoiacap.com/article/generative-ai-a-creative-new-world/?trk=cndc-detail

2 Generative AI: 应用层蓝图构想

以下是 Generative AI 的应用格局图,描述了为每个类别提供支持的平台层以及将在上面构建的潜在应用程序类型。

Source:https://www.sequoiacap.com/article/generative-ai-a-creative-new-world/?trk=cndc-detail

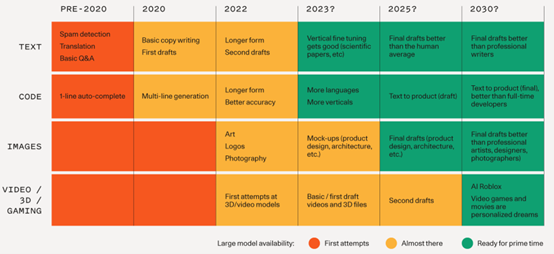

文本是进展最快的领域。

代码生成可能会在短期内对开发人员的生产力产生重大影响,如 Amazon CodeWhisperer 所示。

图像是一种较新的现象。我们看到了不同风格的图像模型的出现,以及用于编辑和修改生成的图像的不同技术。

语音合成已经存在了一段时间(例如,你好 Siri!)。就像图像一样,今天的模型也为进一步完善提供了起点。

视频和三维模型正在迅速上线。人们对这些模式开启电影、游戏、虚拟现实和实体产品设计等大型创意市场的潜力感到兴奋。

其他领域:从音频和音乐到生物学和化学,许多领域都在进行基础模型研发。

下图说明了我们如何期望基本模型取得进展以及相关应用成为可能的时间表。

Source:https://www.sequoiacap.com/article/generative-ai-a-creative-new-world/?trk=cndc-detail

3 Generative AI: 文字生成图像(Text-to-Image)方向

回顾过去的一年,有两个 AIGC 方向已经发生了让人惊艳的进步。其中一个方向就是:文字生成图像(Text-to-Image)方向。

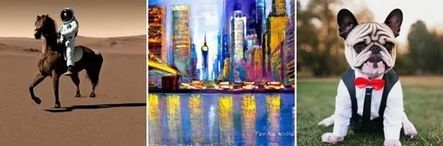

根据来自亚马逊云科技的官方博客,用户现在可以很方便的在 SageMaker JumpStart 中使用 Stable Diffusion 模型,轻松地生成富有想象力的绘画作品。

The following images are in response to the inputs “a photo of an astronaut riding a horse on mars,” “a painting of new york city in impressionist style,” and “dog in a suit.”

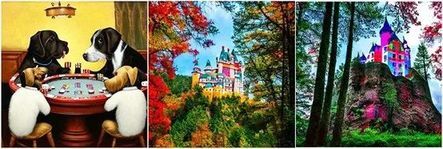

The following images are in response to the inputs: (i) dogs playing poker, (ii) A colorful photo of a castle in the middle of a forest with trees, and (iii) A colorful photo of a castle in the middle of a forest with trees. Negative prompt: Yellow color.

关于文字生成图像(Text-to-Image)方向的论文解读、示例代码等我们还会有其他专题深入讨论。

以上就是关于 Transformer 和 Generative AI 的部分介绍。在下一篇文章中,我们将详细讨论关于 Generative AI 另一个重要的进步方向就是:文字生成(Text Generation)方向。分享这个领域的最新进展,以及亚马逊云科技在为支持这些大型语言模型(LLMs)的编译优化、分布式训练等方面的进展和贡献。

作者黄浩文

亚马逊云科技资深开发者布道师,专注于 AI/ML、Data Science 等。拥有 20 多年电信、移动互联网以及云计算等行业架构设计、技术及创业管理等丰富经验,曾就职于 Microsoft、Sun Microsystems、中国电信等企业,专注为游戏、电商、媒体和广告等企业客户提供 AI/ML、数据分析和企业数字化转型等解决方案咨询服务。