论文名称: Adversarial Learning for Chinese NER from Crowd Annotations(基于对抗学习的众包标注用于中文命名实体识别)

团队名称:业务平台事业部

主要作者:杨耀晟,张梅山,陈文亮,王昊奋,张伟,张民

1. 文章目的与思想:

为了能用较低的成本获取新的标注数据,我们采用众包标注的方法来完成这个任务。众包标注的数据是没有经过专家标注员审核的,所以它会包含一定的噪声。在这篇文章中,我们提出一种在中文 NER 任务上,利用众包标注结果来训练模型的方法。受到对抗学习的启发,我们在模型中使用了两个双向 LSTM 模块,来分别学习众包标注数据中的公有信息和属于不同标注员的私有信息。对抗学习的思想体现在公有块的学习过程中,以不同标注员作为分类目标进行对抗学习,从而优化公有模块的学习质量,使之收敛于真实数据(专家标注数据)。我们认为这两个模块学习到的信息对于任务学习都有积极作用,并在最终使用 CRF 层完成 ner 标注。

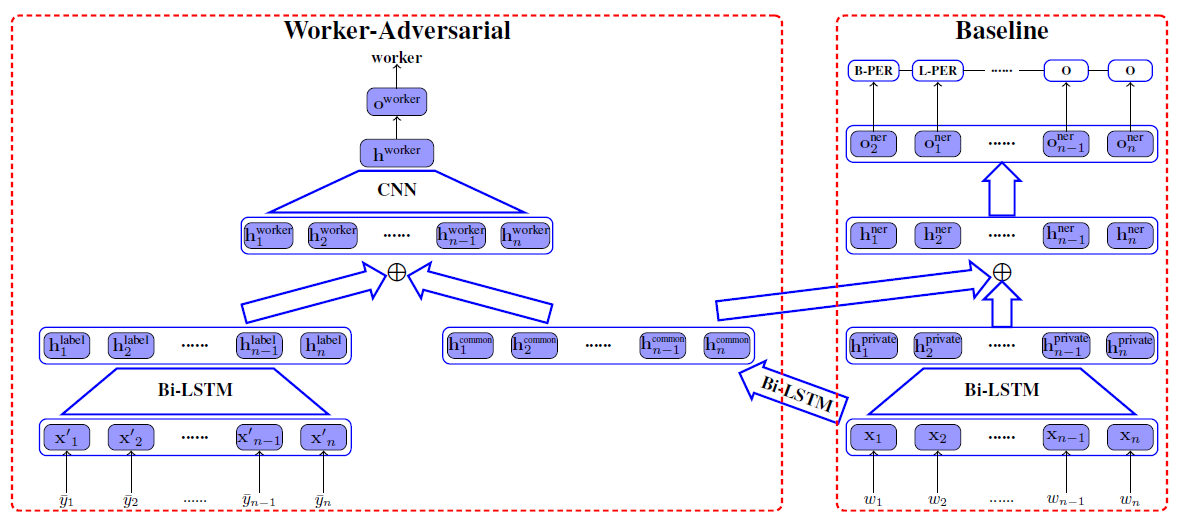

模型如下:

2. 数据使用:

我们在对话数据和电商数据上对模型的性能进行验证。

1)对话数据是由 gowild 公司提供的,我们让 43 位标注员在两万句语料上标注“人名”和“歌名”实体。我们认为这份数据非常适合我们的任务。

(1)若让一位专家标注员标注对话数据,由于他的认知是有限的,所以当他出现标注失误时对模型的影响是比较大的。在这种情况下,多位标注员可以在一定程度上弥补单个标注员对于“歌名”和“人名”的认知不足。例如:歌手“周传雄”,但并不是所有人都知道他的另一个称呼“小刚”。多人的知识面肯定要比一个人来的广。

(2)人机对话语料中包含一定比例的语法错误:

- 你怎么子我都看的手机死机了,在弄自己开门进来干嘛都记得。

- 你说谢谢的诗意哥哥吗?

不同的标注员对于上述句子的语义理解可能是不同的,我们也希望模型能学习到这些特征,使模型能更好收敛到最真实的数据分布,提高模型的泛化能力。

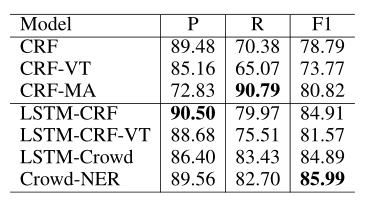

最终,我们的模型在对话数据上取得了近一个点的 F1 提升。

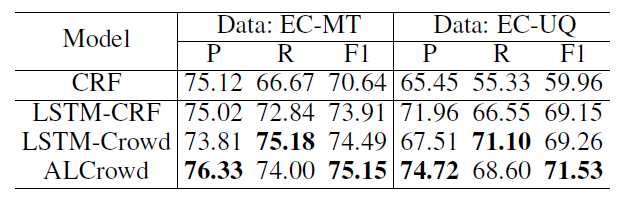

2)电商数据是由阿里巴巴提供。首先我们让五位标注员对标题数据和用户请求数据进行标注,目标是标注出已定义好的五类实体:品牌、产品、型号、规格、原料,每句标注任务随机分配给两位标注员。对于标注员的标注结果,我们通过样本抽样,分析得到造成标注噪声(标注不一致)的主要原因是不同标注员对于标注规范和每一句标注样例的认识是不同的。特别是在标题数据集中,产品、型号实体的边界定义非常容易造成标注不一致。

在上述众包标注得到的数据集上训练我们论文中提出的模型,可以得到一个点左右的提升:

文章分块解析:

相关工作:

(1)序列标注:早期用来处理序列标注问题的模型都十分依赖人工设计的特征模板,例如:HMM, MEMM 和CRF 模型,模型的性能很大程度上受限于特征模板的质量。神经网络热潮来临后,一个成熟的新模型被广泛应用:它使用双向LSTM 来提取序列特征,并用CRF 解码,在序列任务上取得了显著成果,这也是我们文章中的baseline 模型。

(2)对抗训练:对抗网络最早被成功的应用在计算机视觉领域。近几年,“对抗”这一概念也被引入到NLP 任务中,分别在跨语言、跨领域和多任务学习中取得突破。在这些任务中使用“对抗学习”,目的就在于学习到训练语料中的“共有特征”。我们的工作也是以这一目的为出发点,希望通过对抗学习的方式,让模型能分辨出“众包”数据中的“标注噪声”。

(3)众包标注模式:为了能在短时间内以较低成本获取标准语料,我们采用众包标注的模式,具体得到的数据情况见上面的“数据使用”。

Baseline

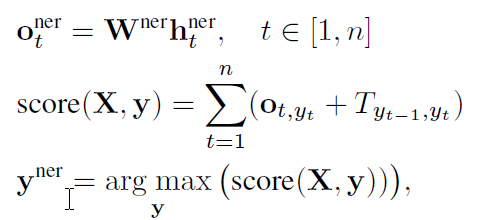

在文章的所有实验中,我们使用 BIOE 的标签集合。首先,我们训练 CRF 作为传统 baseline 模型。随后,尝试将序列特征映射到更高维度,也就是用 LSTM 模块提取特征。在中文任务中,输入单位为 char(字符),每个字符经过 lookup-table 映射成向量后,经过双向的 LSTM 层提取特征:

最终用CRF 层进行解码,使模型能更好得学习标签之间的依赖关系:

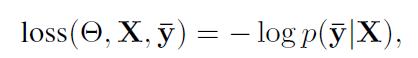

这一部分的loss 为:

优化目标为最小化这个loss 值。

对抗学习部分:Worker Adversarial

我们使用的是众包数据作为训练语料,数据集中存在一定量的标注错误,即“噪声”。这些标注不当或标注错误都是由标注员带来的。不同标注员对于规范的理解和认识面是不同的,我们可以认为一位标注质量高的标注员的标注结果和专家标注员是非常相近的。对抗学习模块如下:

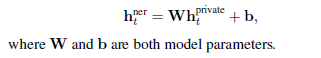

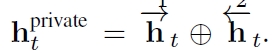

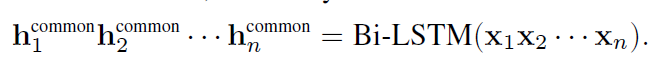

1) baseline 中的 BiLSTM 称为“private”,它的学习目标是拟合多为标注员的独立分布;再加入一个名为“common”的 BiLSTM 模块,common 与 private 的输入相同,它的作用是学习标注结果之间的共有特征:

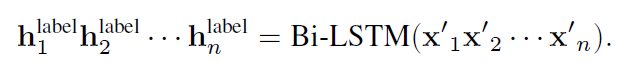

2) 再引入一个新的 BiLSTM 模块,名为“label”,以当前训练样例的标注结果序列为输入。

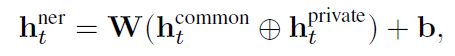

3)分别将 common 和 private 模块的输出合并,作为 ne 部分的输入:

最后用CRF 解码,公式与baseline 相同,不再贴出。

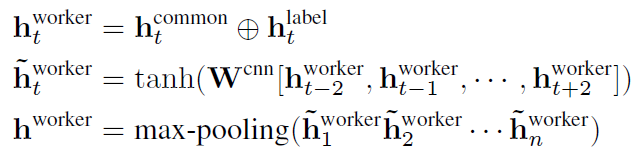

4)label 和 common 的输出合并,再输入 CNN 进行特征提取,最终对标注员进行分类:

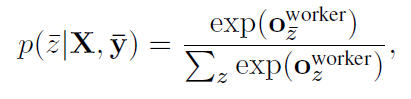

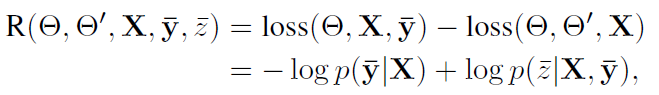

要注意的是,我们希望标注员分类器最终失去判断能力,所以它在优化时要反向更新:

如果您也有论文被 AAAI录用或者对论文编译整理工作感兴趣,欢迎关注AI前线(ai-front),在后台留下联系方式,我们将与您联系,并进行更多交流!