本文最初发布于 THENEWSTACK 博客。

自 2022 年 11 月推出ChatGPT以来,OpenAI一直受到知识工作者、开发人员以及几乎所有互联网和 Web 用户的广泛关注。但是,OpenAI已经成立很长时间了,甚至在 ChatGPT 创建之前就已经存在了,而且为开发人员提供了许多令人兴奋的服务。它是首批通过简单 REST API 端点开放生成式 AI 的平台公司之一。

这是 OpenAI 系列文章的第一篇,我们将探讨 OpenAI 的总体情况及其平台架构。通过这篇文章,我们将了解 OpenAI 平台的基本原理和基本构建模块。

OpenAI:生成式 AI 民主化

OpenAI 成立于 2015 年,是由 Ilya Sutskever、Greg Brockman、Trevor Blackwell、Vicki Cheung、Andrej Karpathy、Durk Kingma、John Schulman、Pamela Vagata 和 Wojciech Zaremba 等人创立的一家非营利性研究机构。Sam Altman 和 Elon Musk 是初始董事会成员。

微软在 2019 年宣布投资 10 亿美元,并在今年早些时候宣布了新一轮 100 亿美元的投资,OpenAI 成了人们关注的焦点。企业投资者包括 Infosys 和 Khosla,个人投资者则包括 Reid Hoffman、Peter Thiel 和 Jessica Livingston。

虽然人们经常批评 OpenAI从一家非营利性人工智能公司转变为一家商业人工智能公司,但它一直处于生成式人工智能研究的前沿。得益于和微软的合作伙伴关系,它获得了由 Azure 计算服务提供支持的最先进的基础设施。

关于 OpenAI 的历史和发展情况,这里就不过多介绍了。现在我们看下该公司的现状。

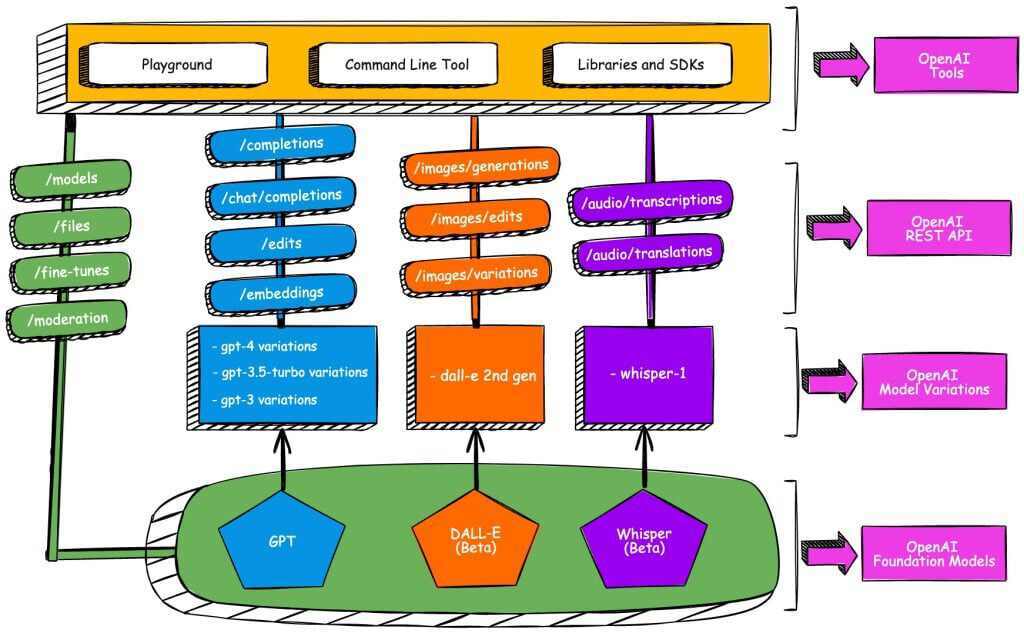

生成式人工智能模型使用大型数据集基于无监督学习(称为基础模型)进行训练。在比较高的层面上,OpenAI 包括三个关键的基础模型:GPT、DALL-E 和 Whisper。GPT 是训练用来处理文本内容的最流行的模型之一。DALL-E 可以基于自然语言输入生成图像。最后,Whisper 是一个将语音转换为文本并将一种语言翻译成另一种语言的模型。

OpenAI 支持的所有用例和生成式 AI 场景都是围绕着这三个基础模型。其中,由于 ChatGPT 的成功,GPT 获得的关注最多。ChatGPT 是基于 GPT 模型的最新版本 GPT-4 的。GPT 模型有多种变体,可以分别支持单词补全、交互式聊天、校订、改写、摘要和文本分类等场景。类似地,DALL-E 可用于创建、编辑图像及生成图像变体。Whisper 模型可用于音频文件的转录和翻译。

为了方便开发人员嵌入生成式人工智能,OpenAI 已经公开了多个与应用场景对应的 API。为了集成 GPT 或 DALL-E 等模型,开发人员必须获得 API 密钥并使用它来访问 Open AI REST 端点。

OpenAI API 使人们可以通过简单的 REST 接口访问最先进的语言和视觉模型,从而使生成式 AI 民主化。任何了解如何使用 API 的开发人员都可以将生成式 AI 的强大功能嵌入到其应用程序中。他们既不需要理解神经网络背后的复杂数学运算,也不需要访问基于高端 CPU 和 GPU 的强大的计算基础设施。

OpenAI 的基础模型可以通过自定义的私有数据集进行调优。然后,可以使用调优后的模型在私有数据上进行推理,大幅提高生成式人工智能的价值。OpenAI 已经将调优功能作为一个 API 公开,它可以接受基础模型的变种和自定义数据集。

下图概括了 OpenAI 平台的架构。最底层由基础模型组成,上面一层是各种模型变体,每一个都针对特定的用例做了优化。最上层是 REST API,它通过广为人知的端点公开模型。

探索 OpenAI 生态系统

OpenAI 构建了面向开发人员和最终用户的工具、SDK 和服务。ChatGPT 就是一个面向最终用户的服务的示例。OpenAI 主要利用 ChatGPT 从用户那里获得交互式反馈,这对改进 GPT 模型有很大的帮助。它还利用输入和提示来分析用户与模型的交互方式。

OpenAI 为开发人员提供了一个操练场,可以作为 REST API 的交互界面,用于测试调优后的模型如何响应相同的输入或提示。开发人员还可以用它来调整影响模型准确性和创造性的参数。

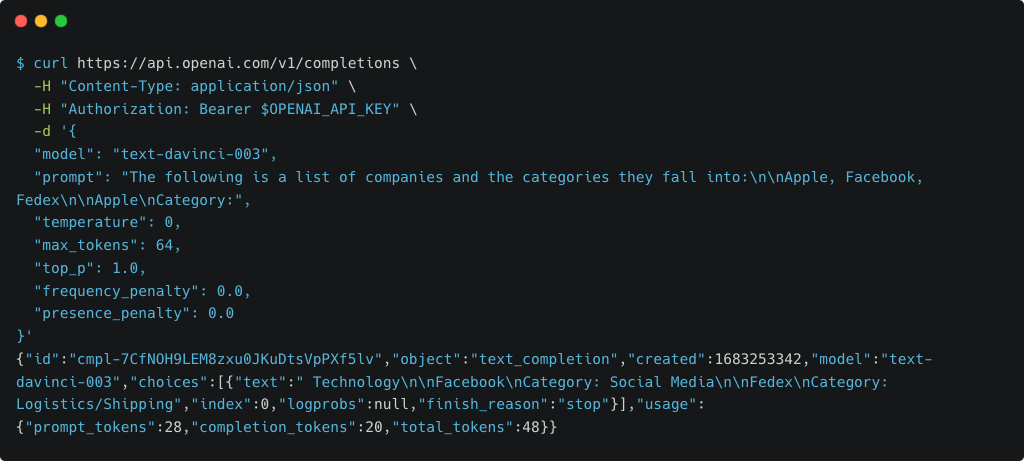

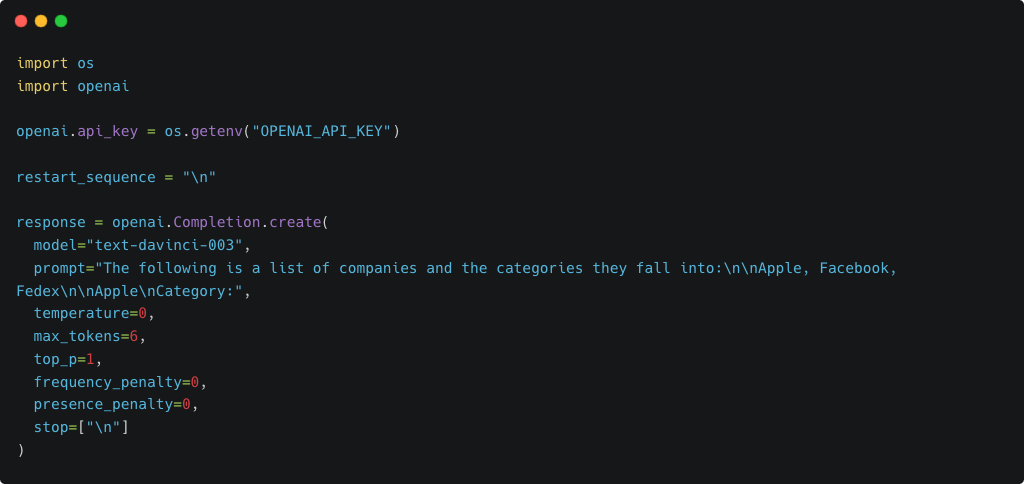

虽然使用 cURL 这样的工具调用 REST API 很简单,但 OpenAI 官方提供了一个Python库,可以简化 Jupyter Notebook 等环境中的 API 消费。对于那些喜欢使用 JavaScript 的人,官方还提供了一个 Node.js 库工具。OSS 社区已经针对 C#、C++、Go、Kotlin 和 Swift 等语言构建了各种库。

下图展示了通过 cURL 调用/vi/completions API:

同样,也可以通过 OpenAI 官方维护的 Python 库完成:

OpenAI 还发布了将消息转换为词元的工具和库——那是 GPT 等大型语言模型的基本输入单元。这些工具可以帮助开发人员评估使用 OpenAI API 所涉及的成本。当你通过 PIP 安装 Python 库时,还可以获得一个方便的 API 测试 CLI。

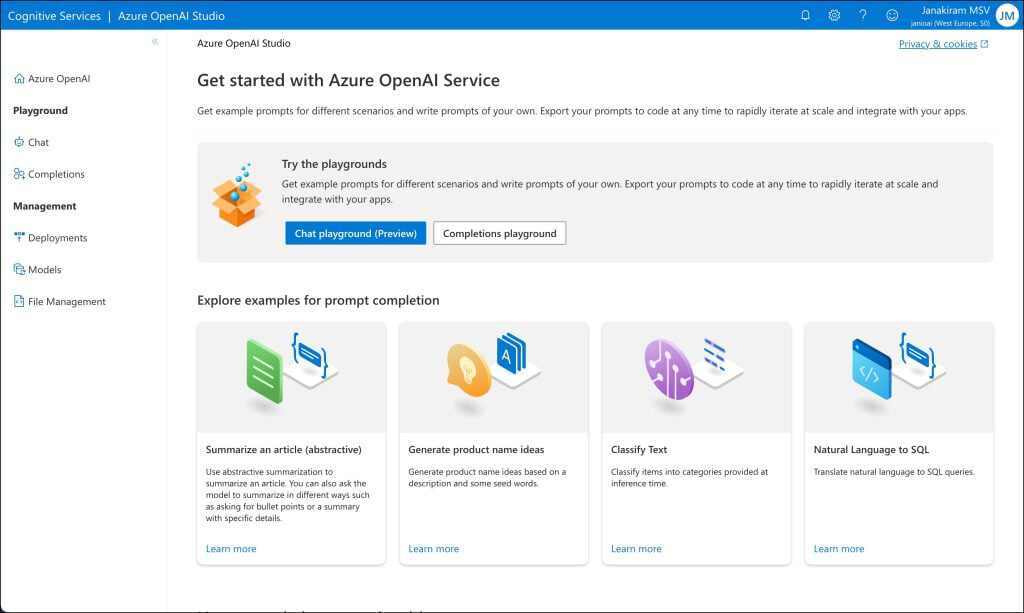

如果你是微软 Azure 开发人员,则可以注册 Azure OpenAI 服务,它与微软的云服务实现了紧密的集成,如活动目录、虚拟网络、基于角色的访问控制等。

在本系列的下一篇文章中,我们将深入探讨提示工程以及它在处理 GPT 方面的重要性。敬请关注!

原文链接:https://thenewstack.io/beyond-chatgpt-exploring-the-openai-platform/

延伸阅读:

OpenAI:我们将 Kubernetes 扩展到了 7500 个节点