GPU 是一种关键的硬件,可帮助运行训练和部署人工智能算法所涉及的无数计算。

行业分析师表示,持续的 GPU 紧缩已经影响了大大小小的企业,包括人工智能行业的一些领先平台,并且至少在一年或更长时间内可能不会出现有意义的改善。

AI 圈里,苦 H100 GPU 久矣

OpenAI 联合创始人兼职科学家 Andrej Karpathy 近日发文称“目前硅谷最热门的八卦,就是谁谁又买了多少块 H100 GPU。”

特斯拉掌门人马斯克曾经向整个科技行业发出警告,称巨大的 GPU 危机即将来临。今年 4 月,马斯克曾发表推文说,“如今不管是人是狗,都在疯狂购买 GPU。”而巨大的需求,势必引发严重的供应短缺。时间快进到当下,每个人都想搞自己的 AI 产品和业务。面对这样一场声势浩大的 AI 洪流,即使是像英伟达这样的全球巨头也难以及时制造出充足的 GPU 货源。

市场对高性能 GPU(特别是英伟达 H100)的需求仍在猛增。截至 2023 年 8 月,科技行业正经受英伟达 H100 短缺的严重折磨。GPU 供应不足,正在对严重依赖其进行模型训练和推理任务的 AI 厂商造成重大影响。

微软最近的年度报告显示了人工智能芯片可能长期短缺的最新迹象。该报告首次将 GPU 的可用性确定为投资者可能会遇到的的风险因素。

微软写道:“我们将继续寻找和评估扩大数据中心位置和增加服务器容量的机会,以满足客户不断变化的需求,特别是考虑到对人工智能服务不断增长的需求。” “我们的数据中心取决于许可的可建设土地、可预测的能源、网络供应和服务器,包括 GPU 和其他组件。”

微软对 GPU 的认可凸显了计算能力的获取如何成为制约 AI 发展的关键因素。该问题直接影响正在构建人工智能工具和产品的公司,并间接影响希望将该技术应用于自己目的的企业和最终用户。

来自 OpenAI 公司的 Andrej Karpathy 表示,“目前硅谷最热门的八卦,就是谁谁又买了多少块 H100 GPU。”有趣的是,AWS Lambda CEO Stephen Balaban 也提到,“Lambda 将于今年年底之前上线数千块 H100——如果您需要 64 块或者更多的 H100,请提前私信预约。”没错,这宝贝现在就是这么紧俏。

包括 Quora 公司 CEO Adam D’Angelo 和 OpenAI 创始人 Sam Altman 在内的多位 AI 领导者,也都表达了自己对于 GPU 短缺问题的担忧。OpenAI 透露,GPU 供应不足阻碍了他们的短期计划,包括模型微调和划拨专用容量。也许这正是 OpenAI 目前拘囿于 GPT-4,无法进一步履行其大语言模型开发承诺的原因之一。

谁,需要多少?

不只是 AI 公司,其他几类组织也对 H100 GPU 有着迫切需求。其中既包括研究大语言模型的初创企业,也有 Azure、GCP 和 AWS 等云服务供应商(CSP),CoreWeave、Lambda 等大型私有云,以及马斯克的特斯拉等其他知名公司。说到马斯克,他自己已经抢先一步购买了数千块英伟达 GPU,给自己的 xAI 储备“战略物资”。面对这块人人抢夺的现状,马斯克甚至曾劝 Altman 买下 ai.com 域名来换取 GPU 资源。

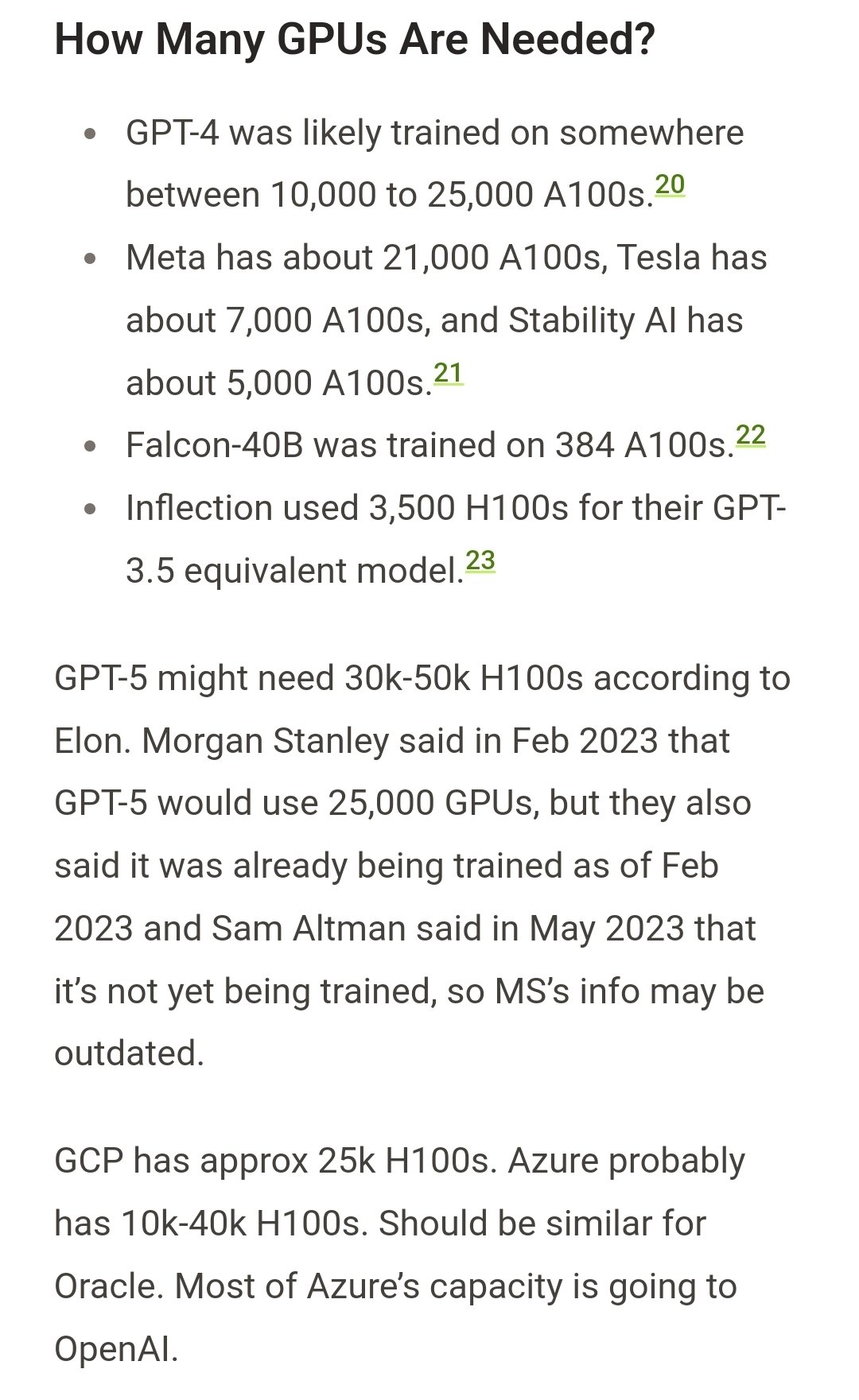

据报道,GPT-4 的训练过程可能用到了约 1 万到 2.5 万块英伟达 A100。至于 GPT-5,马斯克估计可能需要 3 万到 5 万块 H100。2023 年 2 月,摩根士丹利预测 GPT-5 大概需要使用 2.5 万个 GPU。面对如此庞大的 GPU 需求,加之英伟达又是市场上唯一可靠的供应商,似乎整个 AI 世界的运转都着落在了这家显卡巨头身上。

根据最近一篇博文,OpenAI 预计需要约 5 万块 H100 GPU,Inflection AI 的采购计划则大致在 2.2 万块左右。Meta 的需求尚不明确,但有传言称他们可能需要约 2.5 万个 GPU,且实际上限甚至可能超过 10 万块。

目前硅谷最热门的八卦,就是谁谁又买了多少块 H100 GPU。近日,在 Twitter 上广为流传的一张“我们需要多少张 GPU”的图片引发了网友们热议。

包括 Azure、Google Cloud、AWS 和甲骨文在内,各大主要云服务供应商可能各自需要约 3 万个 GPU。AWS Lambda 和 CoreWeave 等私有云预计共需 10 万个 GPU。其他专注于 AI 业务的厂商,例如 Anthropic、Helsing、Mistral 和 Character 等,可能分别需要约 1 万个 GPU。

根据马斯克的说法,GPT-5 可能需要 3 万-5 万张 H100。

值得注意的是,这些数字只是近似估值,云服务商及其最终客户间可能存在一些需求重合。综合来看,H100 GPU 的市场总需求可能在 43.2 万块左右,按每个 GPU 价格 3.5 万美元计算,意味着产品总价值高达 150 亿美元——没错,全部要被英伟达赚走。

此外,值得一提的是,上述估算还不包括字节跳动(TikTok)、百度和腾讯等中国公司。这些公司可能对 H800 这款专为中国市场设计的 GPU 同样有着大量需求。

尽管前景充满不确定性,但业界仍希望随着供应增加和 GPU 技术的进步,最终逐步缓解短缺问题。例如,英伟达一直在谈论发布 A800——号称能在 AI 模型构建方面提供同样的算力,只是目前还没有可靠的实证。而在需求缺口得到填补之前,AI 公司只能探索其他替代性 GPU 选项,并借助合作伙伴关系来应对这段充满挑战的时期。毕竟 AI 热度如此之高,该做的工作也还是得做。

GPU 稀缺性已成新的护城河

令事态雪上加霜的是,业界专家担心当前 GPU 稀缺性可能引发自我强化的循环。换言之,这种稀缺性本身成为新的护城河,增强各方囤积 GPU 资源的心理、进一步加剧资源不足。也许这就是马斯克当初囤积 GPU 的原因所在。下一代 H100 继任者预计要到 2024 年底才会推出,这漫长的一年半将反复折磨用户们脆弱的神经。

2010 年,我们使用黄仁勋的英伟达 GPU,证明无需任何无监督预训练,即可通过简单的反向传播实现对深度前馈网络的训练。2011 年,我们的 DanNet 成为首个超级卷积神经网络。而到如今,计算成本降低到当初的百分之一,但英伟达公司的市值则涨了 100 多倍……

获取 H100 已经成为 AI 公司面临的重大难题,也开始阻碍他们的正常运营,导致产品发布和模型训练纷纷出现延迟。AI 热潮带来的对算力前所未有的需求也在加剧这种情况,导致 GPU 制造中使用的各种基本组件均告短缺。

英伟达一直在支持全球几乎所有 AI 初创公司,而且似乎在为初创公司提供资助,帮助他们建立业务并购买 GPU。如今的英伟达已经在 GPU 市场上建立起垄断地位,而其他参与方也不得不抱紧这条大腿。于是乎,满足市场需求的责任将无人分担,只能着落在英伟达自己身上。

但 GPU 的制造涉及复杂的工艺流程,需要各种关键组件。内存、互连速度(例如 InfiniBand)、缓存和缓存延迟等因素,在 GPU 的实际性能表现上起着至关重要的作用。其中任何一种组件的短缺,都有可能导致 GPU 生产延迟、进而引发整体供应不足。

参考链接:

https://analyticsindiamag.com/why-the-ai-world-is-looking-up-to-nvidia/

https://edition.cnn.com/2023/08/06/tech/ai-chips-supply-chain/index.html