OpenAI 里有不少人,比我们想象中更希望实现通用人工智能(AGI)。

最近有个播客特别火,前 OpenAI 员工、哥伦比亚大学 2021 届毕业生 Leopold Aschenbrenner 花了 4 个小时谈论当前 AI 发展趋势:2027 年实现 AGI,2030 年超级智能出现,现有对齐技术恐失效。

这次播客在 Spotify、Twitter 和 Youtube 都有传播,光 Youtube 上就有 10 万次观看。Aschenbrenner 大肆宣扬了“2027 年实现 AGI”的看法:“到 2027 年,模型将能够完成人工智能研究人员/工程师的工作,这是非常有可能的。”

另外他还发表了一篇 165 页的名为《情境感知》的宣言,对 AI 发展的未来做出了一系列预测,并在开头写下了“致敬 Ilya Sutskever”。总结来说这份宣言除了 3 年实现 AGI,还包含以下几个关键节点:2024 年,训练计算正在快速崛起;效率计算将在 8 个月内实现倍增;通用人工智能会在本个十年之内到来。

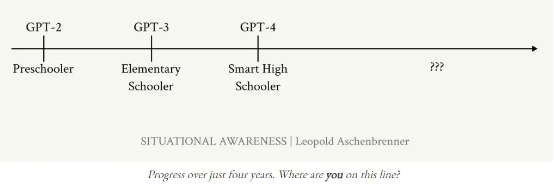

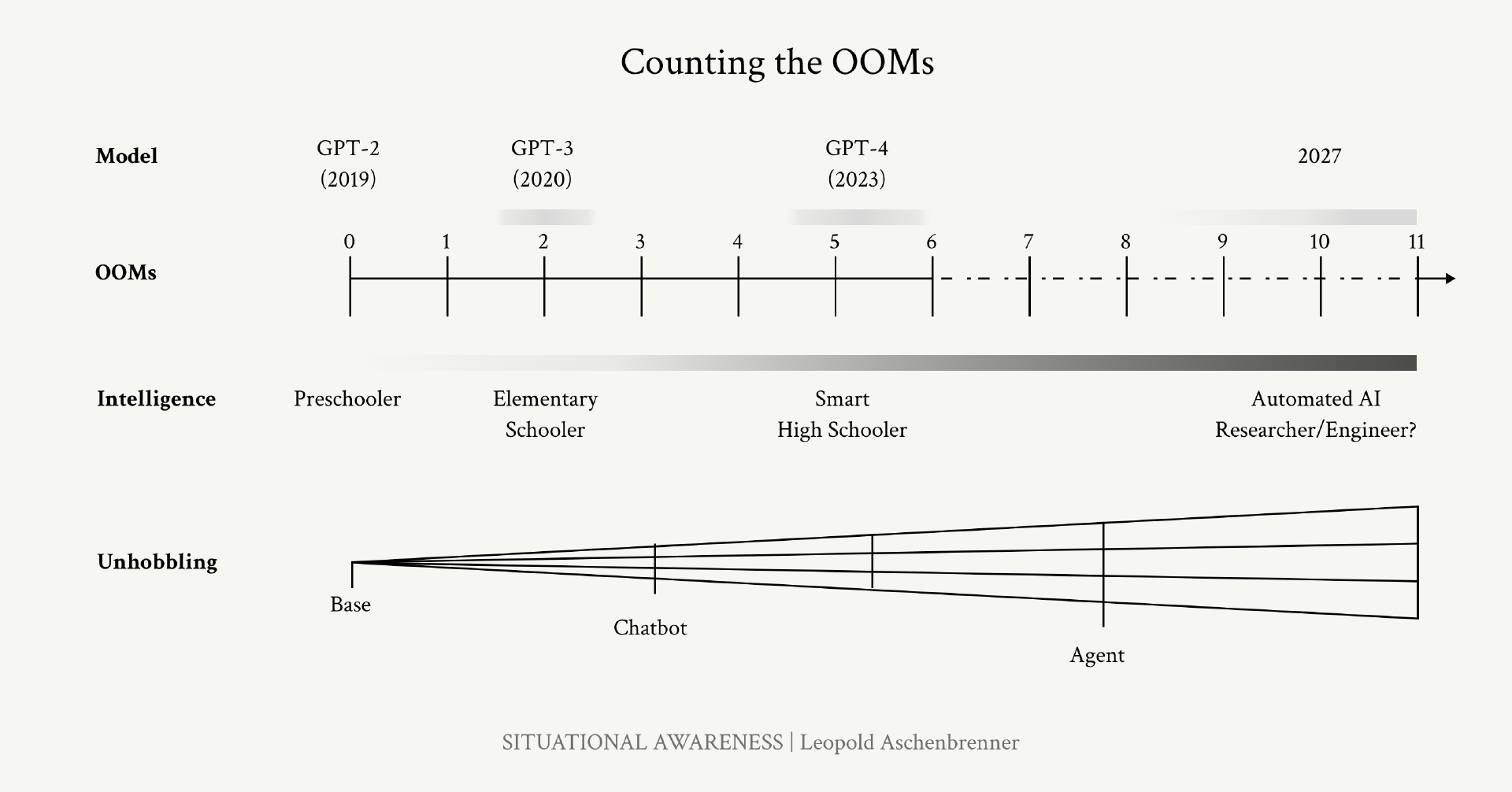

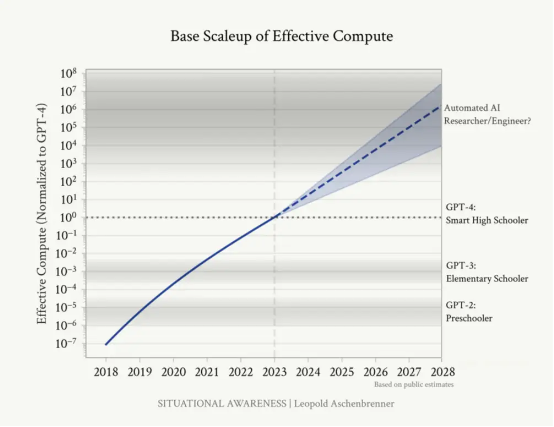

Aschenbrenner 认为,AI 发展的速度可以通过 OOM(数量级)来衡量。过去四年,AI 从 GPT-2 发展到 GPT-4,相当于从“学龄前儿童”进化为“聪明的高中生”。他预测,到 2027 年,AI 将实现与 GPT-2 到 GPT-4 相似的跃迁。在达到 AGI 之后,AI 可能会在不到一年的时间内从人类水平快速过渡到超人类水平。

AI 的进展主要得益于算力、算法效率和通过微调解锁的潜力(如基于人类反馈的强化学习、思考链、工具和脚手架等)。Aschenbrenner 预计,到 2027 年,算力和算法效率将分别增加 2 到 3 个 OOM。

OpenAI 出来的 AGI 鼓吹者

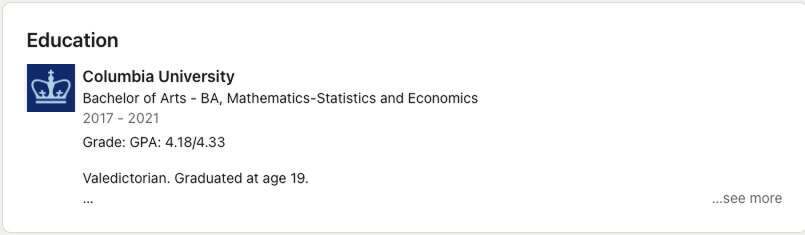

Leopold Aschenbrenner 是哥伦比亚大学 2021 届毕业生,其毕业论文“Aversion to Change and the End of (Exponential) Growth”获得了经济学最佳毕业论文 Romine 奖,之后便一直从事经济方向的研究,看起来并没有太多和技术直接相关的经历。

本科毕业后,他自称经历了一年的 Gap year,然后于 2023 年加入了 OpenAI 的“超级对齐”团队,具体工作不知。一年半后,他在接受采访时表示他因涉嫌泄露机密信息于今年 4 月被解雇。

在本期播客中,他透露了离开 OpenAI 后,成立了一家专注于 AGI 的投资公司。

大家好,我是 Leopold Aschenbrenner。我最近成立了一家专注于 AGI 的投资公司,主要投资人包括 Patrick Collison、John Collison、Nat Friedman 和 Daniel Gross。在此之前,我曾在 OpenAI 的超级对齐(Superalignment)团队工作。再往前,我曾在牛津全球优先事项研究所长期从事经济增长研究。我来自德国,目前住在加利福尼亚州旧金山。

AI 研究员、律师兼作家 Tobias Mark Jensen 对这位只有 25 岁的 AGI 鼓吹者作出了以下评价:

你在二十出头的时候,在做些什么?我自己那时的生活很简单,平时上学听课,周末则把自己灌得酩酊大醉。

在同样的年纪,Leopold Aschenbrenner 正在 OpenAI 的“超级对齐”团队与 Ilya Sutskever 合作。在此之前,19 岁的他以优异的成绩毕业于哥伦比亚大学,并在牛津大学从事经济增长研究。如今 24 岁的他正与其他硅谷人士一道,创立了一家专注于 AGI 方向的风险投资基金。

Aschenbrenner 对于 AGI 的期待可以理解,毕竟有望从中获利。但从种种迹象来看,他们似乎太过狂热,甚至堪称是年轻版的 Sam Altman。

情境感知或者说态势感知(SA)指的是对环境、个中元素及其如何随时间或其他因素而变化的理解能力。情境感知在诸多环境中都是有效决策的核心前提。而如果 AGI 或者说超级智能真的即将实现,那么当前的文明,甚至全人类似乎还没做好掌控这股力量的准备。

或者从认知角度出发,立足 AGI 如何影响全人类这个问题,我们到底该如何理解“情境感知”?来自德国、现居旧金山的年轻人 Aschenbrenner 在采访中倒是言之凿凿。

这份爆火的“胡言乱语”实际都讲了啥?

被 OpenAI 公司解雇的 Aschenbernner 不再受到 OpenAI“不诋毁”协议的约束,于是他公开发表了一份名为《情境感知:未来的十年(SITUATIONAL AWARENESS: The Decade Ahead)》的宣言。

“情境感知”这词读着就透露一种诡异感。这证明了这些“精英”已经与普罗大众间产生了极度夸张的脱节。这份宣言的根基并不是事实、数据或者理性判断,而完全源自主观推断、狂妄自大以及对技术那宗教式的崇拜。

让我们来看看 Aschenbrenner 最核心也最奇怪的主张,可怕的是这些主张很可能得到了 OpenAI 员工乃至硅谷不少技术投资者的支持。

AI 将继续呈指数级增长

“我提出以下主张:到 2027 年,模型将能够接替 AI 研究员/工程师的工作,而且可能性极高。这不是科幻小说中的畅想,而是图表数据支持的结论。”

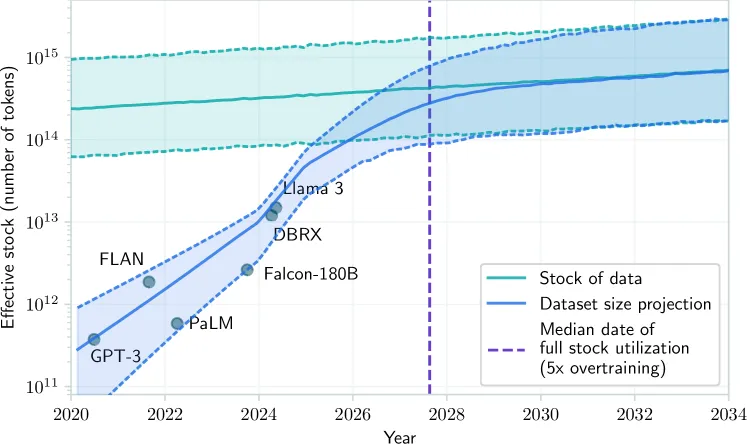

之后 Aschenbrenner 亮出了以下图表:

那我们就需要回答几个问题了:

算力的增长是否一定等价于更强的 AI 智能?

AI 是否具备盈利空间?

我们真能认同 GPT-4 智力水平与“聪明的高中生”相当的说法吗?

一项研究表明,扩展定律(Scaling Law)已经达到极限,即投入更多数据和更多算力来训练 AI,也无法继续显著增强 AI 智能。AI 初创企业所能吸引到的种子资金在最近一个季度急剧缩水,全世界在 AI 领域砸下巨额金钱,但截至目前获得的回报却基本可以忽略不计。

至于 GPT-4 的智力水平与聪明的高中生相当,完全是个不负责任的说法。只有立足狭义的基准测试,这种判断才算正确,但这些测试并不能准确衡量智力水平。正如 Melanie Mitchell 所言,“AI 在基准测试中的表现,并不一定能体现 AI 在现实世界中的真实能力。”

还有一点,基准测试中的问题和答案很可能遭到了“污染”,也就是说其已经被纳入了 AI 训练数据当中。由于 OpenAI 拒绝分享其模型训练数据来源,所以这个问题既无法证实、也无法证伪。

AI 将取代人类劳动力

“最终,我希望我们能迎来一种类似于远程办公临时工的方案。AI 智能体将加入业务流程,像新员工一样入职,并在 Slack 上向同事发送消息、使用业务软件、提交 pull request,甚至能在处理大规模项目时提供个人独立工作数周所交付的成果。当然,实现这一切需要比 GPT-4 更好的基础模型,但可能也不用好太多——多数资源都将集中在解决限制模型实际应用的基础障碍方面。”

考虑到最近的发展速度,在未来一、两年内出现 Aschenbrenner 构想中那种自主 AI,似乎也并不算在痴人说梦。

但这一切,是否值得?

Aschenbrenner 这一生中可能从未接触过平凡的岗位。他做出的声明应该没有特别的恶意,但却再次凸显出人工智能上层阶级对普通人赖以生存的平凡岗位的真实评价:鄙夷。

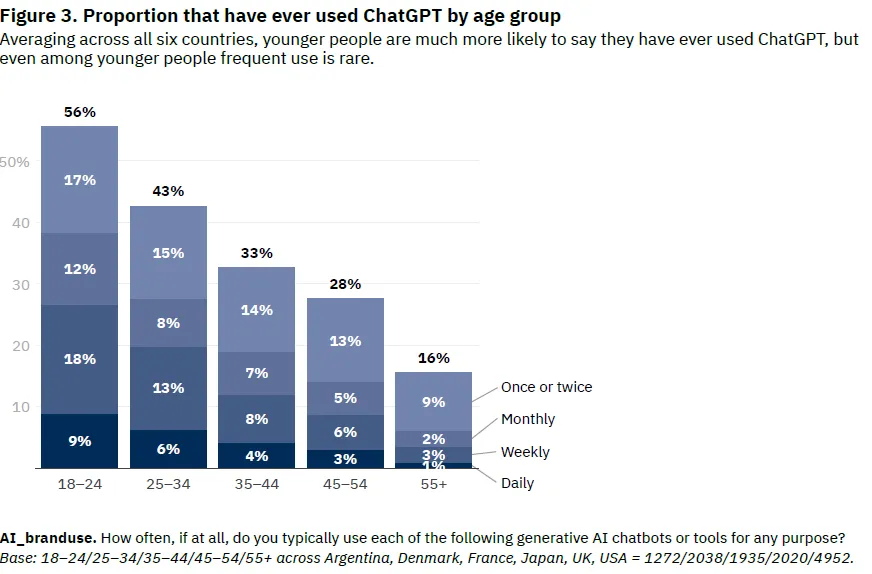

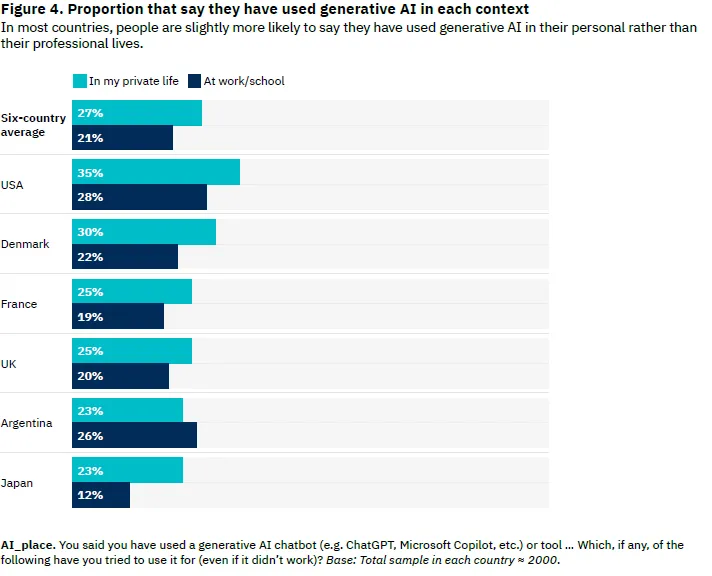

但目前还没有任何迹象表明,AI 智能体会在未来一到两年内取代普通办公室白领。任何用过 GPT-4 或者谷歌 Gemini 的普通人都知道,这些模型还远不够直观或者说易于理解。老实讲,AI 工具对于很多任务根本帮不上什么忙,各个国家乃至大洲中需要频繁使用 ChatGPT、谷歌 Gemini 乃至微软 Copilot 的用户只占全部工作岗位中的极少数(数据来自路透社新闻研究所和牛津大学 2024 年 5 月的报告)。

OpenAI 赚钱吗?

“报告显示,OpenAI 公司在 2023 年 8 月的收入为 10 亿美元,到 2024 年 2 月的收入则为 20 亿美元,相当于每 6 个月翻一番。如果这一趋势持续下去,那么到 2024 年底/2025 年初,其年收入应该会增长至约 100 亿美元。”

这是心智正常的成年人能说出来的话吗?种种预测简直就是胡言乱语。其中的逻辑水平类似于:“我今年能跳 1 米,而在训练 6 个月后能跳 1.5 米。只要这个进度保持不变,那么训练 10 年后我就能跳 10 米。”

AGI 是一种极为隐秘的强大武器

“我们正在开发人类有史以来最强大的武器。我们目前开发的算法机密,实际上也是对国家最重要的国防秘密——这些秘密将成为美国及其盟友在未来十年内保持经济与军事优势的基础,并决定我们是否具备必要的领先优势以保障 AI 安全。这些秘密将决定第三次世界大战的结果,也将决定整个自由世界的未来。”

他明白自己在说什么吗?!Aschenbrenner 深切关注中国抢在美国之前开发出 AGI 的可能性。对他来说,至少在国家安全层面,OpenAI 目前开发的聊天机器人比核武器还要重要。而且面对好奇心爆炸的读者,他压根没有解释 AGI 到底要如何成为“人类有史以来最强大的武器”。

通过他这份《情境感知》宣言,让人意识到下一代手握特权但却盲目鲁莽的投资者们要比人们想象中更离谱。这真的很可悲,世界上最富裕的阶层掌握着真正能让世界变好的资源,但他们的生活和思维方式却彻底偏离了现实。

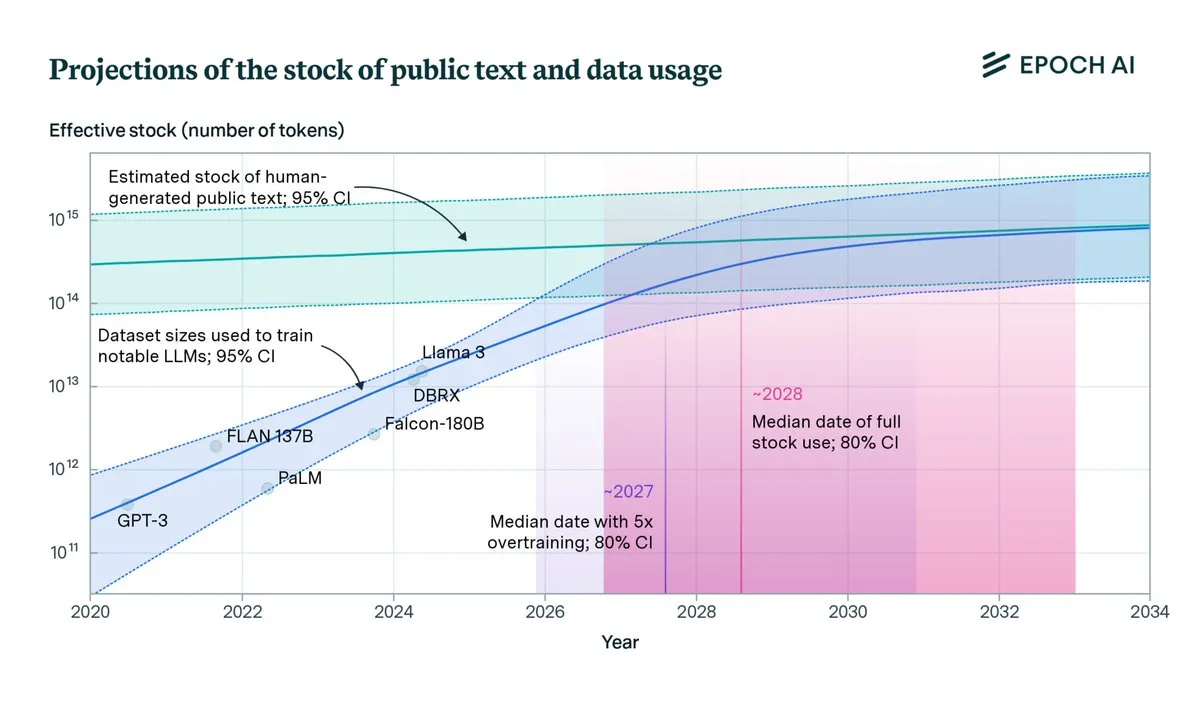

AGI 仍面临一系列现实障碍

我们都知道训练数据即将耗尽,那为什么所有风险投资方仍在疯狂炒作 AGI,而且不强调其感知与通用学习方面的特征、反而总想把它描述成一种商业工具?人有记忆的,OpenAI、机器学习研究员和科学家们在几年之前提出的 AGI 概念我们可还记得呢。

最近《时代》杂志报道了 Epoch AI,这是一家关注 AI 发展轨迹、旨在造福社会的研究机构。他们最近发表的论文相当有趣。

2024 年 6 月 4 日发表的这篇《数据会被耗尽吗?人类生成数据正在束缚大模型持续扩展( Will we run out of data? Limits of LLM scaling based on human-generated data)》的文章提出,如果我们在 2026 年之前就用尽了高质量训练数据,或者说在 2028 年之前达到现有训练方法的极限,那在 2027 年实现 AGI 是否将是天方夜谭?

目前还无法断言大语言模型到底是不是实现通用学习 AGI 的正确架构,但各位技术乐观主义者显然希望得到肯定的答案,并热切期待能够从中获利。不少风险投资资金和 Copilot 时代的炒作也都扎根于此。

Leopold Aschenbrenner 的宣言和主张肯定存在很大问题,但倒也可以理解,毕竟他最近正忙着为刚成立的 AGI 投资公司做营销。但他并未透露这家 AGI 投资公司具体叫什么名字。

但从行动上看,既然 AGI 投资公司的架子都搭起来了,他的决心自然也不比那帮技术乐观主义者差多少。至于这究竟是不是个好的投资决策,只能说目前 AGI 的概念在旧金山还算有市场,而最终能证明一切的只有时间。

他们并不真正关心 AGI 对于现实社会的潜在影响,其核心目的永远是直接从中获利。哪怕是那些离开了 OpenAI 的前“超级对齐”团队成员,其中也有不少在大肆宣传 AGI 以及衍生自 2022 年 ChatGPT 的其他技术分支。这些方案更多强调如何取代中等技术工人,而非创造任何具有决策能力和自我意识的通用学习成果。

换言之,AGI 一直是 OpenAI 最核心的支柱性营销概念。

写在最后

大家如何看待 Aschenbrenner 的观点?现在真是建立 AI 投资基金的好时机吗?无论答案如何,现实中确实有越来越多的初创公司选择将“AGI 幻想”纳入其营销叙事当中。

市场上不少资金充足的 AI 研究及生成式 AI 初创公司其实很难创造收入,他们的多数产品根本没有市场需求。除了 OpenAI 这位绝对的时代宠儿和明星之外,大多数企业都面临着残酷的市场激烈,而且根本不敢指望能获得理想的投资回报率。

在 ChatGPT 发布整整 18 个月之后,我们并没有看到 AI 在造福人类方面取得实质性进展。技术乐观主义者总想让大家相信,生成式 AI 是一项与互联网本身一样伟大的发明。但,真是这样吗……

特斯拉、亚马逊、谷歌、TikTok、Snap 以及微软等公司在 2024 年的前几个月都经历了大规模裁员。Zoom 希望为员工打造数字孪生,让这些数字副本参加会议;包括 Figma 在内的不少企业则尝试用 AI 改善成本管理,借此减少必要的员工数量。

同时,软件和云计算厂商,正在被生成式 AI 需求“抽干活力”。有证据表明软件和云计算厂商也将直接暴露在生成式 AI 公司的火力覆盖范围内。AI 可能会继续侵蚀资本主义和股票市场上的企业数量,并导致一众软件和云计算厂商的生存空间不断被压缩。

Veeva 公司 CEO Peter Gassner 最近表示,AI 已经成为“决定竞争地位的优先因素”。

由于收入令人失望、预期疲态尽显,Salesforce 的股价遭遇 2024 年以来的最大跌幅。

一众软件和云计算厂商今年第一季度的收益预测都不及预期,产品面临的竞争环境也趋于白热化。

客户这边越来越不愿意在软件、CRM、云计算乃至 RPA 方面签订多年长期合同。而在另一方面,生成式 AI 领域的投资回报率仍存在严重的投机属性,其成本甚至经常高于预期生产力或者理论上能够节约的劳动时间。

面对如此严重的 AI 泡沫,任何头脑清醒的人都能基于数据轻易驳倒所谓 AGI 将在短期内实现的论点。

也许 Leopold Aschenbrenner 有一天会成为新的技术巨星,又或者沦为为 AGI 飘渺神话造势的又一颗棋子。但无论如何,这股炒作趋势已然形成,虚幻且危险。

参考链接:

https://situational-awareness.ai/from-gpt-4-to-agi/

https://www.youtube.com/watch?v=zdbVtZIn9IM

https://www.ai-supremacy.com/p/the-rise-of-the-agi-profiteers