“我不相信他”:负责捍卫人类利益的 OpenAI 团队为何分崩离析。

ChatGPT 可以说话,但 OpenAI 员工不能

Ilya Sutskever 与 Jan Leike 上周二宣布将离开 OpenAI。这两位是公司 superalignment“超级对齐”团队的负责人,主要工作就是确保 AI 技术与开发者的目标保持一致,避免对人类造成不可预测的损害。

选择离开的不只有他们。自去年 11 月以来,也就是 OpenAI 董事会试图以“宫斗”方式解雇 Sam Altman 之时,公司里至少 5 名关注 AI 安全的员工已经或主动、或被动地离开 OpenAI。

这到底在闹哪样?如果大家一直在社交媒体上关注此事,可能会以为是 OpenAI 悄然取得了巨大技术突破。表情包“Ilya 看见了什么?”认为这位前首席科学家之所以仓惶离场,是因为他看到了令人恐惧的东西——比如可能毁灭人类的 AI 系统。

但真正的答案可能跟对技术的恐惧无关,而仍然出在人的身上——也就是 OpenAI 掌门 Altman。熟悉该公司内情的消息人士称,关注 AI 安全的稳健派已经彻底对 Altman 失去了信任。

一位不愿透露姓名的内部知情人士表示,“信任崩溃是个逐渐的过程,就如同多米诺骨牌的倒落一样。”

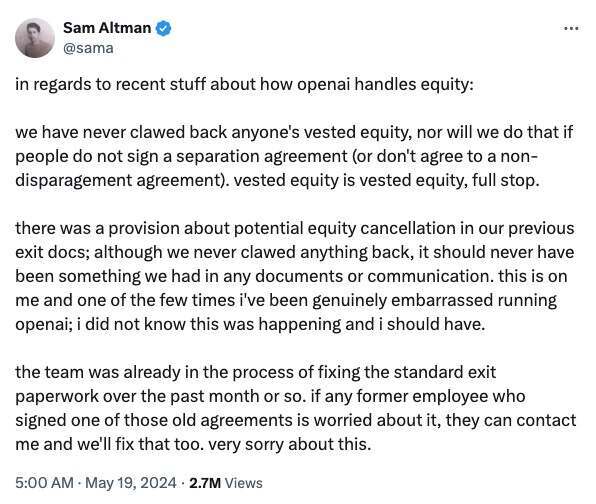

没有多少员工愿意公开讨论这个问题。这一方面是因为 OpenAI 向来会与离职员工签订相当严苛的离职协议,而拒绝签署则意味着放弃补偿权益,有可能损失数百万美元。

OpenAI 有着极其严格的离职协议,其中包含前 OpenAI 员工必须遵守的保密和保密条款。它禁止他们在余生中批评他们的前雇主。即使承认 NDA 的存在也被视为违反了协议。

离职员工如果拒绝签署该协议,或泄露协议内容,他们将有可能失去在职期间所获得的所有已归属期权。对于像 OpenAI 这样的初创公司员工来说,期权收益是一项重要甚至是高于其薪资的补偿形式。因此,用这份收益作为威胁,是让离职员工保持沉默的一种非常有效的方式。

有点讽刺的是,OpenAI 刚宣布了令人兴奋的新产品 ChatGPT 4o,让 ChatGPT 可以像人类一样说话。是的,ChatGPT 可以说话,但 OpenAI 员工必须保持沉默。“封口令”的存在,让 OpenAI 获得了几乎一边倒的批评意见。

风向变了。OpenAI 正处于全民唾弃的边缘。

OpenAI 否认三连,但没人相信他们了

鉴于当前舆论哗然的形势,OpenAI 发出了一份声明,强调「我们从未剥夺任何现任或前雇员的应得利益,也不会因对方拒绝签署离职或禁止负面评论的协议而剥夺其利益。」而在询问这是否反映出政策内容有所变更时,OpenAI 的回应是「声明反映了事实」。

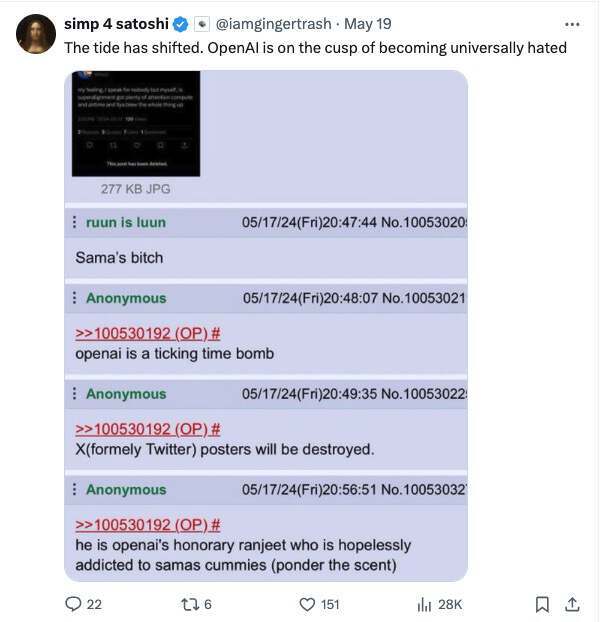

昨天下午,Altman 本人在一条推文中承认,OpenAI 公司的离职协议中确有一条关于离职员工「潜在股权撤销」的规定,但表示该公司已经在调整具体内容。

关于近期出现的有关 OpenAI 如何处理权益一事的讨论:

我们从未因对方拒绝签署离职协议(或禁止负面评论协议)而剥夺任何人的应得权益,未来也不会这样做。应得权益就是应得的,无需讨论。

关于我们原有文件中提出的潜在股权撤销规定,尽管我们从未实际实施,但也承认这条内容本就不该存在。这是我的问题,也是我在执掌 OpenAI 以来最尴尬的情况;我确实不知道有这么一条,抱歉。

过去这一个月来,相关团队已经在调整标准离职条款。如果有任何前员工担心旧协议引发问题,都可以与我联系并共同解决这个问题。再次抱歉。

但还有一位前雇员,他拒绝签署离职协议,为的就是可以自由批评该公司。Daniel Kokotajlo 于 2022 年加入 OpenAI,加入治理团队后一直希望引导公司拥抱安全部署理念,但最终于上个月选择辞职。他说这也意味着他放弃了高达 85%的家庭净资产。

Kokotajlo 在上周接受采访时表示,“OpenAI 正在训练越来越多的 AI 系统,目标就是最终超越人类智能。这可能是人类有史以来最激动人心的目标,但如果我们不能谨慎行动,那也可能陷入万劫不复的深渊。”

OpenAI 曾明确表示希望建立通用人工智能(AGI),这是一种理想系统,能够在诸多领域实现等同甚至超越人类的智能表现。

Kokotajlo 坦言,“我曾充满希望,认为 OpenAI 就是技术发展的灯塔,会以负责任的态度逐步迈向 AGI。但现在很多人都意识到根本就不可能,我逐渐对 OpenAI 领导层及其处理 AGI 的负责态度失去信任,并最终选择辞职。”

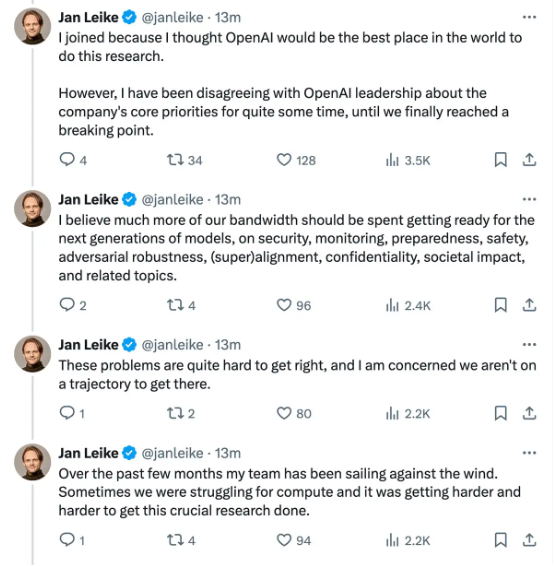

Leike 上周五也在 X 上发帖解释了自己辞去超级对齐团队联合负责人职务的原因,情况与 Kokotajlo 基本相似。他写道,“我一直对公司的核心优先事项设置保留意见,而形势最终发展到了临界点。”

现在,Altman 社交媒体下面,都是大片质疑的声音:“为什么安全要退居次要位置?”“为什么禁止前员工批评 OpenAI?”“理性的人不会信任你。”

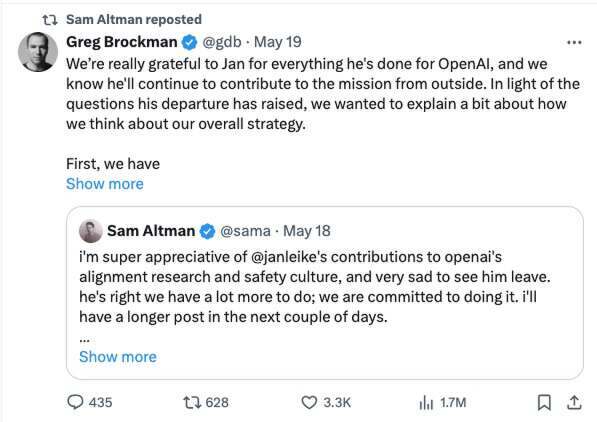

Greg Brockman 也不得不出面发表了一条署名为“Sam and Greg”的长推文,表示他们没有放弃安全,并且在“努力减轻风险”。网友们照样不买账,认为这都是废话,一看就是 Altman 的手笔。

外媒对此评论说,这是 Altman 已经被大家的反应“吓坏了”。

OpenAI 安全团队为何不信任 Sam Altman?

在回答这个问题,我们需要将时间倒回去年 11 月。当时,身为 OpenAI 董事会成员的 Ilya 也参与过对 Altman 的“逼宫”。董事会指出,Altman“在沟通中未能一直保持坦诚。”换句话说:我们不相信他。

但这场行动最终失败,Altman 和他最忠诚的盟友、公司总裁 Greg Brockman 威胁要将 OpenAI 的顶尖人才一股脑带去微软。也就是说除非立刻让 Altman 官复原职,否则 OpenAI 就会当场爆炸。面对这种威胁,董事会只得屈服,劫后余生的 Altman 比以往任何时候都更加强大,并立即组织起更支持他、愿意让他放手做事的新董事会。

入宫行刺失败,事情就绝对不可能善了。

虽然 Ilya 和 Altman 曾多次对外大秀二人的深厚友情,但在上周 Ilya 还是宣布离职,并表示将投身于“对我个人而言意义重大的项目。”几分钟后,Altman 也在 X 上发帖,称“这让我非常难过。Ilya 是……我的亲密好友。”

Sam Altman 和 Ilya Sutskever 于 2023 年 6 月 5 日在一所大学里共同发表演讲

但实际情况是,自从政变失败以来,这半年间 Ilya 就没有出现在 OpenAI 的办公室。他一直以远程方式领导超级对齐团队,以确保未来的 AGI 能够与人类利益保持一致。虽然想法不错,但却与公司的日常运营彼此分离,OpenAI 的主要精力完全放在 Altman 领导下的商业化产品开发方面。在 Altman 复职后不久,Ilya 还曾发布并迅速删除过这样一条推文:

这个月我学到了很多。与其费心运用各种手段,倒不如“棍棒底下出孝子”。

因此尽管对外总在刻意展示二人的亲密关系,但在经历了政变之后,Ilya 和 Altman 还能不能算朋友真的要打个大大的问号。

而 Altman 对“逼宫”一事的反应,也揭示出他性格中的某些侧面:除非董事会让他官复原职,否则他就拼个鱼死网破,而且坚持对董事会成员进行大洗牌以巩固自身地位,表现出牢牢把握权力的坚定决心,甚至直接消除了未来再次面临质疑的可能性。已经有多位前同事和雇员证明 Altman 就是个控制狂,当面一套、背后一套——比如他曾多次在人前强调安全,但实际工作时却根本不在乎。

举例来说,Altman 会从沙特阿拉伯筹款,希望借此建立新的 AI 芯片公司,为自己的 AI 前沿探索储备充足的算力资源。此事让关注安全的员工们感到震惊。如果 Altman 真的在以安全方式构建和部署 AI,为什么要以近乎疯狂的方式攫取芯片,不惜一切代价加快技术开发?他又为什么要跟沙特合作,坐视对方利用 AI 增强数字监控或人权侵犯等潜在风险?

内部知情人士指出,于员工们而言,所有这一切都导致了文章开头提到的“失去信任,因此哪怕 OpenAI 如何强调自己对某件事的重视,人们也都不再相信。”

而这个渐进的过程,在上周开始全面爆发。

超级对齐团队联合负责人 Jan Leike 就拿出了鲜明的态度。他在脱离 OpenAI 的几小时后就在 X 上发帖称“我辞职了。”没有温暖的告别,也没有对公司管理层的哪怕虚与委蛇的夸赞。

其他重视安全的多位前雇员则给 Leike 的离职帖点赞,同时加上了爱心的表情符号。Leopold Aschenbrenner 作为其中一位,就是上个月被 OpenAI 开除的超级对齐团队成员。媒体报道指出,他和同团队的另一位研究人员 Pavel Izmailov 因泄漏信息而被解雇。但 OpenAI 方面并未提供关于泄漏的证据。鉴于每位员工在加入 OpenAI 时都需要签署严格的保密协议,所以对于一位身经百战的硅谷老兵来说,Altman 完全可以将最无害的信息分享也定义成“泄漏”,借此把 Ilya 一系的员工全都清理出 OpenAI 之外。

就在 Aschenbrenner 和 Izmailov 被离职的同一个月,另一位安全研究员 Cullen O’Keefe 也离开了公司。

两周之前,公司一位安全研究员 William Saunders 在 EA 论坛上发表一篇神秘的帖子。EA 论坛是有效利他主义运动成员们的线上聚会场所,一直在积极参与 AI 安全事业。Saunders 总结了自己作为超级对齐团队成员在 OpenAI 所做的工作,写道“我于 2024 年 2 月 15 日从 OpenAI 辞职。”一位评论者则提出了核心问题:Saunders 为什么要专门发帖讨论这事?

Saunders 回应称,“无可奉告。”用户们由此猜测,他很可能是受到了禁止负面评论协议的约束。

将上述消息跟公司内部人士的话语结合起来,我们至少发现有七位前雇员都曾努力在内部推动 OpenAI 的安全意识,但却最终对公司主导者彻底失去信心,并最终选择退出。

知情人士指出,“我认为公司里很多认真关注安全和社会影响的同事,心里都抱有一个悬而未决的疑问:为 OpenAI 这样的公司工作,到底是不是对的?要想让员工们放心,OpenAI 就必须对所做之事深思熟虑、同时承担起责任。”

随着安全团队的解散,OpenAI 的工作安全该由谁保障?

由于 Leika 不再负责超级对齐团队的管理,OpenAI 任命公司联合创始人 John Schulman 取代了他的位置。

但该团队已经被掏空,Schulamn 也仍忙于处理他之前的主要工作,确保 OpenAI 现有产品的安全。在这样的背景下,谁能指望 OpenAI 会认真开展具有前瞻性的安全工作?

恐怕没戏。

知情人士解释称,“超级对齐团队当初建立的目的,就是如果公司成功打造出通用人工智能,那么必然会引发各种类型的安全问题。该团队实际是一笔面向未来的专项投入。”

但即使该团队满负荷运转,这笔“专项投入”也只能调动 OpenAI 内的一小部分研究人员,且只承诺为其提供 20%的算力资源。现如今,这批算力可能会被移交给其他 OpenAI 团队,也不清楚是否将继续探索如何避免未来可能出现的 AI 灾难性风险。

需要明确一点,这绝不是说 OpenAI 当前发布的产品(例如能够与用户开展顺畅对话的最新大模型 GPT-4o)就会毁灭人类。但随着这项技术的快速发展,未来如何谁也不敢保证。

知情人士表示,“最重要的就是搞清楚他们目前是否正在构建和部署不安全的 AI 系统,以及能不能指望他们安全构建和部署 AGI 或者超级智能。前一条我不知道,但后面这点我认为是指望不上。”

Leike 在上周五的 X 帖子中也表达了同样的担忧。他指出,他的团队一直在努力争取足够的算力来完成工作,但总体上可谓是“逆水行舟”。

之所以加入 OpenAI,是因为我觉得这里是最适合开展这项研究的场所。

然而很长一段时间以来,我跟 OpenAI 领导层在公司核心优先事项方面一直存在着分歧,这种分歧最终走到了临界点。

我认为我们应该将更多的资源花在为下一代模型做好准备上,具体包括安全、监控、准备、安全对抗稳健性、超级对齐、保密性以及社会影响等相关主题。

这些问题很难解决,我甚至担心 OpenAI 还没找到正确的路线。

过去这几个月间,我的团队一直在逆水行舟。有时候我们会在算力方面遇到困难,也让这项重要的研究变得愈发举步维艰。

其中最重要的一条,就是 Leike 提到“我认为我们应该将更多的资源花在为下一代模型做好准备上,具体包括安全、监控、准备、安全对抗稳健性、超级对齐、保密性以及社会影响等相关主题。这些问题很难解决,我甚至担心 OpenAI 还没找到正确的路线。”

当 AI 安全领域最举足轻重的从业者之一表示世界领先的 AI 厂商还没找到正确路线时,恐怕我们都有理由感到担忧。

参考链接:

https://www.lesswrong.com/posts/kovCotfpTFWFXaxwi/simeon_c-s-shortform