9 月 7 日,腾讯在数字生态大会上正式推出混元大模型。据介绍,腾讯混元大模型是由腾讯全链路自研的通用大语言模型,拥有超千亿参数规模,预训练语料超 2 万亿 tokens,具备强大的中文创作能力,复杂语境下的逻辑推理能力,以及可靠的任务执行能力。

目前,腾讯云、腾讯广告、腾讯游戏、腾讯金融科技、腾讯会议、腾讯文档、微信搜一搜、QQ 浏览器等超过 50 个腾讯业务和产品,已经接入腾讯混元大模型测试。同时,腾讯混元大模型将作为腾讯云 MaaS 服务的底座,客户不仅可以直接通过 API 调用,也可以将混元大模型作为基底模型,为不同产业场景构建专属应用。

在这一波大模型浪潮中,云服务被认为是最理想的大模型承载平台,而大模型也将引领下一代云服务的演进。通过云厂商所提供的基础设施、模型服务、训练加速框架等支持,大模型的能力将很快渗透到各行各业中。

与此同时,算力紧缺是摆在眼前的困境。如何在有限的卡上,构建稳定可靠的算力集群,如何让有限的算力资源发挥出最大的价值,也成为各家云厂商和模型公司最重要的课题。

大模型时代的赢家

如今我们正处于“智能涌现”的风口浪尖,人工智能只需访问每天产生的 2.5 万亿字节数据中的一小部分,就能创造出人类智力无法比拟的奇迹。不久前,由 Google DeepMind 构建的 AlphaDev,结合了计算机推理和直觉,帮助我们人类发现一些我们原本不知道的东西:一种全新且更快的排序算法,排序速度上取得的突破超越了科学家们几十年来的研究。

人类可能需要 20 年的时间才能成为领域专家,然后将这种思维应用于解决实际问题。如今,人工智能可以在几分钟或几秒钟内实现这种专业化。

腾讯集团副总裁、云与智慧产业事业群 COO、腾讯云总裁邱跃鹏将今年这一特殊的年份描述为“大模型的元年”,他说:“今天有点像移动互联网刚到来的时候,那一年我们往后看,可能没有太多人想到十几年之后移动互联网带来的深刻改变。”

如今,在技术创新带来的这股潮流趋势下,全球的科技企业都开始了 GPT“军备”竞赛,希望通过研发更强大的 GPT 模型来增强他们的产品和服务。以微软纳德拉为首的一众大佬都声称要将“所有产品上搭载 AI,彻底改造”。

然而,人工智能的高成本构成了一个不容忽视的难题,这也成为了许多企业参与的障碍,大企业反而比初创企业更能占据有利的地位。Semianalysis 估计,截至 2023 年 2 月,OpenAI 使用超过 3,600 台 Nvidia HGX A100 服务器来为 ChatGPT 提供服务。这些 HGX 服务器均包含 8 个 A100 GPU,每台成本为 $10,000 美元。这大约相当于为 ChatGPT 提供服务的硬件成本高达 2.88 亿美元,显然这些基础设施只有大型云服务提供商才能提供。

另一方面,训练和“推理”(实际运行)大语言模型的高昂成本是一种结构性成本,与之前的计算热潮不同。即使软件被构建或训练,它仍然需要大量的计算资源来运行大语言模型,因为每次生成提示响应时都需要进行数十亿次计算。相比之下,我们日常使用的应用程序所需的计算要少得多。也就是说,训练模型的成本只是冰山一角,隐藏在水面之下还有巨大的“推理成本”,即每次调用模型输出时产生的成本。Semianalysis表示,“以任何合理规模部署模型时,推理成本远远超过训练成本。事实上,ChatGPT 推理的成本超过了每周的训练成本。”

因此,以最低的综合成本获取算力资源已经成为人工智能公司成功的关键因素,而在云计算行业中,那些提供这种“铲子”的企业价值不可小觑。

“针对大模型所有相关能力的投入和研究是必需的,所有云厂商都必须做好对于 AGI 的支持,这是一个必答题,没有人能不答这道题。”邱跃鹏表示。

“目前投资规模最大的是在训练,没有几十亿的资本投入,很难下场去持续做大模型。另一方面,真的下场做大模型的企业不多,未来真正的应用场景还是在下游。结合场景看,未来,推理是比训练更大的市场。今天我们看到很多场景用了大模型之后,带来的效果提升确实非常明显,这说明大模型的商业模式相对来说更清晰。虽然目前还很难讲具体的算力需求究竟有多少,但一定是非常长期的机会。”

传统云服务能满足需求吗?

传统的云基础设施并不是为支持大规模人工智能而设计的,随着 AI 普及度和复杂度越来越高,云厂商也面临了一些全新的挑战,计算、存储以及 IT 架构等层面都发生着翻天覆地的变化。

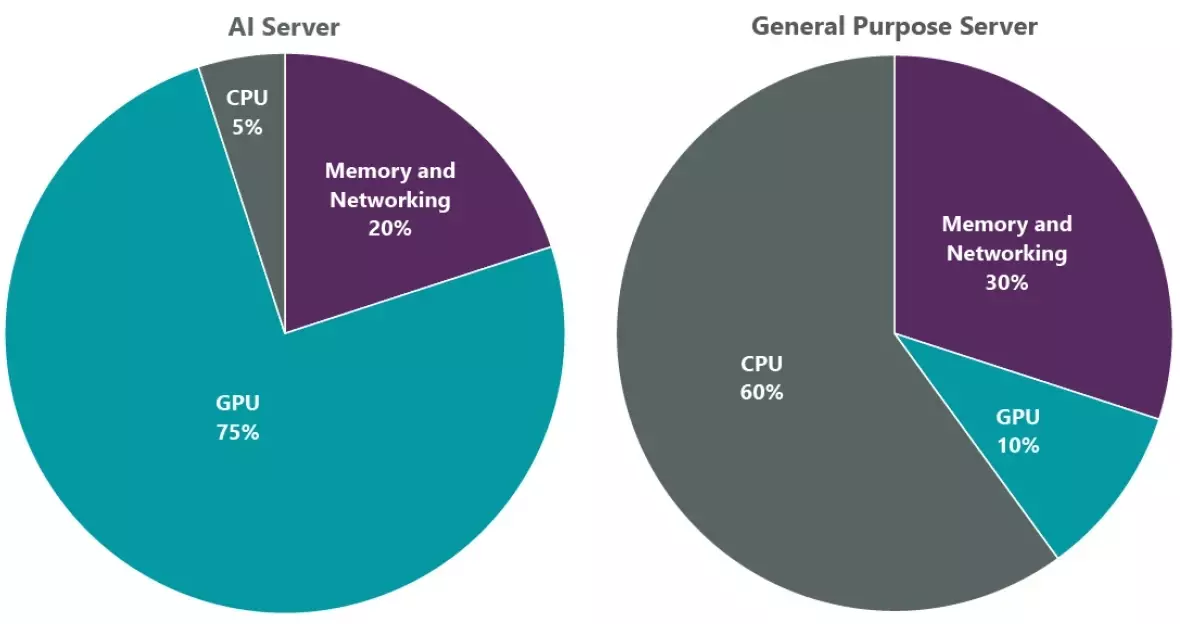

传统云服务大部分由通用 CPU 的服务器组成,而更适合运行 AI 工作负载的 GPU 集群只占基础设施的一小部分。根据英伟达在 2023 年台北电脑展会上的演讲,如果使用 GPU 进行训练,相比 CPU 服务器,客户可以以 4% 的成本和 1.2% 的电力消耗来训练一个 LLM。因此,该公司表示 CPU 已落伍,用 GPU 才是训练大语言模型的首选。

传统服务器和 AI 服务器对 GPU 的依赖对比,来自摩根大通的估计。

但高密度算力需求,也会给云服务带来影响,比如 IDC(数据中心)的规划对于高密集算力而言,仍然有许多瓶颈,例如需要高功率供电的机架。高功率的电力供给基础设施都很早期,高功率供电的机架很稀缺。

邱跃鹏提到,“IDC 是非常长周期的投资,面向未来,算力基础设施也需要相应地升级,来更好地承接大模型带来的新需求。”

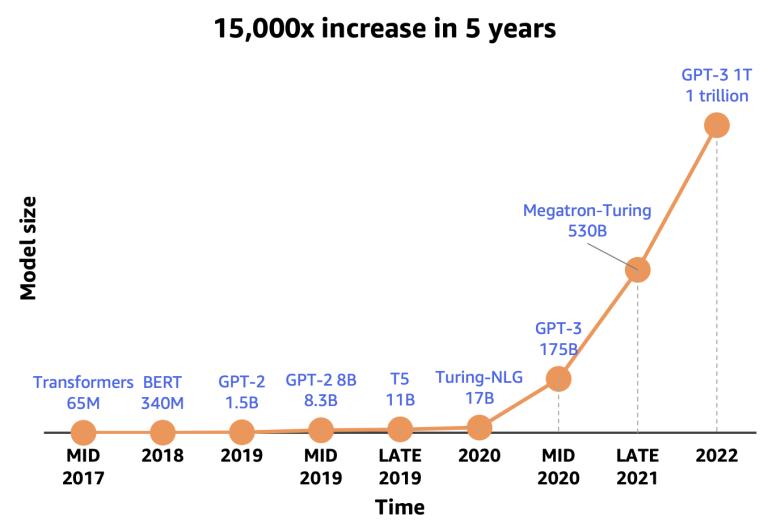

而从存储方面来说,在过去几年中,大语言模型的尺寸每年平均增长了 10 倍,参数数量从数百万个到万亿不等,大语言模型(LLM)也会面临存储容量的挑战,单个存储设备是不可能满足存储要求的。例如,OpenAI 的 GPT-3 模型拥有 1750 亿个参数,仅其参数就需要超过 300GB 的存储空间。

正如 OpenAI 论文“Language Models are Few-Shot Learners”中表示的那样,较大的模型往往表现更好,然而,参数数量增加也提出了更高的存储容量需求。如果在读取数据时机器出现问题,或者导致 SSD 硬件故障,都是不能容忍的。

最后一个是大模型“解锁”了各行各业的数据。以前是个别企业带着大家通过 AI 技术逐个攻克单一领域的问题,模型参数量和算力需求在多年来其实也一直是一个比较稳定的水平,据估算,海量数据因为依赖结构化也只用起来了 20%。而现在,随着大模型通用能力的加持,各行各业的万千企业都已经参与到了这里面来,Embeding(向量化)技术让非结构化数据的应用也有了更多的想象空间,模型训练的所需算力也变成了千卡规模,数据检索也会面临更大的压力。

基于以上种种挑战,腾讯云认为,在新的大模型时代,需要更高效的云技术。如果把之前的云称为 AI 1.0 时代,那么在 1.0 时代里,行业着重关注的是单机单卡的性能、标量数据的结构化精确检索,以及云原生带来的自动调度。而现在,当行业进入到了 AI 2.0 时代,在这个背景下,由于服务重点发生了转变,现在更多关注 AI 企业和大模型,云厂商需要将重点转向集群性能的提升、向量数据的存储与检索等方向上。

腾讯云是如何解决当前挑战的

传统云计算已经无法满足 AI 企业及大模型诉求,云智算已成为了关键支撑,腾讯面向 AI 场景专用,打造了腾讯云 AI 超级底座。

在这次大会上,我们关注到了腾讯云 AI 超级底座的几个关键产品:

高性能算力集群

对于想要自己打造大模型的企业而言,需要考虑的头一件事,就是算力够不够。

基于当下大模型大规模、高效率的训练需求,腾讯云上线了全新一代高性能计算集群 HCC,相比上一代整体提升了 3 倍。在实际业务测试当中,业内传统的集群方案训练一次需要 50 天的时间,而腾讯云只需要 4 天。

HCC 不止是一个单纯的算力资源,还包含了目前腾讯最先进的存储和 3.2T RDMA 网络能力,以及上层最前沿的软件定义技术、云原生编排技术和加速框架。

存储层面,训练场景下,几千台计算节点会同时读取一批数据集,需要尽可能缩短数据集的加载时长。腾讯云提供了 COS+GooseFS 对象存储方案,提升端到端的数据读取性能,以及 CFS Turbo 高性能并行文件存储方案,解決大模型场景大数据量、高带宽、低延时的诉求。

腾讯称,目前 HCC 已成为国内性能最强的训练集群,算力能够实现无损释放。

他们在硬件方面进行了大量的优化和升级,不断提高了集群的计算能力和稳定性,基于腾讯自研星星海服务器,搭载了目前业内领先的 GPU 芯片,支持单卡在 FP16 精度下输出 989TFlops 的算力(如果在精度差一点的推理场景下,可以接近 2000TFlops)。

另外,运行成本是开发者普遍非常关心的问题,大模型兴起初期,有开发者抱怨说:“跑一把大模型 ,体验就感觉就像坐在一辆被困在路上的出租车里:要么下车,要么盯着计价器跳动”。

虽然云计算工程师们已经能把故障率降得很低很低,但由于大模型任务和环境的复杂,仍然有可能出现偶发的中断。训练中断也是当前整个行业高度关注的话题。

腾讯云基于云原生能力,能够支持集群的监控和断点续算能力。为此腾讯提供了 7*24 小时的全局监控视角,支持编排、框架、实例等多层级的指标监控。一旦触发故障,系统能够在 5 分钟内恢复任务,10 分钟内恢复基础设施,并且无需人工干预,就能够自动最大化保障任务的连续进行。一个粗略的计算是,每减少一小时异常,干卡规模可节省数十万元成本。

高性能数据处理

在 AI 2.0 时代,所有的数据最终都将向量化。

为了满足企业在这个新时代对数据检索的需求,腾讯推出了一款专为 AI 场景打造的数据库:腾讯云向量数据库。

这是一款企业级的分布式向量数据库,相较于传统的单机插件式向量数据库方案,腾讯提供了 10 倍的单索引规模,支持高达 10 亿级行数,助力企业应对海量非结构化数据检索的挑战。

许多企业在 AI 接入过程中,Embedding 工程成为了非常大的瓶颈。而腾讯向量数据库集成 Embedding 能力,可以使得企业数据接入 AI 的工期从 30 天缩短到了 3 天,效率提升 10 倍。

大模型不仅需要大算力,还需要海量的高质量数据。

大模型的成功依赖于三个要素:模型、算力和数据,拥有高质量的数据能够使模型更加精准。

腾讯在云上打造了云原生数据湖仓、向量数据库。它们就像“过滤器”,能够对大量的原始数据进行清洗、分类。

云原生数据湖仓,目前能支持每秒百万级数据更新入湖、TB 级海量吞吐能力。配合刚刚发布的腾讯云向量数据库,能够实现 10 亿级向量检索规模、100 亿级的离线数据清洗规模,并将延迟控制在毫秒级。

实测效果显示,对比传统方式,腾讯云的高性能数据处理引擎,让原始数据清洗性能提升了 40%+,企业运行综合成本降低 50% 。

通过对各类数据的收集、分类、去重、清洗、管理,能够给大模型提供纯度极高的数据“燃料”,大模型也能基于这些高质量数据,全面提升训练和推理效率。

TI 平台提供精调部署能力

不是所有的企业都需要从头开始训练大模型

很多企业需要在通用大模型的基础上,灌入自己的数据做训练或精调,从而打造出适合自身业务的行业大模型。腾讯云也结合开发者和企业的使用需求,进一步完善了训练推理框架和 TI 平台工具链。

在训练推理层面,腾讯借助自研的机器学习框架 Angel,完成了混元的训练。Angel 训练速度相比业界主流框架提升 1 倍,推理速度比业界主流框架提升 1.3 倍。目前,企业和开发者可以通过 TI 平台直接使用该框架。

TI 平台提供的工具覆盖环境准备、代码调试、性能评估和部署全链路,具备高性能的大模型精调与部署能力,覆盖大模型开发、应用全生命周期,让客户只需加入自己独有的场景数据,即可在短时间内精调出专属的模型方案。

写在最后

大模型已经成为当前云服务提供商不可或缺的机遇。

事实上,云厂商之间正在围绕大模型展开竞争,重新争夺公有云市场,因为 AI 并不只是带来算力投入的增长,而是会带来整个业务的增长——当大模型的能力不断进化,企业在云上使用模型服务的需求也会增加;而被大模型改造的应用和产品,也带来了新的市场空间。基础设施、模型和应用,三者相辅相成,已经成为云厂商必争的空间。

面对全新的发展机遇,腾讯集团高级执行副总裁、云与智慧产业事业群 CEO 汤道生表示:“以大模型生成技术为核心,人工智能正在成为下一轮数字化发展的关键动力,也为解决产业痛点,带来了全新的思路。腾讯产业互联网将通过智能增强、数据增强、连接增强,持续助力产业增强。”

截至目前,国内主要大厂的大模型均已上线,而真正的竞争才刚刚开始,能否落地,能否真正产生价值,才是制胜关键。