太平洋时间本周二 11:01,谷歌在官网中宣布在 180 多个国家/地区通过 Gemini API 提供 Gemini 1.5 Pro 的公开预览版,这是它目前功能最强大的生成式 AI 模型。谷歌本以为能在互联网上掀起一番声势浩大的讨论,不料短短 40 分钟后,OpenAI 就出来抢风头了:它发布了非预览版的 GPT-4 Turbo,将之前独立的 GPT-4 Vision 直接集成到模型中。这还没完,下午 6:20,Mistral 在 X 上直接了当地甩出一条磁链,强势开源 Mixtral 8x22B 这个超大模型。

谷歌刚拔剑出鞘,OpenAI 和 Mistral 立马摩拳擦掌加入战斗,科技界“三强争霸赛”一触即发。不过,到底是虚张声势还是确实“有点东西”,让我们一探究竟。

Gemini 1.5 Pro :“听”懂掌声

Gemini 1.5 Pro 目前已在谷歌面向企业的 AI 开发平台 Vertex AI 上提供公共预览版。它能处理的上下文从 12.8 万个 token 增加到 100 万个 token,相当于大约 70 万个单词,或者大约 3 万行代码。这大致是 Anthropic 旗下模型 Claude 3 最大上下文量的四倍,OpenAI 旗下模型 GPT-4 Turbo 最大上下文量的八倍。

Gemini 1.5 Pro 版本扩展了输入模态,首次提供了本地音频(语音)理解功能和全新的文件 API,使文件处理变得更加简单。此外,Gemini 1.5 Pro 现在能够对上传到谷歌 AI Studio 中的视频进行图像(帧)和音频(语音)推理,谷歌也期待尽快为此添加 API 支持。

您可以上传讲座的录音,Gemini 1.5 Pro 可以将其变成小测验,并附有答案。

不过,Gemini 1.5 Pro 对于没有访问 Vertex AI 和 AI Studio 权限的人来说是不可用的。目前,大多数人只能通过 Gemini 聊天机器人来接触 Gemini 语言模型。虽然它功能强大,也能理解长命令,但它的速度不如 Gemini 1.5 Pro。

GPT-4 Turbo:不如不“看”?

OpenAI 宣布 GPT-4 Turbo with Vision 模型已经通过 OpenAI API 向开发人员开放。该模型延续了 GPT-4 Turbo 系列 128,000 个 token 的窗口大小,以及截止至 2023 年 12 月的知识库,最大的革新之处在于其新增的视觉理解能力,可处理和分析多媒体输入信息。

OpenAI 称这些变化有助于简化开发人员的工作流程并打造更高效的应用程序,因为“过去,开发者需要调用不同的模型来处理文本和图像信息,但现在,只需一次 API 调用,该模型就可以分析图像并应用推理。”

OpenAI 还提到此次更新是“ Majorly improved(重大改进)”,不过网友则对这个“小修小补”表示不感兴趣:“如果不是 GPT-5 的话,还是别发了。”

延伸阅读:OpenAI 重磅发布的 GPT-4 Turbo with Vision,是编码的倒退

Mixtral 8x22B :强势开源

今年 1 月,Mistral AI 公布了 Mixtral 8x7B 的技术细节,该模型以 47B 左右的参数总量,展现了不错的性能——在人类评估基准上明显超过了 GPT-3.5 Turbo、Claude-2.1、Gemini Pro 和 Llama 2 70B 聊天模型。

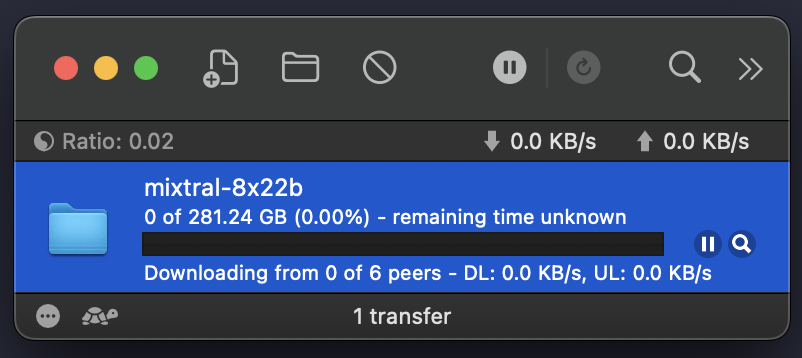

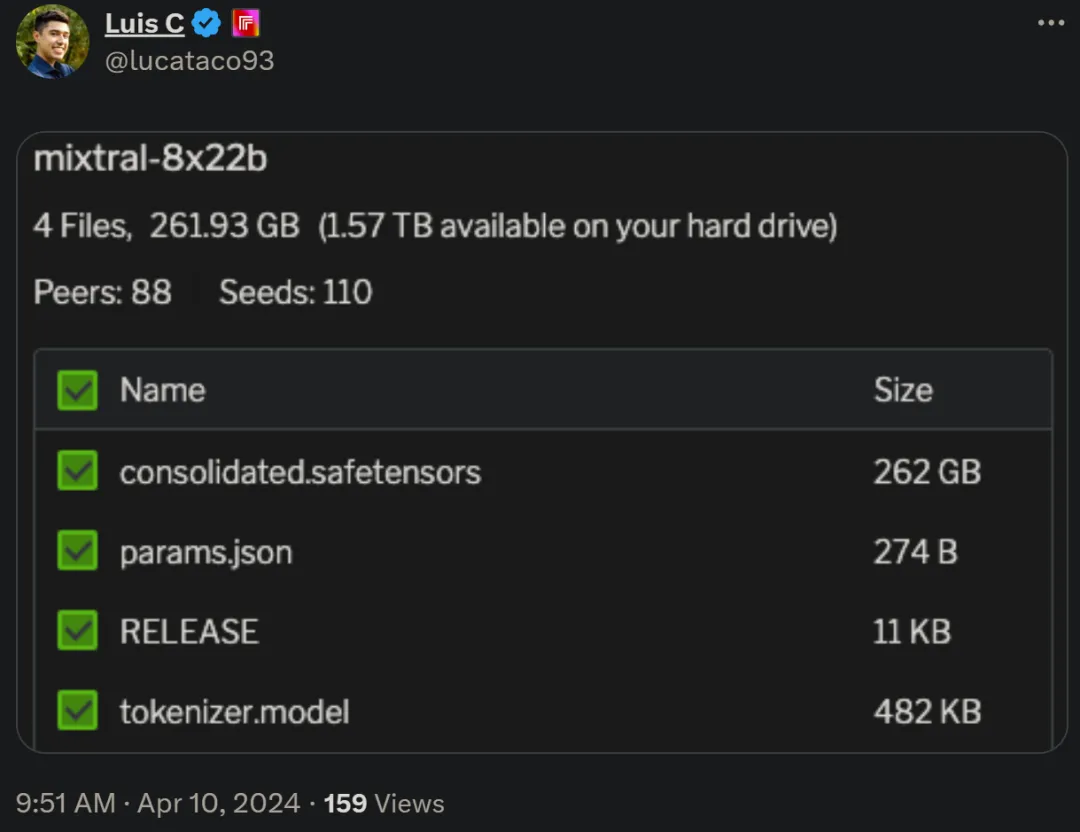

短短 3 个月后,Mistral AI 开源了 Mistral 8X22B 模型,再一次为开源社区注入了新鲜血液。Mistral AI 提供的磁链大小为 281 GB,下载后可以看到模型文件大小约为 262 GB,比之前的 Mixtral 8x7B 大得多,鉴于 Mixtral 8x7B 优秀的表现,网友们表示很看好 Mistral 8X22B,不过目前还没有看到有人运行它。

芯片大战

除了软件的较量,另一边,硬件领域中的芯片也是八仙过海。

对于提升训练 AI 模型所需的算力来说,CPU 至关重要。而众所周知,购买 AI 芯片的成本惊人,英伟达的 Backwell 芯片,预计售价在 3 万美元到 4 万美元之间。为了在 AI 军备竞赛中节省开支,微软和亚马逊均在自研处理器方面发力,谷歌自然不甘落后。本周二的 Cloud Next 2024 大会上,谷歌还正式宣布,将自研首款基于 Arm 的 CPU。据称这款 CPU 处理器 Axion,将提供比英特尔 CPU 更好的性能和能源的效率,其中性能提高 50%,能源效率提高 60%,比起目前基于 Arm 的最快通用芯片,Axion 的性能还要高出 30%。

GPU 方面,当地时间 4 月 9 日,英特尔举办了面向客户和合作伙伴的英特尔 on 产业创新大会。这场大会上,英特尔首次介绍了他们的 GPU 产品 Gaudi 3,对标英伟达早前的主力产品 H100。据介绍,英特尔 Gaudi 3 将带来 4 倍的 BF16 AI 计算能力提升,采用 128GB HBMe2 内存,支持 1.5 倍的内存带宽提升,采用 5nm 制程制造。此外,这颗芯片能够支持多种的大模型,包括 Llama、文生图的 Stable Diffusion、语音识别的 Whisper 等等。

短短几天,科技圈的大事层出不穷,不得不祭出这张 meme 了。

作为这场科技革命千千万万的见证者之一,我时刻期待着。

参考来源:

https://developers.googleblog.com/2024/04/gemini-15-pro-in-public-preview-with-new-features.html

https://platform.openai.com/docs/models/continuous-model-upgrades