老黄的新宣言:决胜 AI 的 iPhone 时刻。

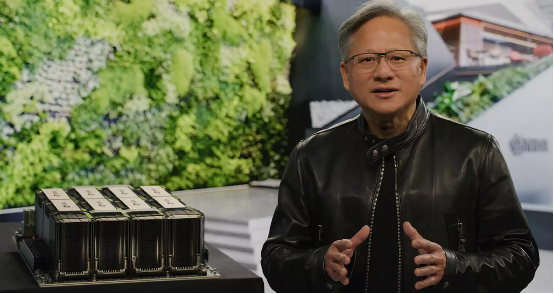

北京时间 3 月 21 日晚间,在英伟达 GTC2023 上,英伟达创始人兼首席执行官黄仁勋穿着他标志性的皮夹克,站在位于英伟达总部的垂直绿墙前,发表了一场主题演讲。

这场发布会几乎完全聚焦于人工智能。

演讲中,黄仁勋介绍了新一轮技术突破,从 AI 训练到模型部署,再到半导体、软件库、系统乃至云服务,分享了英伟达的加速计算平台如何推动人工智能、元宇宙、云技术和可持续计算的下一波浪潮。英伟达持续推进 AI 硬件,并重点关注这些技术在科技、医疗、金融、图像、物流配送等行业的应用场景,让各行各业的企业更容易使用其技术。

“我们正处于 AI 的 iPhone 时刻,”黄仁勋表示 “初创公司正在竞相打造颠覆性产品和商业模式,科技巨头也在寻求突破。”

最近站在风口浪尖之上的“顶流” — 生成式人工智能和 ChatGPT 也在本场发布会占了较大篇幅。“推动这波浪潮的引擎是加速计算,燃料则是 AI。生成式 AI 凭借令人印象深刻的能力令众多企业产生了紧迫感,开始重新构思自己的产品和商业模式。”

面对逐渐放缓的摩尔定律以及各行业对于可持续性、生成式 AI 和数字化的旺盛需求,加速计算和 AI 的到来可谓恰逢其时。黄仁勋表示,“工业企业正竞相推动数字化转型,并将自身重塑为软件驱动型科技公司,保证自己成为颠覆的力量、而非被颠覆的对象。”

最近 AIGC 和 ChatGPT 的走后也让英伟达成为背后赢家,大型语言模型需要规模庞大的算力,目前大模型竞赛中的很多玩家都依赖英伟达的 GPU 芯片。据悉,受益于 ChatGPT 相关产品的热度,英伟达 A100、H100 及 A800 系列 GPU 等三款针对数据中心的 GPU 代工订单增加。

投资公司 Baird 认为,ChatGPT 的“有意义的”订单正在到来,并帮助该英伟达上调了下半年数据中心收入预期。Baird 分析师 Tristan Gerra 表示,英伟达的 Hopper 芯片很可能受益于大型语言模型的增长,并成为一种“长期趋势”。

据悉,自今年年初以来,英伟达股价涨幅已超 80%。英伟达 2023 财年第四季度财报显示,AI 数据中心业务再次成为该公司最大的收入来源。

以下为英伟达 GTC 2023 的重要发布概览:

AI 的 iPhone 时刻

英伟达提供的技术可以说是 AI 发展的基础,黄仁勋讲述了显卡巨头如何在生成式 AI 革命之初为其提供助力。早在 2016 年,他就向 OpenAI 交付了第一台英伟达 DGX AI 超级计算机,这也正是支持 ChatGPT 大语言模型实现突破的底层引擎。

去年年底亮相以来,ChatGPT 迅速进入公众视野,吸引到超 1 亿用户,成为历史上增长速度最快的应用程序。黄仁勋感慨,“我们正处于 AI 的 iPhone 时刻 。”

英伟达 DGX 超级计算机最初仅供 AI 研究,但如今已经在世界各地的企业中全天候运行,负责提炼数据和处理 AI。

目前,财富百强企业中有一半都在使用 DGX AI 超级计算机。“DGX 超级计算机已经成为现代 AI 的工厂。”

面向数据中心的英伟达 H100、Grace Hopper 和 Grace

如今,部署 ChatGPT 这类大语言模型已经成为新的重要推理工作负载。

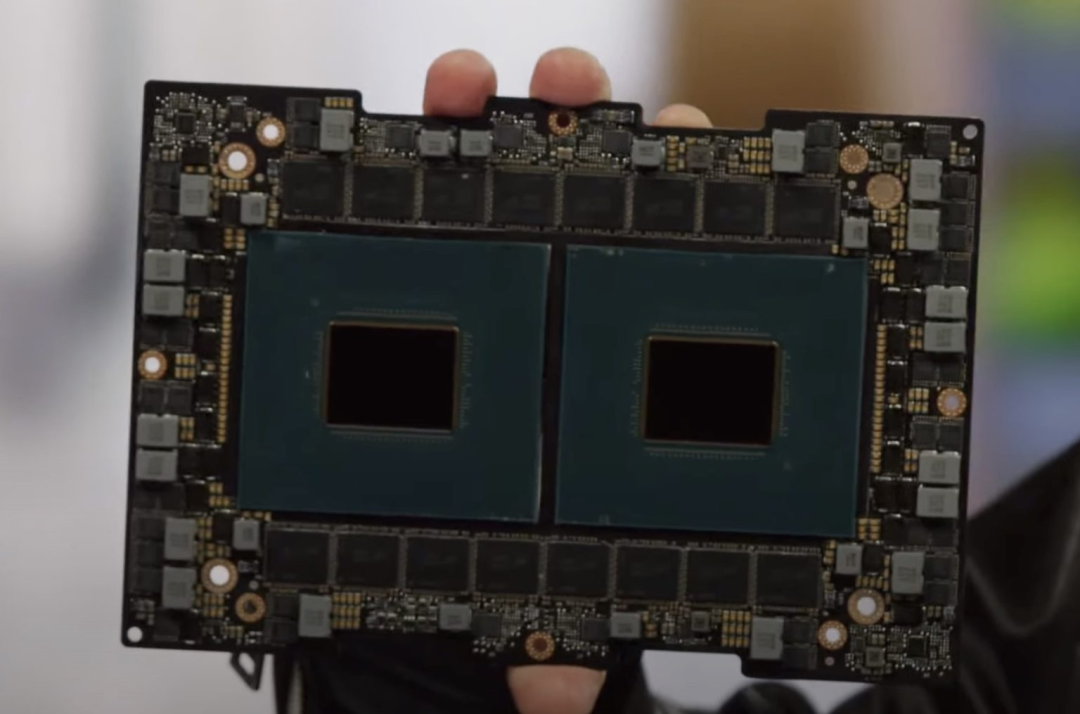

为了更好地应对这类需求,黄仁勋公布了新的双 GPU NVLink 产品 H100 NVL。

基于英伟达的 Hopper 架构,H100 内置一个 Transformer Engine,能够高效承载 GPT 这类大体量模型。与处理 GPT-3 的 HGX A100 相比,通过双 GPU NVLink 接入四对 H100,从而将速度提升 10 倍。

“H100 能够将大语言模型的处理成本降低一个数量级。”

H100

与此同时,过去十年间,云计算年均增长 20% 并发展出价值万亿美元的新产业。英伟达为 AI 和云优先时代设计出 Grace CPU,其中 AI 负载由 GPU 加速。目前 Grace 已经向部分客户提供样片。

NVIDIA Grace 超级芯片

英伟达的新型超级芯片 Grace Hopper 可通过 900 GB/ 秒高速接口将 Grace CPU 与 Hopper GPU 连接起来。Grace Hopper 专为大型数据集而生,特别是用于推荐系统和大语言模型的 AI 数据库。

“客户希望将 AI 数据库再扩大几个数量级,而 Grace Hopper 正是这类用例中的理想引擎。”

DGX — AI 基础设施的蓝图

最新版本的 DGX 采用 8 个相互连通的英伟达 H100 GPU,将其作为巨大的单一 GPU 使用。“英伟达 DGX H100 堪称全球客户构建 AI 基础设施的蓝图”,而且目前这款产品已经全面投产。

H100 AI 超级计算机也已筹备上线。

甲骨文 Oracle Cloud Infrastructure 宣布将先期提供搭载 H100 GPU 的新型 OCI Compute 裸机 GPU 实例。此外,亚马逊云科技也宣布即将为 P5 实例推出 EC2 UltraClusters 选项,最大规模可扩展至 2 万个互连 H100 GPU。上个星期,微软 Azure 也刚刚发布其 H100 虚拟机 ND H100 v5 的内部预览版。

Meta 已经其 AI 生产和研究团队部署了由 H100 驱动的 Grand Teton AI 超级计算机。还有 OpenAI,他们在 Azure 超级计算机上使用 H100 以支持 AI 研究。

其他接纳 H100 的合作伙伴还包括 Cirrascale 和 CoreWeave、Google Cloud、Lambda、Paperspace 以及 Vult。

现在英伟达的客户已经可以从各领先服务器制造商处购买配备有英伟达 H100 GPU 的服务器和系统,包括源讯、思科、戴尔科技、技嘉、HPE、联想和 Supermicro 等。

DGX Cloud:将 AI 引入每一家企业

为了帮助初创公司和大企业运用 DGX 的强大能力加快新产品开发和 AI 战略的推进,黄仁勋还公布了 NVIDIA DGX Cloud。

通过与微软 Azure、Google Cloud 和 Oracle Cloud Infrastructure 的合作,DGX Cloud 将把 DGX AI 超级计算机“通过浏览器引入每一家企业”。

DGX Cloud 专门针对 NVIDIA AI Enterprise 进行了优化,这是一套全球领先的端到端 AI 开发与部署加速软件套件。“DGX Cloud 将为客户提供最好的英伟达 AI 与领先云服务商的最佳服务。”

英伟达将与领先云服务商合作托管 DGX 云基础设施,第一步就是携手 Oracle Cloud Infrastructure。微软 Azure 预计将从下季度起托管 DGX Cloud,该服务也将很快扩展至 Google Cloud。

企业客户可以按月租用 DGC Cloud 集群,借此轻松实现大规模多节点训练负载的开发。

为生成式 AI 提供“增压加速”

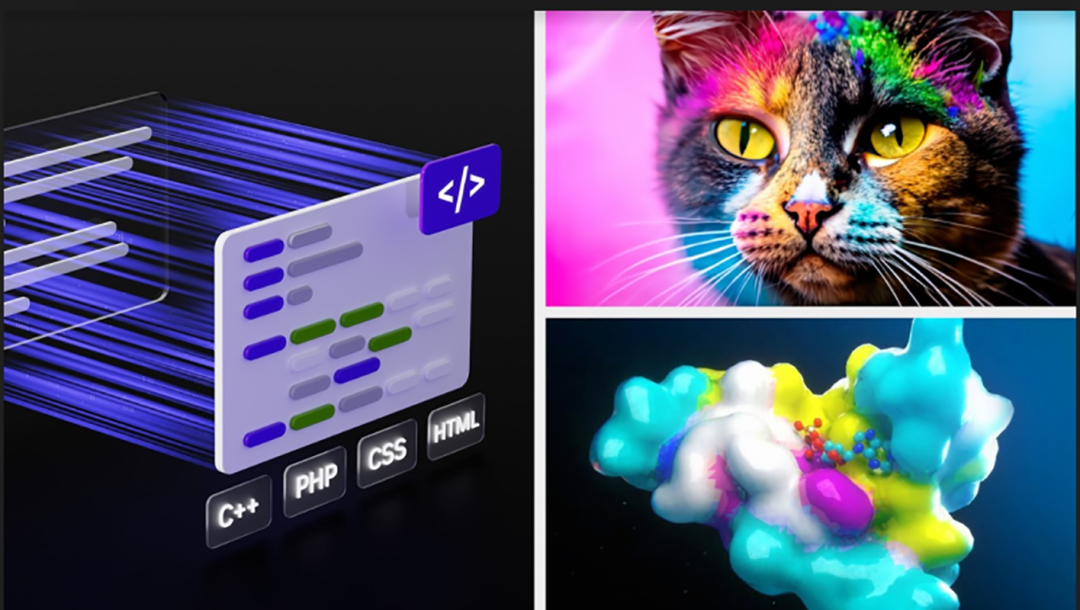

为了帮助生成式 AI 开发者加快探索的脚步,黄仁勋又公布了 NVIDIA AI Foundations。这个云服务系列主要面向希望构建、改进和操作定制化大语言模型的客户,能够利用专有数据训练出适应特定领域任务的生成式 AI 成果。

Nvidia AI Foundations 是针对语言、视觉模型和生物学的云服务

AI Foundations 服务包含用于构建定制化语言文本到文本生成模型的 NVIDIA NeMo;可利用许可或专有内容训练自定义模型的视觉语言模型服务 Picasso;以及服务于总值达 2 万亿美元的药物发现行业研究人员的 BioNeMo。

Adobe 也在与英伟达合作,共同为未来的创造性工作构建下一代 AI 功能。Getty Images 则与英伟达合作训练负责任的文本到图像与文本到视频生成式基础模型。Shutterstock 与英伟达合作训练文本到 3D 生成式基础模型,希望简化 3D 资产的创建流程。

加速医学进步

英伟达宣布 Amgen 正通过 BioNeMo 加速药物发现。此外,Alchemab Therapeutics、阿斯利康、Evozyne、Innophore 和 Insilico 也都是 BioNemo 的早期用户。

BioNeMo 能够帮助研究人员利用专有数据创建、微调和交付定制化模型。

黄仁勋还宣布,英伟达已经与全球最大医疗保健技术提供商美敦力建立合作,共同构建用于软件定义医疗设备的 AI 平台。双方将合作为美敦力系统构建通用平台,将手术指引、机器人辅助手术等各类成果纳入其中。

美敦力此次也公布了利用 NVIDIA Holoscan 软件库打造的实时传感器处理系统 GI Genius,能够利用 AI 技术实现结肠癌的早期检测,计划于今年年底左右正式上线。

黄仁勋总结道,“市值 2500 亿美元的全球医疗器械市场,正经历一场根本性变革。”

为生成式 AI 应用的部署加速

为了帮助企业快速部署生成式 AI 艺术形式,黄仁勋公布了用于 AI 视频、图像生成、大语言模型部署和推荐的推理平台。

这些功能将与英伟达的全栈推理软和最新的英伟达 Ada、Hopper 及 Grace Hopper 处理器相结合,包括此次推出的英伟达 L4 Tensor Core GPU 及 H100 NVL GPU。

• 英伟达 L4 for AI Video 可将 AI 视频处理性能提升至 CPU 的 120 倍,能效优化达 99%。

• 英伟达 L40 for Image Generation 针对图形生成和 AI 支持的 2D、视频及 3D 图像生成进行了优化。

• 英伟达 H100 NVL for Large Language Model Deployment 可高效部署 ChatGPT 等大语言模型。

• 英伟达 Grace Hopper for Recommendation Models 适用于图推荐模型、矢量数据库和图神经网络等用例。

Google Cloud 是首家向客户交付 L4 的云服务商,此次发布了新的 G2 虚拟机内部预览版。谷歌还计划将 L4 集成至 Vertex AI 模型商店当中。

把 Omniverse 带向“数亿用户”

黄仁勋宣布英伟达将与微软合作,将 NVIDIA Omniverse Cloud 全托管云服务推向各个行业,为每一家企业赋予前所未有的模拟和协作能力。

“微软和英伟达将把 Omniverse 带向数亿 Microsoft 365 与 Azure 用户。”同时推出的还有新的 NVIDIA OVX 服务器和新一代工作站,其中搭载 NVIDIA RTX Ada Generation GPU 和英特尔针对 NVIDIA Omniverse 优化的最新 CPU。

黄仁勋还播放了一段视频,展示了英伟达为 3D 设计协作与数字孪生模型构建的这套 Omniverse 开放平台。在 Omniverse 平台之上打造的机器人模拟与合成生成方案 NVIDIA Isaac Sim,已经成功帮助亚马逊建立起高保真度数字孪生副本,同时显著节约了时间和资金。

在演示中,亚马逊借此开发出首款全自动库管机器人 Proteus,它能与人类员工一道在巨大的配货仓库中将商品搬来挪去。

推动 3 万亿美元的汽车产业实现数字化

为了表达 Omniverse 的影响力和强大实力,黄仁勋还介绍了 Omniverse 在价值 3 万亿美元的汽车产业中发挥的数字化推动作用。到 2030 年,汽车制造商将建设 300 家工厂、生产 2 亿辆电动汽车,电池制造商则着手兴建 100 多处超级工厂。“数字化将提高行业的整体效率、生产力和行动速度。”

谈到 Omniverse 在整个行业的未来应用,黄仁勋分享了 Lotus 利用 Omniverse 建立虚拟组装焊接站,奔驰利用 Omniverse 来构建、优化和规划新车型的装配线。Rimac and Lucid Motors 则使用 Omniverse 开发出能忠实反映车辆设计参数的数字商店。

宝马与 Idelworks 合作,在 Omniverse 中利用 Issac Sim 生成合成数据与场景,借此训练工厂内的工程机器人。黄仁勋表示,宝马正使用 Omniverse 规划全球工厂运营,甚至在一家新电动车工厂开业两年前就完全在 Omniverse 中建立了孪生模型。

另外,英伟达还宣布与全球领先的新能源汽车制造商比亚迪合作,在生产体系中广泛引入 NVIDIA DRIVE Orin 集中式计算平台。

加速半导体突破

面对当前生产工艺已接近物理极限的事实,黄仁勋公布了 NVIDIA cuLitho 计算光刻库,将帮助阿斯麦尔、台积电和新思科技等半导体领先企业加速新一代芯片的设计和制造。这套全新软件库已经被全球芯片代工巨头台积电和电子设计自动化领军企业新思科技集成至其最新一代 NVIDIA Hopper 架构的 GPU 软件、制造流程和系统当中。

芯片制造商阿斯麦尔与英伟达就 GPU 和 cuLitho 库开展密切合作,计划在所有计算光刻软件产品中支持 GPU 集成。黄仁勋谈到,随着光刻技术逼近物理极限,英伟达推出的 cuLitho 有望帮助半导体行业迈向 2 纳米甚至更远的新节点。

“芯片行业,是几乎一切其他行业的基础。”

参考链接:

https://blogs.nvidia.com/blog/2023/03/21/gtc-keynote-spring-2023/