英伟达将斥资约 10 亿元收购初创 AI 公司 OctoAI

近日,外媒 The Information 的 Anissa Gardizy、Aaron Holmes 和 Stephanie Palazzolo 援引发给股东的一份消息称,英伟达已就收购 OctoAI 展开了深入谈判,OctoAI 是一家销售软件的初创公司,旨在提高人工智能模型的运行效率。根据 OctoAI 发给股东的一份文件,英伟达提议以约 1.65 亿美元收购该公司,这还不包括该公司的债务和其他费用。

据公开资料显示,OctoAI(前身为 OctoML)成立于 2019 年,公司联合创始人兼首席执行官 Luis Ceze 是一位出生于巴西的美国计算机科学家、商人和学者,也是华盛顿大学 Paul G. Allen 计算机科学与工程学院的计算机科学教授,后因其在 Apache TVM 和仿生数据存储系统方面的杰出成就而闻名。OctoAI 总部位于华盛顿州西雅图,成立 7 年间获得了 Madrona Venture Partners、Amplify Partners、Tiger Global 和 Addition Capital 等机构资金支持。

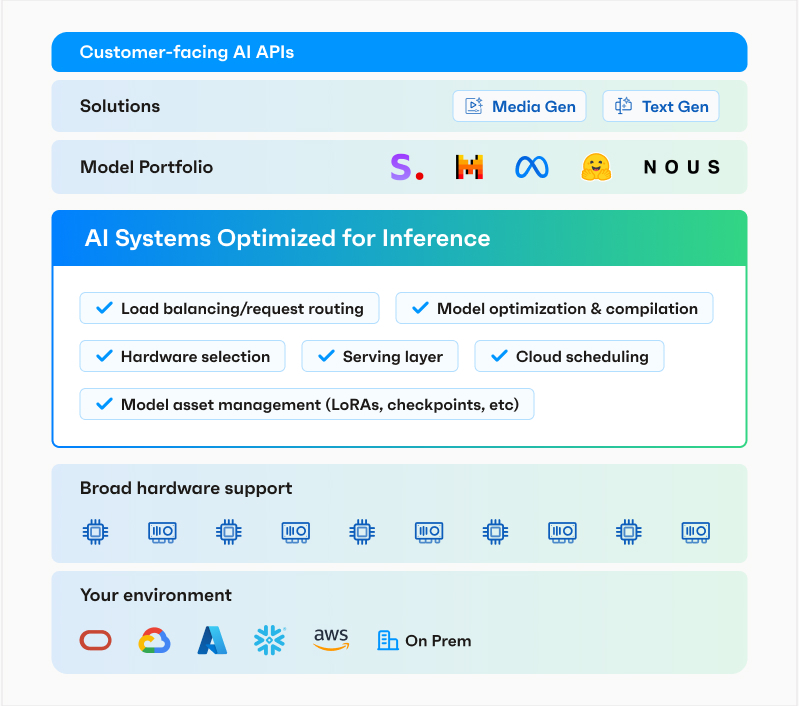

OctoAI 的使命是让人工智能更易于访问和可持续,以便它可以用来改善生活。OctoAI 平台为应用程序构建者提供了完整的堆栈,以便在云端或本地运行、调整和扩展他们的人工智能应用程序。借助适用于 SDXL、Mixtral 和 Llama2 等热门模型的超快推理 API、端到端开发人员解决方案和世界一流的 ML 系统,企业可以专注于构建让客户赞叹的应用程序,而无需成为人工智能基础设施专家。

此前,OctoAI 曾从包括 Tiger Global Management、Madrona Venture Group 和 Amplify Partners 在内的投资者哪里筹集了 1.32 亿美元,最终在 2021 年获得了约 9 亿美元的估值。

英伟达没有立即回应的置评请求。

为什么能被英伟达看上?

早在今年 4 月,OctoAI 公司就宣布推出了软件平台 OctoStack,该平台可让公司在其内部基础设施上托管人工智能模型。据悉,这是业界首个可在任何地方为生成式 AI 模型提供服务的完整技术堆栈。

在早期,OctoAI 几乎只专注于优化模型,使其运行更有效。基于 Apache TVM 机器学习编译器框架,该公司随后推出了 TVM 即服务平台,并随着时间的推移,将其扩展为一个成熟的模型服务产品,将其优化功能与 DevOps 平台相结合。随着生成式人工智能的兴起,该团队随后推出了完全托管的 OctoAI 平台,帮助其用户服务和微调现有模型。OctoStack 的核心就是 OctoAI 平台,但用于私人部署。

图片来源:OctoAI

OctoAI 首席执行官兼联合创始人 Luis Ceze 曾在接受媒体采访时称,该公司平台上有超过 2.5 万名开发人员和数百名在生产中使用该平台的付费客户。Ceze 说,这些公司中很多都是 GenAI 原生公司。不过,想要采用生成式 AI 的传统企业市场要大得多,因此 OctoAI 现在想通过 OctoStack 为这些企业提供服务。

许多大型语言模型都是通过基于云的 API(应用程序编程接口)提供的。此类模型托管在各自开发人员的基础设施上,这需要客户将其数据发送到该基础设施进行处理。在内部硬件上托管神经网络无需与外部提供商共享数据,这可以简化企业的网络安全和法规遵从性。

OctoAI 表示,其新的 OctoStack 平台使在公司内部基础设施上托管 AI 模型变得更加容易。该平台可以在本地硬件、主要公共云和 AI 优化的基础设施即服务平台(如 CoreWeave)上运行。OctoStack 同样适用于英伟达集团和 Advanced Micro Devices Inc. 的多种 AI 加速器,以及 Amazon Web Services 中提供的 AWS Inferentia 芯片。

在创建神经网络的初始版本后,开发人员可以通过各种方式对其进行优化,来提高性能。其中一种技术是运算符融合,它能够将人工智能执行的一些计算压缩为更少、更高效的硬件计算。另一种技术是量化技术,它减少了神经网络必须处理的数据量,能够产生准确的结果。

此类优化并不总是适用于不同类型的硬件。因此,针对一款显卡优化的 AI 模型不一定能在不同芯片制造商的处理器上高效运行。OctoStack 采用的开源技术 TVM 可以自动优化不同芯片的神经网络。

OctoAI 表示,这一平台可以帮助客户更高效地运行 AI 基础设施。据该公司称,由 OctoStack 驱动的推理环境提供的显卡利用率是自建 AI 集群的四倍。该公司还承诺将运营成本降低 50%。

OctoAI 联合创始人兼首席执行官 Luis Ceze 表示:“要让客户能够构建可行且面向未来的生成式 AI 应用程序,需要的不仅仅是经济实惠的云推理。硬件可移植性、模型入门、微调、优化、负载平衡——这些都是需要全栈解决方案的全栈问题。这正是我们在 OctoAI 构建的。借助 OctoStack,客户可以根据自己的情况利用我们行业领先的 GenAI 系统,控制他们的数据、模型和硬件。”

OctoStack 的主要优点:

快速运行任何模型: 企业选择理想的开源模型组合(例如 Llama、Mistral、Mixtral 等)、定制模型和专有模型,同时最大限度地提高性能。

在任何环境中运行:在用户选择的云中的云虚拟专用连接 (VPC) 中运行:AWS、Microsoft Azure、Coreweave、Google Cloud Platform、Lambda Labs、OCI、Snowflake 等。

选择任何硬件目标: 在广泛的硬件上运行模型,包括 NVIDIA 和 AMD GPU、AWS Inferentia 等。

专业知识和创新:受益于 OctoAI 在独立于硬件的全栈推理优化方面无与伦比的专业知识,这些专业知识经过多年的专门研究和开发磨练而成。

持续优化:本地客户可以获得类似于 SaaS 优势的持续更新,包括订阅新优化的模型和对其他硬件类型的支持,确保他们的 AI 能力始终保持领先地位。

OctoStack 支持流行的开源 LLM,例如 Meta 公司的 Llama 和初创公司 Mistral AI 开发的 Mixtral 专家混合模型。公司还可以运行内部开发的神经网络。据 OctoAI 称,OctoStack 可以随着时间的推移更新推理环境中的 AI 模型,而无需对其支持的应用程序进行重大更改。