整理 | 华卫、核子可乐

近日,有外媒报道称,OpenAI 正在制定新策略,以应对人工智能大模型改进速度放缓的问题。当时消息一出,知名认知科学家、AI 研究员 Gary Marcus 立即表示,“正如我所说,GPT 正在进入收益递减的时期。”

而近期,遭遇发展瓶颈的大模型似乎并不只有 GPT,所遇到的问题也远不仅于一个。彭博社在最新文章中这样写道:“(OpenAI、谷歌、Anthropic)三家 AI 公司为开发新模型付出了巨额努力,但回报越来越少。

看到这一论断后,OpenAI 负责模型微调的研究员 Steven Heidel 公开表示,“即使大模型的进展完全停止(需要明确的是,这并没有发生),仍然有至少十年的产品可以在今天的模型上建立。”

言下之意大概是,大模型在未来几年仍“大有前途”。与此同时,AI 圈也在几波的消息冲击下,迎来了多项立于新视角的重大成果。

OpenAI 在内,都撞到了同一堵墙

事情的最开始,是 The Information 突然曝料,OpenAI 的下一个旗舰模型可能不会像其“前辈”那样带来巨大的飞跃。测试代号为 Orion 的新模型的 OpenAI 员工发现,尽管它的性能超过了 OpenAI 的现有模型,并且只完成了 20% 的训练就达到了 GPT-4 的水平,但与从 GPT-3 到 GPT-4 的巨大飞跃相比,整体质量的提升要小得多。

换句话说,GPT 的升级速度似乎正在放缓。事实上,Orion 在某些领域(如编码)可能并不会比以前的模型更好。对于此前有关其旗舰车型计划的消息时,OpenAI 方面表示:“我们今年没有发布 Orion 模型的计划。

报道提到,GPT 开发速度放缓的部分原因是用于预训练的文本和数据供应减少(预训练有助于 LLM 理解概念之间的关系,从而解决起草内容或调试代码等任务)。根据 OpenAI 员工和研究人员的说法,该公司现在难以获得高质量的培训数据,开发人员已经耗尽了网站、书籍和其他用于预培训的公开文本。

为了解决这些问题,OpenAI 成立了一个基础团队,以研究如何在新训练数据不断减少的情况下继续改进其模型的新策略。据介绍,新策略包括在利用人工智能模型生成的合成数据训练模型,以及在后期训练过程中对具有有限新数据的模型进行更多改进。

这种减速或表明,由于数据稀缺和硬件成本飙升等因素,对大模型来说,传统的扩展改进可能已经达到极限。“传统 scaling laws 下的 LLM 进展可能会放缓”,有研究人员和企业家担心,生成式 AI 已经遇到了障碍,即使如 OpenAI 般急于扩大该技术使用规模的公司,也发现这在实践中很棘手。

并且,类似的困境不止出现在 OpenAI,还有其他前沿实验室在这方面遇到更严重的问题。据数据科学家 Yam Peleg 曝料,从某个前沿实验室传出消息,他们试图通过更长时间的训练和使用越来越多的数据来强行获得更好的结果,结果却意外地达到了一个巨大的收益递减墙(比公开发布的更严重)。

“因此,我认为可以肯定的是,所有主要参与者都已经达到了训练时间更长、收集数据更多的极限… 现在的关键是数据质量,而这需要时间。”Peleg 表示。而这样的说法正在被不少人认同,有网友表示,“所有的实验室似乎都撞到了这样的墙。”

总而言之,目前可能需要新的方法来推动 AI 技术超越其当前的极限。

“LLM 只会照本宣科”,一生变就崩溃?

“我们的数据用完了。合成数据始终意味着提炼现有模型,而不是向人类学习。”一位网友在听到消息后这样说道。

另一位网友则表示,“未来应该是 LLM 与推理模型相结合,推理能力越强,效果越好。天不会塌下来。”

一波未平一波再起,除此之外,最近麻省理工学院的一项研究又引发了许多人对于大模型本身理解和学习能力的诸多质疑,甚至有网友锐评道,“LLM 只会照本宣科,而不能像人类甚至其他动物那样将所学到的知识应用于新事物。”

研究人员发现,尽管生成式 AI 的输出令人印象深刻,但其对世界并没有连贯的理解。也就是说,一旦任务或者环境稍有变化,之前表现良好的模型可能会瞬间崩溃。

研究人员重点研究的是 transformer 模型,一类在随机生成的序列数据之上训练而成,另一类则由遵循策略生成的数据训练而成。并将评估示例放在确定性有限自动化(DFA)的问题上,分别是在纽约市的街道上导航以及玩棋盘游戏。

在导航的应用例中,虽然模型能够近乎完美地为用户提供纽约市的导航路线,但当研究人员封闭部分街道再添加绕行路线之后,其性能则会显著下降。哈佛大学博士后 Keyon Vafa 表示,“令人惊讶的是,只要添加一条绕行路线,模型性能就会迅速下降。哪怕我们只封闭掉 1% 的街道,准确率就会立即从接近 100% 下降到 67%。”

但两类 transformer 模型都没能在导航示例中形成连贯的世界模型,并且研究人员在还原模型生成的城市地图时发现,该地图往往包含随机方向的天桥或者大量现实中并不存在的街道。

而在棋盘游戏的示例中,他们发现 transformer 无需了解任何规则,就几乎能够准确预测游戏中的有效棋路。Vafa 解释道,“棋盘游戏中,如果你看到的是两台随机计算机在下棋,而不是冠军棋手在下棋,理论上你会看到所有可能的棋步,甚至是冠军棋手不会走的坏棋。”

令人惊讶的是,研究人员发现随机做出选择的 transformer 反而形成了更准确的世界模型,这可能是因为它们在训练期间接触过更多潜在的下一步棋路。不过,尽管 transformer 几乎在所有情况下都能生成准确的方向和有效的棋路,只有一类模型能够生成连贯的世界模型。

研究人员强调,“看到这些模型那令人印象深刻的表现,我们往往认为它们一定是对现实世界有所了解。但我想提醒大家的是,这个问题不可轻下结论,更不能单凭直觉就言之凿凿。”

对于目前大模型发展中显现的这些瓶颈,有网友提出了一些有趣的想法。

一位网友建议,“我想知道是否有可能将 LLM 与 Cyc(一个逻辑引擎和生活常识规则数据库)连接起来。该引擎可以找到语言模型(文本)和 Cyc 模型之间的最佳匹配,并对较短的候选模型(最小的逻辑图)进行加权。从语言模型生成候选 Cyc 模型可能首先需要大量的训练。”

还有一位网友表示,“现在需要人形机器人来改进 scaling law。如果没有机器人在现实世界中亲身经历的纯数据,GPT 就不可能得到改进。”

scaling 开始出现“正确的方向”

眼见 scaling laws “撞墙”的消息让 AI 圈炸开了锅,声势也愈演愈烈,隔几日后 The Information 再次发文对先前的曝料作了进一步解释。

据其介绍,此前 OpenAI 的 CEO Sam Altman 在 Reddit 上被问及 GPT-5 和 o1 的完整版本时透露,OpenAl 将优先考虑开发 o1 及其后续产品,而不是 GPT,理由是并行发布的计算资源有限。并且,OpenAI 可能会放弃其于 2018 年开始的 GPT 命名约定 (GPT-1),考虑将 Orion 与 Q*/Strawberry 推理能力融合为“o2"。

The Information 称,Altman 之所以专注于推出推理模型,正是因为 GPT 的改进速度正在放缓。而他们的推理范式通过对数线性计算扩展引入了新的扩展潜力,尽管 o1 的定价比非推理模型高出六倍,目前还限制了其客户群。

路透社也发文称,有十几位人工智能科学家、研究人员和投资者认为,这些技术(OpenAI 最近发布的 o1 模型背后的技术)可能会重塑人工智能军备竞赛的格局,并对人工智能公司对能源和芯片类型等资源的需求产生影响。

对这场 scaling 广遭质疑的“闹剧”,图灵奖得主 LeCun 则引用 Ilya Sutskever 此前的表述道, “2010 年代是 scaling 的时代,现在我们又回到了奇迹和发现的时代”,“现在 scaling 正确的方向比以往任何时候都更重要。”

最近几天我们也看到,开始有围绕传统 scaling laws 作进一步改进和优化的成果和路线涌到公众视线中。

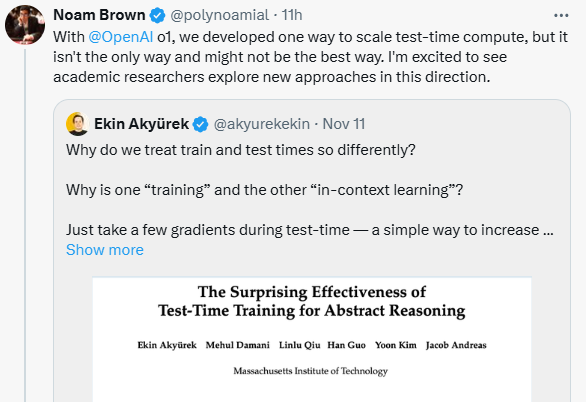

首先是 OpenAI 研究员 Noam Brown 转发了一项麻省理工学院关于“测试时训练 (Test-Time Training, TTT) 能够让 scaling 模型的性能有很大提升”的研究,并透露道,O1 中也开发了一种名为“测试时计算”的方法。“ 我很高兴看到学术研究人员朝着这个方向探索新方法。”Brown 说。

还有来自哈佛大学、斯坦福大学与 MIT 等机构的合作团队,提出了一种“精度感知”(precision-aware)的 scaling laws,该定律在模型参数数量和数据规模之外增加了精度的考量维度,允许预测模型在不同精度下的损失,并表明以较低精度训练较大的模型可能是计算最优的。

即将担任 UCSD 助理教授的 Dan Fu 这样评价该成果,“随着下一代的 GPU 上线,我一直在想的一件事是,我们可以将量化 /scaling 位数的范围降低到何种程度……这篇论文迈出了回答这个问题的第一步!”

参考链接: