2025 年 4 月 10 - 12 日,QCon 全球软件开发大会将在北京召开,大会以 “智能融合,引领未来” 为主题,将汇聚各领域的技术先行者以及创新实践者,为行业发展拨云见日。

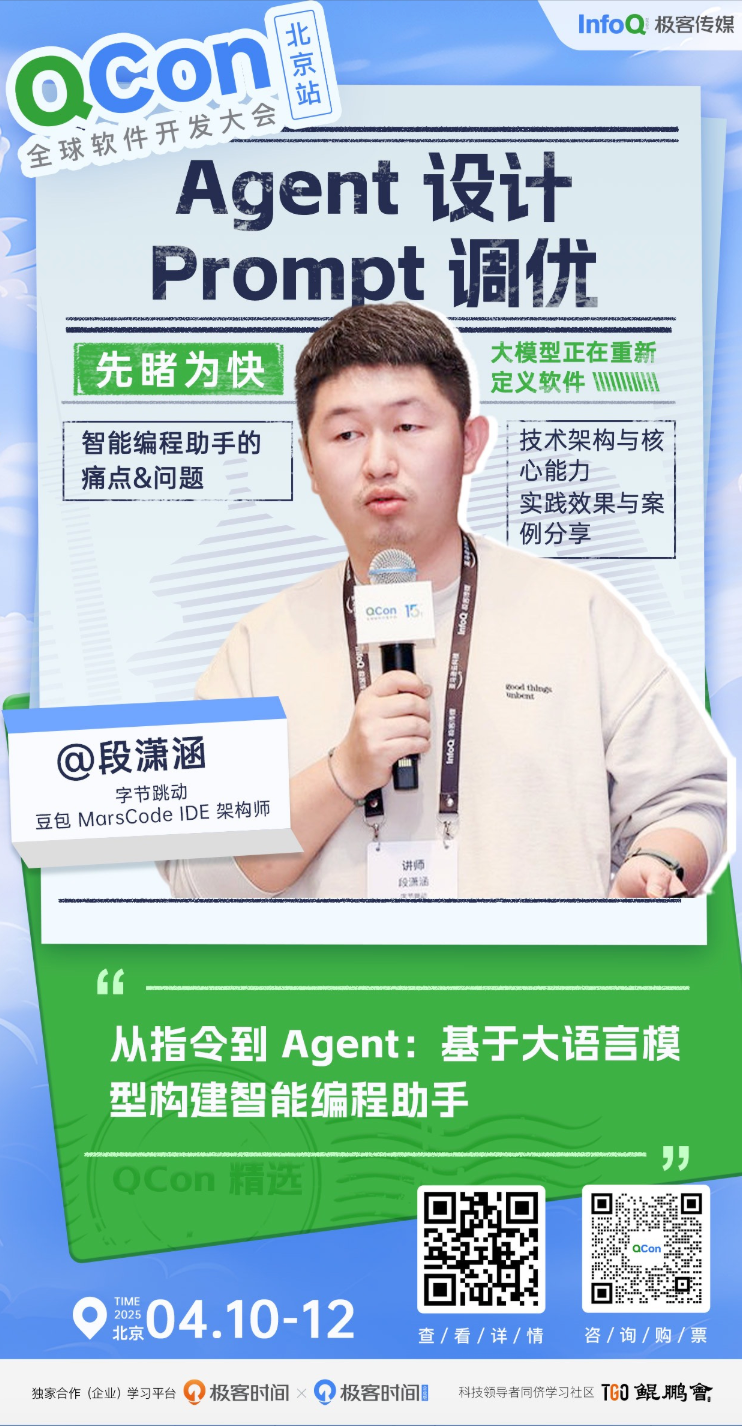

字节跳动 豆包 MarsCode Trae IDE 架构师 段潇涵已确认出席并发表题为《从指令到 Agent:基于大语言模型构建智能编程助手》的主题分享,深入探讨如何基于大语言模型构建新一代智能编程助手,分享从概念到落地的完整实践经验。

本演讲将首先剖析当前研发效率的痛点,展示传统开发工具的局限性,以及大语言模型带来的新机遇;接着将详细介绍智能编程助手的技术架构,包括 Agent 的核心设计理念、工程能力构建方法,以及与 IDE 的深度集成实践,通过实际案例的演示展示智能助手如何在代码理解、生成、优化等场景中提供有效支持。作为一线实践者,段潇涵也将分享字节跳动 Trae IDE 团队在工程落地过程中积累的经验与教训,包括架构选型、prompt 优化、系统集成等关键决策点的思考。

段潇涵目前致力于大语言模型在研发工程领域的落地实践,构建基于大语言模型的 AI 编码助手,同时致力于推进 IDE 云端化进程,使其与研发基础设施平台融合,为开发者提供一站式的智能研发体验。他在本次会议的详细演讲内容如下:

演讲提纲

1.智能编程助手的痛点 &问题

研发效率痛点分析

传统工具的局限性

大语言模型带来的机遇

2. 技术架构与核心能力

Agent 架构设计

工程能力构建

多轮对话与记忆管理

代码知识图谱与上下文感知

Prompt 设计与调优

代码理解与生成

IDE 系统集成

3. 实践效果与案例分享

典型应用场景展示

真实案例演示

4. 经验总结与建议

工程实践心得

常见问题与解决方案

5. 未来展望

您认为,这样的技术在实践过程中有哪些痛点?

模型能力的不稳定性。同样的提示词,模型在不同时刻可能给出不同质量的结果。特别是在处理复杂代码时,有时会出现理解不准确、生成代码有错误的情况。为了解决这个问题,我们不得不增加大量的校验和修正机制,这就导致了系统复杂度的提升和响应时间的增加。

上下文长度的限制。在实际开发中,相关的代码上下文经常会很长,但模型能处理的内容长度是有限的。如果强行压缩上下文,可能会丢失重要信息;如果采用多轮对话来传递信息,又会影响效率和体验。这是一个需要在体验和效果间不断权衡的问题。

成本与效果的平衡。高性能的大语言模型调用成本很高,但如果使用较小的模型,又可能无法满足复杂场景的需求。我们必须在每个环节仔细评估是否值得使用大模型,有时不得不用规则加传统算法的方式来替代,以平衡成本和效果。

这些问题目前还没有完美的解决方案,需要在实践中不断调整和优化。重要的是正视这些局限性,在系统设计时充分考虑各种约束,找到最适合实际场景的平衡点。

演讲亮点

在 Agent 技术架构方面,不同于传统的 prompt 模板方案,将开发需求分解为具体步骤,并在执行过程中进行自我反思和修正

在上下文感知方面,构建代码知识图谱,实时构建代码的结构和依赖关系等,解决了大语言模型处理大型代码库时的上下文限制问题

听众收益

了解大语言模型在研发领域的实践路径

掌握构建智能编程助手的关键技术要点

获得可直接借鉴的工程经验

除此之外,本次大会还策划了多模态大模型及应用、AI 驱动的工程生产力、面向 AI 的研发基础设施、不被 AI 取代的工程师、大模型赋能 AIOps、云成本优化、Lakehouse 架构演进、越挫越勇的大前端等专题,届时将有来自不同行业、不同领域、不同企业的 100+资深专家在 QCon 北京现场带来前沿技术洞察和一线实践经验。

现在报名即可以享受 9 折优惠,单张门票立省 680 元,详情可扫码或联系票务经理 18514549229 咨询。