Apple 在 WWDC 2017 大会上发布了一种使用机器学习的方式,以及一种开发人员在自身应用中添加机器学习的方式。

Apple 新发布的机器学习 API 称为 Core ML,允许开发人员将机器学习模型集成到 App 中,App 运行于采用 iOS、macOS、watchOS 和 tvOS 的 Apple 设备上。由于模型驻留在设备上,因此数据不会离开设备。

Core ML 提供了应用开发人员可用的多种 API 调用,无需开发人员在 App 中额外添加任何模型。例如,它所提供的计算机视觉算法包括了面部识别和追踪、特征点检测和事件识别。开发人员也可调用 Core ML 做自然语言分析,例如实现对电子邮件、文本和 Web 页面的分析。自然语言处理 API 调用包括了语言检测、标记化(Tokenization)、词性标注(POS tagging)抽取和命名实体识别等。

开发人员也可以设计并使用自己的机器学习模型。Core ML 支持超过 30 层的深度神经网络,也支持其他一些机器学习方法,例如 SVM 和线性模型。在设备上可以使用 CPU 和 GPU,这为在 Apple 设备上运行强大的算法提供了很大的空间。

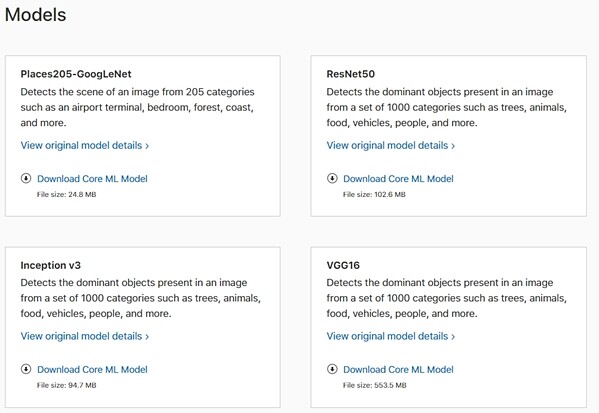

Apple 提供了一些预先训练好的模型,开发人员可以下载它们到自己的 App 中。在Apple 开发者网站上提供的一个模型可检测205 种图像场景(例如候机楼或卧室)。另外还提供了三种模型,可用于检测图像中的对象。开发人员也可以使用 Apple 提供的转换工具,将一些已有的模型转换为 Core ML 格式。该工具支持的机器学习工具包括:Keras(使用 Tensorflow 作为后端)、Caffe、Scikit-learn、libsvm 和 XGBoost。但是它不支持将已有的 Tensorflow 模型导入 Core ML 中,这在用于Android 的Tensorflow Lite 上是支持的。

对于那些想在自身App 中添加人工智能的开发人员,可以访问 Core Ml 的官方文档。

查看英文原文: Apple Announces Core ML: Machine Learning Capabilities on Apple Devices