人工智能可怕的攻势

不管你是否准备好,这两年,人工智能可以说是以秋风扫落叶之势,向人类发起了攻城略池的各项挑战。

2016 年,AlphaGo 初试牛刀,以 4:1 对阵韩国围棋高手李世石,引发了全球对人工智能的关注。2017 年年初,人工智能“Master”用连胜 60 局的战绩横扫了世界围棋界各路顶尖高手,一周时间的最后,Alpha Go(阿尔法狗) 脱下“Master”的马甲,宣布暂时闭关。他的最后一个对手、世界冠军古力留下两个字:绝望。

正如在 1997 年,IBM 的深蓝超级计算机击败国际象棋世界冠军卡斯帕罗夫那样,它已成为人工智能发展的里程碑事件。再到前不久,加拿大阿尔伯特大学开发的人工智能扑克系统 DeepStack 在一对一的无限下注德州扑克战胜了世界最强的人类德州扑克玩家。这一年来,人工智能的快速发展引发了世界一片惊呼,市场关注度空前高涨。

深度神经网络是目前人工智能领域最热门的路线之一。AlphaGo 和 Master 的核心技术就是深度神经网络。这个月的《最强大脑》第四季中人机大战特别吸晴的百度智能 AI 小度,也是以深度神经网络为核心。

想象一下一台十分好学上进的超级计算机,不知疲倦地和各个领域的宗师切磋对抗:深蓝、疯石、沃森、ZEN、仙王座……地学习各种人类的阴谋诡计,学成之后,它究竟会做些什么?早晚有一天这些家伙们会联合起来!

在可怕的人工智能面前,人类是不是就束手无策了?

不一定。人类手中可能还有一根救命稻草:“对抗样本”。

对抗样本

2015 年,三位科学家 Nguyen A、Yosinski J、Clune J 发表了一篇论文:《 Deep neural networks are easily fooled: High confidence predictions for unrecognizable images 》,在论文中,研究者构造了一类“对抗样本”,就是人为设计的图像,发现很容易骗过人工智能。机器视觉在这些样本上会产生戏剧性的错误,如下图。

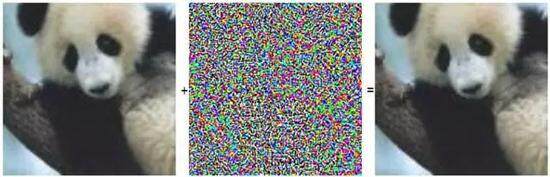

左图被神经网络以 60% 的置信度将它识别为“熊猫”,然后给它人为叠加上中图所示微小的扰动(实际叠加权重只有 0.7%),得到右图。在人类看来,几乎没有什么变化,但人工智能却以 99.3% 的置信度识别为“长臂猿”。

研究者指出,只要对图片做出一些人类无法察觉的修改,人工智能就会被“愚弄”;还可以设计出某些人类无法识别的图片,人工智能却“确信”它识别出的东西。

左图被人工智能识别为一只狗,但右图却识别为一只鸵鸟。右图就是“对抗样本”的一个例子。

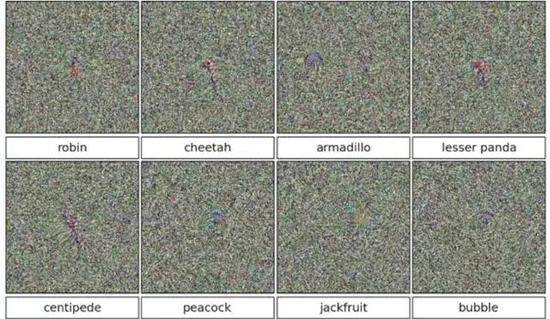

上述八张图片,在人类眼里是毫无意义的图片,但却被人工智能分别识别为知更鸟、猎豹、犰狳、小熊猫、蜈蚣、孔雀、菠萝蜜和气泡。置信度均接近 100%。

这些奇特的错误并不限于某个特定的神经网络,能骗过一个网络的图片,也能骗过另一个;它们也不限于图片识别,甚至不限于神经网络本身——研究者所尝试过的所有机器学习模型,都出现了这样的问题。Ian Goodfellow 指出,这种问题,不仅深度神经网络构建的的系统不能避免,更槽糕的是,其他各种机器学习算法也都无法避免。

来自不同团队的研究者已经确保了他们的愚弄图片不止在一个系统里整蛊成功。Google 的 Christian Szegedy 和他的同事们,在一篇论文《Explaining and Harnessing Adversarial Examples》写道:

“一个为某一模型生成的样本,通常也会被其他模型错误归类,即使它们有着完全不同的架构。”或者使用的是完全不同的数据集。“这意味着这些神经网络对校车长什么样有着某种共识,”Jeff Clune 表示,“但它们的共识与人类辨认校车的标准大相径庭。这一点让很多人大吃一惊。”

而到目前为止,人工智能这个错误,研究者还没有特别有效的修正办法。

人类最后的希望

对抗样本本来是个系统漏洞,但它却有可能成为人类对抗人工智能最后的希望,如果未来有一天,我们不得不与人工智能对决的话。为什么?因为对抗样本有三个特点:

- 对抗样本并不限于一个具体的神经网络,因此制造对抗样本也不需要获得该模型的源代码之类的东西。只要模型是被训练来执行相同的任务的,它们就会被同样的对抗样本欺骗,哪怕这些模型有不同的架构、使用了不同的训练样本。因此,人类只要设计一个模型,创造出相应的对抗样本,就能用这些样本攻击那些同样任务的人工智能。

- 对抗样本很难用常规的办法解决。有研究组尝试了各种各样传统手段,包括多个模型取平均值、同一图像多次判断取平均值、带噪音训练、生成模型等等,都不能解决对抗样本问题。有针对性的专门训练可以让模型的抵抗力更强,但也无法真正消灭盲区。

- 人类不会被这些样本欺骗。当然,人类也会在意想不到的地方跌倒——心理学已经提供了浩如烟海的视错觉和其他错觉例子。这些错觉可以认为是人类专属的“对抗样本”。但是面对神经网络的对抗样本,和面对人类的对抗样本,二者并不重合。我们都会犯错,但犯的错误不一样。

因此,未来人类如果和人工智能之间爆发战争,对抗样本的漏洞也许会帮助人类战胜人工智能。

我们有理由相信,这段时间吸晴的 AlphaGo、Master、小度等等,它们也会受困于精心设计的对抗样本——当人类无法正面战胜人工智能的时候,可能必须要开辟新的战线,决一死战:设法引导人工智能步入心智陷阱,从而战胜人工智能。但问题是,人类如何找出对方的盲区,如何引导对方失误,自己要做出多少牺牲,是否有可能制造出某种对抗样本,令对方陷入更大的心智陷阱,乃至死机?

感谢朱昊冰对本文的审校。

给InfoQ 中文站投稿或者参与内容翻译工作,请邮件至 editors@cn.infoq.com 。也欢迎大家通过新浪微博( @InfoQ , @丁晓昀),微信(微信号: InfoQChina )关注我们。