本文原作者: Thomas W. Dinsmore ,原文发布于: THE YEAR IN MACHINE LEARNING 。本文的翻译已获得作者授权。

这是 2016 年度机器学习盘点系列文章三篇中的第一篇。

本文将回顾机器学习 / 深度学习领域下列五方面的进展:

- 对于偏见的担忧

- 可解释的模型

- 深度学习的快速发展

- 超级计算成为主流

- 依托云平台打造的机器学习 / 深度学习栈

第二篇文章将介绍开源机器学习和深度学习项目领域的最新进展。

第三篇将回顾商用软件供应商在机器学习和深度学习领域的举措。

对于偏见的担忧

随着越来越多的组织扩大了在数据分析和自动化决策等领域对机器学习技术的使用,人们对这种技术可能存在的偏见更加担忧。2016 年,有媒体报道在刑事判决过程中所用的预测模型存在种族偏见,机动车保费报价存在价格歧视,图像识别应用习得“白色”是美丽的特征,谷歌的 word2vec 算法被发现存在成见。

2016 年有两本畅销书探讨了这个问题。其一为 Cathy O’Neil 所著的《 Weapons of Math Destruction 》(数学这一毁灭性武器),该书有望获得美国国家图书奖。在华尔街日报的采访中,Jo Craven McGinty 将 O’Neil 的观点总结为:“算法本身不存在偏见,但开发算法的人也许有偏见。”

第二本书由Ariel Ezrachi 和Maurice Stucke 撰写,名为《 Virtual Competition 》(虚拟竞争),着重探讨了机器学习和算法决策导致价格歧视的原因和这里面存在的阴谋。Burton Malkiel 在他的书评中提到,这本书“呈现出作者针对互联网世界的深入理解和优异的研究成果。博学的作者通过相关判例法,以及经济与行为心理学领域的研究文献证明了自己的论点。”

该领域大部分数据科学家均对自己工作成果中隐含的偏见深表担忧。毕竟偏见本身也是一种错误,有偏见的算法属于不准确的算法。然而雇佣这些数据科学家的组织可能无法针对偏见的检测和纠正投入测试和验证所需的足够资源。更重要的是,负责业务的人员通常会夸大自家预测式模型的准确度和精确性,或者错误地鼓吹不恰当的应用领域。

在欧洲, GDPR (译注:General Data Protection Regulation,通用数据保护规则)为使用机器学习技术的组织提供了激励措施,鼓励他们更严肃地对待可能存在的偏见。我们也许能在 2017 年听到有关 GDPR 的更多消息。

可解释的模型

说到 GDPR,从 2018 年开始,采用机器学习技术实现自动化决策的组织必须准备好随时向受到决策影响的主体,以及管控机构解释决策的由来。因此从 2016 年开始,就有越来越多的组织开始关注可解释机器学习算法的研发。

- MIT 计算机科学与人工智能实验室公布了神经网络研发中取得的进展,可以对预测的结果提供解释。

- 在国际人工智能联合会议上,David Gunning 就最新成果的可解释性进行了总结。

- MIT 在 Innovation Showcase 活动中选择了机器学习领域初创公司 Rulex 成为入围选手,Rulex 实现了一种名为 Switching Neural Networks 的技术,可用于了解分类和回归规则集的可解释性。

- 在 O’Reilly Radar 活动中,Marco Tulio Ribeiro、Sameer Singh 以及 Carlos Guestrin介绍了本地可解释的模型无关解释( LIME ),这种技术可以对任何机器学习分类器的预测进行解释。

- _ 华尔街日报 _ 也报道了 Capital One 开发出能解释决策背后原因的机器学习技术所做的努力。

在 Nautilus 杂志中,Aaron M. Bornstein问到:_ 人工智能是否会永远这样“神秘”下去?_ 这方面目前存在若干问题,包括缺乏对“可解释性”含义的明确界定。

“审查过程中的可解释性”和“功能的可解释性”必须明确加以区分。评估机动车时我们不会拆解出发动机和各种零件分别进行评估,只须坐进去试驾就够了。因此某种程度上我们只能通过最终的行为结果对机器学习模型进行评估,而非分别评估其中的不同组件。

深度学习的快速发展

在财富杂志九月份的一篇文章中,Roger Parloff解释了为什么深度学习技术会突然之间改变我们的生活。神经网络和深度学习并非新技术,最近这些技术才得以广泛运用主要是出于三个原因:

- 运算能力便宜了,并且会更加便宜,相关讨论请参阅下文有关超级计算的章节。

- 深度学习技术在“认知”应用程序,例如图像分类、语音识别,以及语言翻译等领域取得了不错的效果。

- 研究人员发现了设计和训练深度学习模型的新方法。

2016 年,深度学习驱动的认知应用程序领域还将达成全新里程碑:

- 微软团队开发了一套能像人类一样识别谈话内容的系统。该团队曾使用卷积(Convolutional)和长短期记忆(LSTM)神经网络开发出 Microsoft Cognitive Toolkit(CNTK)。

- 在 Google Research 博客上,Google Brain 团队公布了 Google Neural Machine Translation System,这个基于深度学习的系统目前每天被用于处理 1800 万次翻译请求。

- TechCrunch 的 Ken Weiner报道了深度学习驱动的图像识别领域最新进展,以及所能产生的影响。

风险投资家正在积极投资能够运用深度学习技术的初创公司,尤其是能通过认知解决方案在市场中脱颖而出的公司:

- Affectiva ,使用深度学习技术识别数字化视频中的面部表情,获得了 Fenox Venture Capital 提供的 1400 万美元 D 轮投资。

- Clarifai ,提供深度学习驱动的图像和视频识别服务的初创公司,得到了 Menlo Ventures 提供的一系列总额 3000 万美元的 B 轮投资。

- Zebra Medical Vision ,一家通过深度学习技术识别医学影象,诊断骨骼、大脑、心血管系统、肝脏,以及肺部疾病的以色列初创公司公布了获得 Intermountain Health 提供的 1200 万美元风险投资。

越来越多初创公司组成的新兴生态正在通过深度学习构建自己的业务,例如:

- Deep Genomics ,这家多伦多公司使用深度学习技术研究疾病、疾病的突变,以及基因疗法。

- 网络安全初创公司 Deep Instinct 使用深度学习技术预测、阻止、检测针对企业计算系统的威胁。

- Ditto Labs 使用深度学习技术识别社交媒体所发布图片中包含的品牌和徽标。

- Enlitic 提供了基于深度学习的病患分流、疾病筛查和临床支持,借此提高医学专家的生产力。

- Gridspace 提供了基于深度学习技术的谈话识别系统。

- Indico 提供了对社交媒体中文字和图片进行分析的深度学习工具。

自然语言处理领域的初创公司 Idibon 资金耗尽并关闭,这一迹象表明深度学习技术的商业化开发也并非全都是炒作和泡沫。随着财力雄厚的大型供应商逐渐涉足这一领域,我们将看到再 DL 工具市场方面出现进一步的合并。对刚进入这一领域的企业来说,专用应用程序可能是他们最大的机会,借此他们可以针对那些众所周知的问题提供相关领域的技能和打包式的解决方案。

超级计算成为主流

为了让深度学习变得更实用,我们需要极为强大的运算能力。2016 年,硬件供应商公布了专为机器学习和深度学习打造的,更强大的新平台。

虽然目前主流的做法是通过 GPU 进行加速,但在深度学习领域,GPU 与 FPGA 的优缺点也引发了广泛的争议。Anand Joshi介绍了 FPGA 所面临的挑战。_The Next Platform_ 的 Nicole Hemsoth介绍了同时利用两种方式进行加速的混合做法所蕴含的潜力。2016 年,微软也公布了将会使用Altera FPGA,而百度称自己更倾向于选择标准化的Xilinx FPGA。

NVIDIA 发布了 DGX-1

2016 年的 NVIDIA 犹如一头猛兽,过去的一年里市值翻了三倍。该公司发布了 DGX-1,一款面向深度学习的超级计算机。DGX-1 包含八颗 Tesla P100 GPU,每颗的运算速度均比 NVIDIA 之前的评测基准快 12 倍。只须 12.9 万美元即可获得能与装备有 250 颗 CPU 的服务器相等程度的运算能力。

NVIDIA 还发布了深度学习 SDK ,其中包含有关深度学习的基元、数学库、多 GPU 通信工具、CUDA 工具包和 DIGITS,以及一个模型训练系统。该系统可支持主流的深度学习框架,如 Caffe、CNTK、TensorFlow 以及 Theano。

技术媒体对此赞不绝口:

- ExtremeTech :“还有啥是计算机做不到的吗?”

- Gizmodo :“强大到让人发傻。”

- Engadget :“疯了。”

- TechReport :“GPU 神了。”

MIT Technology Review采访过 NVIDIA CEO 黄仁勋,此人现已成为华尔街最喜欢的技术名人。

此外 Karl Freund 也报道了 NVIDIA 在 SC16 超级计算展会上的活动。

DGX-1 的早期用户包括BenevolentAI、PartnersHealthCare、阿贡和橡树岭实验室、纽约大学、斯坦福大学、多伦多大学、SAP、Fidelity Labs、百度,以及瑞士国家超算中心。Nicole Hemsoth介绍了 NVIDIA 通过深度学习超级计算机为癌症研究所提供的支持。

克雷发布了 Urika-GX

克雷也发布了 Urika-GX,这是一种预装 Hortonworks Data Platform、Cray Graph Engine、OpenStack 管理工具,以及 Apache Mesos 的超级计算装置,可搭载 Intel Xeon Broadwell 处理器、22TB 内存、35TB 本地 SSD 存储,以及克雷的高性能网络互联接口。克雷在第三季度可交付单机架 16、32 或 48 节点的配置,预计 2017 年将能交付更大规模的配置。

英特尔的回应

Wired 有关谷歌深度学习芯片的头条报道:_ 英特尔该惊慌失措了_ 看起来很有先见之明。英特尔收购了仅成立28 个月的深度学习软硬件解决方案初创公司 Nervana Systems ,根据 Re/code 的报道,收购价格高达4.08 亿美元。技术媒体按照惯例发布的有关“独角兽”的报告自然蜂拥而至。

英特尔称,打算使用Nervana 的软件完善Math Kernel Library,并将Nervana Engine 与Xeon Phi 处理器划分为不同的市场。Nervana neon 是 YADLF(Yet Another Deep Learning Framework,另一款深度学习框架),根据 Kdnuggets 的最新调查,其使用量在所有深度学习框架中位居第十二位。根据Nervana 的介绍,Neon 的性能评测远胜Caffe,但其实 CNTK 也胜过 Caffe。

Paul Alcorn 针对英特尔的全新 Xeon CPU 和 Deep Learning Inference Accelerator提供了更多细节介绍。在财富杂志上,Aaron Pressman争辩称英特尔有有关机器学习和人工智能的战略为“智能”,但明显滞后于NVIDIA。Nicole Hemsoth认为英特尔的做法“挑起了GPU 的战争”。

此外英特尔还收购了 Movidius,这家公司将深度学习芯片装入了存储卡中。

依托云平台打造的机器学习/ 深度学习栈

机器学习的用例与云平台密不可分。工作负载具备即席性,面向具体项目,模型的训练需要在短时间内投入大量运算能力。负责得出推论的工作负载则体现出截然不同的模式,也正是因为如此这般的原因,负责训练和推论的工作负载应该分别选择最适合的平台。

Amazon Web Services

在年初发布了没人愿意使用的深度学习项目DSSTNE 作为烟雾弹后,AWS宣布将通过 MXNet 实现深度学习的标准化。此外 AWS 还新发布了三款托管式机器学习服务:

- 用于图像识别的 Rekognition

- 用于文字到语音转换的 Polly

- 对话聊天机器人开发平台 Lex

2014 年,AWS 成为市面上首家提供 GPU 加速云服务的云平台。2016 年,AWS提供了最多包含16 颗Tesla K8- GPU 的P2 实例。

Microsoft Azure

通过在 2015 年以 CNTK 的形式发布,微软将自己的深度学习框架更名为 Microsoft Cognitive Toolkit,并发布了 2.0 版,其中新增了 Python API 以及诸多其他改进。该公司还通过 Azure发布了 22 种认知 API,涵盖视觉、语音、语言、知识,以及搜索。此外微软还发布了适用于Azure HDInsight 的Spark 托管服务,并继续对Azure 机器学习服务进行着完善。

微软还发布了Azure N 系列计算实例,该系列由NVIDIA GPU 驱动,并已于12 月正式上市。

Azure 是微软高级分析整体战略中的一环,具体内容我们还将在第三篇中介绍。

Google Cloud

谷歌于二月发布了 TensorFlow Serving ,根据 Noah Fiedel 在 Google Research Blog 上的解释,这是一种开源的推论引擎,可用于处理训练后模型的部署并可对整个生命周期进行管理。

谷歌于春末发布了自行构建的专有深度学习芯片 Tensor Processing Unit(TPU)。高性能计算领域专家 Karl Freund 在福布斯杂志上对谷歌的公告进行了解读。Freund 认为 TPU 主要会被用于推论,而非模型的训练,换句话说,它取代的是 CPU 而非 GPU。

为了推动 Google Cloud Machine Learning 继续发展,谷歌于 10 月组建了一个专门的团队,并宣布了有关该服务的一系列改进:

- Google Cloud Jobs API 为企业提供了查找、匹配求职者,提供工作建议的能力,目前处于有限 Alpha 预览阶段。

- Cloud Vision API 已能运行于谷歌自己的 Tensor Processing Unit ,价格降低了 80%。

- Cloud Translation API 将发布标准版和高级版两个版本。

- Cloud Natural Language API 已完工并可正式上市。

2017 年,Google Compute Engine 和 Google Cloud Machine Learning 将可使用 GPU 加速实例,详见这里。

IBM Cloud

2016 年,IBM 对假新闻的涌现做出了巨大贡献。

6 月的 Spark Summit 活动中,IBM 大张旗鼓地公布了一款名为_IBM Data Science Experience_ 的服务。但很多老练的观察家发现这则消息让人费解,他们的媒体通稿中描述了一种适用于Apache Spark,使用Jupyter IDE 的托管服务,但当时IBM 已经有适用于Apache Spark 且使用了Jupyter IDE 的托管服务了。

11 月,IBM 低调地发布了另一个服务,并且没有提供新闻通稿,这也完全可以理解,毕竟没什么值得炫耀的。果不其然,这又是一个使用Jupyter IDE 的Spark 服务,但同时又包含了R 服务和Rstudio,以及一些仓促写就的“社区”文档和“精心策划”的数据来源,据称已经可以在数百个地区免费使用了。真了不起。

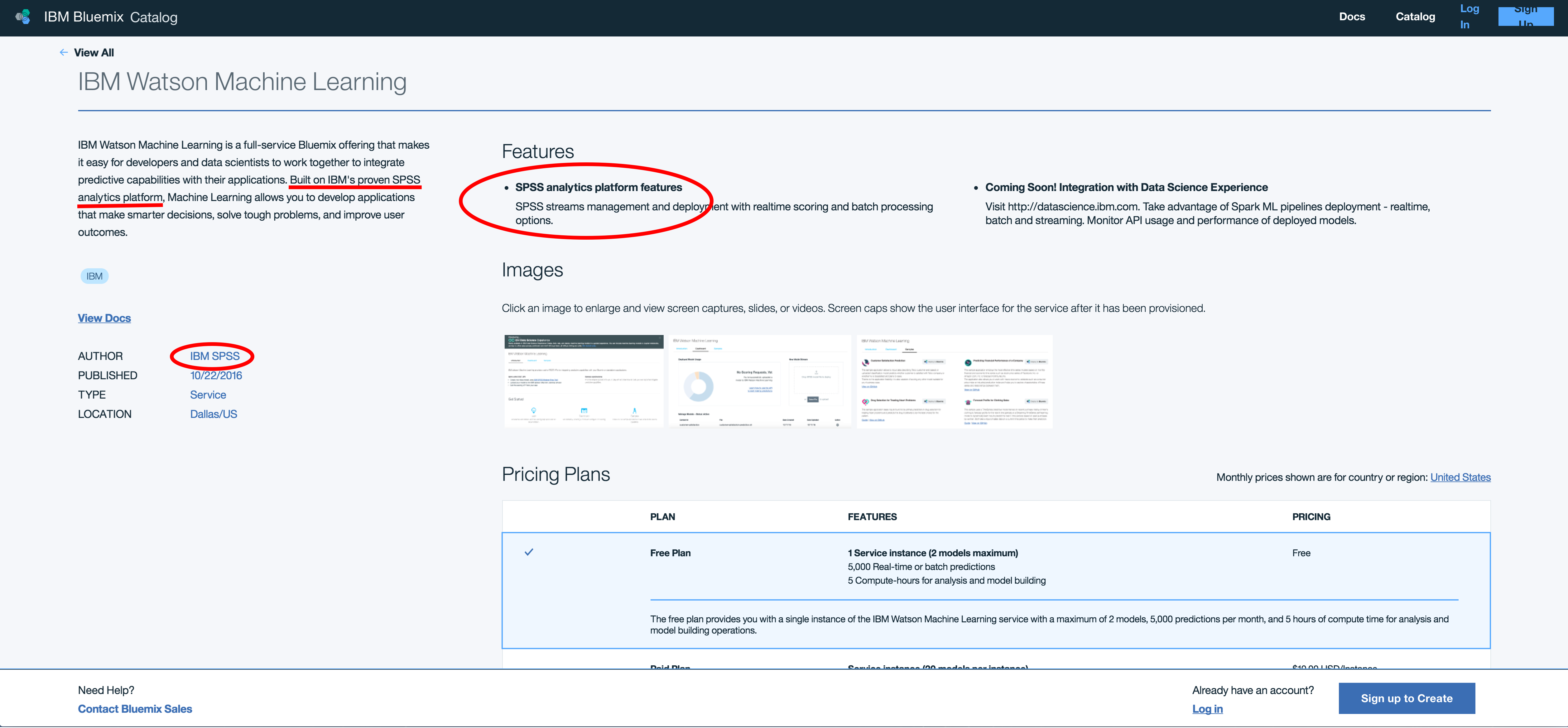

IBM 在机器学习方面还有其他重大举措,该公司重新发布了原有的SPSS 服务,只不过这次改名为Watson Machine Learning。分析师们纷纷为这个服务鼓掌喝彩,但是竟然没人真正登录上去看看他们发布的到底是啥。

当然,IBM 称对于该服务的完善他们制订了宏伟的计划。IBM 能有计划还真是棒。我们每个人都渴望更大规模,更好的产品,但是也要注意,尽管IBM 非常善于“重塑”被人开发出来的成果,但该公司在历史上还从未开发出任何一款在商业上获得成功的高级分析软件产品。

IBM Cloud 是 IBM 宏伟战略的组成部分,所以我打算在第三篇中详细谈一谈。

感谢杜小芳对本文的审校。

给InfoQ 中文站投稿或者参与内容翻译工作,请邮件至 editors@cn.infoq.com 。也欢迎大家通过新浪微博( @InfoQ , @丁晓昀),微信(微信号: InfoQChina )关注我们。